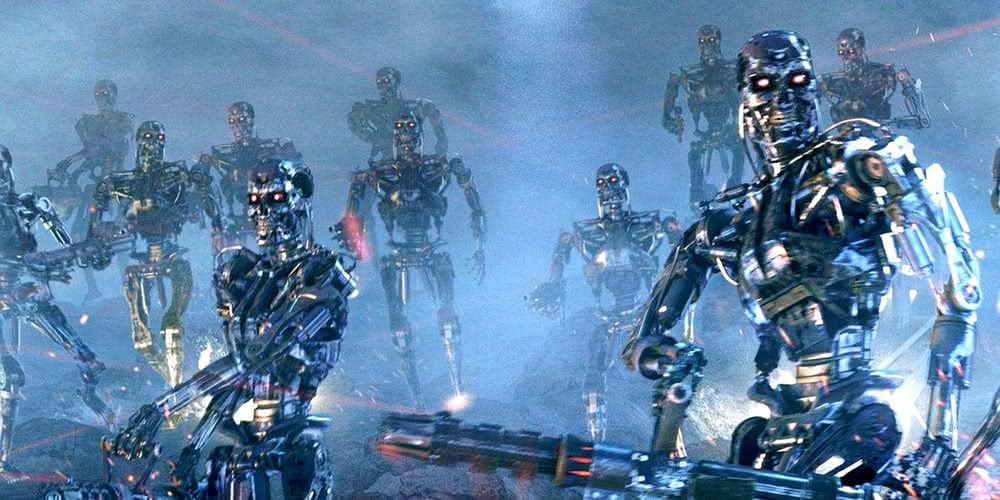

Broń autonomiczna na cenzurowanym: czy maszynom można ufać?

Scharre był również żołnierzem, odbywającym polową służbę w Iraku i w Afganistanie. W raporcie skupia się na rzeczywistych – a nie hipotetycznych – sytuacjach, w których zautomatyzowane systemy zawiodły. Jego podstawowe i powtarzane w różnych formach twierdzenie brzmi: jakkolwiek wyrafinowane byłyby systemy autonomicznej broni, brakuje im ludzkiej elastyczności i zrozumienia złożoności sytuacji.

W pełni autonomicznych systemów uzbrojenia nie ma jeszcze nawet amerykańska armia. Wojskowi zażyczyli sobie kilka lat temu pierwszych pół-autonomicznych rozwiązań – np. pocisków amerykańskiej marynarki, które, ogólnie nakierowane, po kilkuset kilometrach lotu same wybierałyby cele. I to wystarczyło, aby broń wzbudziła wiele kontrowersji.

Stosunki armii z zaawansowanymi systemami elektronicznymi mają swoją długą i dość szorstką historię. W 2007 r. grupa myśliwców F-22 Raptor wzięła udział w grach wojennych. Uległy poważnej awarii podczas lotu przez Pacyfik. Te supernowoczesne samoloty – zaprojektowane tak, by być niewidzialnymi dla radarów, wyposażone w zaawansowane systemy radarowe, najnowsze rodzaje broni i silnik, który pozwala gwałtownie przyspieszać bez pozostawienia olbrzymiej smugi kondensacyjnej – nie oparły się tzw. problemowi roku 2000.

Podczas przelotu z Hawajów na Okinawę w sześciu Raptorach nagle wyłączyła się cała elektronika. Okazało się, że oprogramowanie przestało działać, gdyż samoloty przekroczyły linię zmiany daty. Wyłączyły się systemy sterujące paliwem, nawigacją, częściowo pracy odmówiła komunikacja. Próby ponownego wystartowania systemu komputerowego nie przyniosły żadnych rezultatów. Na szczęście dla pilotów pechowych myśliwców w pobliżu znajdowały się samoloty- cysterny, które zapewniły im paliwo i doprowadziły je na Hawaje. Szczęśliwie była też ładna pogoda. Dzięki niej, nawet po zgubieniu samolotu-cysterny Raptory mogłyby zawrócić i najprawdopodobniej odnalazłyby Hawaje.

Po tym incydencie emerytowany generał brygady, Don Shepperd, powiedział: „Potrzebna im była pomoc. Gdyby zostali odseparowani od latających cystern, albo pogoda uległaby gwałtownemu pogorszeniu, nie mieliby żadnego punktu odniesienia. Systemy odpowiedzialne za komunikację i nawigację przestały działać. Prawdopodobnie samoloty musiałyby zawrócić i szukać Hawajów. Kiepska pogoda w trakcie podejścia do lądowania mogła spowodować poważne problemy”.

Wojskowi nie od dziś uważają, że im więcej podzespołów elektronicznych znajduje się w otaczającym nas sprzęcie, tym bardziej staje się on zawodny. Gdy mówimy o tosterze, można się z tego śmiać, ale strach pomyśleć, co będzie, jeśli „zastrajkują” systemy np. w wyrzutniach rakiet balistycznych.

W 2008 r. miały miejsce wydarzenia, które na kilka lat powstrzymały wdrażanie w wojsku bojowych robotów. Do Iraku przerzucono kilka autonomicznych robotów TALON w wersji SWORDS (Special Weapons Observation Reconneissance Direct-action System), wyposażonych w broń maszynową. Podczas testów na miejscu zaczęły się obracać, kierując broń w stronę amerykańskich żołnierzy. W obliczu zagrożenia, nie czekając na dalszy rozwój wypadków, wyłączono uzbrojone maszyny. Pomysł nie został jednak zarzucony na zawsze.

Międzynarodowy ruch przeciw robotom

Po raz pierwszy specjaliści z wielu krajów zasiedli do dyskusji na temat zakazu używania automatycznych zabójców podczas Konferencji do spraw Rozbrojenia ONZ w Genewie, w maju 2014 r. Apel, jaki wówczas wypracowano, został podchwycony przez Międzynarodowy Komitet Czerwonego Krzyża, strażnika konwencji genewskich, czyli szeregu prawnych umów międzynarodowych regulujących ochronę rannych podczas wojen oraz pomocy humanitarnej dla poszkodowanych w konfliktach. „Głównym problemem jest potencjalny brak kontroli człowieka w procesie identyfikacji celu i decyzji o jego zaatakowaniu, w tym ludzi”, powiedziała Kathleen Lawand z MKCK. „Idea pozwalająca maszynom na podejmowanie decyzji o życiu i śmierci na polu bitwy, z małym udziałem człowieka lub bez niego, rodzi uzasadnione poczucie zagrożenia”, dodała.

„Roboty-zabójcy zagrożą podstawowym zasadom prawa międzynarodowego”, mówił z kolei Steve Goose, dyrektor oddziału uzbrojenia w organizacji obrony praw człowieka Human Rights Watch. Laureaci Pokojowej Nagrody Nobla (w tym Lech Wałęsa) wystosowali apel o zakazanie używania autonomicznych robotów bojowych. „To niepojęte, że istoty ludzkie wkładają swój wysiłek w konstruowanie maszyn zdolnych do samodzielnego zabijania ludzi, bez udziału człowieka”, pisali sygnatariusze.

Opublikowany potem raport organizacji Human Rights Watch i naukowców z Uniwersytetu Harvarda stwierdzał, że takie militarne roboty byłyby zbyt niebezpieczne. Same wybierałyby bowiem swoje cele i zabijały ludzi, ale nie umiałyby przestrzegać międzynarodowego prawa. Poza tym nie bardzo byłoby wiadomo, kogo w razie czego pociągnąć do odpowiedzialności.

W niedawnej debacie, inżynier robotyki, brytyjski profesor Noel Sharkey opowiadał się z kolei nie za zakazem, ale za ścisłą kontrolą takich urządzeń. „Całkowity zakaz nie miałby sensu. Moim zdaniem ważne jest, by to człowiek kontrolujący tę maszynę, a nie sam robot, podejmował decyzję, do kogo strzelać”, powiedział.

Automaty to mniej przypadkowych ofiar?

Zdaniem wielu ekspertów nie można jednak ograniczać badań w dziedzinie robotyki. Technologia wykorzystywana w produkcji maszyn dla wojska może mieć także wiele zastosowań cywilnych. Nikt nie ma wątpliwości, że roboty różnego rodzaju pomagają rozbrajać ładunki wybuchowe, zwalczać klęski żywiołowe, pomagać ludziom w obliczu rozmaitych zagrożeń. Nie można też demonizować autonomii maszyn. Ich niezależność i samodzielność bowiem jest tym, o co toczy się walka w laboratoriach i ośrodkach zajmujących się budową robotów.

Pomimo protestów i międzynarodowych kampanii, wielu zwolenników stosowania robotów-zabójców zdecydowanie uważa, że dzięki nim wojny będą mniej krwawe, bo zacznie ginąć mniej żołnierzy. Zwracają uwagę, że roboty, choć nie odczuwają litości, są również odporne na negatywne ludzkie emocje, jak panika, gniew i żądza zemsty, które czasem prowadzą do zbrodni wojennych.

Obrońcy robotów używają też argumentu, że postęp techniki wojskowej doprowadził do ogromnego zmniejszenia strat cywilnych w ostatnim półwieczu. Precyzyjne bombardowania z powietrza w czasie wojny w Iraku przyniosły bez porównania mniej cywilnych ofiar niż bombardowania lotnicze w czasie II wojny światowej.

Pod względem ochrony cywilów roboty wypadają na froncie lepiej niż żołnierze. Za pomocą technologii uda się wyeliminować część czynników negatywnie wpływających na zachowanie żołnierzy – złość, strach, frustrację, zamknięcie poznawcze mogące wywoływać zjawisko samorealizującej się przepowiedni – i wprowadzić mechanizm ściślejszego przestrzegania praw wojny. Zamiast zasady „Najpierw strzelaj, potem pytaj” autonomiczne systemy będą kierowały się mniej agresywną strategią, zgodnie z regułą „Nie czyń niepotrzebnie krzywdy”. Nie zrobimy tego, odtwarzając w robocie cały ludzki proces wnioskowania moralnego, ale możemy pokusić się o zapisanie w nim zasad zawartych w międzynarodowym prawie humanitarnym. Roboty staną się etyczne, gdy zostaną wyposażone w oprogramowanie zmuszające je do przestrzegania praw wojny.