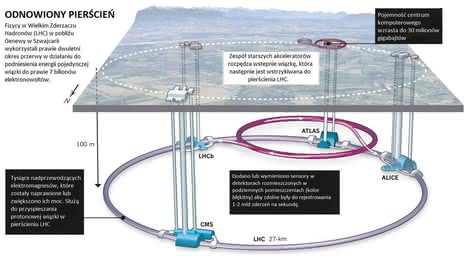

ZDERZACZ 2.0 - Nowa odsłona wielkiego eksperymentu

Przez ten czas, gdy LHC nie pracował, dodawano do instalacji nowe elektromagnesy, a te stare poddawano sprawdzeniu i remontowi. Większość z zaplanowanych udoskonaleń (2) udało się przeprowadzić w terminie.

Potem rozpoczęło się schładzanie elementów konstrukcji do poziomu umożliwiającego osiągnięcie zjawiska nadprzewodnictwa.

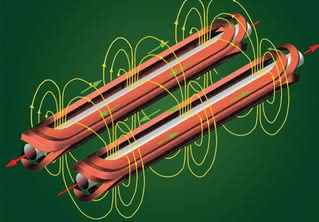

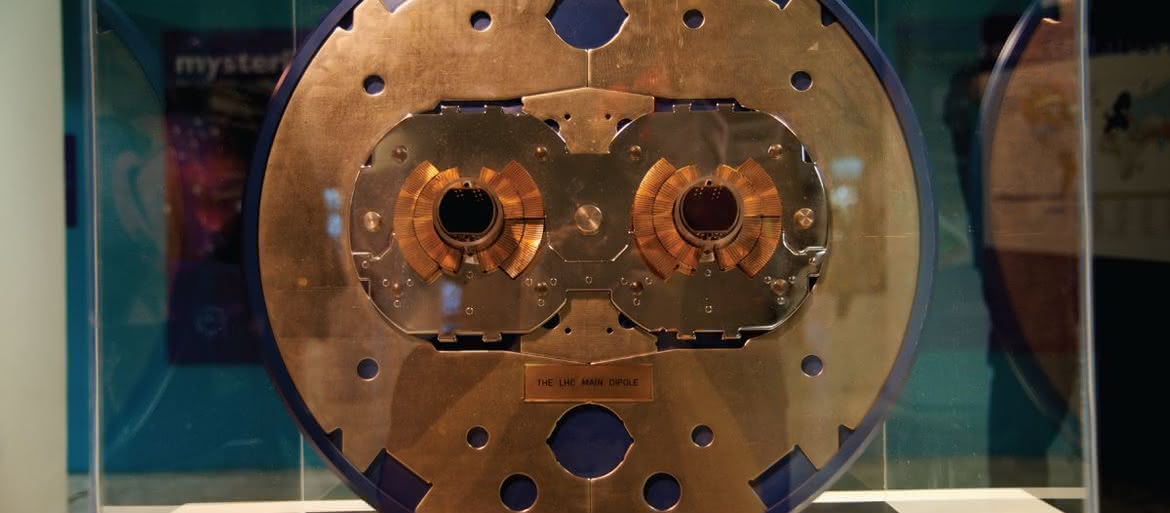

Elektromagnesy najważniejsze

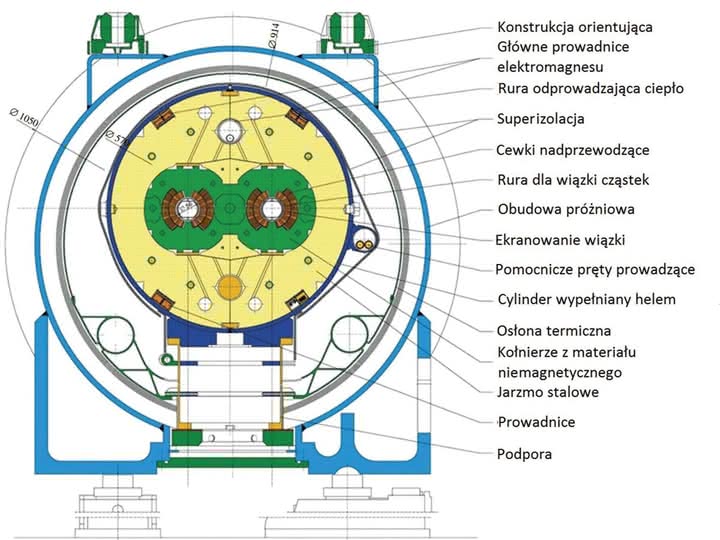

Wspomniane elektromagnesy, których długość wynosi 15 m, a masa 35 ton, wspierają się na potężnych dźwigarach przymocowanych do betonowych elementów konstrukcji tunelu. Jeszcze przed przerwą, po awarii we wrześniu 2008 r., LHC został wyposażony w specjalny system czujników i obwód bezpieczeństwa do detekcji najdrobniejszych wzrostów napięcia w sieci.

Podczas ostatniej przebudowy wymieniono lub wzmocniono ponad 10 tys. obwodów łączących elektromagnesy ze sobą, co zespołowi liczącemu 250 osób zajęło rok pracy.

Już od czerwca 2014 r. trwa proces schładzania magnesów w celu osiągnięcia operacyjnej temperatury 1,9 Kelwina przez pompowanie do systemu ciekłego helu (3).

W tej temperaturze osiąga się nadprzewodnictwo. Aby skutecznie przeprowadzić operację schładzania, specjaliści podzielili przestrzeń LHC na osiem sekcji. W każdej można obniżać temperaturę w sposób niezależny.

Schłodzenie każdej z owych odgrodzonych części oddzielnie zajmuje ok. dwóch miesięcy. Potem przeprowadzane są testy elektryczne w warunkach wysokoenergetycznych. Gdy energia wiązki sięga 6,5 TeV, notuje się spontaniczne przerwy w działaniu elektromagnesów.

Potrafią tracić też właściwości nadprzewodzące. Specjaliści w LHC nie określają jednak takich wypadków jako awarii. System musi przejść po prostu nieco cykli próbnych włączeń i testów, aby zacząć funkcjonować bez zakłóceń.

W LHC występuje wielka różnorodność magnesów - dipole, kwadrupole, sekstupole, oktupole, dekapole itd., co daje ogólną liczbę ok. 10 tys. Każdy z elektromagnesów ma swój wkład w optymalizację trajektorii cząstek (4).

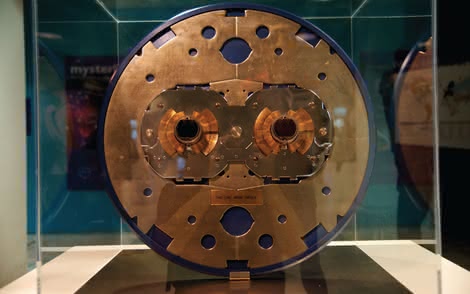

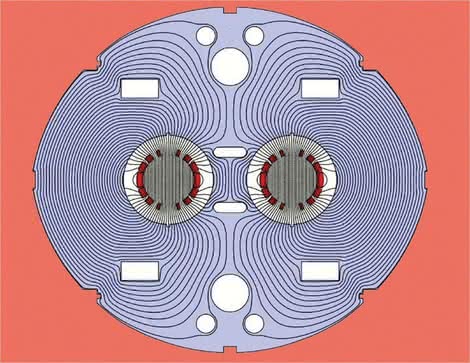

Większość magnesów korekcyjnych jest osadzona w chłodzonej części głównych dipoli i kwadrupoli. Magnesy LHC mają albo szczelinę podwójną (np. główne dipole), albo pojedynczą (niektóre z kwadrupoli wejściowych).

Kwadrupole wejściowe są to specjalne magnesy stosowane do ogniskowania wiązki tak, żeby miała możliwie najmniejsze rozmiary w punktach zderzenia, maksymalizując w ten sposób szansę czołowego zderzenia dwóch biegnących naprzeciw siebie protonów.

Największe magnesy to dipole, których jest 1232. Właśnie dipole (5) stanowiły najważniejsze wyzwanie technologiczne przy projektowaniu LHC. W akceleratorze protonów, takim jak LHC, maksymalna energia, jaką można osiągnąć, jest wprost proporcjonalna do natężenia pola magnetycznego dipola (6) przy danym obwodzie akceleratora.

Elektromagnesy nadprzewodzące w LHC mogą wytworzyć silne pole magnetyczne o natężeniu 8,3 tesli na całej swojej długości (7). W dipolach LHC zastosowano kable niobowo-tytanowe (NbTi), które w temperaturach poniżej 10 K (-263,2°C) stają się nadprzewodnikami, tzn. przewodzą elektryczność bez oporu.

W rzeczywistości LHC będzie pracować w temperaturze, która jest nawet niższa od temperatury panującej w przestrzeni kosmicznej (2,7 K, czyli -270,5°C). W dipolach płynie prąd o natężeniu 11 700 amperów, który wytwarza silne pole magnetyczne o natężeniu 8,3 T, konieczne do zakrzywiania wiązki o energii 7 TeV wokół 27-kilometrowego pierścienia LHC.

Gdyby magnesy pracowały w temperaturze 4,5 K (-268,7°C), wytwarzałyby pole magnetyczne o natężeniu tylko 6,8 T. Maksymalne natężenie prądu w przeciętnym domu mieszkalnym wynosi ok. 60 A.

Cewki magnetyczne dla LHC nawinięte są z kabla zawierającego do 36 skręconych 15-milimetrowych żył, z których każda zrobiona jest z 6000-9000 pojedynczych włókien o średnicy 7 mikrometrów (dla porównania ludzki włos ma ok. 50 mikrometrów grubości).

27-kilometrowy obwód LHC potrzebuje ok. 7600 km kabla, co odpowiada ok. 270 tys. km żyły. LHC jest największym systemem chłodzenia w świecie i jednym z najzimniejszych miejsc na Ziemi. Tak niska temperatura potrzebna jest do pracy magnesów, które utrzymują protony na torze.

Aby zapewnić 27-kilometrowemu pierścieniowi (4700 ton materiału w każdym sektorze) cały czas temperaturę nadciekłego helu 1,9 K (-271,3°C), układ chłodzący LHC musi dostarczyć całkowitej mocy chłodzenia - ok. 150 kilowatów dla chłodziarek o temperaturze 4,5 K i 20 kilowatów dla tych o temperaturze 1,9 K.

Klasyczna newtonowska zależność pomiędzy prędkością i energią kinetyczną (K = (1/2)mv²) obowiązuje tylko dla prędkości dużo mniejszych od prędkości światła.

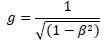

Dla cząstek poruszających się z prędkością bliską prędkości światła musimy zastosować równanie szczególnej teorii względności K = (g - 1)mc², gdzie c jest prędkością światła (299 792 458 m/s), g związane jest z prędkością wzorem b = v/c, a m równe jest masie cząstki w spoczynku.

Układ systemu chłodzącego oparty jest na pięciu "wyspach kriogenicznych", z których każda musi rozprowadzać chłodziwo i przenosić kilowaty mocy chłodzącej na dalekie odległości.

Proces chłodzenia przebiega w trzech fazach: ochłodzenie do temperatury 4,5 K (-268,7°C), wypełnienie ciekłym helem chłodzonej masy magnesów, ostateczne ochłodzenie do temperatury 1,9 K (-271,3°C).

Pierwsza faza przebiega w dwóch etapach: najpierw hel ochładzany jest do temperatury 80 K w wymiennikach ciepła chłodziarki, korzystających z 10 tys. ton ciekłego azotu.

Następnie turbiny chłodzące obniżają temperaturę helu do 4,5 K (-268,7°C), przygotowując wprowadzenie go do chłodzonej masy magnesów.

Gdy tylko magnesy są wypełnione, urządzenia chłodzące obniżają temperaturę do 1,9 K (-271,3°C). Całkowita ilość potrzebnego helu będzie wynosiła ok. 120 ton, z czego 90 ton zostanie wykorzystane w magnesach, a reszta w rurach i jednostkach chłodzących.

Płynny azot nigdy nie jest bezpośrednio wprowadzany do LHC, żeby uniknąć jakiejkolwiek możliwej przyczyny "uduszenia" w tunelu podziemnym.

Aby utrzymać temperaturę pracy magnesów na poziomie 1,9 K, cały układ chłodzący będzie potrzebował ok. 40 tys. szczelnych połączeń rur i 120 ton helu dla całego LHC.

W czasie normalnej pracy większość helu będzie krążyć w zamkniętych pętlach obiegu chłodziarek. Wybór temperatury pracy LHC wynika z konieczności zastosowania helu o "super" własnościach, jak i nadprzewodzącego stopu niobowo-tytanowego w cewkach magnesów.

Przy ciśnieniu atmosferycznym hel w stanie gazowym skrapla się w temperaturze ok. 4,2 K (-269,0°C), lecz gdy jest chłodzony w dalszym ciągu, ulega drugiemu przejściu fazowemu w stan nadciekłości w temperaturze ok. 2,17 K (-271,0°C).

Wśród wielu ważnych własności nadciekły hel wykazuje bardzo wysokie przewodnictwo cieplne, dlatego został wybrany jako środek chłodzący i stabilizujący wielkie układy nadprzewodzące.

Stąd: 1 eV = (1,602 × 10-19 C) x (1 V) = 1,602 x 10-19 J. W fizyce stosuje się wiele jednostek energii. Dżule, kalorie i kilowatogodziny są jednostkami używanymi w rożnych kontekstach. Tylko dżul należy do międzynarodowego układu jednostek (SI), ale wszystkie jednostki są między sobą powiązane poprzez współczynniki konwersji.

W fizyce cząstek najczęściej używaną jednostką energii jest elektronowolt (eV) i jego wielokrotności: keV (10³ eV), MeV (106 eV), GeV (109 eV) i TeV (10¹² eV). Elektronowolt jest "wygodną" jednostką, ponieważ w jednostkach powszechnie używanych energie cząstek - z którymi mają do czynienia fizycy - są bardzo małe.

Jeżeli weźmiemy jako przykład LHC, to całkowita energia zderzenia ma wynosić 14 TeV, co czyni to urządzenie najpotężniejszym w świecie. Gdy tę wartość energii zamienimy na dżule, to otrzymamy: 14 x 10¹² x 1,602 x 10-19 = 22,4 x 10-7 dżuli. Jest to bardzo mała ilość energii w porównaniu np. do energii obiektu ważącego 1 kg i spadającego z wysokości 1 m, wynoszącej: 9,8 dżuli = 6,1 x 1019 elektronowoltów.

Komputery mają co przetwarzać

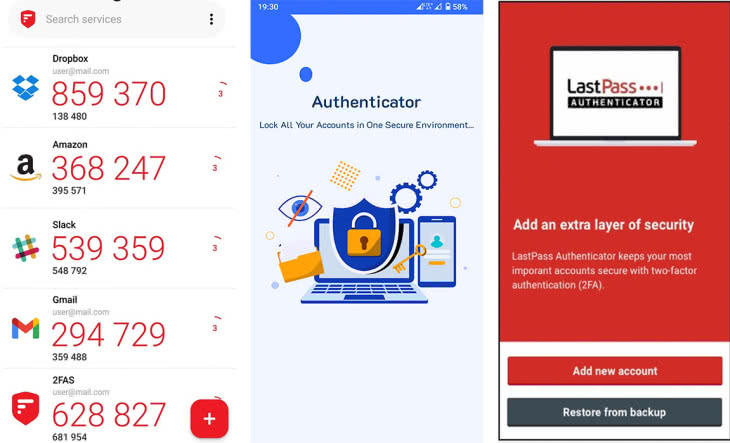

Jedną z istotnych zmian konstrukcyjnych będzie teraz dodanie do układu detektora CMS (Compact Muon Solenoid) czterech komór, których zadaniem jest wyłapywanie mionów i spełnianie funkcji swoistego "spustu".

Bo, jak podkreśla w rozmowie z magazynem "Nature", Tiziano Camporesi, nowy szef projektu CMS, nie tylko o zwiększenie mocy wiązek i zderzeń chodziło w przebudowie Zderzacza, ale również o nowe sposoby odfiltrowywania danych.

Wraz ze zwiększeniem energii wiązek wzrośnie liczba protonów w nich przyspieszanych i następnie wchodzących w kolizje. Jak się przewiduje, w CMS można liczyć na miliard do dwóch miliardów kolizji na sekundę.

Zadaniem spustu będzie selekcja kolizji do dalszej analizy. Celem tego "filtra" jest zredukowanie liczby analizowanych wydarzeń do kilkuset na sekundę. Zmniejszenie liczby danych ma głęboki sens, o czym dobrze wiedzą specjaliści od komputerowej obróbki pozyskanych w LHC danych.

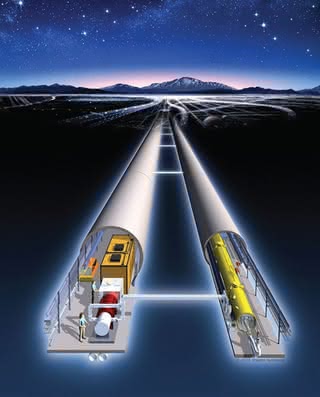

"Surówka", czyli elektroniczne sygnały z detektorów, płyną przez sieć światłowodowych połączeń do głównego kampusu CERN i centrum komputerowego (8), gdzie przetwarzaniem ich zajmuje się ok. 100 tys. procesorów.

Identyfikacji, pomiaru energii i kierunku ruchu każdej zarejestrowanej cząstki dokonuje się poprzez algorytmy. Rezultaty obliczeń zapisywane są na taśmie magnetycznej - brzmi to może nieco staroświecko, ale okazuje się, że jest to tania i trwała metoda magazynowania danych, przynajmniej w CERN.

Dane te - jak wspomnieliśmy wcześniej - są udostępniane tysiącom uczonych na całym świecie, a od niedawna również każdemu chętnemu. W celu dystrybucji informacji naukowej CERN utworzył Worldwide Computing Grid - sieć trzynastu rozsianych po świecie wielkich centrów komputerowych, które z kolei łączą się z mniejszymi klastrami, rozmieszczonymi w liczbie 150, głównie w uczelniach.

Zainteresowany analizą danych fizyk przesyła do tej sieci swój program - algorytm badawczy - i określa, jakie rodzaje kolizji chce analizować. Oprogramowanie zarządzające siecią wyszukuje centrum danych dysponujące wymaganą mocą obliczeniową.

W wybranym momencie w sieci CERN może wykonywać się równocześnie nawet kilkanaście tysięcy różnych programów badawczych.

Podczas etapu LHC 1.0, pomimo stosowania "spustów", czy też filtrów, o których była mowa, kompleks Zderzacza generował 15 petabajtów danych na rok, czyli więcej niż ważą wszystkie filmy wrzucane w tym samym czasie do serwisu YouTube.

Restart LHC i planowane podwojenie liczby wyłapywanych wydarzeń da ok. 30 petabajtów rocznie, czyli dostawę danych w tempie jednego gigabajta na sekundę. Nic dziwnego, że CERN rozbudowuje swoje centrum obliczeniowe i zdolności przesyłowe sieci.

Jego genewska siedziba (9) połączyła się np. niedawno za pomocą dwóch światłowodów o szybkości transferu 100 gigabitów na sekundę z hubem w Budapeszcie. A jednak jeśli chodzi o możliwości obliczeniowe i samą sieć, już teraz trzeba myśleć o kolejnych etapach rozbudowy LHC.

Może to w efekcie wywołać konieczność obsługi na początku przyszłej dekady aż 110 petabajtów danych na rok, a potem nawet i 400! Obecnie istniejący system komputerowy i sieć nie dałyby rady ocenie takich ilości danych.

Specjaliści w CERN martwią się, że stagnacja panująca w ostatnich latach w dziedzinie nowych technologii procesorowych nie wróży im niczego dobrego. Producenci chipów zwiększają ich możliwości przez dodawanie kolejnych procesorów do jednostek obliczeniowych.

Niewiele to jednak daje systemowi obsługującemu Wielki Zderzacz Hadronów. Jego kod został bowiem napisany w ten sposób, że obsługiwany może być tylko przez jeden procesor w danym momencie. Przestawienie na przetwarzanie paralelne oznaczałoby konieczność zmiany 15 milionów linii kodu pisanego przez tysiące ludzi przez wiele lat.

Mimo to nie warto popadać z tego powodu w czarny pesymizm. Pamiętajmy, że gdy fizycy z CERN potrzebowali pod koniec lat 80. XX wieku nowego, efektywnego sposobu wymiany informacji, powstał World Wide Web, czyli Internet, jaki potem poznaliśmy i zaczęliśmy powszechnie używać.

W latach 90. potrzeba było udoskonalić metody dostępu do danych komputerowych i wtedy właśnie w Internecie stworzono największą sieć obliczeniową na świecie. Naukowcy są pewni, że i tym razem nie tylko poradzą sobie z problemami, ale opracują wyprzedzające epokę rozwiązanie.

Chmura obliczeniowa OpenStack wykorzystywana przez CERN liczyła dotychczas 75 tys. rdzeni roboczych w ponad 3 tys. serwerów, plus dodatkowo 45 tys. rdzeni.

Tim Bell, odpowiedzialny za OpenStack zapowiada, że przed ponownym uruchomieniem LHC w pierwszym kwartale 2015 r. liczba rdzeni obliczeniowych obsługujących użytkowników systemu ma sięgnąć 150 tys. rdzeni.

• Silne oddziaływania wiążą ze sobą kwarki, aby utworzyć protony, neutrony i inne cząstki. Wiążą one również protony i neutrony w jądra, gdzie pokonują ogromne odpychanie elektryczne pomiędzy protonami. Nośniki: gluony.

• Oddziaływania elektromagnetyczne wiążą elektrony z jądrami w atomach i wiążą atomy w cząsteczki; są również odpowiedzialne za właściwości ciał stałych, cieczy i gazów. Nośniki: fotony.

• Słabe oddziaływania są odpowiedzialne za naturalną promieniotwórczość, np. ziemi, która jest pod naszymi stopami. Odgrywają również zasadniczą rolę w oddziaływaniach jądrowych wewnątrz takich gwiazd, jak Słońce, gdzie wodór jest zamieniany w hel. Nośniki: pośredniczące bozony wektorowe.

• Grawitacja powoduje, że jabłko spada na ziemię. Jest to siła przyciągająca. W skali astronomicznej wiąże ona materię w planetach i gwiazdach, a także łączy gwiazdy w galaktyki. Nośniki: grawitony.

Jeszcze dalej w przyszłość

LHC to dopiero początek drogi badawczej: ma posłużyć jeszcze 20 lat, w drugiej odsłonie zwiększyć energię zderzeń do docelowej (14 TeV), a od 2024 r. liczba zderzeń rejestrowanych podczas eksperymentów ma zwiększyć się dziesięciokrotnie.

Będzie to tzw. Wielki Zderzacz Hadronów o Wysokiej Świetlności, znany pod angielską nazwą High Luminosity Large Hadron Collider (HL-LHC), wcześniej nazywany także Super Large Hadron Collider (SLHC).

W lutym 2014 r. na Uniwersytecie Genewskim odbyło się spotkanie grupy naukowców, którzy będą pracować nad przyszłymi fundamentalnymi projektami badań w CERN (w ramach Europejskiej Strategii Rozwoju Fizyki Cząstek Elementarnych).

Jednym z pomysłów jest zbudowanie podobnego do LHC kołowego zderzacza hadronów o obwodzie od 80 do 100 km (10). Jego średnica wyniosłaby ok. 30 km.

Według założeń programu FCC (Future Circular Colliders, czyli Kołowych Zderzaczy Przyszłości), energie zderzeń w nowym urządzeniu mają dochodzić nawet do 100 TeV.

Jednocześnie naukowcy od kilku lat pracują nad pomysłem liniowego zderzacza - Compact Linear Collider, znanego jako CLIC (11). Ma on opierać się na nowatorskiej technologii przyspieszania.

Na razie trwają badania nad potencjałem i kosztami takiego rozwiązania. Fizycy wiedzą, że o następcy LHC trzeba myśleć już teraz. Wstępna koncepcja Wielkiego Zderzacza Hadronów pojawiła się w latach 70. XX w., a prace projektowe rozpoczęły się w następnej dekadzie.

Zatem cykl projektowania i budowy takiego urządzenia wynosi 30-40 lat. Czy coś może powstrzymać fizyków przed tworzeniem coraz to większych urządzeń badawczych? Chyba tylko ograniczenia budżetowe.