Fotografia epoki smartfonów

Czy świat cyfrowej fotografii i smartfonowych kamer z aplikacjami jest słusznie krytykowany? Przecież dzięki tym technologiom różne formy i techniki robienia zdjęć stają się dostępne dla każdego. Weźmy np. fotografie panoramiczne. Kiedyś potrzeba było specjalistycznego sprzętu, wysokiego kunsztu montażowego i wielkich umiejętności, aby takie obrazy tworzyć. Dziś wystarczy włączyć odpowiedni tryb, appkę i obracać się z aparatem w dłoni na jednej nodze wzdłuż własnej osi. Zastosowany przez producenta algorytm nie tylko skleja obrazy, ale również usuwa niektóre, wynikające z robienia zdjęcia "na oko", niedoskonałości.

Podobnie "samo się robi" wszystko lub prawie wszystko w lubianym przez wielu trybie HDR (ang. High Dynamic Range Image), w którym wysoko kontrastowe fotografie powstają przez łączenie kilku różnych zdjęć tego samego obrazu (1). Przynajmniej jedno z ujęć ma długi czas naświetlania do ekspozycji bardziej zacienionych obszarów, a jedno - krótki, ukazujący detale. Oczywiście całą tę robotę można by wykonać ręcznie. Fotografujący, umiejętnie i szybko manipulując czasami naświetlania i otwarciem przysłony, zrobiłby kilka ujęć, a następnie osoba biegła np. w Photoshopie nałożyłaby je na siebie. Tylko po co, skoro smartfonowi wystarczy na to chwila?

Sztuczna fotograficzna inteligencja

Technologie idą jednak dalej, zamieniając się powoli w sztuczną fotograficzną inteligencję i poprawiając liczne niedoskonałości amatorskich zdjęć. Nowe aplikacje korygują wady, wynikające z samej natury fotografii wykonywanych z wykorzystaniem niewielkiej optyki, będącej do dyspozycji w aparatach komórkowych. Rozmywające się brzegi obrazu nie są problemem w profesjonalnych dużych lustrzankach, ale gdy ma się tyle miejsca na obiektyw, ile jest w cienkim smartfonie, to optyki się nie da oszukać. Czy jednak naprawdę?

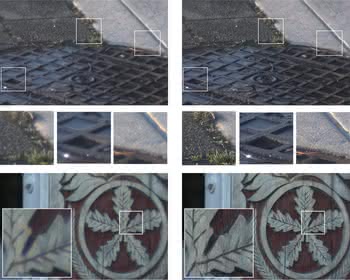

Wolfgang Heidrich, naukowiec związany z Uniwersytetem w Thuwal w Arabii Saudyjskiej, pracuje nad algorytmem poprawiającym te aberracje optyczne, nieuniknione przy miniaturyzacji. Działa on przez korekcję podstawowych kolorów RGB - czerwonego, zielonego i niebieskiego. Efektem, nawet przy marnej jakości soczewkach, staje się obraz ostry jak żyletka (2).

Inną typową przyczyną nieostrości są poruszenia. I na to znajdzie się sposób. Tak przynajmniej obiecuje firma Kari Pulli z Kalifornii, opracowując mechanizm, który we współpracy z żyroskopem aparatu, koryguje rozmycia wynikające z ruchu, nie zabijając jednak samego efektu ruchu na fotografii.

Są tacy, którzy uważają, że smartfonowo-aplikacyjna foto-rewolucja to coś więcej niż korekcja błędów i niedoskonałości, wynikłych z braku wprawy lub czasem pecha. Według nich zmienia się całkowicie "paradygmat" fotografii. Nie decydują już bowiem moment robienia zdjęcia i panujące okoliczności, lecz późniejsze działania. Dopiero po "pstryknięciu" wybieramy, jakie powinny być kompozycja, a nawet temat zdjęcia.

Świat z filtrem

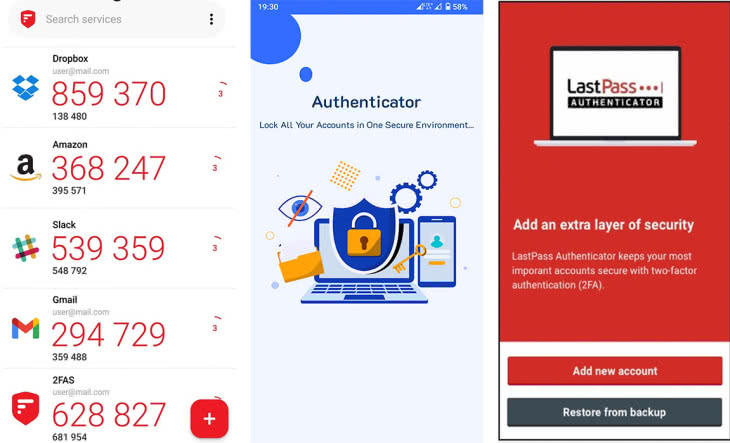

Najbardziej znaną użytkownikom smartfonów lub tabletów formą przetwarzania rzeczywistości na inną (lepszą?) są filtry w aplikacjach foto. Można więc robić zdjęcia komórką, następnie przekolorować je na np. wyblakłe, dodać gustowną ramkę i upiększyć swój autoportret (3), a następnie wszystko to udostępnić społecznościom internetowym i mobilnym, za pomocą np. aplikacji Instagram.

Wysyp mobilnych aplikacji na najbardziej popularnych platformach mobilnych iOS i Android to już wcale nie takie świeże zjawisko. Pozwalają one wykonywane za pomocą smartfonów zdjęcia edytować, przerabiać, czasem dodatkowo ozdabiać, dodawać opisy i osobiste komentarze, a następnie publikować w serwisach społecznościowych. Instagram i Path pojawiły się jesienią 2010 r.

Znany z iPhone'ów Hipstamatic, zamieniający nasze fotki w obrazki w stylu retro, był dostępny w App Store wcześniej. Wielu narzeka, że technologie, tendencje i mody w Internecie zmieniają się tak szybko, iż trudno za nimi nadążyć. Co więc powiedzieć o świecie mobilnym, świecie smartfonów, tabletów i setek tysięcy aplikacji, w którym tempo zmian powoduje, że tradycyjny Internet zdaje się poruszać w ślimaczym tempie? Bo już po Instagramie i Hipstamatic'u mieliśmy wysyp kolejnego, a potem jeszcze następnego pokolenia foto-aplikacji, które mogą więcej, oferują nowe rozwiązania i funkcje, imponują ciekawszymi niż poprzednie technologiami.

Może to trochę dziwne, ale sporo funkcji w filtrach foto-aplikacji polega na "zepsuciu" zdjęcia, z punktu widzenia klasycznej sztuki robienia zdjęć. Kolejne tło, które nakładają na wykonaną fotografię niektóre filtry aplikacji Instagram, daje efekt rozmycia, większego ziarna, szumu i nawet podniszczenia obrazu (4). Purystom może to nie w smak, ale cóż, taka moda. Część filtrów oferowana przez Instagram, podobnie jak wiele innych mobilnych aplikacji foto, ujmuje zdjęcia w różne rodzaje ramek, winietuje je (5) itd.

A technika wciąż się rozwija. Opracowany na amerykańskim Uniwersytecie Brown algorytm komputerowy potrafi zmienić wykonywane przez nas zdjęcia tak diametralnie, że wyglądają na zrobione w zupełnie innej porze roku niż w rzeczywistości. Przez manipulacje oświetleniem zmienia się diametralnie warunki pogodowe i porę dnia (6). Program działa w oparciu o wprowadzanie prostych, naturalnych komend głosowych. Jeśli chcemy np. ze słonecznej fotografii zrobić zdjęcie w deszczu, wpisujemy po prostu "więcej deszczu" (ang. more rain).

Algorytm nie działa jednak tak prosto, jak to wygląda z punktu widzenia użytkownika. Tworzenie pochmurnego dnia na słonecznej fotografii to nie tylko zmiana koloru nieba, ale znacznie subtelniejsze modyfikacje wielu innych fragmentów zdjęcia. Jak mówią twórcy oprogramowania, wykorzystali oni techniki uczenia komputera, na czym określone zmiany polegają (machine learning). Celem programu jest uproszczenie technik edycji zdjęć i udostępnienie zwykłym użytkownikom funkcji dostępnych dotychczas tylko fachowcom.

Koniec z tradycyjną optyką

Poprawne operowanie głębią ostrości to trudna sztuka w tradycyjnych aparatach. Tymczasem w aparacie Lytro w ogóle nie trzeba się tym martwić, gdyż "zdejmuje" on ostry obraz na wszystkich widzianych w obiektywie planach.

Dopiero w obróbce komputerowej decydujemy, które przedmioty będą ostre. Przed matrycą znajduje się tzw. soczewka plenoptyczna składająca się z kilkuset tysięcy mikrosoczewek. Każda taka mikrosoczewka obejmuje fragment matrycy światłoczułej.

Na matrycy zostają więc zarejestrowane nie pojedyncze piksele, ale setki miniobrazków będących wycinkami całej fotografii. Dzięki temu matryca światłoczuła rejestruje znacznie więcej informacji, które można wykorzystać do przetwarzania fotografii (np. zmiany głębi ostrości) już po jej wykonaniu.

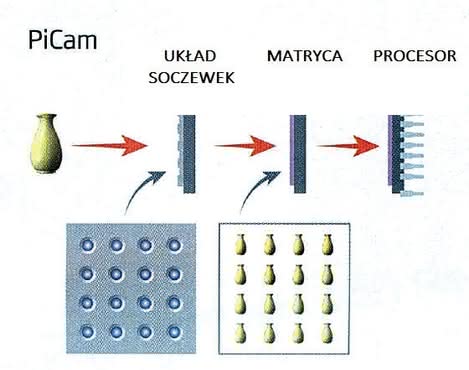

Podobnie do Lytro działa technika PiCam, zaprojektowana do smartfonów, która zastępuje pojedyncze soczewki panelem z szesnastoma małymi szkłami (7).

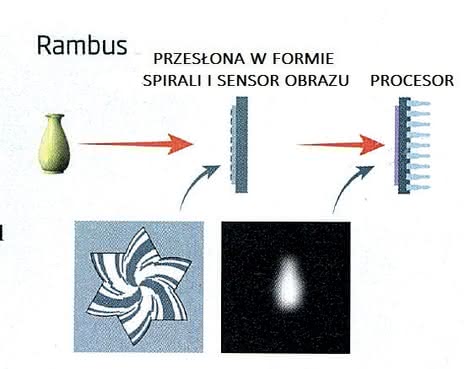

Obraz przedostaje się przez każde z nich pod nieco innym kątem, trafiając następnie na światłoczułą matrycę, skąd dane o wielu wygenerowanych obrazach trafiają do procesora, który przetwarza je w jeden obraz o znacznie powiększonej głębi. Można też wrócić do źródeł i do najprostszej metody fotografii, bez optyki w ogóle. Oczywiście, współcześni wynalazcy dodają do prostoty najnowszą elektronikę i powstaje taki system jak Rambus, który zamiast soczewki ma tylko spiralną aperturę (8).

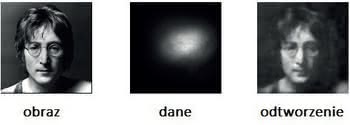

Obraz na matrycy zyskuje postać wzorów podobnych do płatków śniegu, które razem tworzą rozmyte odbicie obiektu, przetwarzane potem w celu odwzorowania tego, co "widzi" kamera (9). Powstaje coś, co mocno odbiega od widzianego przez nas obrazu i tego, co rejestruje tradycyjna fotografia, ale z drugiej strony, nie chodzi przecież o wierne obrazowanie tylko o zabawę obrazem. Patrick Gill, współautor projektu Rambus, przekonuje, że to optyka w aparacie zniekształca i zmienia obraz, a jego technologia pokazuje to, co rzeczywiście widzi kamera - odtąd możemy ten maszynowy obraz zobaczyć sami.

Ujrzeć niewidzialne

W przypadku Rambusa, patrząc "okiem" maszyny, widzimy, jak się zdaje, mniej. Jednak maszyna może zobaczyć więcej niż my i wtedy powyższa filozofia nabiera innego sensu. Japońska firma Komamura, specjalizująca się w urządzeniach noktowizyjnych, skonstruowała kamerę, która potrafi rejestrować barwny obraz o jakości HD w warunkach nocnych. Japończycy porównują wyniki zapisu obrazu z obrazem z kamery Canon FS-100. Jakość i naświetlenie szczegółów na filmie nakręconym za pomocą "sokolego oka" (choć może właściwszą nazwą byłoby "sowie oko") to zupełnie inna, lepsza klasa niż zapewnia nie najgorsza przecież kamera Canona. Dodatkowo nocny obraz jest barwny, co bardzo różni go od np. termowizyjnych kamer oferujących zwykle jeden kolor - zielony - w wielu odcieniach. Tak doskonałe odwzorowanie nocnego widoku od razu nasuwa myśli o możliwych zastosowaniach technologii np. w wojsku lub w kamerach monitoringu.

System, który pozwala zobaczyć to, co jest za rogiem, czyli rzeczy dla nas niewidzialne, bez używania lusterka, skonstruowali naukowcy z uniwersytetów w niemieckim Bonn i kanadyjskiej Kolumbii Brytyjskiej. Opiera się na odtwarzaniu obrazów poza polem widzenia, za pomocą rozproszonego światła. Technika wykorzystuje laserową wiązkę rzucaną na ścianę, która zasłania obiektywowi kamery obiekt, który ma zostać zaobserwowany. Początkowo w wizjerze kamery widać po prostu ścianę. Jednak po chwili, gdy zaczynają działać subtelne algorytmy matematyczne, wykrywające tzw. echo obrazu, czyli niewielkie ilości światła odbite od obiektu, rozproszone a następnie padające na powierzchnię ściany - zaczynamy dostrzegać kształty schowane za rogiem!

Okazuje się, że urządzenie zbiera wiele różnych odbić światła i sumuje je, starając się wytworzyć wypadkową, czyli zarys obrazu. To właśnie oddzielenie kształtu, o który chodzi, od szumu jest największym wyzwaniem. Oprogramowanie opracowane przez Niemców i Kanadyjczyków radzi sobie z nim najlepiej ze znanych na świecie rozwiązań. Oczywiście obrazy uzyskane w ten sposób są raczej zarysami, jednak bez wątpienia pokazują to, co dotychczas było niewidzialne (10).