Najnowsza internetowa wojna na górze. Premium czy klasa ekonomiczna?

Microsoft już w styczniu 2023 r. rzucił wyzwanie Google’owi (1) i jego wyszukiwarkowej dominacji, integrując ChatGPT z wyszukiwarką Bing. Google nie zdecydowało się na szybką ripostę. Oświadczyło, że nie będzie od razu uruchamiać własnego produktu tej klasy z powodu "ryzyka utraty reputacji", ponadto jego reprezentanci wygłosili szereg kąśliwych uwag na temat stronniczości i trafności odpowiedzi chatbotów AI, co miało dowodzić, że nie są jeszcze gotowe do zastąpienia wyszukiwarek internetowych. W trzeciej dekadzie marca Google udostępniło swojego Barda (2), jednak jedynie dla wyselekcjonowanej grupy użytkowników testowych. Pierwsze publikowane w serwisach internetowych wyniki testów "odpowiedzi Google’a na ChatGPT" sugerowały, że potrafi mniej niż usługi OpenAI i Microsoftu.

Microsoft jest obecnie związany biznesowo z OpenAI, która tworzy kolejne wersje modelu GPT (w marcu z dużym hałasem wprowadzono GPT-4). Zainwestował w nią miliard dolarów w 2019 roku, a w ostatnich miesiącach kolejne dziesięć miliardów dolarów, i ma ambitne plany rozwoju kolejnych produktów wykorzystujących modele AI, nie tylko wyszukiwarkę, ale także oprogramowanie Windows. W marcu 2023 r. dodał do wyszukiwarki Bing kolejny po usłudze chatu model tekstowo-obrazowy AI, zasilany przez DALL-E 2 również autorstwa OpenAI. Microsoft poczynił już wcześniej znaczące inwestycje w sztuczną inteligencję i jest głównym graczem w ekosystemie AI poprzez swoją platformę chmurową Azure. Opracował również szereg produktów AI, takich jak Cognitive Services, które zapewniają wstępnie zbudowane modele AI dla wizji, mowy, języka i podejmowania decyzji.

Warto przypomnieć, że zręby konwersacyjnych interfejsów wspomaganych przez sztuczną inteligencję w wyszukiwaniu informacji i korzystaniu z aplikacji użytkowych zostały nakreślone przez szefa Microsoftu, Satyę Nadellę jeszcze w 2016 r., w wywiadzie dla serwisu "The Verge". Zatem zapowiedź wprowadzenia zasilanych przez model AI okien dialogowych w Outlooku, Wordzie, Teamsami czy Excelem, to nie tyle nowe pomysły podjęte pod wpływem osiągnięć OpenAI i sukcesu ChatGPT, lecz kontynuacja dłuższej strategii.

Google ma tylko dwa lata?

A co z Google’em? Twórca poczty Gmail, Paul Buchheit, mówił w ostatnim czasie w mediach, że Google dzieli zaledwie rok lub dwa lata od "całkowitej zapaści". Powodem ma być rewolucja chatbotów AI, które "zniszczą Google w taki sam sposób, jak wyszukiwarka internetowa zabiła ogłoszenia drobne". Większość przychodów Google’a pochodzi ze sprzedaży reklam w jego własnej wyszukiwarce. W 2021 roku, około 80 proc. z 257,64 mld dolarów przychodów Google pochodziło z reklam. "AI wyeliminuje mechanizm Search Engine Result Page (SERP), czyli to, na czym zarabia Google najwięcej. Nawet jeśli utrzymają się w nurcie rozwoju AI, to nie mogą jej w pełni wdrożyć bez zniszczenia najbardziej wartościowej części własnego biznesu", komentował Buchheit. Jego zdaniem, postępy w tej dziedzinie z pewnością zmienią sposób, w jaki ludzie uzyskują dostęp do informacji.

Już w marcowym wydaniu MT pisaliśmy o "czerwonym alarmie" w Google z powodu premiery ChatGPT i wszystkiego, co nastąpiło w konsekwencji tego wydarzenia. "The New York Times" donosił w styczniu 2023 r., że firma wezwała współzałożycieli Google'a Larry'ego Page’a i Sergeya Brina, by pomogli w rozwiązaniu problemu. W tym samym czasie spółka nadrzędna Google’a, Alphabet, zmniejszyła zatrudnienie (o 12 tysięcy pracowników), chociaż to akurat ostatnio typowe dla wielkich. Dziesięć tysięcy ludzi zwolnił Microsoft, Facebook też masowo zwalnia.

Nie można jednak powiedzieć, że Google zaspało kwestię AI. Od ponad dekady rozwija przecież pionierskie projekty w dziedzinie sztucznej inteligencji i to jego zespół opatentował najprężniejszą obecnie na tym obszarze technikę generatorów opartych na wielkich modelach językowych (LLM). Stworzony przez Google'a model LaMDA (Language Model for Dialogue Applications) miał swoją premierę i sporo medialnego rozgłosu już w pierwszej połowie 2022 r.

Już w 2012 roku Google zatrudniło Raya Kurzweila, informatyka i wizjonera "osobliwości" technologicznej, do pracy nad modelami przetwarzania języka. Rok później Google kupiło brytyjską firmę DeepMind, która miała (i wciąż ma) na celu stworzenie sztucznej inteligencji ogólnej. Jednak uczeni zatrudnieni w Google i eksperci w dziedzinie techniki powstrzymali projekty, które dziś określilibyśmy mianem prekursorów ChatGPT, ze względu na obawy etyczne wokół masowej inwigilacji. Google zobowiązało się do samoograniczeń w dziedzinie AI. W 2018 roku Google wycofało projekt dotyczący sztucznej inteligencji w projektach wojskowych na skutek buntu pracowników.

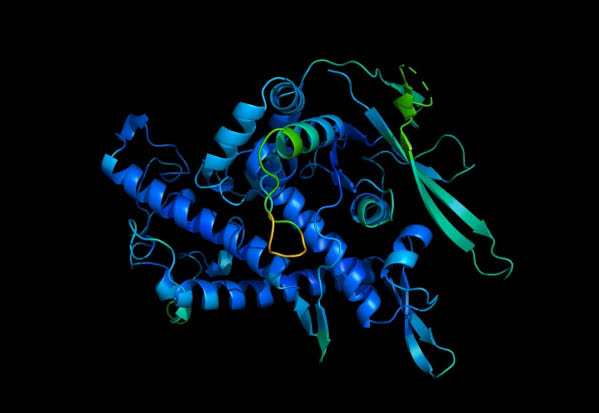

W zeszłym roku Deepmind zademonstrował GATO, wykazujący się niezwykłą płynnością w wielu zadaniach. Ta sama sieć może grać na Atari, podpisywać obrazy, czatować, układać klocki za pomocą ramienia robotycznego i wiele więcej, decydując na podstawie kontekstu. Na konto Google idą też postępy w modelowaniu białek, raka, matematyki i wiele innych.

AlphaFold stworzony przez DeepMind dokładnie przewiduje modele 3D struktur białkowych (3) i przyspiesza badania w prawie każdej dziedzinie biologii. Google ma listę programów AI, które planuje zaoferować twórcom oprogramowania i innym firmom, w tym technologii tworzenia obrazów, które mogłyby zwiększyć przychody do działu Cloud. Są też narzędzia, które pomogą innym firmom tworzyć własne prototypy AI w przeglądarkach internetowych, zwane MakerSuite, które będą miały dwie wersje "Pro".

W maju 2023 r. Google ma, według pogłosek, zapowiedzieć również narzędzie ułatwiające budowanie aplikacji na smartfony z systemem Android, o nazwie Colab + Android Studio, które będzie generować, uzupełniać i naprawiać kod. We wstępnych zapowiedziach mowa też o innym narzędziu do generowania i uzupełniania kodu, o nazwie PaLM-Coder 2. Warto dodać, iż specjaliści Google'a stoją za techniką AutoML-Zero, która służy do samodzielnego, bez ludzkiej interwencji, odkrywania algorytmów uczenia maszynowego. Opisuje się ją jako podłoże dla samoistnej ewolucji maszyn, które same opracowują nowe algorytmy pozwalające im się rozwijać i wzbogacać nowe możliwości.

Wyszukiwarkowy dominator buduje też od pewnego czasu AI tłumaczącą na tysiąc języków. W tej chwili model obsługuje ponad sto różnych języków. Google ogłosiło ów "Universal Speech Model" (USM) w listopadzie 2022. USM ma dwa miliardy parametrów i jest przeszkolony na 28 miliardach zdań pochodzących z ponad trzystu języków. Jego funkcje mają pozwalać na automatyczne rozpoznawanie mowy lub automatyczne generowanie napisów w filmach. Jeśli system będzie w stanie rejestrować i tłumaczyć w locie mowę w czasie rzeczywistym, to będzie coś, czego oczekuje się od lat i dekad. Co zgryźliwsi dodają - byleby tylko AI potrafiła też rozpoznać, czego nie tłumaczyć, bo ostatnią rzeczą, jakiej potrzebujemy, jest zalew tłumaczeń rozmów w tle i wtłaczanie tego wszystkiego do naszych uszu.

Na razie, pomimo wszystkich wymienionych wyżej osiągnięć i projektów, utrzymuje się wrażenie, że Google jest o krok do tyłu. W marcu OpenAI ogłosiła uruchomienie API GPT dla programistów oraz Whisper, modelu transkrypcji mowy, dodając również obsługę wtyczek do ChatGPT, co pozwoli AI na dostęp do internetu, bieżących i aktualnych informacji (zamiast, jak do tej pory, bazy danych obejmującej okres do końca 2021 roku). Wtyczki będą mogły asystować w zakupach lub w innych działaniach użytkowników w internecie, czasami nawet działając za użytkownika (co wzbudza kontrowersje). Kto nie widzi w tym zagrożenia dla cesarstwa Google’a, ten chyba nic nie widzi.

Co ciekawe, jak podał niedawno "The Wall Street Journal", inżynierowie Google’a, Daniel De Freitas i Noam Shazeer, opracowali przed laty konwersacyjnego chatbota AI, którego nazwali Meena z myślą o wykorzystaniu go w wyszukiwaniach sieciowych. Jednak wówczas kierownictwo Google'a nie pozwoliło udostępnić go publicznie ze względu na obawy dotyczące bezpieczeństwa. Zarząd udaremnił podejmowane przez inżynierów próby wysłania bota do zewnętrznych badaczy, dodania funkcji czatu do Asystenta Google i uruchomienia publicznego demo. Twórcy opuścili Google'a pod koniec 2021 roku, aby założyć własną firmę.

Teraz, według doniesień, Google inwestuje 300 milionów dolarów w Anthropic, startup złożony z weteranów OpenAI, twórcy ChatGPT. Założony jeszcze w 2021 roku Antropic stworzył coś podobnego do ChatGPT o nazwie Claude (w momencie przygotowania tego wydania MT jeszcze niedostępny publicznie). Jednak nie jest jasne, czy Google w ogóle planuje zintegrować Claude’a ze swoimi usługami, tak jak zrobił to, robi i zamierza robić Microsoft. Nie ma także pełnej jasności co do planów Google'a wobec wzmiankowanego Barda. Wiadomo, że Google testuje zmiany na swojej stronie głównej, z dodaniem być może jakiejś formy konwersacyjnego interfejsu.

Do ogólnego zamieszania dochodzą inne wydarzenia, takie np. jak wywiad szefa DeepMind (powiązanego z Google), Demisa Hassabisa, udzielony magazynowi "Time", w którym wspomniał o swoich zamiarach uruchomienia podobnego do GPT modelu w tym roku. Miałby to być model Sparrow, opisany w pracy badawczej DeepMind opublikowanej pod koniec 2022 roku. Został zaprojektowany tak, aby rozmawiać z użytkownikiem, odpowiadać na pytania i przeszukiwać Internet, używając Google'a do informowania o swoich odpowiedziach.

Wielkie poruszenie

Oczywiście także wielu innych potentatów technologicznych podejmuje działania i projekty, które mają w ich zamierzeniu pozwolić im utrzymać się na powierzchni pośród burzy zmian, która zaczęła się jeszcze w 2022 r.

Np. porównywalny na swoim rynku z Google chiński gigant Baidu zaprezentował w marcu 2023 r. nowy duży model językowy o nazwie Ernie Bot, który potrafi rozwiązywać zadania matematyczne, pisać teksty marketingowe, odpowiadać na pytania dotyczące chińskiej literatury i generować odpowiedzi multimedialne. Ernie Bot to skrót od angielskojęzycznej nazwy "Enhanced Representation from kNow-ledge IntEgration" i według doniesień z Kraju Środka nie jest jedynym tego typu projektem na tamtejszym rynku. Jedna z największych firm e-commerce, chińska Alibaba, opracowała szereg produktów AI, w tym napędzany przez model językowy chatbot do obsługi klienta, który może obsługiwać miliony zapytań klientów dziennie. Tencent, chiński potentat na rynku gier, również zaproponował chatbota AI do obsługi klienta.

Amazon ze swoim funkcjonującym od lat inteligentnym asystentem Alexa nie musi niczego w tej dziedzinie udowadniać a i tak pod wpływem ostatnich wydarzeń informuje o pracach nad podobnym do ChatGPT narzędziem oraz o współpracy z konkurencyjnych wobec OpenAI start-upem Stability AI, który m.in. stworzył generator obrazów Stable Diffusion.

Pośród ogólnego wielkiego poruszenia warto zwrócić uwagę, że bierności nie zachowują także nieco mniejsi, ale wciąż ważni w rozgrywce na rynku techniki internetowej i komputerowej, gracze. Próbująca coraz skuteczniej w ostatnich latach rywalizować z Google wyszukiwarka DuckDuckGo uruchomiła opartą na sztucznej inteligencji usługę DuckAssist, Adobe wprowadziła oparty na własnych zasobach i danych generator obrazów FireFly.

Eksperci i komentatorzy zwracają uwagę na brak wyraźnych sygnałów przejmowania się tym, co się dzieje ze strony Apple. Apple podobnie jak Amazon od lat rozwija opartego na AI asystenta o nazwie Siri. Ma liczny zespół specjalistów, ale jakoś nie wyrywa się do tworzenia produktu, który miałby być bezpośrednią odpowiedzią na ChatGPT. Zdaniem wielu publicystów jest tak zapewne dlatego, że jako producent sprzętu i systemu nie musi. Twórcy rozwiązań prawdopodobnie sami przyjdą do Apple z prośbą o zintegrowanie ich rozwiązań z produktami oznaczonymi jabłuszkiem. Zresztą, niewykluczone również, że Apple zaskoczy wszystkich już jesienią nową ofertą, która przyćmi generatory i modele innych firm.

Mająca długą historię projektów (ale również niepowodzeń) firma Meta, posiadaczka przede wszystkim Facebooka, w lutym 2023 r. zademonstrowała duży model językowy, który może działać na pojedynczym procesorze graficznym, co otwiera drzwi do wydajności podobnej do ChatGPT na sprzęcie klasy konsumenckiej.

LLaMA-13B podobno przewyższa możliwości ChatGPT, mimo że ma znacznie mniejsze rozmiary. Meta opracowała całą kolekcję modeli językowych LLaMA o rozmiarach od siedmiu do 65 miliardów parametrów. Dla porównania, model GPT-3 OpenAI - podstawowy model ChatGPT - ma 175 mld. Meta twierdzi, że wersja o wielkości 13 mld może być uruchomiona na pojedynczym procesorze graficznym Nvidii A100, który jest stosunkowo dostępny, kosztując kilka dolarów za godzinę wynajmu na platformach chmurowych, w licznych benchmarkach dla modeli językowych AI przewyższa kilkanaście razy większy modelu GPT-3 firmy OpenAI. LLaMA nie ma jednak formy chatbota. Jest to pakiet open source, do którego dostęp może uzyskać każdy. Polityka ta, jak twierdzi firma, ma na celu "demokratyzację dostępu" do AI i pobudzenie badań tej problematyki. Meta opracowała również szereg innych produktów AI, choćby DeepFace, oprogramowanie do rozpoznawania twarzy, które może rozpoznawać twarze z dużą dokładnością.

Parametr jest zmienną, którą model uczenia maszynowego wykorzystuje do przewidywania lub klasyfikacji na podstawie danych wejściowych. Liczba parametrów w modelu językowym jest kluczowym czynnikiem wpływającym na jego wydajność, przy czym większe modele są zazwyczaj w stanie poradzić sobie z bardziej złożonymi zadaniami i wytworzyć bardziej spójne dane wyjściowe. Większa liczba parametrów zajmuje jednak więcej miejsca i wymaga więcej zasobów obliczeniowych do uruchomienia. Jeśli więc model może osiągnąć takie same wyniki jak inny model z mniejszą liczbą parametrów, stanowi to znaczący wzrost wydajności. "Uważam, że w ciągu roku lub dwóch będziemy uruchamiać modele językowe o znacznej części możliwości ChatGPT na własnych (najwyższej klasy) telefonach komórkowych i laptopach", napisał niezależny badacz AI Simon Willison w serwisie Mastodon, analizując znaczenie nowych modeli AI firmy Meta.

Udostępnienie w modelu open source jest możliwe, gdyż Meta szkoliła swoje modele LLaMA, używając publicznie dostępnych zbiorów danych, takich jak Common Crawl, Wikipedia i C4. Byłoby to nowością w branży, w której do tej pory wielcy rywale w wyścigu o AI zachowywali najpotężniejsze zasoby AI dla siebie. "W przeciwieństwie do modeli Chinchilla, PaLM czy GPT-3, używamy wyłącznie publicznie dostępnych zbiorów danych, dzięki czemu nasza praca jest możliwa do odtworzenia, gdy większość innych modeli opiera się na danych, które nie są publicznie dostępne lub nie są udokumentowane", napisał na Twitterze członek projektu Guillaume Lample.

Specjaliści z Meta snują wizje "własnej", "lokalnej" sztucznej inteligencji hostowanej na pojedynczym komputerze, w firmowym systemie lub w chmurze. Przyszłe wersje LLaMA mogłyby być, według tych planów, szkolone na danych i np. e-mailach pojedynczych użytkowników lub niewielkich grup. Pozwoliłoby to przygotować model na bardzo zindywidualizowane potrzeby i chronić wrażliwe dane osobowe, tajemnice firmy itd.

Do akcji wkraczają start-upy

Gdy giganci technologiczni przygotowują swoje odpowiedzi na zagrożenie ChatGPT, kilka start-upów uruchomiło wyszukiwarki z interfejsami czatu podobnymi do bota. Należą do nich You.com, Perplexity AI (4) i Neeva. Zbudowane przez nich narzędzia ilustrują zarówno potencjał, jak i wyzwania związane z adaptacją technologii w stylu ChatGPT do wyszukiwania. You.com, założona przez Richarda Sochera, eksperta w dziedzinie języka i AI, może udzielać odpowiedzi poprzez interfejs czatu. Odpowiedzi są opatrzone cytatami, które mogą pomóc użytkownikowi w ustaleniu pochodzenia danej informacji. Jednak model czasami łączy źródła, które nie pasują do siebie.

Aravind Srinivas, założyciel i dyrektor generalny start-upu wyszukiwania Perplexity AI, który wcześniej pracował w OpenAI, mówi, że wyzwanie związane z aktualizacją systemu podobnego do ChatGPT najnowsze informacje oznacza, że muszą one być połączone z czymś innym. "Same nigdy nie będą w stanie być dobrymi wyszukiwarkami", mówi magazynowi "Wired".

Saam Motamedi, inwestor w Greylock Partners, który zainwestował w Neeva, firmę zajmującą się wyszukiwaniem opartym na sztucznej inteligencji, zauważa, że nie jest jasne, jak interfejsy czatu pogodzone mogą być z modelem przychodów z wyszukiwarek, czyli reklamą. Google i Bing używają zapytań użytkowników do serwowania reklam, które pojawiają się na górze listy wyników. Motamedi podejrzewa, że nowe formy reklamy mogą wymagać pojawienia się dla interfejsów wyszukiwania w stylu czatu, aby być opłacalne, ale nie jest oczywiste, co to będzie. Jego Neeva pobiera opłatę abonamentową za nieograniczone wyszukiwanie bez reklam.

Drogie szkolenie, jeszcze droższe wnioskowanie

I tak doszliśmy do najważniejszego problemu nurtującego Google'a i innych w kontekście wejściach nowych interfejsów sztucznej inteligencji. Potentaci stali się potentatami, ponieważ znaleźli sposób zarabiania na swoich produktach (5). Jak zarabiać na nowych produktach podobnych do ChaGPT, opartych na modelach AI? Już wiadomo, że Microsoft najprawdopodobniej użyje ChatGPT z MS Office. Ma to sens, ponieważ jest to stosunkowo mało ryzykowny sposób na początek i nie jest prawdopodobne, że zrazi klientów.

Jednak to podejście o niskim ryzyku ma również minusy. Ponieważ MS ma właściwie monopol na segment Office, dodawanie kolejnych funkcji raczej nie sprawi, że więcej osób skorzysta z usług Microsoftu. Praktycznie każdy, kto potrzebuje Teams, Worda czy Excela, i tak go ma, a większość firm nie ma tak naprawdę żadnej alternatywy. Tak więc dodatkowe przychody uzyskane z integracji nie będą raczej duże.

Grupa globalnych gigantów ma dostęp do ogromnych ilości danych, zasobów i wiedzy specjalistycznej, co daje im przewagę konkurencyjną w ekosystemie sztucznej inteligencji. Należy jednak pamiętać, że ekosystem AI stale się rozwija i mogą pojawić się nowi gracze, którzy mogą zakłócić dominację tych globalnych gigantów. Dodatkowo, ramy prawne i względy etyczne również mogą wpłynąć na to, co się stanie. Tak czy inaczej nad siecią napędzaną AI wisi fatum ogromnych kosztów.

Zanim pojawił się ChatGPT OpenAI, niewielki start-up o nazwie Latitude zdołał przyciągnąć uwagę wielu użytkowników swoją grą AI Dungeon (6), która pozwalała wykorzystywać sztuczną inteligencję do tworzenia fantastycznych opowieści na podstawie podpowiedzi (tzw. promptów). Jednak w miarę wzrostu popularności AI Dungeon koszty utrzymania tekstowej gry fabularnej zaczęły gwałtownie rosnąć. Oprogramowanie do generowania tekstów w AI Dungeon było zasilane technologią językową GPT oferowaną przez OpenAI. "Żartowaliśmy, że mamy pracowników ludzkich i mamy pracowników AI, a na każdego z nich wydawaliśmy mniej więcej tyle samo", mówił szef firmy Nick Walton w mediach. "Wydawaliśmy setki tysięcy dolarów miesięcznie na AI, a nie jesteśmy dużą firmą, więc był to bardzo wielki koszt". Do końca 2021 roku Latitude przełączył się z korzystania z oprogramowania GPT na tańsze oprogramowanie językowe oferowane przez startup AI21 Labs i bezpłatne rozwiązania open source. Rachunki Latitude za "korzystanie ze sztucznej inteligencji" spadły kilkakrotnie. Firma zaczęła też pobierać od graczy opłaty abonamentowe.

Historia ta odsłania nieprzyjemną prawdę, która kryje się za boomem generatywnych technik AI. Koszty rozwoju i utrzymania oprogramowania mogą być ogromne, zarówno dla firm, które rozwijają modele językowe, jak i tych, które wykorzystują AI do zasilania własnych produktów. Wysoki jest koszt zarówno początkowy, czyli szkolenia, jak też stały, czyli "wnioskowania", czyli mówiąc w uproszczeniu, obsługi bieżących zapytań, za którymi stoją miliardy obliczeń. Większość szkoleń i wnioskowania odbywa się obecnie na procesorach graficznych (GPU), które nie są tanie.

Podstawowy układ Nvidia dla centrów obliczeniowych kosztuje mniej więcej 10 tys. dolarów. Analitycy szacują, że proces szkolenia dużego modelu językowego, takiego jak GPT-3 OpenAI, może kosztować ponad cztery miliony dolarów. Koszty innych modeli nie są znacząco niższe. np. największy model LLaMA firmy Meta wykorzystał 2048 jednostek GPU Nvidia A100 do wyszkolenia 1,4 mld tokenów (750 słów to około tysiąca tokenów), co zajęło jakieś 21 dni. Szkolenie zajęło około miliona godzin pracy GPU. Przy cenach usług serwerowych AWS Amazona kosztowałoby to ponad 2,4 miliona dolarów.

Jednak wyszkolenie modelu to dopiero początek wydatków. Pamiętajmy o pozycji w kosztach określanej jako "wnioskowanie". W przypadku produktu tak popularnego jak ChatGPT, który według szacunków firmy inwestycyjnej UBS osiągnął w styczniu sto milionów miesięcznych aktywnych użytkowników, przetworzenie milionów promptów, które ludzie wprowadzili do oprogramowania tylko w pierwszym miesiącu, mogło kosztować OpenAI 40 milionów dolarów. Koszty jeszcze bardziej rosną, gdy te narzędzia są używane miliardy razy dziennie. Analitycy finansowi szacują, że chatbot Bing AI Microsoftu, który jest zasilany przez model OpenAI ChatGPT, aby udzielać odpowiedzi wszystkim użytkownikom Binga na każde żądanie, potrzebuje infrastruktury wartej nawet cztery miliardy dolarów.

Jeden z prezesów spółki macierzystej Google, Alphabet, John Hennessy powiedział Reutersowi, że prowadzenie rozmowy z dużym modelem językowym może kosztować dziesięć razy więcej niż standardowe wyszukiwanie po słowach kluczowych. SemiAnalysis, firma badawcza i konsultingowa skupiona na technologii chipów, oszacowała, że dodanie AI w stylu ChatGPT do wyszukiwania może kosztować Alphabet trzy miliardy dolarów, co jest kwotą umiarkowaną, bo uwzględnia oszczędności wynikające z użycia własnych chipów Google’a, Tensor Processing Units (TPU). Jednak rachuby te nie uwzględniają możliwego spadku dochodów z reklamy w wyszukiwarce w rozumieniu tradycyjnym, której popularność może szybko spadać.

Zawsze też jako prosta opcja zarabiania jest pobieranie opłat za dostęp. Dostęp do OpenAI Plus bez opóźnień i ograniczeń, a od niedawna do najnowszego modelu GPT-4, kosztuje dwadzieścia dolarów miesięcznie. Wtedy użytkownik powinien raczej mieć realny powód biznesowy, by używać tego narzędzia. Nie wydaje się to droga do masowego udostepnienia technik sztucznej inteligencji. Alphabet, czyli Google, bada opcje stosowania prostszych i tańszych rozwiązań AI do prostszych zadań. Taki właśnie "mniejszy model" LLM LaMDA zasilać ma chatbota Bard, co oznacza potrzebę "znacząco mniejszej mocy obliczeniowej" i umożliwia kierowanie usługi do większej liczby użytkowników. Użytkownicy jednak mogą nie widzieć wyraźnego powodu, by używać AI "klasy ekonomicznej". I koło się zamyka.

Mirosław Usidus

Źródło: stock.adobe.com