Sztuczna superinteligencja na horyzoncie. Dogonić człowieka i go… przegonić

Mózg ma około 80-100 miliardów neuronów i około 100 bilionów synaps. GPT-4 będzie miał tyle parametrów, ile mózg ma synaps, tylko nie bardzo wiadomo, czy to można porównywać.

Niektórzy eksperci w tej dziedzinie twierdzą, że osiągniemy AI na poziomie człowieka, czyli ową AGI (skrót od angielskiego terminu - Artificial General Intelligence) do 2030 roku, inni, że do 2040 roku, a niektórzy - że nigdy. Według OpenAI, firmy, która stworzyła GPT-3 i buduje teraz GPT-4, "trudno jest przewidzieć, kiedy AI na poziomie człowieka może znaleźć się w zasięgu ręki". Jak przyznaje OpenAI, "dzisiejsze systemy AI mają imponujące, ale wąskie możliwości". Dodaje jednak: "trudno jest nawet wyobrazić sobie, jak wiele AI na poziomie ludzkim może przynieść społeczeństwu korzyści - równie trudno jest wyobrazić sobie, jak bardzo może zaszkodzić społeczeństwu, jeśli zostanie zbudowana lub użyta niewłaściwie".

OpenAI wierzy w duże liczby

Z tworzeniem superinteligencji lub AGI (to dwie różne rzeczy) raczej jednak nie pójdzie tak szybko, jak sądzą optymiści (i pesymiści także), bo zdaniem większości ekspertów, najpopularniejsze obecnie w dziedzinie AI techniki głębokiej nauki maszynowej nie wystarczą do osiągnięcia tego poziomu. Stuart Russell, profesor informatyki w Berkeley i pionier AI, zauważa, że "skupianie się na surowej mocy obliczeniowej całkowicie mija się z celem (…) Nie wiemy, jak stworzyć naprawdę inteligentną maszynę".

Jednak w OpenAI nie słabnie przekonane, że duże sieci neuronowe karmione wielkimi zbiorami danych i trenowane na ogromnych komputerach są najlepszą drogą do AGI. Greg Brockman z OpenAI powiedział w wywiadzie dla "Financial Times": "Sądzimy, że najwięcej korzyści odniesie ten, kto ma największy komputer". Czyli inaczej rzecz ujmując, stworzenie AGI to byłby problem rozwoju ilościowego deep learningu. OpenAI wierzy w hipotezę skalowania swojego algorytmu - transformaty.

Aby rozwijać się ilościowo, potrzeba ogromnych mocy obliczeniowych. Wykorzystywane przez OpenAI procesory graficzne szybko wykazały swoje ograniczenia. Zresztą nie są one projektowane do AI, lecz do maszyn wykorzystywanych w grach komputerowych. Pojawiła się potrzeba stworzenie sprzętu specjalnie dla AI. I tu na scenę wkroczył wspomniany Cerebras Systems.

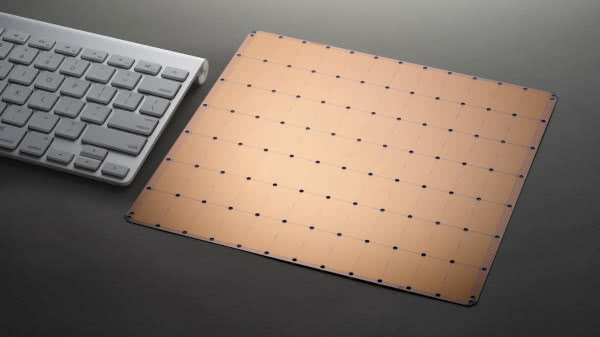

Stosunkowo nowa firma, produkująca chipy już w 2019 roku, zbudowała największy układ scalony, jaki kiedykolwiek był wykorzystywany do szkolenia dużych sieci neuronowych. Wafer Scale Engine Two (WSE-2) to kwadrat o boku ok. 22 cm z 2,6 mld tranzystorów i 850 000 rdzeni obliczeniowych (1). Dla porównania - typowe procesory graficzne mają ich kilkaset.

Rozwiązano też problem ciepła w układzie za pomocą nowatorskiego systemu chłodzenia. Zastosowano też nowatorski system przepływu danych.

Cerebras pasuje do OpenAI, która rozwija się równie błyskawicznie. W czerwcu 2018 roku opublikowała pracę zatytułowaną "Improving Language Understanding by Generative Pre-Training". Przedstawiła w niej GPT-1, model silnego przetwarzania języka naturalnego. W lutym 2019 roku OpenAI opublikowało drugą pracę - "Language Models are Unsupervised Multitask Learners", przedstawiającą GPT-2, generator większy o rząd wielkości, i w odróżnieniu od jedynki zdolny do pracy wielozadaniowej.

Następnie, w maju 2020 roku, OpenAI zaprezentowało model GPT-3, który stał się prawdziwą sławą. Sam Altman (2), szef OpenAI, na jednym ze spotkań wspomniał o GPT-4, które jak zaznaczył, wbrew powszechnemu przekonaniu: GPT-4 nie będzie większe niż GPT-3 (pod względem liczby parametrów), ale będzie wykorzystywać więcej zasobów obliczeniowych (chipy Cerebras). Wspomniał nawet o GPT-5, który miałby, jak sądzi, przejść z powodzeniem test Turinga, czyli być sztuczną inteligencją nieodróżnialną od ludzkiej. Tak definiuje się AGI, ale nie jest do końca jasne, co to miałoby oznaczać.

Jeśli założymy, że GPT-4 będzie miał znacznie więcej parametrów, to możemy się spodziewać, że będzie jeszcze lepszym mechanizmem samouczącym się niż poprzednicy. Musi być jednak bardziej odporny na złe podpowiedzi. My, ludzie, również polegamy na "podpowiedziach", ale potrafimy dokonać samooceny, weryfikując, to co nam podsuwa świat. System, który nie jest zdolny do samooceny, nie może być nazwany inteligentnym.

Przyglądając się temu, co już znamy, czyli modelowi GPT-3, trudno nie zauważyć, że jego pamięć jest dość ograniczona. Człowiek nie zapomina rzeczy, które wydarzyły się wczoraj. W GPT-3 API w wersji beta pozwala użytkownikowi na wprowadzenie tekstu o długości 500-1000 słów, okna kontekstowego. Oznacza to w praktyce, że system nie potrafiłby kontynuować napisanej wcześniej dużej powieści czy dokończyć kodowania dużego programu komputerowego.

GPT-3 po prostu nie ma pojęcia, co jest poza oknem kontekstowym. Model ma też inne problemy, np. z tekstami, które nie pochodzą z internetu, z abstrahowaniem, czyli z wszystkim, z czym człowiek bez większego problemu daje sobie radę.

Ilościowe podejście OpenAI wzbudza w kręgach specjalistów sporo wątpliwości. Gdyby je przyjąć dosłownie, to bliżej AGI jest chiński Wu Dao 2.0, który opiera się na znacznie większej liczbie danych i parametrów niż GPT-3. W przeciwieństwie do GPT-3, Wu Dao 2.0 może uczyć się różnych zadań w czasie, nie zapominając tego, czego nauczył się wcześniej. Ta cecha wydaje się zbliżać AI do ludzkiej pamięci i mechanizmów uczenia się. Chińczycy twierdzą, że uczeń Wu Dao - noszący imię Hua Zhibing, posiada "pewne zdolności w zakresie rozumowania i interakcji emocjonalnych". Należałoby jednak zachować ostrożność w przyjmowaniu tych wypowiedzi.

Relacje dla ludzi łatwe, dla maszyn - duże wyzwanie

AI jest lepsza od ludzi w wielu zadaniach, np. w przewidywaniu pogody, diagnozowaniu niektórych chorób, w szachach i Go. Modele głębokiego uczenia są całkiem niezłe w rozumieniu zależności między danymi wejściowymi i wyjściowymi, ale to mniej więcej wszystko. Niezależnie od tego, czy jest to uczenie nadzorowane, czy uczenie ze wzmocnieniem, dane wejściowe i pożądane dane wyjściowe są jasno zdefiniowane i łatwe do zrozumienia przez model. Jest to akceptowalne dla zadań takich jak klasyfikacja, a nawet generowanie. Jednak, jeśli chcemy, aby modele AI były w stanie podejmować decyzje, używając tego, co nazywamy "zdrowym rozsądkiem", który jest w rzeczywistości abstrakcyjnym rozumowaniem, to AI staje się bezradna.

Oczywiście podejmowane są wysiłki na rzecz rozwoju w maszynach czegoś, co nazywane jest "deep reasoning", a polega głównie na próbach wpojenia maszynom zrozumienia ukrytych relacji pomiędzy rzeczami i obiektami. Na przykład prosty sylogizm: "Wszystkie zwierzęta piją wodę. Koty są zwierzętami", z którego dla ludzi wnioskowanie, że wszystkie koty piją wodę, nie jest trudne. Jednak dla maszyn to kłopot, gdyż zamiast rozumować relacyjnie, muszą się tego, że koty piją wodę, z setek tysięcy przykładów uczyć.

Sztuczna inteligencja nie jest całkowicie pozbawiona możliwości rozumowania relacyjnego. Modele symbolistyczne oparte na logice są z natury relacyjne. Modele te definiują relacje pomiędzy symbolami za pomocą języka logiki i matematyki, a następnie rozumują o tych relacjach za pomocą np. dedukcji, arytmetyki i algebry.

Także znany ośrodek DeepMind zaproponował metodę opartą na sieciach relacyjnych rozszerzonych o inne artefakty w celu wnioskowania o relacjach z niestrukturalnych danych wejściowych, takich jak obrazy lub zbiory danych tekstowych. W testach obrazkowych sieć relacyjna DeepMind osiągnęła zadziwiającą dokładność 96 proc., która była o około 20 proc. lepsza od innych modeli relacyjnych.

W testach tekstowych model DeepMind poradził sobie z 18/20 zadaniami, wykazując margines błędu na poziomie 2,1 proc. Badania DeepMind wyraźnie pokazały, że sieci relacyjne mogą stać się ważnym elementem składowym modeli głębokiego uczenia, które wymagają zdolności rozumowania relacyjnego. Są to jednak dopiero początki. Do AGI jest tu jeszcze bardzo daleko.

Ludzki poziom lada dzień albo za pół wieku

Na konferencji Joint Multi-Conference on Human-Level Artificial Intelligence, która odbyła się w zeszłym roku w Pradze, eksperci w dziedzinie AI z całego świata podzielili się swoimi nadziejami i danymi na temat postępów badań w kierunku "human-level AI" (HLAI), AI na poziomie ludzkim, która jest według jednych ostatnim przystankiem przed prawdziwą AGI lub nawet przystankiem docelowym.

Większość ekspertów uważa, że to nadchodzi - raczej wcześniej niż później. W ankiecie przeprowadzonej wśród uczestników konferencji firmy badawcze GoodAI i SingularityNet stwierdziły, że 37 proc. respondentów uważa, że ludzie stworzą HLAI w ciągu 10 lat. Kolejne 28 proc. uważa, że zajmie to 20 lat. Zaledwie dwa proc. uważa, że HLAI nigdy nie powstanie.

Oto kilka charakterystycznych opinii: Irakli Beridze, dyrektor Centrum Sztucznej Inteligencji i Robotyki, UNICRI, Organizacja Narodów Zjednoczonych powiedział: "W tej chwili nic nie wskazuje na to, że jesteśmy blisko AGI. I nikt nie może powiedzieć z jakimkolwiek autorytetem lub przekonaniem, że stanie się to w określonym czasie".

Seán Ó hÉigeartaigh, dyrektor wykonawczy Cambridge Center for the Study of Existential Risk: "Biorąc pod uwagę to, o czym wiemy, możliwe jest, że stanie się to w ciągu 50 lat".

Marek Rosa, szef GoodAI: "Myślę, że jesteśmy prawie na miejscu. Nie przewiduję, że będziemy mieli ogólną AI za trzy lata, czy za 30 lat. Ale jestem przekonany, że może się to stać lada dzień".

Hava Siegelmann, kierownik programu w DARPA: "Myślę, że ogólna AI to określenie bardzo ogólnej idei. (…) możemy to osiągnąć w krótkim czasie".

Nadinteligencji nie da się kontrolować

Nie należałoby przy tym mylić ogólnej sztucznej inteligencji wiązanej z odtworzeniem ludzkiego poziomu z superinteligencją, znacznie przewyższającą inteligencję najbystrzejszych i najbardziej utalentowanych ludzkich umysłów.

Filozof z Uniwersytetu Oksfordzkiego Nick Bostrom definiuje superinteligencję jako "każdy intelekt, który znacznie przewyższa ludzkie możliwości poznawcze w praktycznie wszystkich interesujących nas dziedzinach". Zatem program, wygrywający z ludźmi w gry takie jak szachy czy Go, nie jest w żadnym razie superinteligencją, gdyż ma przewagę jedynie w bardzo wąskim zakresie. Bostrom traktuje superinteligencję jako ogólną dominację w zachowaniu zorientowanym na cel.

Niektórzy badacze uważają, że superinteligencja prawdopodobnie pojawi się wkrótce po rozwoju sztucznej inteligencji ogólnej AGI. Pierwsze maszyny z inteligencja ogólną prawdopodobnie od razu będą miały ogromną przewagę w przynajmniej niektórych aspektach, w tym zdolność doskonałego zapamiętywania, znacznie większą bazę wiedzy i zdolność do wielozadaniowości niedostępną dla jednostek biologicznych. Może to dać im możliwość, albo jako pojedynczej istocie, albo jako nowemu gatunkowi, by stać się znacznie potężniejszymi od ludzi i wyprzeć ich z rynku albo nawet w ogóle ze światowej sceny.

Czy dałoby się przed tym jakoś obronić ludzi? Wykorzystując teoretyczne obliczenia, międzynarodowy zespół badaczy, w tym naukowcy z Centrum Ludzi i Maszyn w Instytucie Maxa Plancka ds. Rozwoju Człowieka, wykazał na początku 2021 r., że kontrola nad superinteligentną nie byłaby możliwa. Załóżmy, że ktoś zaprogramowałby system AI o inteligencji przewyższającej ludzką, tak aby mógł uczyć się samodzielnie. Podłączona do Internetu, AI może mieć dostęp do wszystkich danych ludzkości. Mogłaby zastąpić wszystkie istniejące programy i przejąć kontrolę nad wszystkimi maszynami online na całym świecie.

"Superinteligentna maszyna, która kontroluje świat (3), brzmi jak science fiction, ale istnieją już maszyny, które wykonują pewne ważne zadania samodzielnie, bez pełnego zrozumienia ze strony programistów, jak się tego nauczyły. Pojawia się więc pytanie, czy w pewnym momencie nie stanie się to niekontrolowane i niebezpieczne dla ludzkości", pisze w komunikacie współautor badania Manuel Cebrian.

Naukowcy rozważali dwa różne pomysły na to, jak można by kontrolować superinteligentną AI. Z jednej strony, możliwości superinteligencji mogłyby zostać specjalnie ograniczone, na przykład poprzez odcięcie jej od Internetu i wszelkich innych urządzeń technicznych, tak aby nie miała kontaktu ze światem zewnętrznym. Jednak to sprawiłoby, że taka AI stałaby się znacznie mniej potężna, więc z natury przeczyłoby to jej definicji.

Gdyby nie było takiej możliwości, AI mogłaby być od początku motywowana do realizowania tylko tych celów, które leżą w najlepszym interesie ludzkości, na przykład poprzez zaprogramowanie w niej zasad etycznych. W swoim badaniu zespół opracował teoretyczny algorytm powstrzymywania, który zapewniałby, że superinteligentna AI w żadnym wypadku nie może zaszkodzić ludziom. Jednak dokładna analiza pokazuje, że w naszym obecnym paradygmacie obliczeniowym taki algorytm nie może być zbudowany.

"Jeśli sprowadzić problem do podstawowych reguł z informatyki teoretycznej, okazuje się, że algorytm, który nakazywałby AI nie niszczyć świata, mógłby niechcący wstrzymać jej własne działania. Gdyby tak się stało, nie wiedzielibyśmy, czy algorytm powstrzymujący nadal analizuje zagrożenie, czy też zatrzymał się, aby powstrzymać szkodliwą AI. W efekcie czyni to algorytm powstrzymywania bezużytecznym", wyjaśnia Iyad Rahwan, inny członek tego samego zespołu badawczego. Co więcej, badacze dowodzą, że możemy nawet nie wiedzieć, kiedy pojawią się superinteligentne maszyny, ponieważ rozstrzygnięcie, czy maszyna wykazuje inteligencję wyższą od ludzkiej, należy do tej samej sfery, co problem powstrzymywania.

Prowadzi to do konkluzji, że to mogło się już stać, ale nawet o tym nie wiemy. Te spekulacje jednak to już nieco inny temat i trochę wkraczają w klimat znanych wizji science fiction (4).

Mirosław Usidus