Schyłek ery kamienia trawionego?

Niedawno koncern, w którym Prawo Moore’a się zrodziło (Gordon Moore był jednym z założycieli Intela), zaczął wydawać nieco dziwnie brzmiące oświadczenia. W ubiegłym roku odłożył premierę nowej serii chipów bazujących na 10 nm. Na początku 2016 r., zamiast wydawania dwóch generacji procesorów w jednym procesie technologicznym, wydłużył daną technologię na trzy generacje procesorów. Nowe założenie ma również dotyczyć układów wykonanych w 10-nanometrowej litografii.

Do tej pory producent wydawał procesory w ramach strategii TICK-TOCK, gdzie krok TICK oznaczał zmniejszenie procesu technologicznego, a krokiem TOCK było wprowadzenie nowej mikroarchitektury. Przykładowo, procesory Sandy Bridge wprowadziły nową mikroarchitekturę, a Ivy Bridge zmniejszyły litografię, Haswell wprowadziły kolejną mikroarchitekturę, a Broadwell znowu zmniejszyły litografię, po czym obecne modele Skylake wprowadziły nową mikroarchitekturę (przy zachowaniu 14-nanometrowej litografii).

W przyszłym roku mamy dostać procesory Cannonlake w 10-nanometrowej architekturze, natomiast rok później pojawią się układy Icelake na bazie nowej mikroarchitektury. W 2019 r. znowu przyjdzie czas na udoskonalenie procesorów - tym razem będą to modele o nazwie kodowej Tigerlake, bazujące na mikroarchitekturze Icelake i 10-nanometrowej litografii. Później być może (ale niekoniecznie) doczekamy się układów w 7-nanometrowej litografii - najwcześniej w 2020 r. Wygląda więc na to, że wprowadzenie coraz bardziej zminiaturyzowanych procesów technologicznych zajmuje coraz więcej czasu. Pierwotnie wspomniana litografia miała zadebiutować w 2016 r., jednak już od dawna było wiadomo, że termin nie zostanie dotrzymany. Kolejne przełożenie byłoby ciosem wizerunkowym.

Może to jednak problem samego Intela, który czuje na plecach oddech azjatyckiej konkurencji - firm TSMC (Taiwan Semiconductor Manufacturing Company) oraz Samsung Electronics. Produkcję 10-nanometrowych układów w dużych ilościach chciały one uruchomić jeszcze przed końcem ubiegłego roku, a teraz mówią o 2017 r. jako okresie startu produkcji chipów w procesie 7 nm. Jeżeli im się to uda, będzie to zła wiadomość dla Intela, który od dawna był liderem w branży układów scalonych.

Warto jednak mieć na uwadze to, że z reguły każdy proces produkcyjny Intela w praktyce okazuje się lepszy od rozwiązań konkurencyjnych. Podczas gdy nowe rozwiązania tej firmy zawsze zapewniały kompleksową miniaturyzację układów scalonych, bez kompromisów odnośnie wielkości tranzystorów, długości bramek itd., procesy konkurentów zazwyczaj poświęcają jedną cechę, aby ulepszyć inną. Dlatego wg wielu obserwatorów Intel, pomimo opóźnienia, wprowadzi ostatecznie 10-nanometrową litografię z pełnią możliwości.

Krzem inaczej

Sporo się mówi o ograniczeniach, z jakimi trzeba się zmagać, stosując krzem w procesorach komputerowych. Mniej znany jest temat wad krzemu wykorzystywanego w ogniwach słonecznych. W krzemowych tranzystorach elektrony wzbudzane są do stanu przewodnictwa za pomocą przepływu prądu elektrycznego. W panelach słonecznych rolę wzbudzającą odgrywać mają fotony światła słonecznego. Problem w tym, że tylko określona część pasma promieniowania słonecznego może to robić skutecznie. Światło w zakresie podczerwieni ma np. zbyt małą częstotliwość i energię, aby wykonać swoją pracę. Ponad połowa słonecznego promieniowania po prostu się marnuje.

Krzem nie ma czegoś, co nazywa się w optoelektronice bezpośrednim pasmem wzbronionym. Oznacza to, że wzbudzić elektrony na wyższe stany energetyczne wcale nie jest tak łatwo. To kolejna bariera zmniejszająca sprawność ogniw krzemowych. Takie bezpośrednie pasma mają za to - często wymieniane jako alternatywne materiały elektroniczne - arsenek galu lub tellurek kadmu. Nie są one jednak wolne od wad. Np. arsen i kadm to silnie toksyczne substancje, a gal i tellur są bardzo drogie. Aby zaś móc myśleć o produkcji paneli słonecznych na wielką skalę (np. pokrywać nimi połacie pustyń), materiał, z których będzie się je wykonywać, nie może ani być zbyt kosztowny, ani stanowić zagrożenia dla środowiska naturalnego. Takie ekonomiczne i ekologiczne wymogi spełnia właśnie krzem.

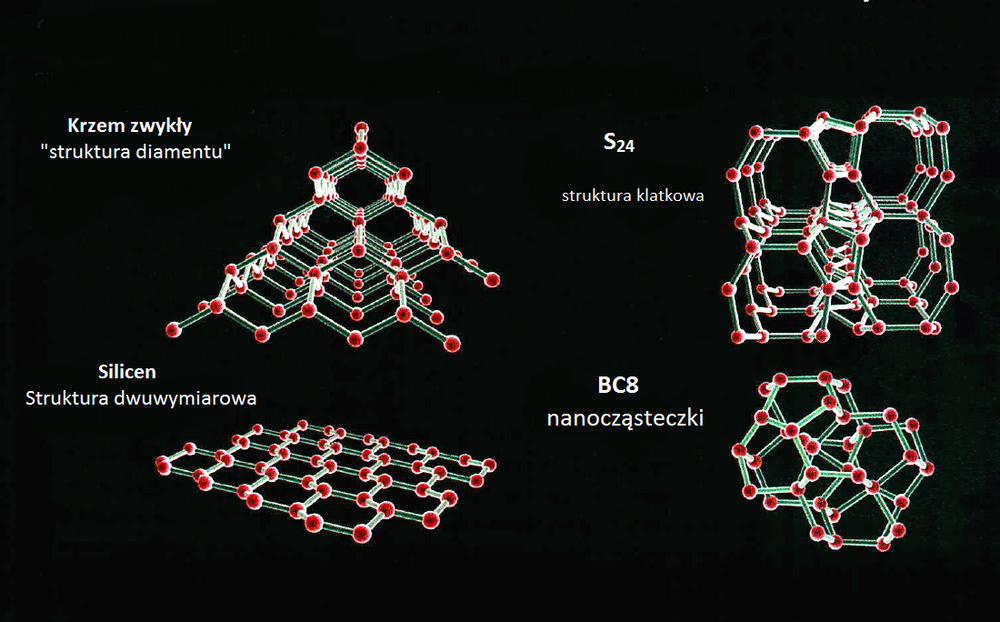

Oczywiście chodzi jednak o zupełnie inny krzem, podobnie jak alotropowa odmiana węgla zwana grafenem jest czymś innym niż dobrze znany węgiel. O takim materiale, oznaczonym wzorem chemicznym Na4Si24, pisano w listopadzie ubiegłego roku w „NewScientist”. Odkrył go Timothy Strobel z Instytutu Carnegie w Waszyngtonie. Mówiąc ściślej, Na4Si24 nie ma co prawda bezpośredniego pasma wzbronionego, wystarczy jednak zastosowanie niewielkiego naprężenia, aby zachowywał się jak arsenek galu.

Najlepsze dostępne na rynku ogniwa osiągają sprawność przetwarzania energii do 25%. Za górną granicę wydajności krzemu w tej dziedzinie uważa się 33%. Limit ten opiera się na założeniu, że jeden foton światła słonecznego może wzbudzać najwyżej jeden elektron. Jednak nasza wiedza o mechanice kwantowej podpowiada, że niekoniecznie musi tak być, a działanie pojedynczego fotonu można rozciągnąć na większą liczbę elektronów. Zdaniem Giulii Galii z Uniwersytetu w Chicago może tak działać - nawet z 42-procentową sprawnością - alotropowa nano-odmiana krzemu, znana jako BC8.

Jest jeszcze silicen. Tranzystor polowy wykorzystujący silicen - czyli krzem w dwuwymiarowej postaci podobnej do grafenu - zbudował już międzynarodowy zespół, w skład którego wchodzili naukowcy m.in. z USA i Francji. Urządzenie nie prezentuje co prawda na razie jakichś niezwykłych parametrów i jest w stanie działać zaledwie przez dwie minuty, jednak funkcjonuje i dowodzi możliwości wykorzystania w elektronice tego stosunkowo nowego materiału. Silicen pozostaje niestety wciąż stosunkowo trudny do wytworzenia. Naukowcy produkują go, odparowując krzem i krystalizując warstwę na kryształach srebra w komorze próżniowej. W odróżnieniu od grafenu silicen jest też w normalnych warunkach atmosferycznych bardzo nietrwały i szybko się rozpada.

Nowe materiały - obiecujące, ale nietrwałe

Generalnie do najciekawszych wątków w badaniach nad nowymi materiałami elektronicznymi należą obecnie informacje o materiałach złożonych z pojedynczej warstwy atomów (tzw. monowarstwy 2D, kojarzone głównie z grafenem). Uczeni pracują nad wspomnianym silicenem oraz stanenem (z atomów cynku) i fosforenem (lub 2D fosfanem - nazwa nie została jeszcze ściśle ustalona). Najpierw jednak trzeba uporać się z rozmaitymi problemami. Nad ich przewodnością wciąż trudno zapanować, a niektóre z nich, jak właśnie silicen, pozostają bardzo nietrwałe.

Niedawno uczonym z kanadyjskiego Uniwersytetu w Montrealu oraz francuskiego centrum badań naukowych CNRS udało się opracować technikę zapobiegania utlenianiu dwuwymiarowych monowarstw czarnego fosforu. Uważa się, że alotropowa odmiana fosforu, zwana czarnym fosforem, może być nowym grafenem - z tym, że lepszym niż grafen, ponieważ w przeciwieństwie do niego ma pasmo wzbronione. Materiał z czarnego fosforu w postaci warstw 2D nazywany jest właśnie fosforenem lub 2D fosfanem.

Już w 2011 r. szwajcarscy uczeni z École Polytechnique Fédérale de Lausanne (EPFL), zaprezentowali pierwszy układ scalony zbudowany z molibdenitu. Materiał ten pozwala na konstruowanie mniejszych tranzystorów niż z krzemu. Z molibdenitu można tworzyć efektywnie działającą warstwę o grubości zaledwie trzech atomów. Jest ona bardzo stabilna i łatwo w niej kontrolować przepływ elektronów. Tranzystory molibdenitowe są też bardziej wydajne i przełączają się szybciej niż krzemowe. Jak twierdzą uczeni, molibdenit równie efektywnie jak krzem wzmacnia sygnał elektryczny. Sygnał wyjściowy może być czterokrotnie silniejszy niż sygnał wejściowy. Ponadto molibdenit, w przeciwieństwie do krzemu, ma interesujące właściwości mechaniczne, które być może pozwolą na produkowanie elastycznych układów scalonych.

Jak widać, laboratoria badawcze bardzo szeroko sięgają w poszukiwaniu materiałów, które zastąpią krzem i inne tradycyjne składniki komponentów elektronicznych. Nie zarzuca się też poszukiwań nowych możliwości samego krzemu.

Od 2009 r. w konstrukcji komponentów funkcjonalnych tranzystorów wykorzystuje się „rozciągnięty krzem”. Owo rozciąganie należy rozumieć dosłownie: w strukturę krzemu zostają wprowadzone atomy germanu, przez co dystans między poszczególnymi atomami ulega zwiększeniu. Na warstwę krzemowo-germanową (SiGe) nakłada się warstwę zwykłego krzemu. Obie warstwy łączą się, tworząc regularną strukturę krystaliczną, przy czym wielkość odstępów między atomami zostaje dostosowana do struktury warstwy SiGe. Zwiększenie tych odstępów poprawia przewodnictwo materiału - elektrony przemieszczają się przez przełączony tranzystor nawet o 70% szybciej, niż gdyby był on wykonany ze zwykłego krzemu.

Powrót do germanu?

Struktura krystaliczna germanu jest naturalnie rozciągnięta, a jego przewodność czterokrotnie przewyższa przewodność krzemu. Elementy tranzystorów wymagające domieszkowania typu „n” mogłyby być wykonane z mieszanki indu, galu i arsenu (InGaAs), mającej sześciokrotnie wyższą przewodność. Już pierwszy prototyp tranzystora z kanałem wykonanym z tego materiału zużywa o połowę mniej energii niż porównywalny tranzystor z krzemowym kanałem. Analitycy rynkowi prognozują, że nowe materiały zaczną być stosowane na masową skalę od 2017 r.

Nawiasem mówiąc, od niedawna okazuje się, że wykorzystanie germanu nie musi się ograniczać wyłącznie do tranzystorów typu „p”. Pojawiła się wiadomość o odkryciu naukowców z Uniwersytetu Purdue, polegającym na opracowaniu metody wykonania z tego pierwiastka również tranzystora typu „n”. W układach scalonych CMOS potrzeba obu typów półprzewodnika. Okazuje się więc, że elektronika może powrócić do źródeł - wszak pierwsze tranzystory sporządzano nie z krzemu lecz z germanu.

A dokładniej, przyszłość należy - jak sądzi Joshua Goldberger z Uniwersytetu Stanowego w Ohio - do dwuwymiarowej formy tego pierwiastka, nazwanej germanenem. Jego laboratorium stworzyło taką strukturę już w 2013 r. i prace rozwojowe trwają. Badaczom chodzi nie tylko o to, że germanen transportuje elektrony dziesięć razy szybciej niż krzem, ale również o to, że świetnie spisuje się w absorpcji i emisji światła, co brzmi obiecująco w kontekście rozwoju fotoniki i diod LED. Ponadto, jak sądzą naukowcy, można go wykorzystać jako tzw. izolator topologiczny, który przewodzi elektryczność tylko na swoich obrzeżach.

Co z rozwojem elektroniki?

Gdy w 1971 r. na rynku pojawił się chip Intel 4004, któremu przypisuje się rozpoczęcie rewolucji komputerów osobistych, składał się on z 2300 tranzystorów o rozmiarach 10 mikrometrów (μm ) każdy. Współczesne najlepsze procesory mieszczą już po 5 mld tranzystorów. W latach 80. szybkości przełączników tranzystorowych w procesorach, wyrażane w częstotliwości taktowania, liczone były w megahercach, czyli milionach cykli na sekundę. W ubiegłej dekadzie osiągnięto już miliardowe częstotliwości taktowania. Intel Pentium 4 HT pracował w tempie 3 GHz.

I teraz, po kilkunastu latach, większość rynkowych chipów wciąż przebywa na poziomie owych 3 GHz, a tylko ponadprzeciętne CPU (i chłodzone w specjalny sposób) taktuje się powyżej 4 GHz. Okazało się, że odprowadzanie energii termicznej powstającej w tak szybko pracujących i tak niewielkich urządzeniach to nie lada wyzwanie. Natrafiliśmy na limity termodynamiczne, które nie pozwalają tak szybko, jak byśmy sobie tego życzyli, odprowadzać ciepła z nanoskalowych układów. Układy scalone są wciąż zmniejszane, bo mogą być - zwyczajowo uznaje się na ogół, iż granica procesu miniaturyzacji znajduje się gdzieś poniżej 5 nm. Jednak procesory nie mogą pracować szybciej, a nawet wręcz trzeba je spowalniać.

W branży komputerowej już od ponad dekady dominuje raczej sceptycyzm, by nie powiedzieć - pesymizm. O zmierzchu krzemu piszą już prawie wszystkie media. Opisywane wyżej alternatywy są wciąż dość mgliste lub na wczesnych etapach rozwoju. W listopadzie 2006 r. sam Gordon Moore miał oświadczyć, że według niego za 2-3 lata (czyli w roku 2008 lub 2009) jego prawo przestanie obowiązywać. Wzrost zgodny z pierwotnym brzmieniem słynnej reguły Moore’a - wg której optymalna liczba tranzystorów w układzie scalonym podwaja się w zbliżonych odcinkach czasu - zawdzięczaliśmy przez dekady zmniejszaniu się tzw. wymiaru charakterystycznego, wzrostowi powierzchni struktur oraz rosnącej efektywności upakowania.

Wprawdzie moce obliczeniowe rosną, ale już prawie nie odbywa się to za sprawą miniaturyzacji, lecz przez dodawanie dodatkowych rdzeni obliczeniowych, czyli mnożenie procesorów w układzie obliczeniowym i przetwarzanie równoległe. Dodawanie rdzeni oznacza jednak większe zużycie energii na obliczenia i na komunikację pomiędzy segmentami.

Jednym z głównych powodów, dzięki któremu ten wykładniczy wzrost stał się możliwy, było i jest stosowanie coraz mniejszych elementów w procesie fabrykacji. Współcześnie dominują technologie 45, 32, 22, a ostatnio 14 nm. Jak wspominaliśmy na początku, słychać o problemach z introdukcją litografii 10 nm. Biorąc pod uwagę fizykę klasyczną, rozmiary te nie mogą się jednak zmniejszać bez końca - granicę stanowi tutaj rozmiar atomów, a kolejnym ograniczeniem jest prędkość światła, wyznaczająca górną granicę dla prędkości przesyłania informacji. Według dokumentów International Technology Roadmap for Semiconductors (ITRS), uwzględniających potencjalne problemy z rozwojem i miniaturyzacją, kolejne procesy dostępne w ostatnich i najbliższych latach wyznaczały etapy: 32 nm - 2009 r., 22 nm - 2012, 14 nm - 2015, 10 nm - 2017… Dalszy rozwój elektroniki stoi pod znakiem zapytania.

Jednak nawet pośród wielu minorowych nastrojów nie brakuje takich informacji jak ta z 9 lipca 2015 r. Firma IBM - a nie Intel, jak by się można było spodziewać - ogłosiła wówczas, że udało jej się stworzyć oparty na krzemo-germanie procesor w technologii 7 nanometrów. Nowa technologia wykorzystuje do tworzenia chipów wiązki światła ultrafioletowego, co wymaga specjalnie stabilizowanych… budynków, w celu zabezpieczenia aparatury wytwórczej przed wibracjami. Może więc jednak nie dotarliśmy jeszcze do kresu miniaturyzacji w tradycyjnych tranzystorach? Jeszcze nie teraz…