Internet jak powietrze. Nowy wirtualny świat potrzebuje dobrych łączy

"Dookoła nas znajdzie się tyle urządzeń, czujników, rzeczy, które będziemy na sobie nosić, a które będą ze sobą w kontakcie, że przestaniemy je zauważać. Staną się po prostu częścią naszej obecności w świecie. Właśnie wyłania się wysoko spersonalizowana, interaktywna i bardzo ciekawa rzeczywistość", mówił Schmidt podczas szwajcarskiej konferencji.

Zettabajty przyszłości

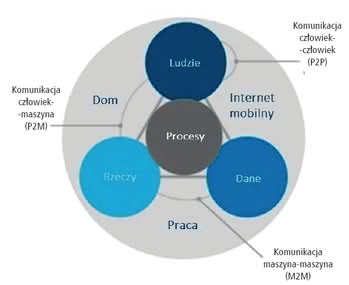

Internet ludzi, Internet rzeczy, wszechogarniająca wirtualna cyberprzestrzeń - jakkolwiek przyszłą sieć (2) nazwiemy, będzie musiała opierać się na infrastrukturze technicznej i to o parametrach oraz możliwościach znacznie przekraczających obecne pasma przenoszenia. W 1997 r. z Internetu korzystało zaledwie 2% ludzkości. Dziś to już ok. 40%.

Według informacji podanych przez ONZ-owski Międzynarodowy Związek Telekomunikacyjny (ITU), liczba użytkowników Internetu na świecie przekroczyła już trzy miliardy. Globalne tempo przyrostu liczby internautów wynosiło w 2014 r. 6,6%. W krajach rozwiniętych liczba korzystających z sieci rośnie o 8,7% na rok. W krajach rozwijających się - o 3,3%. W grupie krajów biedniejszych, mimo wyraźnie skromniejszych statystyk, liczba użytkowników Internetu od 2009 r. podwoiła się. Obecnie internauci z krajów rozwijających się stanowią dwie trzecie globalnej liczby użytkowników Sieci.

Zgodnie z prognozami firmy Cisco - Visual Networking Index (VNI), w latach 2013-2018 ruch w światowych sieciach IP ma wzrosnąć trzykrotnie. Globalny roczny ruch w sieciach stacjonarnych i mobilnych w roku 2018 osiągnie 1,6 zettabajtów (1,6 × 1021). Po raz pierwszy w historii Internetu, większość tej wymiany danych będzie pochodzić z urządzeń innych niż komputery osobiste. Zacznie też wówczas dominować przesył poprzez Wi-Fi. Do ogólnego szybkiego wzrostu przyczynia się rozwój Internetu rzeczy.

W 2018 r. liczba sprzętu łączącego w Internecie tylko maszyny (M2M - Machine to Machine) ma zrównać się z liczbą ludności na Ziemi.

Wkrótce ruch w sieciach mobilnych zwiększy się dziesięciokrotnie, osiągając roczny wzrost na poziomie 60%. Już w roku 2013 aż 33% ruchu IP pochodziło z urządzeń niebędących komputerami osobistymi. Transfer danych związany z usługami wideo ma wynosić w 2018 r. dwie trzecie całego ruchu w sieci.

W 2013 r. wartość ta osiągnęła 42%.

Sieć wciąż chce więcej

Tempo to może rosnąć jeszcze szybciej niż głoszą prognozy, zwłaszcza gdy spojrzymy na błyskawiczny rozwój narzędzi wizualnych w Internecie. Weźmy np. pod lupę aplikację smartfonową Periscope. Pozwala ona na przeprowadzanie czegoś w rodzaju transmisji wydarzenia, którego jesteśmy uczestnikami, i włączenie w nie osób z internetowej społeczności (3). Wystarczy ją uruchomić, by setki, a może nawet tysiące osób mogły na żywo podziwiać to, co widzimy, lub "wejść" w nurt naszego codziennego internetowego życia. Nie jest to jedyna tego rodzaju appka.

Mobilny świat zna jeszcze np. aplikację Meerkat, a wcześniej internauci korzystali z Livestreamu lub Ustream. Periscope pozwala jednak na wirtualne wejście w cudzy świat. Możemy np. siedząc w biurze w Poznaniu, jechać samochodem po kanadyjskim lesie, być na koncercie w Tokio lub podziwiać widok z Wieży Eiffla. I to nie tak, jak w telewizji. Członkowie społeczności mogą bowiem na żywo zgłaszać uwagi i np. prosić o skierowanie kamery w określonym kierunku, na konkretny obiekt lub osobę.

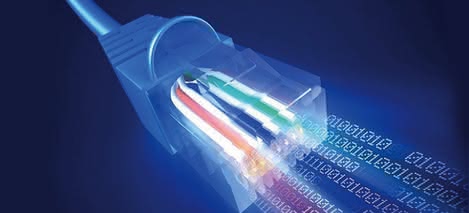

Jak jednak zauważy od razu przytomny użytkownik mobilnej sieci, aby te transmisje na żywo w ogóle działały, muszą być zapewnione zarówno zasięg, jak i sprawna sieć, i to na wysokim poziomie - tak po stronie nadawcy, jak i odbiorców. Chodzi przecież o wideo na żywo... Dlatego właśnie naukowe ośrodki na całym świecie niezmordowanie pracują nad zwiększeniem pojemności łączy (4). 1,4 terabajta (TB) na sekundę - to teraz szybkość przesyłu danych istniejącymi i wykorzystywanymi na co dzień dla celów sieciowych przewodami, z którą muszą się zmierzyć chętni do dalszego ustanawiania rekordów.

O udanym teście rekordowej prędkości poinformowały firma telekomunikacyjna British Telecom oraz francuski dostawca rozwiązań sieciowych Alcatel-Lucent. Test polegał na przesłaniu danych pomiędzy centrum Londynu a położonym w odległości 400 km miastem Ipswich. Osiągnięta prędkość 1,4 TB/s oznacza, że można by w ciągu sekundy przesłać tym łączem 44 filmy o jakości HD. W teście wykorzystano najnowszą technologię o nawie flexigrid, która pozwala optymalizować transfer danych, przez tworzenie w sieci odrębnych kanałów. W tym przypadku było ich siedem po 200 GB/s każdy.

Istnieją co prawda metody szybszego przesyłu danych, np. złożone systemy wykorzystujące lasery, ale na razie ograniczają się do sfery laboratoriów naukowych. Tymczasem wspomniana technologia BT i Lucenta wykorzystuje już zainstalowaną i wykorzystywaną sieć. Prace nad nowymi rozwiązaniami mają na uwadze przede wszystkim szybko rosnące zapotrzebowanie użytkowników Internetu na coraz szybsze i bardziej przepustowe łącza.

Pod koniec października 2014 r. wspólna praca naukowców z holenderskiego Uniwersytetu Technologicznego w Eindhoven i Uniwersytetu Środkowej Florydy pozwoliła ustanowić nowy rekord przesyłu danych pojedynczym włóknem optycznym o długości jednego km. Udało się im osiągnąć transfer na poziomie 256 terabitów (Tb) na sekundę (32 terabajtów na sekundę).

Informacje o kolejnych rekordach w szybkości transferu pojawiają się ostatnio coraz częściej. Dwa miesiące przed Holendrami badacze w duńskiej uczelni DTU poinformowali o osiągnięciu prędkości transferu danych na poziomie 43 terabitów na sekundę (mniej więcej 5,4 terabajty na sekundę). Poprzedni rekord prędkości - 26 Tb/s należał do niemieckiego Instytutu Technologicznego w Karlsruhe i na pobicie czekał trzy lata.

Równie szybkie, a nawet szybsze, są postępy prac nad prędkościami sieci mobilnych. Od maja 2013 r. rekord szybkości bezprzewodowego transferu danych na większą odległość wynosi 40 Gb/s. Należy do niemieckiego zespołu naukowców ze wspomnianego Instytutu Technologii w Karlsruhe. Niemcom udała się rekordowa transmisja na odległość ok. jednego kilometra, pomiędzy dwoma budynkami, przy częstotliwości sygnału 240 GHz. Natomiast jesienią 2013 r. za pomocą eksperymentalnych fal sub-terahercowych osiągnęli prędkość przesyłu rzędu 100 Gb/s na odległość 20 m.

Koreański Samsung zapowiedział w październiku ubiegłego roku wprowadzenie nowego standardu Wi-Fi, który cechować będzie się pięć razy większą prędkością niż dotychczas znane rozwiązania. W praktyce oznacza to, że film o wielkości 1 GB da się przesłać pomiędzy urządzeniami w niecałe trzy sekundy. Funkcjonujące do tej pory częstotliwości technologii Wi-Fi - 2,4 GHz i 5 GHz - pozwalały na szybkość transferu sięgającą maksymalnie 866 Mb/s.

Przygotowany przez Samsunga standard 60 GHz pozwala na znacznie więcej. Według zapewnień firmy, szybkość przesyłania danych może wynieść nawet 4,6 Gb/s. Prędkość takiego rzędu udaje się osiągnąć dzięki wyeliminowaniu zakłóceń, powstających w kanale w wyniku podłączania się coraz większej liczby urządzeń będących w zasięgu sieci. Przy częstotliwości 60 GHz wszystkie urządzenia mogą łączyć się jednocześnie i nie wpływa to na obniżanie ogólnej przepustowości sieci. Komercyjnych rozwiązań opartych na nowym standardzie należy spodziewać się już w tym roku.

Przyszłością sieci mobilnych będą prawdopodobnie pasma terahercowe, o których słyszeliśmy już w przypadku wspomnianych eksperymentów Niemców z Karlsruhe. Niedawno Andrew Paulsen i Ajay Nahata z Uniwersytetu w Utah zaprezentowali filtry własnego projektu, pozwalające separować różne częstotliwości w zakresach fal terahercowych i które, jak głoszą często powtarzane obietnice, przyspieszą co najmniej tysiąckrotnie bezprzewodowe transfery.

Technologia pCell, autorstwa wynalazcy i przedsiębiorcy, Steve'a Perlmana, to próba rozwiązania problemu przepustowości sieci bezprzewodowych w inny sposób. Duże wrażenie na komentatorach zrobiły testy przeprowadzone przez wynalazcę, który odtwarzał w jednym pomieszczeniu różne strumienie wideo równocześnie na ośmiu iPhone'ach, dwóch telewizorach o rozdzielczości 4K i kilku innych przenośnych urządzeniach. W tradycyjnych komórkach sieci bezprzewodowej transmisje danych odbywają się we wszystkich kanałach równocześnie i aparaty w nich przebywające niejako muszą je współdzielić.

Technologia pCell polega na tworzeniu komórek sieci, w których poszczególne urządzenia otoczone są, jak to się opisuje, "bąblami". Oznacza to, że telefon lub tablet nie czeka na dane, lecz pobiera je od razu z maksymalną przepustowością dostępną w danej komórce. Jak się łatwo domyślić, wiąże się to z koniecznością tworzenia specjalnej infrastruktury dla nowego typu komórek sieci. Punkty dostępowe, oferowane przez firmę Perlmana, Artemis Networks, nazywa się pWave (5).

Poszukiwania technologii, zarówno przewodowych jak i bezprzewodowych, które będą przenosić wielokrotnie większe ilości danych to nie wszystko. Mnożą się bowiem koncepcje geograficznego upowszechnienia Internetu, dostarczenia go do miejsc, do których jeszcze nie trafił lub w których dostępny jest w niewielkim zakresie. Najgłośniejsze z nich, projekty Google'a, Facebooka oraz SpaceX, znane są w mediach pod wspólną nazwą…

...Sky-Fi

W rozwiniętych krajach w trybie online znajduje się grubo ponad połowa ludności. W Afryce jednak w 2014 r. mogło tak o sobie powiedzieć zaledwie 19%. A i to głównie w dużych ośrodkach miejskich, bo tam budowa infrastruktury jest łatwiejsza i bardziej opłacalna.

I o tych właśnie regionach przede wszystkim myślą obecnie w swoich przedsięwzięciach potentaci Internetu. Chcą zanieść sieć na pustkowia. Google - za pomocą okrążających Ziemię napełnionych helem balonów. Facebook - na skrzydłach dronów. SpaceX - za pomocą mikrosatelitów rozmieszczonych na niskich orbitach. Plany zakładają, że latające serwery zapewnią lokalnym dostawcom dostęp do sieci po obniżonych cenach, a to z kolei przełoży się na lawinowy wzrost liczby indywidualnych użytkowników.

Facebook zamierza korzystać z zasilanych energią słoneczną dronów firmy Ascenta, którą zresztą kupił w 2014 r. Urządzenia mają latać 20 km nad Ziemią, czyli wysoko ponad trasami przelotów samolotów pasażerskich (6). Zasilanie słoneczne oznacza możliwość przebywania w powietrzu bez przerwy całymi miesiącami. Choć w porównaniu z satelitami urządzenia pokrywać mogą znacznie mniejsze obszary, to jednak w odróżnieniu od orbitalnych "machin" można je sprowadzić na Ziemię, naprawić, przenieść nad inny teren. O mniejszych kosztach wyniesienia nie ma nawet co wspominać.

Google eksperymentowało z dronami, ale w końcu zdecydowało się, że Projekt Loon opierać się będzie na balonach wypełnionych helem. W gondoli mają się znajdować urządzenia nadawcze, zdolne również do komunikacji wzajemnej pomiędzy sobą, podobnie zresztą jak drony Facebooka i mikrosatelity SpaceX. Balony Google'a wyróżniają się tym, że nie tylko dostarczają sygnał do stacji bazowych telefonii komórkowej czy do nadajników Wi-Fi na Ziemi, ale mogą same służyć jako stacje bazowe, a pojedyncze urządzenia mobilne łączą się z nimi bezpośrednio (7). W lutym 2014 r. rekord czasu trwania lotu balonu Loon wynosił 50 dni.

Obecnie balony mogą już unosić się w stratosferze sześć miesięcy a nawet dłużej. Balony Google'a nie mają silników, ale można nimi sterować za pośrednictwem komputera. Kierunek lotu jest przyjmowany za pomocą zmiany wysokości w stratosferze. Wiatry wieją tam warstwowo w różnych kierunkach. Wystarczy zmienić warstwę, aby obrać pożądany kierunek. Wiedza o kierunkach i szybkościach wiatrów pochodzi z trzydziestoletnich badań wysokich warstw atmosfery.

Internet dla każdego, ale nie w całości

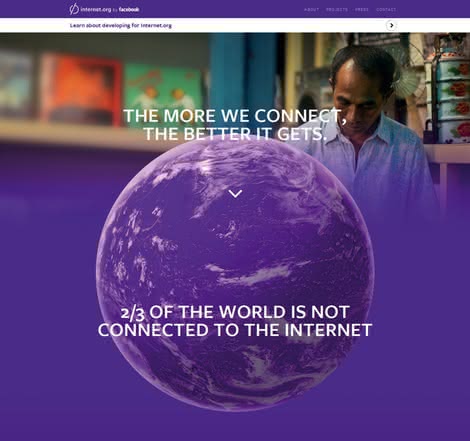

Oczywiście, wielkie firmy nie działają bezinteresownie. Najbardziej zależy im na tym, aby nowi internauci korzystali przede wszystkim z ich usług. Od pewnego czasu Facebook udostępnia np. projekt Internet.org, którego celem jest bezpłatne podłączenie jak największej liczby ludzi do Internetu - często bowiem brak infrastruktury oraz środków na sfinansowanie usługi komercyjnej są głównymi barierami uniemożliwiającymi dostęp do Sieci. Projekt funkcjonuje dzięki współpracy kilku firm, takich jak m.in. Facebook, Samsung, Opera czy Nokia (8). Użytkownicy mają tu dostęp do ograniczonej liczby usług i stron internetowych.

Z programu Internet.org wyłączone są też usługi wymagające wysokiej przepustowości łącza. Niemożliwe jest więc wykorzystanie technologii VoIP, strumieniowania wideo, pobierania plików czy udostępniania zdjęć w bardzo wysokich rozdzielczościach. Strony muszą być też odpowiednio zintegrowane z platformą, co oznacza, że nie mogą wykorzystywać JavaScript, SSL, TLS i HTTPS. Poza tym powinny być zgodne z udostępnionymi przez Facebooka wytycznymi. Aplikacja dostępna jest mobilnie w krajach Azji, Afryki oraz Ameryki Łacińskiej. W projekcie uczestniczą także dostawcy Internetu z tych krajów. Nie muszą za to płacić, a sama aplikacja jest pozbawiona reklam.

W Indiach pojawiły się już jednak zarzuty, że aplikacja nie umożliwia korzystania ze wszystkich zasobów Sieci, co miałoby być sprzeczne z zasadą jej neutralności. Stąd też decyzja niektórych firm z tego kraju, by z projektu się wycofać. Mark Zuckerberg z Facebooka odpowiedział na te zarzuty otwarciem platformy na wszystkich zainteresowanych nią programistów.

Jeśli ci chcą udostępnić swoje materiały, muszą jednak przestrzegać kilku ważnych zasad, w tym najważniejszej, zgodnie z którą cały projekt powstał do promowania nie danych usług, a raczej Internetu jako całości. Internetowe "powietrze" jest już, jak widać, dostępne. Problem w tym, że niektóre firmy chcą, abyśmy tylko ich powietrzem oddychali, a nie konkurencji. Z drugiej strony - wysokiej wydajności łącza, jakich wymaga nowy wirtualny świat, nie są za darmo. Ktoś za wizualne doznania musi zapłacić. Zwykle, gdy zejdziemy w dół łańcucha rynkowego, jest to klient.