Być jak człowiek. Maszyny ludziom, ludzie maszynom

Najambitniejszą częścią biomimetyzmu są próby odtworzenia w świecie nieożywionym mózgu. Mózg nie potrzebuje jednostki centralnej (CPU) ani dysku twardego. Działa na zasadzie otwierania i zamykania błon nerwowych oraz wysyłania fal naładowanych jonów. Fale te powodują zmiany w końcówkach nerwowych, pozwalających na funkcjonowanie mózgu - ów proces nazywany jest plastycznością synaptyczną i pozwala nam uczyć się oraz przetwarzać informacje.

Hipotetyczne sztuczne konstrukcje obliczeniowe naśladujące ludzki mózg nazywane są "neuromorficznymi" - termin ten stworzył w latach 80. XX wieku amerykański uczony Carver Mead. Znane były jego próby imitacji neuronów za pomocą specjalnie skonfigurowanych układów tranzystorowych. Naukowcy z całego świata od dawna usilnie pracują nad systemami działającymi podobnie jak ludzki mózg. Z tego powodu bywają one nazywane sztucznym mózgiem.

Co potrafi ludzki mózg, z czym nie radzi sobie wciąż nawet najbardziej zaawansowany układ sztucznej inteligencji? Potrafi np. szybko poskładać ogrom chaotycznych informacji w sensowne wnioski. Dlatego zbudowanie komputera zdolnego do równoczesnego przetwarzania i zapisu informacji - na podobieństwo mózgu, który błyskawicznie analizuje, zapamiętując wielkie zbory danych - należy obecnie do największych wyzwań technologicznych.

Jak prawdziwe neurony

Wszystkie tradycyjne komputery i urządzenia komputeropodobne opierają się na architekturze opracowanej przez Johna von Neumanna, w której układy procesorowe i pamięciowe są od siebie odseparowane. To poręczne rozwiązanie, gdy chcemy, aby maszyna działała na różnych programach. Jednak procesory, gdy pracują, sięgają po dane z pamięci, a przesyły trwają. Jednostka obliczeniowa czekająca na dane pozostaje często nieczynna.

Ilości danych pochodzących z baz tworzonych przez ludzi i maszyny (działające w ramach Internetu Rzeczy) są obecnie gigantyczne. Architektura von Neumanna staje się w tych procesach wąskim gardłem. Jak szacuje amerykański Departament Energii, na komputerowe przetwarzanie danych zużywanych jest obecnie od 5 do aż 15% światowej produkcji energii - w tym bardzo wiele na same transmisje. Usprawnić to mogłyby rozwijane od lat techniki kwantowe i fotoniczne, które wymagają mniej energii, są szybsze i bardziej efektywne. Jednak ich wykorzystanie to wciąż sfera obietnic. Specjaliści coraz ciekawszym okiem spoglądają więc na rozwiązania oferowane przez ludzki mózg.

Próby zbudowania elastycznych i efektywnie uczących się sieci neuronowych podejmowane są od lat 50. XX wieku. Szczytowym osiągnięciem w tej dziedzinie wydaje się na razie DeepMind Google’a, który w 2016 r. pokonał arcymistrza gry w "Go". Jednak ten syntetyczny mózg jest software’ową symulacją sieci neuronowej, zaś fizyczne obliczenia wciąż odbywają się w krzemowych układach. Zatem wąskie gardło von Neumanna wcale nie zostało tu przezwyciężone.

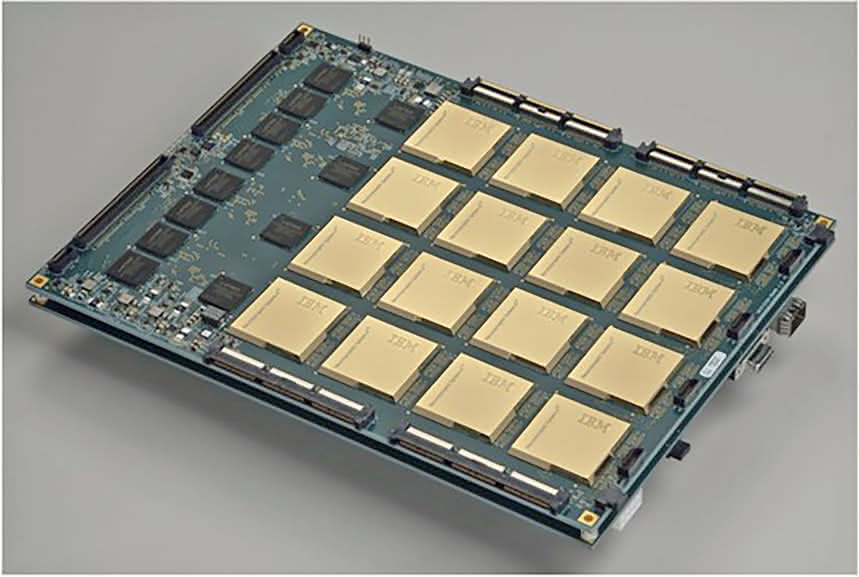

Fizycznie sieć neuronową imituje neuromorficzny procesor IBM o nazwie TrueNorth, skonstruowany w 2014 r. Problem w tym, że gdyby wykorzystać jego architekturę do budowy pełnego syntetycznego odpowiednika mózgu, komputer taki potrzebowałby 10 tys. razy więcej energii niż to, co pracuje w ludzkiej głowie… W dodatku TrueNorth, choć potrafi rozpoznawać proste obrazy, nie działa tak jak połączenia neuronów z synapsami. Nie jest zdolny do wzmacniania pewnych połączeń w procesie uczenia się.

Intel od kilku lat pracuje nad technologią neuromorficznych procesorów naśladujących funkcjonowanie ludzkiego mózgu. W końcu pochwalił się pierwszym tego typu urządzeniem. Eksperymentalny chipset o nazwie Loihi już w 2018 r. trafi do czołowych uniwersytetów oraz instytutów badawczych zajmujących się rozwijaniem sztucznej inteligencji. Firma pisze: "Intel wynalazł pierwszy w swoim rodzaju samouczący się, neuromorficzny chip o kodowej nazwie Loihi naśladujący funkcjonowanie ludzkiego mózgu poprzez działanie na zasadzie bodźców o różnej sile, uzyskiwanych ze swojego otoczenia". Procesor składa się ze 130 tys. krzemowych "neuronów", połączonych 130 milionami "synaps". Zdaniem Intela jest tysiąc razy wydajniejszy pod względem energetycznym od klasycznych maszyn uczących.

Odejść od krzemu

Chipy TrueNorth czy rozwiązanie Intela wciąż jednak trzymają się krzemu, który ma swoje zalety, ale w sensie energetycznej wydajności nie umywa się do organicznej materii komórek neuronowych. Naukowcy pracują więc nad zupełnie innymi modelami komputerów neuromorficznych, które naśladowałyby plastyczność mózgu i pozwalały procesorom na imitowanie funkcji synaps, np. przy użyciu przejścia fazowego w pewnych materiałach, topniejących i krzepnących w określonych temperaturach przy zachowaniu zdolności do przechowywania i uwalniania dużych ilości energii.

Latem ubiegłego roku grupa naukowców pod kierownictwem Evangelosa Eleftheriou z laboratorium IBM w Zurichu poinformowała w "Nature Nanotechnology", że udało jej się zbudować sztuczną wersję neuronu. Składa się on z warstwy tellurku germanowo-antymonowego, umieszczonej pomiędzy elektrodami. Wykorzystuje się tu zmienność fazową tego materiału, który w zależności od przyłożonego napięcia zmienia się z izolatora w półprzewodnik, a następnie w przewodnik. Zdaniem uczonych naśladuje to fluktuacje w zachowaniu neuronów. Są też już inne projekty, w których zmiany fazowe w sztucznych synapsach przebiegają pod wpływem fali świetlnej, co oznacza znacznie mniejsze zużycie energii. Nie jest więc to jedyne proponowane rozwiązanie.

Naukowcy z Uniwersytetu Southampton wykazali pod koniec 2016 r., że memrystory i rezystory są zdolne do zapamiętania swoich poprzednich wartości oporu i można wykorzystać je do tworzenia rozbudowanych oraz zaawansowanych sieci neuronowych. W ramach eksperymentów przygotowali sieć memrystorów z tlenków metali i wykorzystali je jako sztuczne synapsy.

Dzięki temu zainicjowali proces uczenia się bez interwencji z zewnątrz - podobnie, jak odbywa się to w ludzkim mózgu. Stworzone przez naukowców memrystory nie tylko zużywają mniej energii niż poprzednie rozwiązania, ale również pamiętają swój poprzedni stan. To elektroniczne komponenty ograniczające lub regulujące przepływ prądu elektrycznego w obwodzie i będące w stanie zapamiętywać wielkość ładunku, która przez nie przepłynęła oraz zachować dane nawet po wyłączeniu zasilania. Zasadniczo pełnią funkcję zbliżoną do synaps i mają samoistną zdolność do jednoczesnego wykonywania zadań obliczeniowych i przechowywania informacji przy mocno obniżonych objętościach i stracie mocy.

Zespół badawczy z Uniwersytetu Southampton opracował memrystorowy czujnik integrujący (Memristive Integrative Sensor - MIS) w nanoskali, do którego wprowadził serie próbek "napięcie-czas", odtwarzających aktywność elektryczną komórek nerwowych. Funkcjonując jak synapsy komórek mózgowych, czujniki MIS "metal-tlenek" były podobno w stanie kodować i kompresować (aż 200-krotnie) aktywność komórek nerwowych rejestrowaną za pomocą matryc wieloelektrodowych. Naukowcy zapewniają, że oprócz uporania się z ograniczeniami szerokości pasma, ich podejście jest niezwykle energooszczędne, gdyż zasilanie niezbędne dla każdego kanału zapisywania było aż stukrotnie niższe w porównaniu do najlepszych obecnie rozwiązań.

Zadanie neuromorficznych konstruktorów wydaje się jednak wielokrotnie trudniejsze w świetle nowych odkryć uczonych z kalifornijskiej uczelni UCLA - okazuje się, że mózg ma ponad sto razy większą pojemność obliczeniową, niż wcześniej zakładano. Według tych ustaleń, dendryty, kiedyś uznawane za proste pasywne kanały do przesyłania sygnałów, wydają się bardzo aktywne elektrycznie, generując dziesięciokrotnie więcej impulsów niż soma (ciało komórki nerwowej).

- Dendryty stanowią ponad 90% tkanki nerwowej - zauważył Mayank Mehta, neurofizyk z UCLA, opisując w mediach kalifornijskie badania.

Niewidzialne widzialne dzięki maszynom

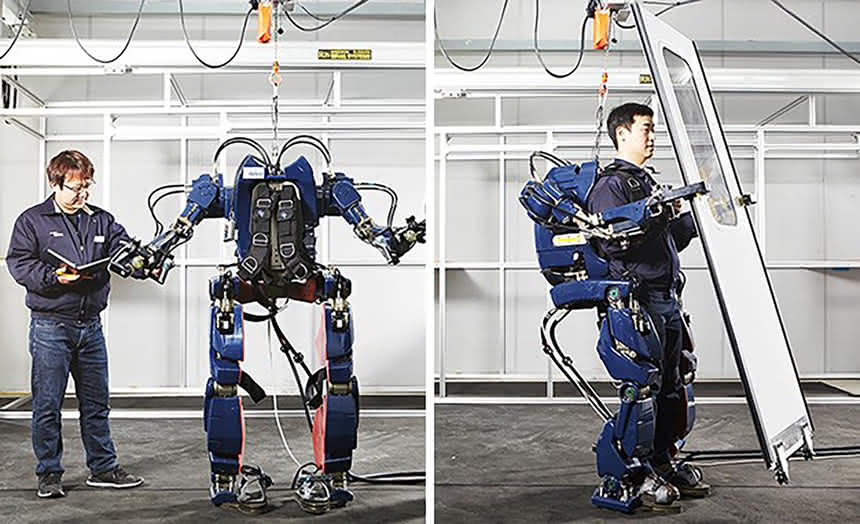

Naśladowanie naszych mózgów nie idzie jeszcze maszynom zbyt dobrze. W zamian dostaliśmy jednak "od nich" - i wciąż dostajemy - rzeczy, które pozwalają nam nie tylko np. polecieć w przestworza czy podźwignąć wielkie ciężary, ale też zobaczyć i usłyszeć to, czego nasze zmysły nie ogarniają. Od dawna mamy noktowizory, termowizory, detektory w zakresie ultrafioletu i sonary. Urządzenia te zapewniają nam dostęp do zdolności obserwowanych wcześniej tylko u zwierząt czy owadów. Nawiązując do mechanizmów ze świata natury, pozostają wytworami myśli technicznej.

Typowym przykładem nowoczesnej technologii otwierającej nam oczy na nowe światy są soczewki z supercienkim detektorem grafenowym, pracującym w pełnym zakresie podczerwieni. Powstały na amerykańskim Uniwersytecie Michigan, w wyniku badań zespołu prof. Zhaohui Zhonga. Inna grupa naukowców i inżynierów - pod wodzą Josepha Forda z Uniwersytetu Kalifornijskiego w San Diego oraz Erica Tremblaya z Instytutu Mikroinżynierii w Lozannie - opracowała z kolei szkła kontaktowe z filtrem polaryzacyjnym, podobne do noszonych w kinach 3D, pozwalające widzieć z prawie trzykrotnym powiększeniem.

Jest też oczywiście rozszerzona rzeczywistość, która nie tylko pozwala lekarzom oglądać bezoperacyjnie wnętrze ludzkiego ciała, ale może pomóc np. strażakom szybko orientować się i szukać ludzi w pożarach, gdy widoczność staje się słaba lub nawet zerowa. Hełm C-Thru ma wbudowaną kamerę termowizyjną, z której obraz przekazywany jest strażakowi noszącemu ów hełm prosto na wyświetlacz znajdujący się przed jego oczami. Z kolei system Striker II, stworzony przez BAE Systems z myślą o pilotach samolotów, zintegrowany z hełmem, wyposażono w sensory, które automatycznie przestawiają gogle pilota w tryb nocny z noktowizorem.

Można wreszcie sięgnąć po kamery, które widzą to, co niewidzialne. Choćby rzeczy znajdujące się za rogiem budynku. Wynalazek, który na to pozwala, skonstruowali naukowcy z uniwersytetów w niemieckim Bonn i w kanadyjskiej Kolumbii Brytyjskiej. Opiera się na odtwarzaniu obrazów poza polem widzenia, za pomocą rozproszonego światła. Technika wykorzystuje laserową wiązkę rzucaną na ścianę, zasłaniającą obiektywowi kamery to, co ma zostać zaobserwowane. Urządzenie zbiera wiele różnych odbić światła i sumuje je, starając się wytworzyć wypadkową, czyli zarys obrazu. Początkowo w wizjerze kamery widać po prostu ścianę. Jednak po chwili, gdy zaczynają działać subtelne algorytmy matematyczne, wykrywające tzw. echo obrazu (czyli niewielkie ilości światła odbite od obiektu, rozproszone a następnie padające na powierzchnię ściany), zaczynamy widzieć kształty schowane za rogiem. Takich rzeczy nie potrafi już żadne żywe stworzenie!

Są też techniki, które pozwalają "zobaczyć" coś w ciemności, a nie potrzebują więcej niż foton na piksel. Choćby ta opracowana przez Ahmeda Kirmaniego z Massachusetts Institute of Technology (MIT) i opisana w "Science". Urządzenie, które skonstruował wraz ze swoim zespołem Kirmani, wysyła w ciemnościach laserowy impuls o niewielkiej mocy, który, po odbiciu od obiektu, zapisuje w detektorze pojedynczy piksel. Sama zasada działania nie jest nowa. Nowością staje się wyrafinowany algorytm, który sprawia, że do tworzenia obrazu potrzeba wielokrotnie mniejszej liczby fotonów niż dotąd. Jak się oblicza, wystarczy zaledwie jedna setna tego, co niezbędne jest obecnie używanym detektorom światła w trudnych warunkach, np. w technice LIDAR.

Skoro zaś istnieją oparte na rozszerzonej rzeczywistości możliwości "oglądania" wnętrza pracującego silnika auta za pomocą dźwięków stamtąd dobiegających, to może czas na kamerę, która "czyta" dźwięki na podstawie obrazu? Prototyp takiego urządzenia opracowali specjaliści z MIT, Microsoft i Adobe. Odpowiedni algorytm rejestrował dźwięki przemowy dochodzącej z torby chrupków ziemniaczanych, od których rejestrator był oddzielony dźwiękoszczelną szybą. W innych eksperymentach udawało się wydobywać dźwięki na podstawie niemego filmu wideo. Technika polega na "wnioskowaniu" o dźwiękach za pomocą analizy ruchu i wibracji obiektów.

Trudno nie zauważyć, iż dążenia do biomimetyzmu i neuromorfizmu oraz kolejne rozwiązania wzmacniające nasze zmysły wyraźnie pokazują, jak współczesna technologia - mimo tylu obaw - skoncentrowana pozostaje wciąż na człowieku.