Wioska na przełomie generacji

Jak zmienią się nasze sposoby komunikacji w najbliższej przyszłości? Jaki nowy skok przygotowuje branża telekomunikacyjna? W listopadzie 2018 r. na konferencji Capacity Europe w Londynie giganci tego sektora odsłonili kolejne etapy rewolucji: sieci 5G, nowe rodzaje chmur i światłowodów, nowe częstotliwości. A to tylko te rozwiązania, które już znamy i wprowadzamy na coraz większą skalę. W ośrodkach badawczych trwa bowiem testowanie jeszcze nowszych koncepcji - od nowych zakresów fal, przez wykorzystanie światła, aż po sieci kwantowe.

Naukowe ośrodki na całym świecie niezmordowanie pracują nad zwiększeniem pojemności łączy. W czerwcu 2018 r. specjaliści z Instytutu Badawczego NICT oraz firmy Fujikura Ltd. przeprowadzili eksperyment transmisji światłowodowej na odległość 1045 km z szybkością 159 Tb/s terabajtów na sekundę. Wykorzystali przewód światłowodowy zdolny do wielopasmowej transmisji multipleksowej, o standardowej średnicy zewnętrznej (0,125 mm), który może być zintegrowany z istniejącym już sprzętem.

Doświadczenie miało miejsce w warunkach laboratoryjnych. Dobrze byłoby jednak móc wykorzystać również zbudowaną wcześniej infrastrukturę. W marcu tego roku poprzez transatlantycki kabel MAREA o długości 6400 km, należący do Microsoftu i Facebooka, będący obecnie najdłuższym na świecie podmorskim przewodem, ustanowiono nowy rekord transferu danych - przesłano informacje z prędkością 26,2 Tb/s. Osiągnięcie przekroczyło oczekiwania samych naukowców, którzy szacowali, że przewodem da się przesyłać maksymalnie 20 Tb/s (jego całkowita przepustowość teoretycznie może osiągać poziom 160 TB/s). Kabel biegnie od hiszpańskiego miasta Bilbao aż do amerykańskiego Virginia Beach. Badacze z firmy Infinera, którzy przeprowadzili test, podkreślają, że rekord został pobity przez już istniejący przewód, więc wydawanie setek milionów na nowe światłowody może okazać się zbyteczne. Kluczowa powinna być modernizacja zbudowanych instalacji.

Informacje o kolejnych rekordach w szybkości transferu pojawiają się w ostatnich latach coraz częściej. W maju 2018 r. japoński operator telekomunikacyjny NTT z powodzeniem zademonstrował pierwszą na świecie transmisję bezprzewodową o przepustowości 100 Gb/s, wykorzystując nową technologię, która przewyższa standardy 5G. Nazywana multipleksowaniem orbitalnego momentu pędu (Orbital Angular Momentum multiplexing), prawdopodobnie nie zostanie jednak wprowadzona na dużą skalę przed rokiem 2030. NTT przeprowadziło eksperymenty transmisyjne na odległość 10 m z wykorzystaniem systemu pracującego w paśmie częstotliwości 28 GHz.

Sieć na pustkowia

Oprócz poszukiwań technologii zdolnych przenosić wielokrotnie większe ilości danych, zarówno przewodowych jak i bezprzewodowych, mnożą się koncepcje geograficznego upowszechnienia Internetu (2), dostarczenia go do miejsc, w których pozostaje jeszcze niedostępny lub dostępny tylko w niewielkim zakresie. Najgłośniejsze z nich w ostatnich latach to projekty Google’a, Facebooka i SpaceX.

Google chciałby zrealizować swój plan za pomocą okrążających Ziemię napełnionych helem balonów. Facebook myślał o wykorzystaniu skrzydeł dronów. SpaceX zaś - o użyciu mikrosatelitów rozmieszczonych na niskich orbitach w ramach kontrowersyjnego projektu Starlink. Plany zakładają, że latające serwery zapewnią lokalnym dostawcom dostęp do sieci po obniżonych cenach, co z kolei przełoży się na lawinowy wzrost liczby indywidualnych użytkowników. Zasilane energią słoneczną olbrzymie drony stratosferyczne Facebooka miałyby latać 20 km nad ziemią, czyli wysoko ponad trasami przelotów samolotów pasażerskich.

Zasilanie słoneczne oznaczałoby możliwość pozostawania w powietrzu bez przerwy przez całe miesiące. Jednak w ubiegłym roku facebookowy projekt Aquila trafił na półki. Zwolniono pracowników zaangażowanych w prace nad urządzeniami, choć sam pomysł ogólnie nie jest chyba jeszcze całkowicie nieaktualny, bo wcześniej Facebook oświadczył, że nad platformami statosferycznymi pracuje wraz z Airbusem.

W 2016 r. brytyjska gazeta "The Guardian" podała informację, że Google rozpoczęło testy systemu dronów o nazwie Project Skybender, których zadaniem będzie dostarczanie Internetu 5G za pomocą technologii fal milimetrowych. Porzucono jednak tę koncepcję na rzecz Internetu balonowego Loon, który opierać się ma na lotach balonów wypełnionych helem (3). W gondolach znajdą się urządzenia nadawcze, zdolne - oprócz rozsiewania Internetu w dół - do komunikacji wzajemnej pomiędzy sobą, podobnie zresztą jak drony Facebooka i mikrosatelity SpaceX.

Balony Google’a wyróżniają się tym, że nie tylko dostarczają sygnał do stacji bazowych telefonii komórkowej, czy do nadajników Wi-Fi na ziemi, ale mogą same służyć jako stacje bazowe, z którymi bezpośrednio łączą się pojedyncze urządzenia mobilne. W lutym 2014 r. rekord czasu trwania lotu balonów Loon wynosił pięćdziesiąt dni. Obecnie mogą one unosić się w stratosferze już sześć miesięcy, a nawet dłużej. Kilka miesięcy temu do projektu dołączył jako inwestor japoński potentat informatyczny Softbank. Balony Google’a nie mają silników, ale można nimi sterować za pośrednictwem komputera. Kierunek lotu jest przyjmowany za pomocą zmiany wysokości w stratosferze. Wiatry wieją tam warstwowo w różnych kierunkach. Wystarczy zmienić warstwę, aby obrać pożądany kierunek. Wiedza o kierunkach i szybkościach wiatrów pochodzi z trzydziestoletnich badań wysokich warstw atmosfery.

Z kolei wg planu Elona Muska, szefa SpaceX, satelity Starlink zapewnią tani i niezawodny dostęp do Internetu na całym świecie - także w miejscach, w których obecnie infrastruktura telekomunikacyjna pozostaje słabo rozwinięta. W listopadzie 2018 r. SpaceX uzyskało zgodę na wystrzelenie swojej konstelacji urządzeń służących realizacji założonego celu. Satelity te mają być rozmieszczane na wysokościach ok. 550 i 1200 km.

SpaceX jest jedną z dziewięciu firm, o których wiadomo, że pracują nad projektami globalnego dostarczania Internetu z kosmosu. Do rozmieszczenia sieci satelitów tego typu przymierzają się m.in. konsorcja OneWeb i Kepler Communications. W kwietniu tego roku plany wysłania na orbitę ponad 3 tys. satelitów do szerokopasmowej komunikacji zgłosiła firma Amazon, w ramach przedsięwzięcia Project Kuiper.

Na razie spośród wymienionych, oprócz SpaceX, tylko firmie OneWeb udało się - i to znacznie wcześniej niż firmie Muska - pomyślnie wynieść na orbitę pierwsze urządzenia do dystrybucji kosmicznego Internetu. OneWeb informuje, że w pierwszej części przedsięwzięcia testowanych jest dwanaście satelitów. Każde z urządzeń waży po ok. 150 kg. Konstelacja będzie działać na niskiej orbicie okołoziemskiej, na wysokości ok. 1200 km nad powierzchnią Ziemi.

W najbliższych latach OneWeb chce umieścić na orbicie ok. 700 satelitów (docelowo będzie to ok. 2 tys.), a kolejne 200 ma być przeznaczone na wymianę, gdyby któryś się nagle popsuł. Działanie pierwszej konstelacji satelitów wyceniono na ok. 2 mld dolarów, a do opracowania pozostały jeszcze niewielkie terminale dla użytkowników, zapewniające dostęp do sieci o prędkości 50 Mbit/s. Nowe satelity, zbudowane już w Stanach Zjednoczonych, będą z czasem wynoszone na orbitę znacznie taniej, szybciej i bezpieczniej niż obecnie, bo na pokładzie rakiety LuncherOne zbudowanej przez firmę Richarda Bransona Virgin Orbit, odpalanej ze znajdującego się w trakcie lotu Boeinga 747-400 Cosmic Girl.

Oczywiście wielkie firmy działają nie do końca bezinteresownie. Najbardziej zależy im na tym, aby nowi internauci korzystali przede wszystkim z ich usług. Opracowywane przez nie projekty budzą również sporo rozmaitych kontrowersji. Przykładowo, zdaniem astronomów satelity systemu Starlink mają utrudniać obserwacje nieba z Ziemi.

Wycisnąć więcej z 5G

Sieć 5G, która opiera się na sieciach światłowodowych, jest dziesięć razy szybsza niż powszechne już dziś 4G i oferuje mniejsze opóźnienia oraz większą przepustowość. Kilka miesięcy temu opisywaliśmy w raporcie "MT" jej zalety, ale również potencjalne wady, więc nie będziemy w tym tekście wchodzić we wszystkie szczegóły. Przez ten czas pojawiło się jednak nieco nowych faktów, o których warto wspomnieć.

Komercyjne, pilotażowe sieci 5G, routery i smartfony zostały już uruchomione w Stanach Zjednoczonych i w wielu krajach na całym świecie. W Polsce Sejm uchwalił ustawę o wdrożeniu sieci 5G. Nowe prawo ma ułatwić budowę infrastruktury telekomunikacyjnej sieci kolejnej generacji. Przyjęte przez nasz parlament rozwiązania realizują zalecenia Komisji Europejskiej, która we wcześniej ogłoszonych dokumentach i deklaracjach wyrażała pragnienie, by kraje członkowskie do 2025 r. zadbały o szerokie pokrycie swych terytoriów siecią technologii 5G. Zgodnie ze wskazaniami Komisji w każdym kraju członkowskim do 2020 r. sieć 5G ma być dostępna na zasadach komercyjnych w co najmniej jednym dużym mieście. W nowych przepisach przewidziano też regulacje, które w związku z budową i modernizacją sieci mobilnych zapewnią dostęp do informacji o emisji promieniowania elektromagnetycznego. Rząd polski udostępnił również białą księgę, w której omówiono najważniejsze zagadnienia związane z polem elektromagnetycznym o częstotliwościach radiowych. Opracowanie dostępne jest pod adresem internetowym: www.gov.pl/web/5g/bialaksiega.

Według zestawienia Nokia 5G Maturity Index, opublikowanego w okresie poprzedzającym targi telekomunikacyjne Mobile World Congress 2019, większość operatorów planuje "ograniczone" komercyjne uruchomienie usług 5G już w okresie 2019-2020. Ogólnie rzecz biorąc, ponad 70% operatorów pracuje już nad 5G w celu poprawy istniejących usług konsumenckich.

Konkurencyjny wobec działań Nokii na rynku 5G Ericsson ogłosił pod koniec czerwca, że planuje budowę swojej pierwszej w pełni zautomatyzowanej inteligentnej fabryki w USA. Będzie się w niej produkować radiotelefony z zaawansowanym systemem antenowym mającym zwiększać przepustowość sieci i zasięg na obszarach wiejskich, a także radiotelefony 5G dla obszarów miejskich. Zakład będzie oczywiście oparty na sieci bezprzewodowej 5G.

- Dzięki łączności 5G przyspieszamy rozwój koncepcji Przemysłu 4.0 i tworzymy w pełni zautomatyzowaną fabrykę - chwalił się w mediach Fredrik Jejdling, wiceprezes Ericssona.

Wspomnijmy w tym miejscu o innym potentacie technologicznym, koncernie Qualcomm. Jest on szczególnie zainteresowany zastosowaniami przemysłowymi wykorzystującymi część pasma 6 GHz, które amerykańska Federalna Komisja Łączności Stanów Zjednoczonych zamierza oddać do użytku bez licencji.

Jak powiedział w wywiadzie dla "Wireless Week" Dean Brenner, wiceprezes Qualcommu, pasmo 6 GHz, w połączeniu z nową technologią, może rozwiązać problemy z łącznością w takich miejscach, jak magazyny, fabryki i porty, wymagającą szybszych, bardziej niezawodnych i solidnych połączeń niż obecna technologia WiFi, lub mobilności nieoferowanej przez połączenia przewodowe.

Technologia Qualcommu opiera się na nowym sposobie współdzielenia widma, przebiegającym na zasadzie innej niż podział czasu pomiędzy użytkowników. Technika ta nosi nazwę synchronicznego współdzielenia czasu i umożliwia użytkownikom z tego samego obszaru geograficznego jednoczesne wykorzystanie widma - napędzając to, co Dean Brenner określa jako "gigantyczny" przyrost wydajności lub trzy-cztery razy większą przepustowość.

Nowa technika różni się od asynchronicznej metody współdzielenia nielicencjonowanego spektrum, w której węzły (nawet te w tej samej sieci) muszą najpierw sprawdzić, czy kanał jest w użyciu. W czasie gdy węzeł "odsłuchuje" zajętość pasma, nie jest w stanie z niego korzystać, dopóki nie przyjdzie jego kolej. Zapobiega to zakłóceniom. Metoda ta może jednak okazać się niewystarczająca w miarę jak sieci stają się bardziej obciążone, co ma już miejsce w warunkach przemysłowych i w środowisku Internetu Rzeczy, gdzie potencjalnie wymagane jest działanie tysięcy czujników lub modułów. Synchroniczne współdzielenie w paśmie 6 GHz ma rozwiązać te problemy.

Inna firma interesująca się pasmem 6 GHz to Federated Wireless. W wywiadzie przeprowadzonym w kilka miesięcy temu jej prezes Iyad Tarazi powiedział "Wireless Week", że jego pracownicy wkładają wiele pracy w technologię pasma 6 GHz. W maju zbudowali nawet prototypowe urządzenie służące jego eksploracji. "W bardzo bliskiej przyszłości" Federated Wireless ma zademonstrować w pełni funkcjonalny prototyp automatycznej koordynacji częstotliwości (AFC).

Coś więcej niż 5G, ale jeszcze nie 6G

Koreański Samsung nie jest głównym rozgrywającym w technice 5G, zamierza jednak uciec do przodu i stawić czoła Nokii oraz Ericssonowi, pracując intensywnie nad kolejną odsłoną komunikacyjnych rozwiązań - siecią 6G. Badania Samsung 6G są prowadzone w Seulu, w Advanced Communications Research Center.

- Aby rozpocząć badania nad tym rozwiązaniem, poszerzyliśmy nasz zespół ds. standardów technologii telekomunikacyjnych - poinformował rzecznik Samsunga w dzienniku "The Korea Herald".

Wczesne rozważania ekspertów podają oczekiwaną prędkość 6G na poziomie 1 Tb/s. Zwykły użytkownik obecnie więcej niż potrzebuje, ale kto wie, ile będzie wymagane np. za sześć lat, gdy rozwiązania rynkowe Samsunga staną się już gotowe. Wszystko to może zresztą potrwać dłużej, zważywszy, że sieć piątej generacji dopiero raczkuje.

Nad "czymś więcej niż 5G", choć niekoniecznie nazywa się to szóstą generacją, pracują również inni. Nadajnik bezprzewodowy zbudowany przez inżynierów z Uniwersytetu Kalifornijskiego zapuszcza się na terytorium częstotliwości 100-gigaherców, potencjalnie oferując transfer danych czterokrotnie szybszy niż prędkość nadchodzącego standardu komunikacji bezprzewodowej piątej generacji.

Powstałe w laboratoriach Nanoscale Communication Integrated Circuits Labs na Uniwersytecie Kalifornijskim urządzenie nadawczo-odbiorcze - czyli w praktyce 4,4-milimetrowy układ scalony nowego typu - jest w stanie przetwarzać sygnały cyfrowe znacznie szybciej i bardziej energooszczędnie dzięki unikatowej architekturze analogowo-cyfrowej. Innowacje zespołu wynalazców zostały opisane szczegółowo w artykule opublikowanym niedawno w czasopiśmie IEEE "Journal of Solid-State Circuits".

- Nazywamy nasz układ czymś więcej niż 5G, ponieważ połączone prędkość i szybkość transmisji danych, które możemy dzięki niemu osiągnąć, o dwa rzędy wielkości przewyższają możliwości piątej generacji - wyjaśnia jeden z autorów publikacji, Payam Heydari, dyrektor NCIC Labs oraz profesor inżynierii elektrycznej i informatyki na Uniwersytecie Kalifornijskim.

Heydari zdradził, że oprócz transmisji sygnałów w zakresie 100 gigaherców, unikalny układ urządzenia nadawczo-odbiorczego pozwala mu zużywać znacznie mniej energii niż obecne systemy, przy obniżonych kosztach całkowitych, torując drogę do powszechnego zastosowania na rynku elektroniki użytkowej. Współautor rozwiązania, Huan Wang, doktorant Uniwersytetu Kalifornijskiego w dziedzinie elektrotechniki i informatyki oraz członek NCIC Labs, dodał, że technologia połączona z etapowymi systemami tablicowymi, które wykorzystują wiele anten do sterowania wiązkami, wiedzie do rozmaitych przełomowych zastosowań w bezprzewodowym przesyłaniu danych i komunikacji.

Układ pracuje przede wszystkim w zakresie od 28 do 38 gigaherców. Jest to krokiem w kierunku standardu 6G, który wg wstępnych założeń (bo nie ma jeszcze oficjalnej specyfikacji) ma pracować w częstotliwościach gigahercowych i wyższych - niewykluczone, że również na poziomie teraherców.

Fale milimetrowe i submilimetrowe

Przyszłością sieci mobilnych będą prawdopodobnie pasma fal milimetrowych i terahercowych, o których słyszeliśmy już kilka lat temu w przypadku eksperymentów i rekordowych transmisji specjalistów z Karlsruhe. Niedawno Andrew Paulsen i Ajay Nahata z Uniwersytetu w Utah zaprezentowali filtry własnego projektu, które pozwalają separować różne częstotliwości w zakresach fal terahercowych, i które, jak głoszą często powtarzane obietnice, przyspieszą co najmniej tysiąckrotnie bezprzewodowe transfery.

Fale milimetrowe (EHF - Extremely High Frequency) to zakres fal radiowych o częstotliwości 30-300 GHz i długości 10-1 mm. Stosowane są w łączności satelitarnej, radiolokacji (radar), radioastronomii, a ostatnio także w badaniach nad bronią elektromagnetyczną.

Specjaliści z koncernu Northrop Grumman przeprowadzili niedawno test technologii, w ramach której wysyłano bezprzewodowo dane na odległość do 20 km z prędkością 100 Gb/s. Amerykańska agencja wojskowa DARPA przeprowadziła też bezprzewodowe testy powietrzne takiego systemu. W tym przypadku połączenie odbyło się między eksperymentalnym samolotem Proteus a systemem naziemnym na poziomie 100 Gb/s na dystansie 100 km. Testy przeprowadzono właśnie przy wykorzystaniu fal milimetrowych, na częstotliwości 71-76 oraz 81-86 GHz, przy pełnej przepustowości na każdej z częstotliwości 2×25 Gb/s. Zainstalowany na ziemi system nadawczoodbiorczy wykorzystany w testach został zbudowany przez inny znany koncern zbrojeniowy - Raytheon.

Amerykańskie wojsko chce wykorzystać te wysokoprzepustowe technologie do przesyłu kluczowych danych zwiadowczych do chmur obliczeniowych, bez potrzeby uziemiania maszyn. Od jakiegoś czasu trwają intensywne prace nad budową następcy zwiadowczego U-2. Bezzałogowiec mógłby odbywać loty trwające całe tygodnie lub nawet miesiące i co jakiś czas przesyłać zgromadzone dane bezprzewodowo do centrów operacyjnych.

Według raportu "Millimeter Wave Technology Market" z lipca 2019 r., w roku 2018 światowy rynek technologii fal milimetrowych w telekomunikacji osiągnął wartość miliarda dolarów amerykańskich. Oczekuje się, że do końca 2025 r. przekroczy 5 mld dolarów. W dokumencie jako główne pola zastosowania tego zakresu fal wymienia się poza telekomunikacją takie dziedziny, jak opieka zdrowotna, przemysł, bezpieczeństwo, transport i motoryzacja. Najbardziej znane z tego rodzaju rozwiązań firmy to m.in. Aviat, BridgeWave, DragonWave, ELVA-1, NEC, Siklu i Trex.

Wciąż mało zbadany obszar naukowych i laboratoryjnych eksperymentów, przeprowadzanych z nadzieją na przyszłe praktyczne zastosowania, stanowią zakresy fal o częstotliwościach terahercowych (submilimetrowych). Chodzi o pogranicze widma podczerwieni, tuż przed początkiem zakresu promieniowania mikrofalowego, czyli ostatni obszar elektromagnetycznego spektrum, który właściwie nie został jeszcze poznany i zagospodarowany.

Wiadomo, że terahercowe zakresy fal są niegroźne dla zdrowia, gdyż nie jonizują "prześwietlanych" obiektów. Mogą więc znaleźć zastosowanie w udoskonalonych systemach bezpieczeństwa, np. na lotniskach, a także w medycynie, badaniu stanu budowli, struktury i ewentualnych mikrouszkodzeń materiałów w przemyśle, wykrywaniu metali ze znacznej odległości itd. Przypuszcza się, że zakres ten zostanie wykorzystany w sieci szóstej generacji, ale nie jest to oczywiste, gdyż pojawiają się nowe techniki transmisji, niekoniecznie oparte na zagospodarowaniu kolejnych obszarów spektrum.

Internet kwantowy na razie drogi i zawodny

W lipcu 2017 r. chiński satelita Micius z powodzeniem dostarczył do stacji naziemnych pary splątanych fotonów. Cząstki przebyły trasę o rekordowej długości, 1600 do 2400 km. Wydarzenie uważa się za kamień milowy w rozwoju telekomunikacji kwantowej.

Dla porównania, poprzedni rekord komunikacji kwantowej wynosił ok. 100 km. Na pokładzie Miciusa umieszczono kryształ, generujący pary splątanych fotonów. Satelitę wyposażono w system laserowy oraz rozdzielacz wiązki, który tworzy dwie odrębne polaryzacje światła. Fotony oscylowały w dwóch możliwych kierunkach - jeden do transmisji, drugi do odbioru.

Nad satelitą czuwa Chińska Akademia Nauk, jednak cały projekt ma charakter międzynarodowy. Na naszym kontynencie znajduje się stacja odbiorcza, którą nadzorują Uniwersytet Wiedeński oraz Austriacka Akademia Nauk. Sukces Chińczyków może w przyszłości doprowadzić do powstania azjatycko-europejskiej telekomunikacyjnej sieci kwantowej.

Chińscy naukowcy do stworzenia systemu wykorzystali pary splątanych ze sobą kwantowo fotonów (subatomowych cząstek światła), w których zmiana stanu jednego z nich pociąga automatycznie zmianę stanu drugiego. Można to uznać za środek łączności szybszy niż fale elektromagnetyczne, czyli prędkość światła, jeśli oczywiście znajdzie się dla tej koncepcji praktyczne telekomunikacyjne zastosowanie.

Brak możliwości wykradzenia danych i podsłuchania transmisji uznawane są za największe zalety systemu opracowanego przez chińskich inżynierów. Pary fotonów, które powstają za pomocą specjalnego lasera na pokładzie satelity, podlegają tzw. efektowi obserwatora. Oznacza to, że nie da się zaobserwować stanu kwantowego bez jednoczesnej jego zmiany. Porównując to do klasycznej komunikacji np. w sieciach telefonicznych, chodziłoby o sytuację, w której sama obserwacja transmisji danych w kablu telefonicznym zmienia układ zapisanych danych. Na nic zdadzą się zatem próby rozszyfrowania transmisji, czy też podsłuchiwania danych w niezauważony dla nadawcy sposób. Tylko prawowity odbiorca klucza szyfrującego wysłanego przez satelitę będzie w stanie odczytać dane. To właśnie z tego powodu fizycy tak ochoczo odwołują się w tym wypadku do słów "fenomen" i "magia".

Głównym celem Chińczyków jest zbudowanie pełnej infrastruktury kosmicznej, która pozwoli na prowadzenie całkowicie bezpiecznej łączności na dużych odległościach z pominięciem infrastruktury naziemnej. Jian-Wei Pan z Uniwersytetu Nauki i Technologii Chin, który prowadzi badania nad satelitą, powiedział, że w ciągu najbliższych pięciu lat chciałby wystrzelić kolejne satelity kwantowe. Ma nadzieję, że do 2030 r. komunikacja kwantowa obejmie wiele krajów, a w ciągu trzynastu lat powstanie kwantowy Internet (4).

Wiele technologii potrzebnych do stworzenia tego ostatniego znajduje się jeszcze w powijakach. Fizycy wciąż nie potrafią precyzyjnie kontrolować i manipulować sygnałami kwantowymi. Chiński Micius może wysyłać i odbierać sygnały, ale tak naprawdę nie jest w stanie informacji kwantowej przechowywać. Najlepsze układy pamięci tego typu mogą zachować dane nie dłużej niż przez godzinę. A badacze wciąż nie wiedzą, jaki materiał mógłby posłużyć budowie układów kwantowej pamięci.

Nie są również pewni, w jaki sposób dałoby się efektywnie przesyłać sygnały pomiędzy węzłami przyszłej sieci kwantowej. Pokrycie Ziemi satelitami kwantowymi jest drogie. Transmisje z Miciusa kosztowały 100 mln dolarów. Kwantowa transmisja naziemna przez światłowód również nie jest doskonała, zaś sygnały zamierają po ok. 100 km i nie mogą być wzmacniane jak sygnał elektroniczny. Tak więc badacze opracowują specjalne wzmacniacze kwantowe, transmitujące sygnały na duże odległości.

- To, że coś jest "kwantowe", nie oznacza, że automatycznie staje się lepsze - studzi emocje fizyczka Kai-Mei Fu z Uniwersytetu w Waszyngtonie, w wypowiedzi dla magazynu "Wired". - Ponadto w wielu przypadkach nie ma w ogóle sensu komunikować się kwantowo.

Sygnały kwantowe mają też rozmaite dziwne właściwości, takie jak superpozycja - gdy lokalizacja cząstki jest rozkładem prawdopodobieństwa i trudno jej położenie dokładnie umiejscowić. Większość sposobów komunikacji między ludźmi wydaje się więc o wiele łatwiejsza do wyrażenia poprzez zakodowanie zwykłych, starych zer i jedynek.

Zdaniem specjalistów w przyszłości Internet kwantowy może być wyspecjalizowaną gałęzią zwykłego Internetu. Grupy badawcze na całym świecie opracowują chipy, które pozwoliłyby klasycznemu komputerowi podłączyć się do sieci kwantowej. Zgodnie z tą ideą przez większość czasu użytkownicy tego rodzaju sprzętów sięgaliby po klasyczne obliczenia i podłączali się do sieci kwantowej tylko do określonych zadań. Można np. podłączyć klasyczny komputer osobisty do sieci kwantowej, aby wysłać wiadomość przy użyciu kryptografii kwantowej, niewątpliwie najbardziej dojrzałej technologii kwantowej. Zgodnie z prawami mechaniki kwantowej, gdyby ktoś próbował wówczas przechwycić klucz do odczytania informacji, jednocześnie by go zniszczył.

Internet kwantowy mógłby być również przydatny dla potencjalnych systemów obliczeń w chmurach. Zamiast kupować osobisty komputer kwantowy, umieszczano by swój komputer kwantowy w chmurze, do którego logowano by się przez Internet.

Koreański SK Telecom zakończył niedawno opracowywanie nowej technologii, pozwalającej na przełączanie kluczy z użyciem hasła kwantowego i kierowanie ich do różnych sieci. Gdy rozwiązanie będzie gotowe, klucze kwantowe dadzą się stosować w sieciach komercyjnych. SK Telecom testuje technologię bezpieczeństwa na swojej sieci próbnej o długości 362 km. Rozwój technologii kwantowego przełączania klucza został przeprowadzony we współpracy ze szwajcarską firmą ID Quantique, specjalizującą się w zabezpieczeniach kwantowych. Koreańczycy zastosowali już swój bezpieczny system kwantowy w sieci próbnej Deutsche Telekom w lipcu ubiegłego roku.

Jak szacuje firma Market Research Media, wartość globalnego rynku kryptograficznej komunikacji kwantowej ma wzrosnąć w 2025 r. do 24,75 mld dolarów.

Jest światło - jest łączność

Obok badań technik kwantowych, a czasem razem z nimi, trwają prace nad łącznością za pośrednictwem światła laserowego (5). W latach 2013-2014, podczas księżycowej misji sondy LADEE, wysłanej przez NASA do badania atmosfery i pyłów wokół naszego największego naturalnego satelity, testowano technologię komunikacji opartą na technice laserowej (LLCD). Specjaliści z amerykańskiej agencji kosmicznej sprawdzali, czy tego rodzaju komunikacja w obie strony będzie w ogóle możliwa. Pokładają w niej ogromne nadzieje, licząc na to, że pozwoli na transmisje danych na nieznanym dotychczas poziomie przepustowości, pozwalającej na przekaz wideo o jakości HD, a nawet przesyłanie filmów w technologii 3D.

Moduły komunikacji laserowej zostały dla tej misji zbudowane przez Massachusetts Institute of Technology (MIT). Ich zadaniem było przesyłanie sześciokrotnie większej ilości danych na jednostkę czasu, przy zużyciu ok. jednej czwartej energii mniej niż tradycyjne urządzenia radiowe. Testy przebiegły pomyślnie.

Wykorzystanie technologii laserowych w sieciach bezprzewodowych może sprawić, że będą one tańsze i szybsze. Od 2014 r. trzy największe firmy telekomunikacyjne w USA testują technologię firmy AOptix, która opiera się na wykorzystaniu lasera w zakresie podczerwieni i transmisji radiowych do przesyłu danych w sieciach szkieletowych. Metodę proponowaną przez firmę uznaje się za znacznie wygodniejszą i mniej kosztowną niż stosowanie instalacji światłowodowych. Podstawowym elementem infrastruktury jest tu urządzenie nadawczo-odbiorcze kształtem przypominające lornetkę (6). Sygnał nadawany jest jako wiązka laserowa połączona z impulsami milimetrowych fal radiowych. Zastosowanie dwóch zakresów i typów promieniowania elektromagnetycznego wynika z niedoskonałości każdego z nich, bowiem wiązka laserowa blokowana jest przez zwykłą mgłę, a sygnał radiowy stwarza problemy podczas deszczu. Razem mogą więcej. Szybkość transferu sięga obecnie 2 Gb/s, zasięg nadajnika wynosi zaś do 10 km. Technologia dobrze sprawdza się w terenach słabiej zagospodarowanych, z gorszą infrastrukturą. Obecnie urządzenia AOptix wykorzystywane są np. do budowy sieci w Meksyku i Nigerii.

Z kolei gałąź Alphabetu (Google’a) oznaczona jako X może wkrótce dostarczać Internet za pomocą laserów w indyjskim stanie Andhra Pradesh. Mają one na celu zapewnienie funkcjonowania na duże odległości "kabla światłowodowego, ale bez kabla". Siła sprawczą jest tu technologia komunikacji optycznej w przestrzeni kosmicznej (FSOC). X utworzy dwa tysiące łączy FSOC. Skrzynki FSOC można umieszczać w odległości kilku kilometrów od siebie, na dachach lub wieżach. Sygnał wysyłany jest bezpośrednio między skrzynkami, co ułatwia pokonywanie zwykłych przeszkód, takich jak rzeki, drogi i tory kolejowe.

Lasery oprócz wielu zalet, zapewnienia bezpieczeństwa i dobrej przepustowości, mają też poważny słaby punkt, którego nie znają inne technologie łączności - wiązki laserowe rozpraszają się w chmurach. Z tego powodu badacze z Uniwersytetu Genewskiego w Szwajcarii zaproponowali nową technikę usuwania warstw chmury, wspomagającą komunikację (7). Naukowcy twierdzą, iż korzystając z ultragorących i ultrakrótkich wiązek laserowych, mogą na krótki czas wywiercić w obłokach otwór.

- Wykazaliśmy, że pewien rodzaj lasera, wytwarzający impulsy o czasie trwania rzędu miliardowych części sekundy, wywołuje falę uderzeniową, która zdmuchuje ze swojej drogi krople wody - powiedział serwisowi "Digital Trends" Jérôme Kasparian, fizyk pracujący nad projektem.

Sztuczna inteligencja, blockchain i triony

Do świata telekomunikacji wchodzą również sztuczna inteligencja i łańcuchy blokowe. Zastosowanie np. techniki uczenia maszynowego pozwala operatorom przewidywać zakłócenia usług, przerwy w funkcjonowaniu komórek oraz wykrywać na bieżąco rozmaite anomalie. Hiszpańska Telefónica podpisała pod koniec 2018 r. umowę partnerską z IBM w celu wykorzystania technologii blockchain do zarządzania międzynarodowym ruchem połączeń. Dzięki skorzystaniu z platformy IBM Blockchain, Telefónica ma nadzieję, że poprawi identyfikację danych w połączeniach międzynarodowych.

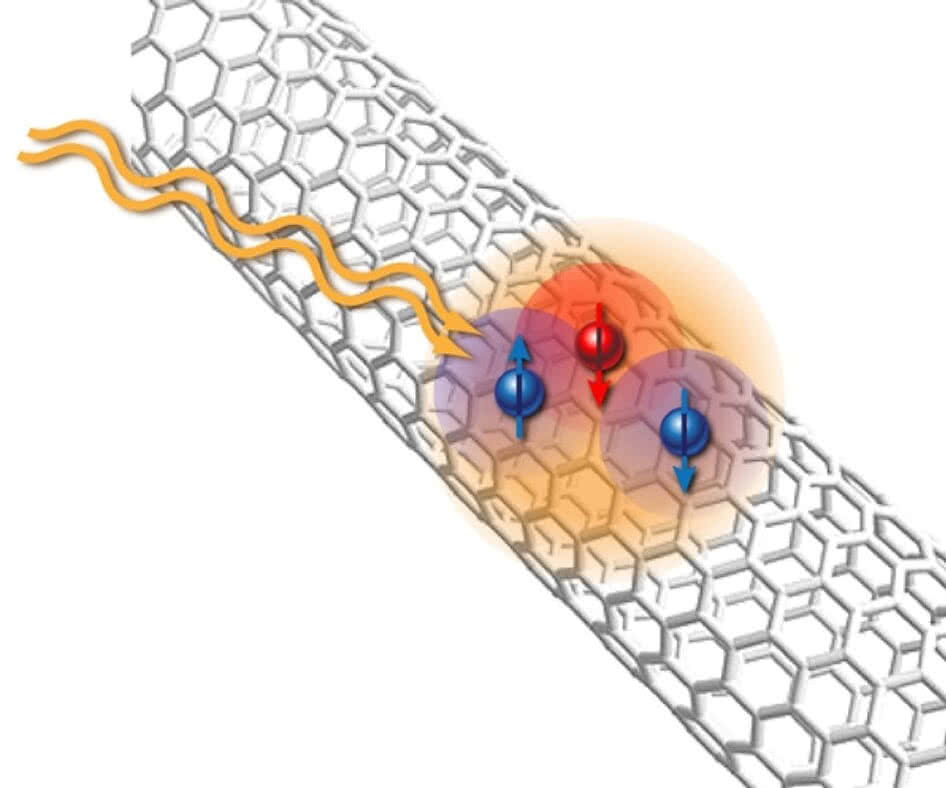

Okazuje się też, że wiele wnieść mogą najnowsze odkrycia w dziedzinie fizyki. Większość elektroniki wykorzystuje dziś pojedyncze elektrony do przewodzenia energii elektrycznej i przesyłania informacji. Według uczonych z Uniwersytetu Kalifornijskiego w Riverside zamiast nich można jednak wykorzystać triony (8), czyli zespoły składające się z trzech naładowanych kwazicząstek. Ujemny trion tworzą dwa elektrony oraz jedna dziura, a dodatni trion - dwie dziury i jeden elektron. Triony można podzielić także na jasne i ciemne, o różnych konfiguracjach spinowych. Naukowcy zmierzyli czas życia ciemnych trionów i odkryli, że trwają one ponad sto razy dłużej niż bardziej powszechne jasne triony. Dłuższa żywotność umożliwia przesyłanie informacji za ich pomocą na znacznie większą odległość. Ponadto transmisja trionowa pozwala na przesyłanie większej ilości informacji niż z zastosowaniem pojedynczych elektronów. Wyniki badań trionów w próbkach dwuselenku wolframu w postaci arkuszy podobnych do grafenowych zostały opublikowane w czasopiśmie "Physical Review Letters".

Eric Schmidt, dyrektor generalny firmy Google w latach 2001-2011, powiedział podczas Światowego Forum Ekonomicznego w Davos w 2015 r., że wkrótce Internet… "zniknie". Stanie się po prostu tak wszechobecnym i wszechogarniającym elementem codziennego życia i rzeczywistości, że przestanie być zauważany i zostanie częścią "tła", na które nie zwracamy uwagi.

- Dookoła nas będzie mnóstwo czujników, urządzeń, z których istnienia przestaniemy zdawać sobie sprawę - stwierdził Schmidt.

Internet ludzi, Internet Rzeczy, wszechogarniająca wirtualna cyberprzestrzeń - jakkolwiek przyszłą sieć nazwiemy, będzie musiała opierać się na infrastrukturze technicznej i to o parametrach oraz możliwościach znacznie przekraczających obecne pasma przenoszenia. Na początku 2019 r. było na świecie 5,11 mld użytkowników telefonów komórkowych, co oznaczało wzrost o 100 mln (2%) w porównaniu z rokiem poprzednim. Liczba użytkowników Internetu wyniosła 4,39 mld, co stanowi wzrost o 366 mln (9%) w porównaniu ze styczniem 2018 r. Dane w raporcie "Global Digital 2019" przygotowanym na początku tego roku przez firmy We Are Social oraz Hootsuite pokazują, że każdego dnia przybywa średnio ponad milion nowych internautów. W grupie krajów biedniejszych, mimo skromniejszych statystyk, liczba użytkowników Internetu od 2009 r. podwoiła się. Obecnie internauci z krajów rozwijających się stanowią dwie trzecie globalnej liczby użytkowników sieci.

Marshall McLuhan (9), mówiąc w 1962 r. o "globalnej wiosce", nie miał dokładnie na myśli tego, czym stał się i do czego zmierza świat na przełomie drugiej i trzeciej dekady XXI wieku. Nic dziwnego - nie istniał przecież wówczas Internet, komunikacja satelitarna była wstępnie testowanym pomysłem, lasery dopiero co wynaleziono, a pojęcia "kwantowa łączność" zapewne by nie pojął. Gdyby jednak żył teraz i przyjrzał się temu, co dzieje się we współczesnej telekomunikacji, zapewne nie miałby nic przeciw używaniu swojej słynnej metafory odnośnie jej stanu i perspektyw.

Mirosław Usidus