Stan relacji człowiek-maszyna: to skomplikowane

Ekrany dotykowe były jednymi z pierwszych naturalnych interfejsów. Jako wynalazek i koncepcja znano je od dekad, ale nie stały się odpowiednio tanie i popularne. Aż do 2007 r., kiedy Apple pokazało ekran dotykowy iPhone’a. Teraz, gdy ludzie przyzwyczajają się coraz bardziej do idei, że używanie myszy i klawiatury nie jest jedynym sposobem interakcji komputerem, naukowcy doskonalą techniki głosowe, śledzenie gałek ocznych, a nawet komunikację bezpośrednio z mózgiem.

Celem - "zniknięcie sprzętu"

Wkrótce po pojawieniu się fali ekranów dotykowych i technologii multitouch, Microsoft zaproponował Kinecta, co wzbudziło oczekiwania szybkiego upowszechnienia się interfejsów gestykulacyjnych, podobnych do sprzętu, który można było zobaczyć w filmie "Raport mniejszości" (1). Jednak po pierwszej fali entuzjazmu gestykulacyjny interfejs zaczął wzbudzać wątpliwości. Używanie ruchów rąk do sterowania komputerami na dłuższą metę okazuje się męczące. Jeśli rozwiązanie takie zastosować do innych urządzeń, np. do telewizorów, co proponowała m.in. Toshiba, to mogą pojawić się niezamierzone i zabawne konsekwencje.

Wyobraźmy sobie zmianę kanału poprzez machanie rękami. Wykonując różne gesty, choćby podczas meczu, możemy niechcący wydawać systemowi niechciane polecenia. Niezbyt to praktyczne. Robert Wang, doktorant w MIT, który opracował system komputerowy sterowany gestami, już w 2010 r. mówił CNN, że trudno jest również używać ruchów dłoni do manipulowania obiektami cyfrowymi, ponieważ nie można ich poczuć.

W społeczności technologicznej nie ma zgody co do tego, czy te nowe metody interakcji między człowiekiem a komputerem całkowicie zabiją mysz, klawiaturę i monitor komputera, czy też będą tylko oferować alternatywne rozwiązania. Ogólnie rzecz biorąc, naukowcy uważają, że w nowych rodzajach interfejsu mysz okazać się może pierwszym sprzętem do wymiany. Klawiatura, jakkolwiek trudno ją określić jako naturalny sposób interakcji, prawdopodobnie będzie bronić się dłużej, ponieważ wiąże się z efektywnym sposobem pisania, a ludzie nie chcą uczyć się zupełnie nowych systemów.

Zdroworozsądkowe podejście nie widzi w tym wszystkim wyniszczającej się wzajemnie konkurencji, ponieważ każdy z rodzajów sprzętu jest dobry do czegoś i nie nadaje się do czego innego. Użycie Kinecta w kabinie samolotu byłoby całkowicie absurdalne. Pisanie na klawiaturze staje się niebezpieczne, gdy np. prowadzimy samochód. Z kolei mówienie o sprawach prywatnych w miejscach publicznych - lub nawet wprowadzanie wówczas prostych poleceń głosowych - wygląda mocno problematycznie i może nie zyskać zbyt wielu zwolenników.

Ogólny kierunek zmian w interfejsie maszynowym daje się uchwycić dość wyraźnie - ma to być ewolucja w kierunku naturalnych sposobów interakcji i komunikacji. Celem dalszym jest to, co Pranav Mistry z Laboratorium Mediów MIT określił w rozmowie z CNN jako "zniknięcie" sprzętu komputerowego, umożliwiające ludziom bezpośredni kontakt z informacjami.

- Sprzęt staje się niewidzialny - mówi. - Świat cyfrowy całkowicie zlewa się ze światem rzeczywistym.

Co to jest skeumorfizm?

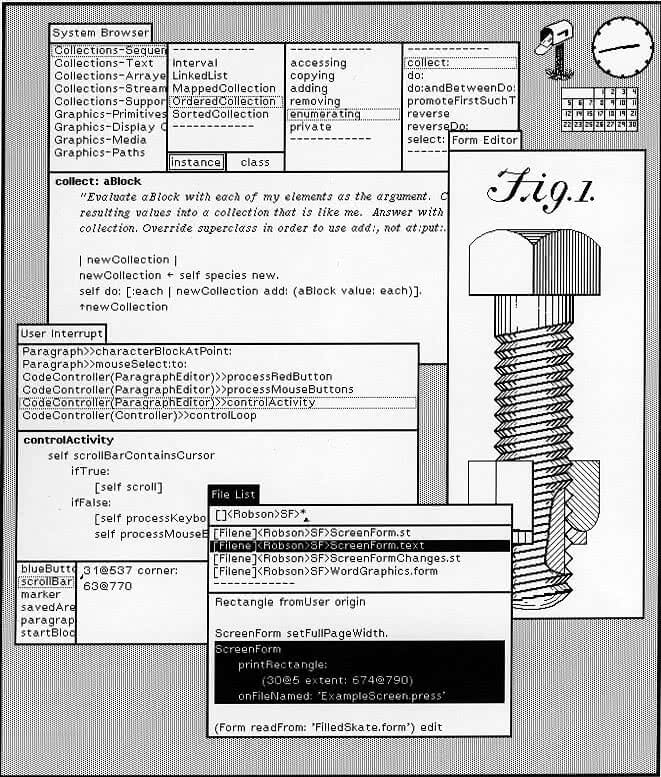

Interfejs jest ściśle związany z designem. Ten ewoluuje trochę na zasadzie mód, ale jednak ogólnie z biegiem czasu zmierza do coraz większej funkcjonalności i przyjaznego charakteru. Kiedy w 1981 r. wprowadzono pierwszy komputer osobisty IBM, był on wyposażony w system operacyjny MS-DOS firmy Microsoft, który wymagał wprowadzania poleceń - komend dla oprogramowania. Było to trudne i nudne, a użytkownik musiał zapamiętywać wiele różnych komend. Trzy lata później firma Apple zademonstrowała komputer Macintosh, który popularyzował wykorzystanie na komputerach osobistych graficznych interfejsów użytkownika (GUI).

Był zresztą oparty na tym, co Steve Jobs widział w Xeroxie w latach 70. (2). Niektórzy uznali to za osiągnięcie równe lądowaniu człowieka na Księżycu. Nie ulega jednak wątpliwości, że GUI Apple’a, a potem interfejs systemu Windows, zapoczątkowały zmianę paradygmatu w interakcjach z komputerami. Użytkownicy zaczęli korzystać z tych maszyn nie tylko dlatego, że musieli, ale dlatego, że chcieli.

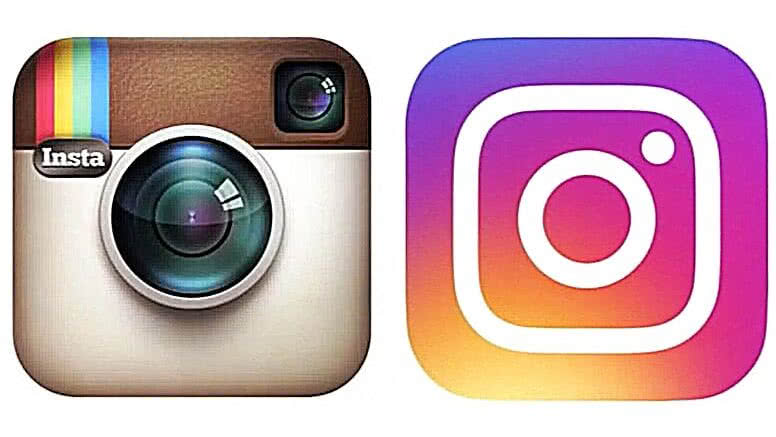

Dążenie do uzyskania lepiej wyglądających, bardziej profesjonalnych i przyciągających wzrok wizualizacji stało się kolejnym wielkim dążeniem producentów i programistów. GUI zaczęły zawierać coraz więcej odniesień i podobieństw do rzeczywistych obiektów i tekstur. Ten typ konstrukcji znany był jako skeumorfizm i jeszcze dekadę temu niepodzielnie panował również w ekranach dotykowych. Wizualne aktualizacje systemu Mac OS X, systemu Windows XP, a nawet premiera pierwszego iPhone'a, zapowiadały fazę tworzenia interfejsów, w której elementy takie jak ikony projektowano w celu uzyskania jak najbardziej realistycznego wyglądu. Na każdym interfejsie użytkownika, od komputerów PC po telefony, pojawiły się tekstury skóry, powierzchnie szklane i błyszczące, aluminiowe ramy. Pojawiły się odbicia, gradienty i cienie.

Wydawało się, że im lepsze są wyświetlacze i moc obliczeniowa, tym bardziej skłaniamy się ku naśladowaniu w naszych cyfrowych sferach rzeczywistości. Ludzie byli pod wrażeniem tego, jak realistyczne może się wydawać coś na cyfrowym ekranie. Wydawało się to takie… fajne. W interfejsie aplikacji iBooks dawało się przerzucać strony w taki sam sposób, jak w prawdziwych książkach.

Po kilku latach uznano jednak, że takie interfejsy na dłuższą metę są obciążające i tworzą zbyt złożone środowisko. Jeśli wszystkie byty cyfrowe naśladowały rzeczywistość, nie pozostawało zbyt wiele miejsca na stymulacje wizualne dla użytkownika. W dodatku świat ten zaczął wydawać się zagracony. Powstał pomysł na flat design ("płaskie projektowanie"). Proste, czyste przyciski, brak tekstur i powierzchni odbijających światło, brak szkła, skóry, wszystko uproszczone (3). Skeumorfizm zaczął stawać się przestarzałym sposobem projektowania.

Interfejsy dotykowe już były powszechne od kilku lat, a komputery istniały od kilku dekad, co oznaczało, że użytkownicy przyzwyczaili się do świata cyfrowego i aby go rozumieć, nie potrzebowali odniesień do prawdziwego życia. Płaski, minimalistyczny design szybko zdobywał popularność. Projekty na nim oparte oznaczały również, że ładowanie aplikacji zajmowało mniej czasu niż dotąd, ponieważ interfejsy stały się mniej wymagające pod względem graficznym. Pomogły stworzyć płynniejsze doświadczenie użytkownika.

Projektowanie płaskie osiągnęło sukces, więc projektanci zaczęli już eksperymentować z tym, w jaki sposób wizualizacje mogą stać się bardziej atrakcyjne, nie ograniczając się jedynie do minimalizmu. Jednym z przykładów jest system Fluent Design firmy Microsoft. Łączy w sobie to, co było pomocne w projektowaniu skeuomorficznym z elementami minimalizmu.

Te nowe fale w projektowaniu interfejsów wynikają trochę z mody, a trochę z rozwoju nowych technologii. Interfejsy VR wchodzą w przestrzeń trójwymiarową, co wpływa na sposób ich projektowania. Pojawia się wykorzystanie fotografii jako uzupełnienia wizualizacji i grafiki w aplikacjach, nadające projektom ludzki wymiar. Skeumorfizm może tu ponownie odegrać bardzo ważną rolę, pomagając użytkownikom przejść do nowych wirtualnych środowisk cyfrowych i przystosować się do nich.

Naturalny jak głos

Jeśli mówimy o naturalnym i prostym interfejsie, to nie można pominąć VUI, czyli interfejsu głosowego (voice user interface). Jest rozwijany od dekad. W 1952 r. Laboratoria Bella stworzyły system Audrey (pierwszy sterowany głosem UI), wyprzedzając nawet komputer sterowany głosem ze "Star Treka". Jednak dopiero niedawno, w dobie wszechobecnej chmury obliczeniowej, konsumenci uzyskali dostęp do wystarczającej mocy obliczeniowej, aby ich głosy mogły być słyszane i interpretowane w czasie rzeczywistym. Dopiero więc w dzisiejszych czasach jesteśmy świadkami narodzin głosowego interfejsu użytkownika z prawdziwego zdarzenia (4).

Choć głos stanowi najstarszy ludzki interfejs, który w dodatku wydaje się bardzo naturalny oraz prosty, przełożenie go na świat interakcji z maszynami okazuje się skomplikowanym zadaniem. Ludzie rozwijają sztukę konwersacji od tysięcy lat. To umiejętność, z której korzystają instynktownie, każdego dnia, przez większość swojego życia. Mowa jest jedną z pierwszych umiejętności, które zdobywamy w dzieciństwie - i jedną z ostatnich, które tracimy w starości, długo po tym, jak nasz wzrok i umiejętności ruchowe zaczną zanikać. Co więc stoi na przeszkodzie, aby przełożyć nasze naturalne skłonności komunikacyjne na świat maszyn?

Choćby prozodia, czyli brzmieniowe właściwości mowy. Składają się na nią intonacja, ton, akcenty i rytm, nadające naszym głosom niepowtarzalny charakter. "Sekretem ludzkiego głosu są melodie", pisze Emma Rodero, profesor na Wydziale Komunikacji Uniwersytetu Pompeu Fabra w Barcelonie. Rodero szeroko badała głosy nieludzkie. Jej zdaniem, poza słowami, których używamy, w mowie dzieje się tak wiele, że trudno jest nauczyć komputer wszystkich niuansów.

Wiele trudności udało się jednak przezwyciężyć, a efektem jest rosnąca liczba urządzeń sterowanych głosem, takich jak Apple HomePod, Google Home i Amazon Echo. Interfejsy głosowe pomagają poprawić wszelkiego rodzaju doświadczenia użytkowników, a niektórzy sądzą, że do 2020 r. głos będzie zasilał 50% wszystkich wyszukiwań.

Wszystkie pięć najważniejszych globalnie firm technologicznych - Microsoft, Google, Amazon, Apple i Facebook - stworzyło głosowych asystentów (lub jest w trakcie).

Siri, asystent AI dla urządzeń Apple iOS i HomePod, pomaga ponad 40 milionom użytkowników miesięcznie, a wg ComScore, co dziesiąty dom w USA posiada już dziś inteligentny głośnik.

Alexa, najbardziej chyba znany przykład tej technologii, jest asystentem AI dla urządzeń Amazon obsługujących głos, takich jak inteligentny głośnik Echo i tablet Kindle Fire. Najpopularniejsze aplikacje (zwane skills - umiejętnościami) związane z Alexą koncentrują się na rozrywce, tłumaczeniu i wiadomościach, chociaż użytkownicy mogą również wykonywać takie działania, jak żądanie przejażdżki Uberem, odtwarzanie muzyki za pośrednictwem Spotify, a nawet zamówienie pizzy za pośrednictwem sieci Domino.

Pojawiają się też poważniejsze polecenia. Bank Capital One wprowadził w 2016 r. funkcjonalność, dzięki której klienci mogą głosem sprawdzić swoje saldo na koncie i terminy płatności, a nawet uregulować rachunek za kartę kredytową. PayPal poszedł potem o krok dalej, pozwalając użytkownikom na dokonywanie płatności przez Siri na iOS lub Apple HomePod.

Firma ComScore stwierdza w swoich badaniach, że ludzie najczęściej używają wyszukiwania głosowego podczas prowadzenia pojazdu. Aktualizacje informacji na temat ruchu drogowego w czasie rzeczywistym stają się dużo łatwiejsze podczas jazdy dzięki Google Assistant i Android Auto, chociaż w każdej sytuacji, w której użytkownik nie jest w stanie dotknąć ekranu (np. podczas gotowania, ćwiczeń lub wykonywania wielu zadań w pracy), możliwość interakcji głosowych staje się cenna...

Jednak okulary

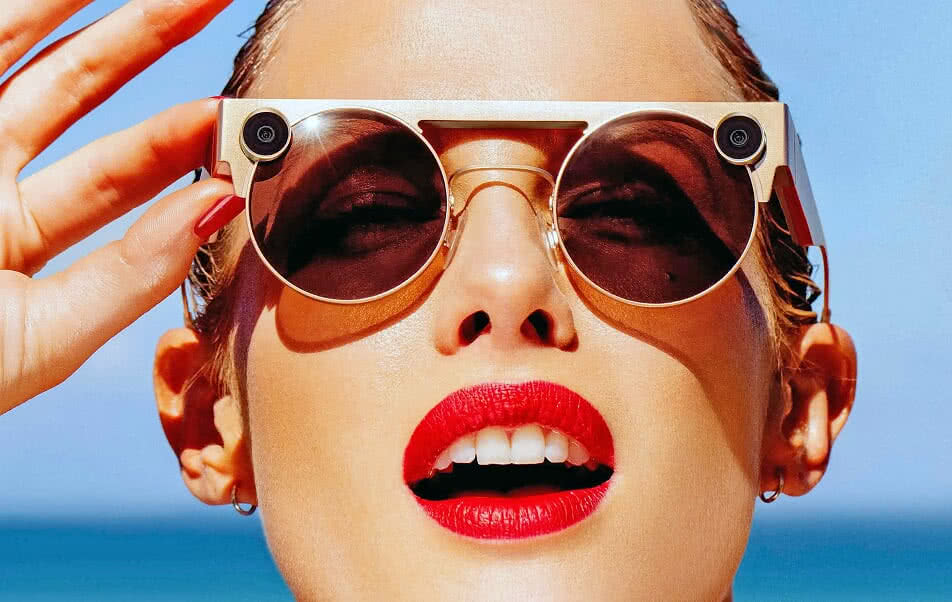

Do różnych rodzajów interfejsu potrzeba jeszcze funkcjonalnych, wygodnych i oczywiście przenośnych urządzeń. Wielu myśli, że będzie to rodzaj okularów. Takich jak produkt Snapchata o nazwie Snap 3 (5). To okulary rzeczywistości rozszerzonej, które pewnego dnia mogą zastąpić smartfon jako nasze urządzenie komputerowe. Snap 3 nie różnią się wcale tak bardzo od swoich poprzedników. Są modnie zaprojektowane i wyposażone w kilka kamer HD, oferują możliwość nagrywania filmów 3D w trybie głośnomówiącym, a następnie przesyłania ich do aplikacji Snapchat - i to już prawie wszystko. Nie można oglądać w nich filmu ani niczego innego. Nie mają wbudowanych wyświetlaczy, jak w opisywanym w tym wydaniu projekcie chińskiej firmy TCL.

Mimo to uważa się, że ten model okularów stanowi zapowiedź urządzenia, które wielu z nas będzie za dziesięć lat nosić jako podstawowy element interfejsu komputerowego. Przyszłe okulary do interfejsu AR/MR nie powinny rzucać się w oczy. Mają być lekkie i wygodne - firmy, które je wyprodukują, będą chciały, aby użytkownicy nosili je przez cały dzień.

Mogą wyglądać jak zwykłe plastikowe ozdoby. Ponieważ są modnym dodatkiem, będą dostępne w wielu stylach i kombinacjach kolorystycznych. Producenci zaopatrzą je z przodu w co najmniej dwie kamery. Mogą również posiadać dodatkowy aparat głębi ostrości, coś w rodzaju kamery TrueDepth na nowszych iPhone'ach. Kamera ta zapewni dokładniejsze odwzorowanie głębokości w większej liczbie warstw realnego świata.

Za pośrednictwem wbudowanego układu mikrofonów okulary mogą oferować wirtualnego asystenta Alexa lub Siri. Użytkownik może być również w stanie poruszać się po obserwowanych treściach poprzez wykonywanie gestów rękami przed przednimi kamerami urządzenia. Kamery skierowane na oczy użytkownika będą w stanie śledzić, co ten przegląda i wybiera. Przykładowo, tekst będzie automatycznie przewijał się, gdy oczy użytkownika znajdą się na dole. Mrugnięcie oczami może stanowić "kliknięcie" w przycisk lub link. To nie fantastyka. Sterowanie gałkami ocznymi jest już dostępne we wspomnianych okularach/goglach TCL. Wszystkie inne rozwiązania też już istnieją.

Wyobraźmy sobie, że zbliża się do nas znajoma… W wyświetlaczu naszych okularów pojawia się jej imię i część historii naszych kontaktów. Z kolei podczas jazdy samochodem możemy zobaczyć rozmaite informacje pojawiające się na trasie. W sklepie zaatakują nas powiadomienia o promocjach i wyprzedażach (6).

Wycieczka po muzeum może być uzupełniona narracją dźwiękową i grafiką na temat oglądanych eksponatów. Dzięki tego rodzaju sprzętowi zagramy w gry podobne do "Pokémon GO", w których wejdziemy w interakcję z postaciami i przedmiotami umieszczonymi lub ukrytymi w rzeczywistych krajobrazach albo przestrzeniach wewnętrznych.

W dłuższej perspektywie, takie projekty jak Google Glass i Snap Spectacles mogą być postrzegane jako wczesne prototypy, ostrożnie przyjmowane przez użytkowników. Te wczesne produkty przecierają ścieżki dla kogoś, kto efektywnie połączy wszystkie elementy - w tym dobrze zaprojektowany i łatwy w użyciu produkt, który konsumenci w końcu docenią.

Podłączysz mózg, to może przetrwasz osobliwość

Według niektórych ostateczną rubieżą rozwoju interfejsów maszynowych będą rozwiązania łączące mózg z komputerem. Pracuje się nad nimi od lat.

Rok temu zaprezentowano kolejny krok w kierunku połączenia człowieka i maszyny. Trzy osoby, sparaliżowane od szyi w dół, były w stanie używać tabletów w żaden sposób nieprzystosowanych do ich potrzeb, korzystając z systemu BrainGate2 (7). Pozwolił on biorącym udział w eksperymencie na wysyłanie SMS-ów, przeglądanie stron i słuchanie muzyki. System ten składa się z interfejsu mózg-maszyna NeuroPort, oprogramowania tłumaczącego sygnały elektryczne z neuronów oraz interfejsu łączącego się z tabletem przez Bluetooth.

Skorzystanie z monitorowania aktywności mózgu wymagało, by uczestnikom eksperymentu wszczepiono dwa malutkie implanty podtwardówkowe, składające się z matryc złożonych z 96 elektrod każda. Elektrody umieszczono w takich miejscach kory ruchowej, aby móc rejestrować aktywność związaną z zamiarem poruszania kończynami. Osoby sparaliżowane musiały wyobrazić sobie, że przesuwają kursor.

W systemie BrainGate2 sygnały elektryczne z kory ruchowej są przekazywane do dekodera i w czasie rzeczywistym tłumaczone na ruchy kursora na ekranie. Parametry ruchu, takie jak prędkość i kierunek, trafiają następnie do prawdziwego kursora. Od strony oprogramowania tabletu wygląda to tak, jakby podłączono do niego bezprzewodową myszkę. Trzeba jednak dodać, że niektórych rzeczy jeszcze BrainGate2 brakuje. W opisywanym eksperymencie używano tablety przystosowane do obsługi wieloma palcami, czego interfejs wciąż nie potrafi symulować. Nie można było więc m.in. korzystać z gestów powiększania i zmniejszania, czy też przeciągania treści. Zabrakło np. możliwości przewijania treści w przeglądarce.

W filmie "Upgrade" (2018) Grey Trace, główny bohater, zostaje trafiony w szyję, a jego żona ginie od kuli. Trace budzi się, by odkryć, że nie tylko stracił żonę, ale czeka go przyszłość na wózku inwalidzkim. Wszczepiony zostaje mu jednak chip komputerowy Stem, zaprojektowany przez słynnego wynalazcę Erona Keena, co pozwoli mu znów chodzić. Stem jest tak naprawdę sztuczną inteligencją, potrafiącą "rozmawiać" z bohaterem w sposób, którego nikt inny nie usłyszy. Może ona nawet przejąć kontrolę nad jego ciałem… Co było dalej, można się domyślać.

W 2012 r., w ramach programu badawczego finansowanego przez amerykańską agencję Defense Advanced Research Projects Agency (DARPA), 52-letnia Jan Scheuermann, od dziesięciu lat sparaliżowana, niemogąca poruszać swoim ciałem od szyi w dół, stała się pierwszym człowiekiem wykorzystującym interfejs mózg-maszyna do przezwyciężenia własnej niepełnosprawności. Dzięki naukowcom z Uniwersytetu w Pittsburghu znów mogła poruszać ramieniem. Nie swoim jednak, lecz mechanicznym.

Początkowo lekarze przeprowadzili czterogodzinną operację, w czasie której do mózgu Jan wszczepiono setki maleńkich elektrod - umieszczono je w tym obszarze, który odpowiada za kontrolę prawej ręki. Następnie część czaszki zastąpiono sztucznym tworzywem - tak, by można było poprowadzić kable do specjalnych wtyków w głowie pacjentki.

DARPA finansuje badania nad tego rodzaju interfejsami od lat 70., a teraz chciałaby zrealizować wizję podobną do filmu "Upgrade", ale bez ingerencji w ciało. Celem programu Nonsurgical Neurotechnology (N3) jest usunięcie potrzeby stosowania elektrod, kabli i chirurgii mózgu. Dr Al Emondi, który zarządza programem, powierzył naukowcom z sześciu wiodących amerykańskich instytutów badawczych zadanie opracowania sprzętu zdolnego do odczytywania myśli z zewnątrz głowy - na tyle małego, by dało się go umieścić w czapce lub zagłówku. Według Emondiego, urządzenie nie tylko musi być zdolne do przekazywania informacji do mózgu w formie, którą mózg zrozumie, ale też zapewniać komunikację w drugą stronę (8).

Emondi dał naukowcom tylko cztery lata na przeniesienie nowej technologii z laboratorium do punktu, w którym będzie się ją testować na ludziach. Jest to chyba w tej chwili najambitniejszy projekt interfejsu mózgowego. Nawet plan Elona Muska dotyczący interfejsu mózg-komputer, Neuralink, nadal wymaga ryzykownej operacji osadzenia chipa w mózgu, choć zamiast kabli ma już obowiązywać forma komunikacji bezprzewodowej.

- Jeśli uda nam się zbudować nieinwazyjny interfejs neuronowy, otworzymy drzwi do zupełnie nowego, jeszcze nieistniejącego ekosystemu - mówi Emondi serwisowi BBC.

Za tymi drzwiami rozciągają się niezwykle śmiałe perspektywy.

- Jedynym sposobem, jaki ludzie rozwinęli, aby wchodzić w interakcję ze światem, jest wykorzystanie swoich ciał, mięśni i zmysłów. Jesteśmy w tym całkiem dobrzy - dodaje w materiale BBC Michael Wolmetz, kierownik badań inteligencji ludzkiej i maszynowej w Laboratorium Fizyki Stosowanej Johnsa Hopkinsa w Laurel, w stanie Maryland. - Stanowi to jednak również fundamentalne ograniczenie naszej zdolności do kontaktowania się ze światem. Jedyną metodą wyjścia poza to ewolucyjne ograniczenie jest bezpośrednie połączenie maszyn z mózgiem.

Aby osiągnąć cel interfejsu, który działa bez potrzeby operacji mózgu, zespoły Emondiego pracują nad kombinacją technik, takich jak ultradźwięki, działanie pola magnetycznego i elektrycznego oraz światła. Problemem jest odróżnienie użytecznej aktywności neuronowej od kakofonii innych hałasów emitowanych przez mózg.

Trzeba też umieć odebrać właściwe sygnały przez czaszkę i skórę głowy. Kolejnym wyzwaniem jest przekazanie informacji z urządzenia do komputera i dostarczenie potrzebnych odpowiedzi w ułamku sekundy. Interfejsy muszą mieć w dodatku "wysoką rozdzielczość" i wystarczająco dużo "szerokości pasma" lub kanałów komunikacji, aby dzięki nim móc np. latać prawdziwym dronem, a nie mozolnie przesuwać ramię robota.

Nikt, kto jest sprawny, nie zdecydował się jeszcze na wszczepienie interfejsu w celu zagrania w grę wideo, taką jak np. "Fortnite". I nikt nie wie, jak wpłynęłoby to na jego zachowanie, ani czy coś zmieniłoby się, gdyby chip znajdował się nie w czaszce lecz np. w czapce. Fakt, że nie jest to technologia inwazyjna, nie oznacza, że nie wyrządza szkody układowi nerwowemu. Istnieją choćby rozmaite zdrowotne granice, które trzeba respektować - np. stosując ultradźwięki, należy ograniczać poziom ciśnienia, a korzystając z pola elektrycznego, nie wolno przekraczać pewnych pułapów mocy.

Zdaniem niektórych, rozwój potężnych interfejsów mózg-komputer mógłby nawet pomóc ludziom przetrwać hipotetyczną technologiczną osobliwość, czyli stan, w którym sztuczna inteligencja zaczyna przewyższać ludzką i jest w stanie się zreplikować. Moglibyśmy wówczas wykorzystać tego rodzaju interfejsy, aby modernizować samych siebie i konkurować z nowymi rywalami - albo nawet połączyć się z AI, co Elon Musk wyraźnie zaznaczył w materiałach promujących rozwiązanie Neuralink.

Mirosław Usidus