Komputerowy przełom – czy możemy na niego liczyć?

Zgodnie z prognozami sprzed kilku lat, przy obecnym tempie rozwoju pierwsze superkomputery o wydajności powyżej 1 eksaflopsa (1018, trylion FLOPS-ów, operacji zmiennoprzecinkowych na sekundę) miały zostać zbudowane ok. 2019 r. Zdaniem Intel Corporation, to tempo rozwoju miało zostać zachowane przynajmniej do roku 2029, kiedy powstać mają komputery o wydajności zettaflops (1021, tryliard FLOPS-ów).

Każdy kolejny krok naprzód w dziedzinie superkomputerów trwa mniej więcej dziesięć lat, ale ten ostatni, w kierunku przetwarzania na zasadzie eksaflopsa, był szczególnie trudny - mamy bowiem do czynienia z ogólnym spowolnieniem tempa rozwoju technologii krzemowej, o czym pisaliśmy w „MT" wiele razy. W dodatku tym razem nie mówimy tylko o większej wydajności obliczeniowej. Epoka eksaskalowa zapowiada radykalne przesunięcie w kierunku przetwarzania danych, które będzie miało znaczący wpływ na krajobraz gospodarczy.

Międzynarodowa Korporacja Danych (IDC) przewiduje, że do 2025 r. ilość globalnych danych wzrośnie o 61%, do 175 zetabajtów. Każdy - od małych firm prywatnych po największe laboratoria rządowe - będzie szukał sposobów na przekształcenie tego oceanu danych w praktyczne wnioski, przy użyciu kombinacji modelowania, symulacji, analizy danych, Internetu Rzeczy (IoT) i sztucznej inteligencji (AI). Epoka eksaskalowa wymaga zatem transformacji infrastruktury cyfrowej, tak aby mogła ona zarządzać ogromną ilością danych i wspierać hybrydowe przepływy pracy łączące symulację, analitykę i AI.

Moc obliczeniowa ma również kluczowe znaczenie dla całych państw i narodowego bezpieczeństwa. Trwa przecież komputerowy wyścig zbrojeń. Trzeba bronić się przed zagrożeniami cybernetycznymi i wzmacniać tradycyjne systemy obronne. Drugim polem jest nauka, w której superkomputery stały się uniwersalnymi instrumentami oraz narzędziami niezbędnymi do odkryć w wielu dyscyplinach. Trzecim nurtem jest walka o konkurencyjność gospodarczą. Superkomputery są wykorzystywane do projektowania lepszych materiałów i produktów, optymalizacji logistyki biznesowej, gromadzenia i przetwarzania ogromnych ilości danych z transakcji biznesowych, mediów społecznościowych, maszyn przemysłowych i Internetu Rzeczy oraz pozyskiwania wglądu w dane w celu poprawy konkurencyjności przedsiębiorstw.

Światłem i dźwiękiem

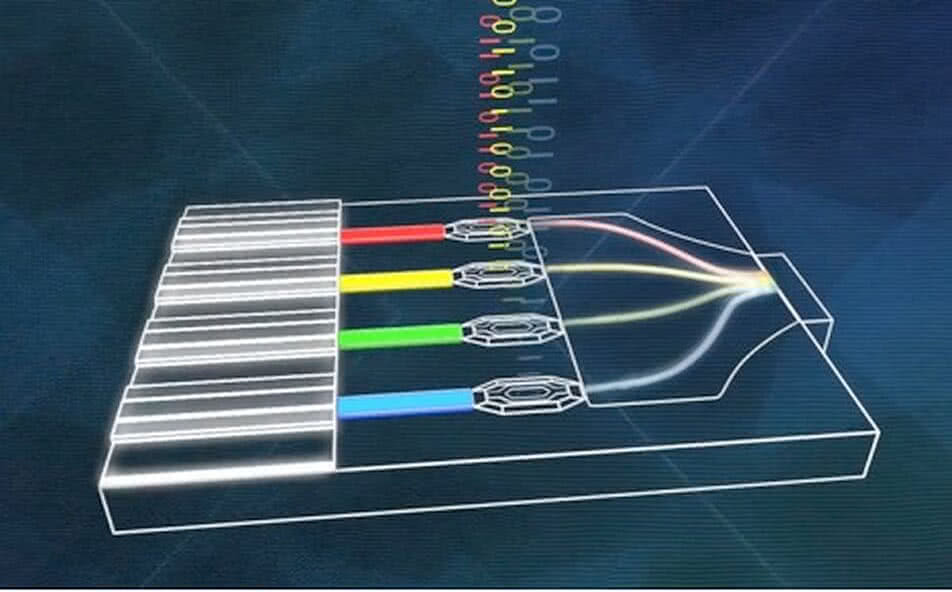

Kryzys krzemu trwa już od ponad dekady. Jednym ze sposobów na jego przezwyciężenie i przywrócenie wigoru podobnego do prawa Moore’a z najlepszych czasów jest fotonika (2). Obiecuje ona przede wszystkim pokonać problemy cieplne i wydajnościowe, z którymi zderzyły się krzemowe układy.

Naukowcy z działu badawczego koncernu IBM, światowego lidera w dziedzinie fotoniki, już kilka lat temu skonstruowali kluczowy składnik przyszłych układów fotonicznych: niskonapięciowy fotodetektor półprzewodnikowy - wyjątkowo szybką i małą fotodiodę lawinową (APD), która pracuje przy niskim napięciu (na poziomie 1,5 V) i może być wbudowywana do modułów wytwarzanych w standardowej technologii CMOS. Szybkość przełączania elementu przekraczała 30 GHz, a przy większym napięciu była jeszcze wyższa.

Inne firmy też się starają. Intel już w 2010 r. zademonstrował prototyp pierwszego w historii bazującego na krzemie łącza optycznego ze zintegrowanym laserem. Już w tej chwili jest ono w stanie przesyłać dane na duże odległości z prędkością 50 gigabitów na sekundę.

Tradycyjnie do przesyłania danych w urządzeniach elektronicznych wykorzystywana jest miedź. Sygnał elektryczny ulega w niej degradacji, dlatego też podzespoły muszą być umieszczone blisko siebie. Tylko dzięki temu jesteśmy w stanie osiągnąć odpowiednią jakość sygnału i duże prędkości jego przepływu. Wykorzystanie fotoniki opartej na krzemie oznacza, że dane można będzie przesyłać szybciej i na większe odległości. Poszczególne elementy superkomputerów czy części bazy danych nie będą musiały znajdować się blisko siebie. Da się je wygodnie rozsiać po całym budynku lub nawet zespole budynków. Zastąpienie łączy miedzianych optycznymi umożliwi stworzenie jeszcze potężniejszych superkomputerów niż obecnie. Jak obliczają specjaliści, wykorzystanie elektroniki do stworzenia 10-terabitowego kanału przesyłu danych pomiędzy CPU a pamięcią wymagałoby 160 watów mocy. Zdaniem specjalistów z Hewlett Packard, jeśli zastąpimy elektronikę zintegrowaną fotoniką, pobór mocy spadnie do 6,4 wata. Problemem jest też stworzenie miniaturowych laserów, które można będzie budować za pomocą dostępnych technologii.

Niedawno uczeni z Uniwersytetu w Kopenhadze opracowali rodzaj działa wystrzeliwującego pojedyncze fotony. Zostało ono zintegrowane w optycznym układzie scalonym, składającym się z miniaturowego kryształu o szerokości 10 i grubości 160 mikrometrów. W centrum znajduje się kropka kwantowa, stanowiąca źródło światła. Gdy oświetlamy laserem kwantową kropkę, światło lasera wzbudza elektrony, które przeskakują z jednej powłoki na drugą, emitując pojedyncze fotony. Zwykle wędrują one we wszystkich kierunkach, jednak ten układ fotoniczny został tak zaprojektowany, że fotony mogą poruszać się tylko przez pojedynczy kanał - zespół z Kopenhagi kontrolował i wysyłał w pożądanym kierunku 98,4% fotonów.

Wkrótce potem uczeni ze szwajcarskich instytutów wraz z kolegami z innych krajów stworzyli pierwszy w historii laser germanowo-cynowy, bezpośrednio połączony z krzemowym chipem. Osiągnięcie to, o którym napisało czasopismo „Nature Photonics", udowodniło, że laserowy układ wzmacnia sygnał, przesyłając go jako wiązkę danych. W celach demonstracyjnych laser jest wzbudzany optycznie. Uczeni muszą teraz dokonać tego samego za pomocą sygnału elektrycznego. Ograniczeniem do przezwyciężenia jest konieczność schładzania układu do -183°C, ale wg badaczy da się z tą temperaturą znacznie zejść w dół.

Fotoniczna (optyczna) technologia komunikacyjna jest o rząd wielkości szybsza niż elektryczna technologia komunikacyjna, ale materiały i procesy wykorzystywane do produkcji fotonicznych układów scalonych są zasadniczo niezgodne z procesem technologicznymi krzemu (CMOS). Oznacza to, że fotoniczne układy scalone zostały wyprodukowane na ultraszybkich, autonomicznych układach, a następnie podłączone poprzez ultrawolny, wysokoenergetyczny interfejs elektryczny z powrotem do zwykłego środowiska komputerowego. Dlatego też fotonika o wysokiej prędkości jest obecnie wykorzystywana jedynie w kosztownych centrach danych i urządzeniach telekomunikacyjnych. Wystarczy zdać sobie sprawę, że te implementacje są zagrożone przez wysokoenergetyczny, wysokolatencyjny, elektryczny interfejs chip-to-chip.

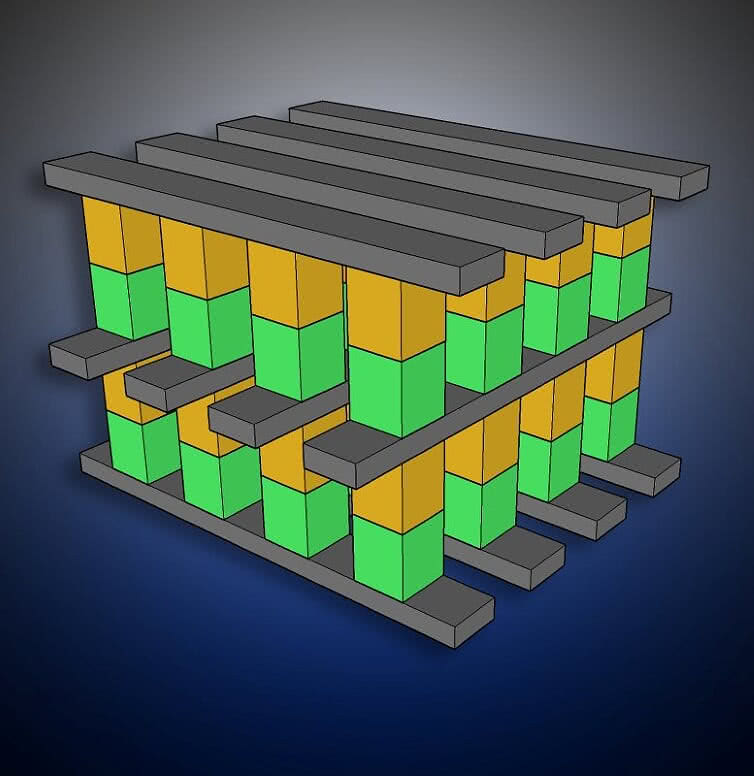

Optyczna transmisja danych na układach scalonych, możliwa dzięki zastosowaniu fotoniki krzemowej (SiP), jest powszechnie uważana za kluczową technologię przezwyciężenia ograniczeń przepustowości i ograniczeń energetycznych połączeń elektrycznych. Innym kierunkiem, na który warto zwrócić uwagę, są tzw. pamięci rezystywne. Najpopularniejszym i najszerzej produkowanym rodzajem pamięci rezystywnej jest ta sprzedawana przez Intela pod marką Optane. Opracowana przez Intela i Microna technika została nazwana przez obie firmy 3D XPoint (3). Według niezależnych analiz mikroskopowych pamięć 3D XPoint zbudowano z dwóch rodzajów materiałów: materiałem rezystywnym jest szkło chalkogenkowe GeSbTe (german, antymon, tellur), a rolę diody ograniczającej przepływ prądu do jednego kierunku odgrywa inne szkło chalkogenkowe (selen, german, krzem, arsen). Jest to pamięć typu PCM, w której materiał memrezystywny zmienia stany skupienia ze szklistego na krystaliczny i na odwrót.

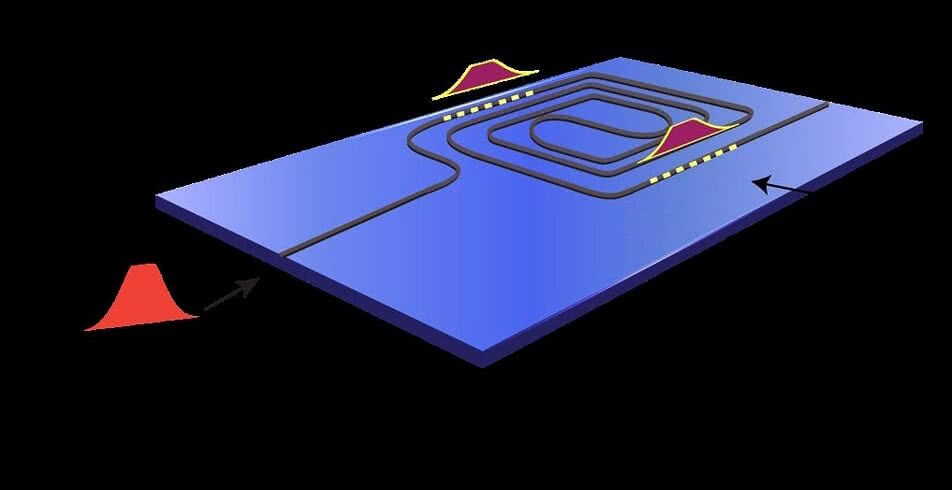

W ubiegłym roku naukowcy zrobili duży krok w kierunku stworzenia kolejnej technologii komputerowych układów, tym razem łączącej światło z dźwiękiem. Po raz pierwszy w historii przechowywali oni informacje oparte na świetle jako fale dźwiękowe na chipie komputerowym, co porównali z przechwytywaniem piorunów jako grzmot.

Kodowanie informacji do fotonów jest dość proste - robimy to już wtedy, gdy wysyłamy informacje za pomocą światłowodu. Ale znalezienie sposobu na to, aby chip komputerowy mógł pobierać i przetwarzać informacje przechowywane w fotonach, jest trudne z jednego powodu - światło jest zbyt szybkie, aby istniejące mikroukłady mogły je odczytać. Dlatego też informacje oparte na świetle, które mkną przez kable internetowe, są obecnie przekształcane w wolne elektrony. Jak się okazuje lepszą alternatywą byłoby spowolnienie światła i przekształcenie go w dźwięk. Tak przynajmniej uważają naukowcy z Uniwersytetu w Sydney w Australii.

- Informacje zawarte w naszym chipie w formie akustycznej przemieszczają się z prędkością o pięć rzędów wielkości wolniejszą niż w optyce - powiedziała mediom kierownik projektu Birgit Stiller.

Zespół opracował system pamięci, który dokładnie przenosi światło i fale dźwiękowe na fotoniczny mikroprocesor - rodzaj chipa, który będzie używany w komputerach wykorzystujących światło (4). Informacja fotoniczna dostaje się do chipa jako impuls świetlny, gdzie wchodzi w interakcję z impulsem „zapisu", wytwarzając falę akustyczną, która przechowuje dane. Kolejny impuls świetlny, zwany impulsem odczytu, uzyskuje dostęp do tych danych dźwiękowych i ponownie przesyła światło. Informacja zapisana jako fala dźwiękowa może pozostać na chipie do 10 nanosekund - na tyle długo, by dało się ją odzyskać i przetworzyć.

Fakt, że zespół był w stanie przekształcić światło w fale dźwiękowe, sprawił, że pobieranie danych stało się bardziej dokładne. W przeciwieństwie do poprzednich prób, system działał w szerokim paśmie. Wyniki zostały opublikowane w „Nature Communications".

Kwantowa wojna światowa

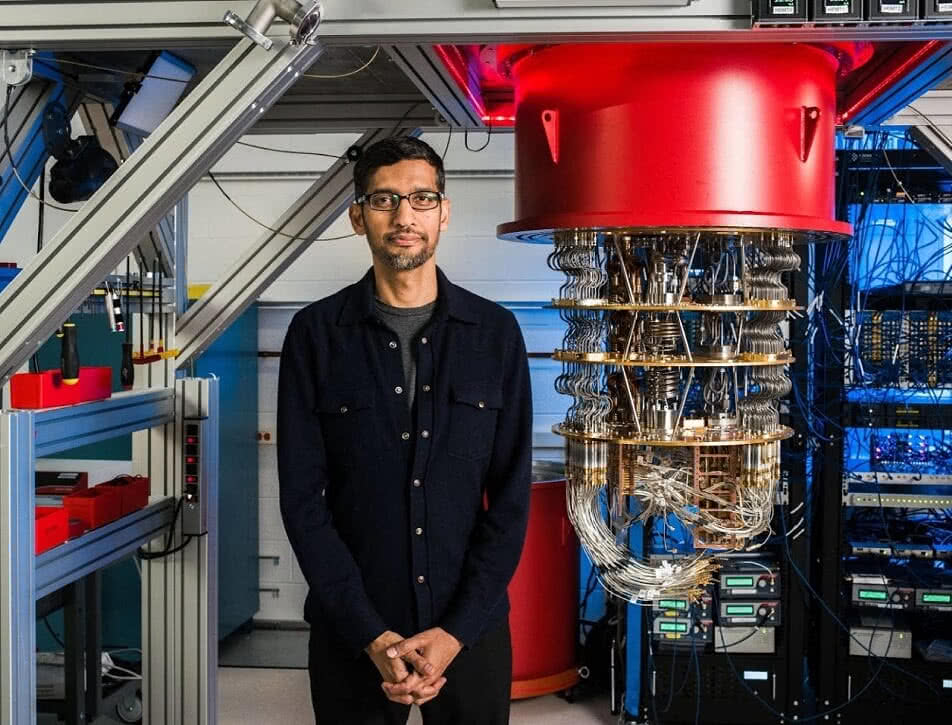

Jak wiadomo, w październiku 2019 r. Google ogłosił „kwantową supremację" (5), twierdząc, że jego maszyna może w 200 sekund rozwiązać problem, który zająłby najszybszemu superkomputerowi na świecie 10 tys. lat. Oświadczenie to zostało odebrane z dużym sceptycyzmem, jednak nikt nie wątpi, że już sama deklaracja wytycza ramy rywalizacji.

Dawno temu, podczas jednego ze swoich osławionych wykładów o fizyce kwantowej na Massachusetts Institute of Technology, laureat Nagrody Nobla, Richard Feynman, zaprezentował teoretyczny model działania urządzenia, które nazwał komputerem kwantowym. Wówczas uznano tę koncepcję za fantastykę naukową. Feynman przekonywał słuchaczy, że do przekształcenia systemu kwantowego w model komputerowy wykorzystać można wiele zjawisk.

Idea Feynmana została po raz pierwszy zrealizowana już piętnaście lat po słynnym wykładzie. W 1996 r. Neil Gershenfeld, Isaac L. Chuang i Marc Kubineca zbudowali maszynę wykorzystująca zjawisko rezonansu magnetycznego NMR. Urządzenie programowano za pomocą impulsów radiowych.

Historia ta dowodzi, że pojęcie „komputer kwantowy" można rozumieć wielorako - sam Feynman w końcu dopuszczał w tym względzie wiele opcji. Umownie uważa się jednak, że przełom w informatyce kwantowej nastąpił dopiero w 2009 r., kiedy dwaj doktoranci z Centrum Fotoniki Kwantowej na Uniwersytecie Bristolskim - Alberto Politi i Jonathan Matthews - zbudowali pierwszy optyczny komputer kwantowy korzystający z czterech kubitów, czyli bitów kwantowych.

Mówiąc kolokwialnie i skrótowo, w przeciwieństwie do tradycyjnego bita - oznaczającego w systemie binarnym 1 lub 0 - kubit opisuje pewien układ kwantowy, o którym nie możemy uzyskać pełnej informacji bez zaburzenia go poprzez pomiar. Te superpozycje stanów są bardzo nietrwałe. Nawet najmniejszy kontakt z otoczeniem powoduje, że w ułamku sekundy układ wypada ze stanu superpozycji do stanu stacjonarnego. Takie zjawisko fizycy nazywają dekoherencją. Stanowi ona największą przeszkodę w pracy maszyn kwantowych, choć zaczynamy nad nią powoli panować.

Prawdziwy wyścig w budowie coraz większych procesorów kwantowych rozpoczął się w drugiej połowie kończącej się dekady. W czerwcu 2017 r. IBM poinformowało, że w chmurze zostanie uruchomiona usługa IBM Q, która pozwala na komercyjny dostęp do komputera kwantowego wyposażonego w pięciokubitowy procesor. Zaledwie półtora miesiąca później, na odbywającej się w Moskwie Międzynarodowej Konferencji na temat Technologii Kwantowych, Mikhail Lukin - kierownik zespołu badawczego Lukin, z Quantum Optics Laboratory na Uniwersytecie Harvarda - ogłosił, że jego zespół zbudował i uruchomił 51-kubitowy komputer kwantowy.

Płaszczyzna rywalizacji firm w dziedzinie obliczeń kwantowych to jedno. Nakłada się jednak na nią ogólniejsza rywalizacji państw, a zwłaszcza największych mocarstw. Amerykanów, którzy oficjalnie prowadzą w tej dziedzinie, niepokoją dokonania Chińczyków. Wiodącą instytucją jest tam Uniwersytet Naukowo-Technologiczny (USTC), jedna z najbardziej prestiżowych szkół w kraju, z siedzibą w Hefei koło Szanghaju. Prezydent Chin, Xi Jinping, odwiedził USTC w 2016 r., gdzie spotkał się z Panem Jianweiem, wiceprezydentem szkoły i chińskim „ojcem kwantowym". UTSC przewodzi wysiłkom mającym na celu zbudowanie ogólnokrajowej sieci komunikacji kwantowej, która poprzez satelity i kable światłowodowe łączyłaby Pekin, Szanghaj, Guangzhou i pięć innych miast. W prezentacji na konferencji w Szanghaju, współorganizowanej w sierpniu przez Międzynarodowy Związek Telekomunikacyjny (ITU), organ Organizacji Narodów Zjednoczonych, Pan wyjaśnił, w jaki sposób satelity kwantowe mogą być wykorzystywane do zapewnienia „bezwarunkowego bezpieczeństwa" w przekazywaniu danych, nie do złamania.

Naukowiec z Kraju Środka kierował również zespołem badawczym stojącym za Miciusem, pierwszym na świecie satelitą kwantowym, wystrzelonym przez Chiny w 2016 r. Nazwany na cześć starożytnego chińskiego filozofa, Moziego, satelita z powodzeniem zarządzał w 2017 r. rozmową wideo między Pekinem a Wiedniem przy użyciu szyfrowania kwantowego, uniemożliwiającego podsłuchiwanie.

„Postępy Chin w nauce kwantowej mogą mieć wpływ na przyszłą równowagę militarną i strategiczną, być może nawet przeskakując tradycyjne amerykańskie zalety wojskowo-technologiczne" - napisali Elsa B. Kania i John Costello w swoim raporcie „The Strategic Support Force and the Future of Chinese Information Operations", dodając, że Stany Zjednoczone „powinny (...) podwoić wysiłki, aby pozostać liderem, a przynajmniej głównym przeciwnikiem w rozwoju technologii kwantowych".

W sierpniu 2018 r. prezydent Donald Trump podpisał ustawę o krajowej inicjatywie kwantowej. Zezwala ona na przeznaczenie w ciągu pięciu najbliższych lat dodatkowego 1,2 mld dolarów na finansowanie badań, jak również mówi o ustanowieniu w USA krajowego komitetu kwantowego w celu koordynacji badań i finansowania publicznego.

„Kubit dla ubogich"

Tyle o potęgach. A co z wyścigu technologii kwantowych może mieć trochę bardziej zwykły użytkownik? Okazuje się, że i jemu (nam) może to i owo skapnąć.

W październiku 2019 r. naukowcy po raz pierwszy zademonstrowali sprzęt do komputera probabilistycznego, który wykonuje obliczenia z wykorzystaniem p-bitów. Rozwiązanie to wypełniałoby lukę między obliczeniami klasycznymi a kwantowymi, dostarczając coś, co naukowcy nazywają „kubitami dla ubogich". Wszystko zostało opisane we wrześniowym numerze „Nature".

Komputery probabilistyczne mogłyby potencjalnie rozwiązać wiele z problemów, które stoją przed maszynami kwantowymi, za to dałoby się je produkować w oparciu o istniejący dziś sprzęt.

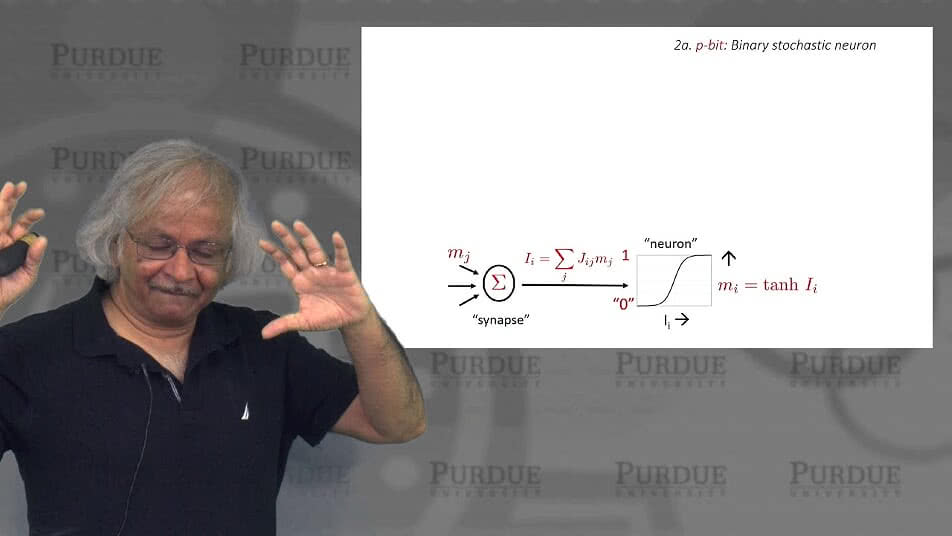

Bit probabilistyczny, czyli p-bit, został zaproponowany w 2017 r. przez grupę badawczą z Uniwersytetu Purdue (6). W przeciwieństwie do konwencjonalnych, stabilnych bitów, p-bity są jednostkami zmiennymi losowo, niestabilnymi: zmieniają się w czasie pomiędzy 0 i 1. Innymi słowy, oceniają do 0 (lub 1) z pewnym prawdopodobieństwem. Można je następnie połączyć, aby wdrożyć funkcje logiczne. Inną unikalną cechą jest to, że są one odwracalne.

Urządzenie opisane w „Nature" opiera się na magnetorezystywnej pamięci RAM lub MRAM (Intel na początku tego roku zapowiedział, że może produkować te układy masowo) i wykorzystuje orientację mikroskopijnych magnesów, aby zmienić opór, by reprezentować 1 lub 0. Badacze z Uniwersytetu Tohoku w Japonii zmodyfikowali MRAM, aby uczynić układ celowo niestabilnym, ułatwiając fluktuacje bitów. Zostało to połączone z tranzystorem w celu kontrolowania fluktuacji. I w ten sposób mamy ów „kubit dla ubogich". Aby zbudować funkcjonalny komputer probabilistyczny, osiem takich jednostek p-bitowych zostało połączonych ze sobą.

Chociaż sprzęt nie rozwiązuje jeszcze żadnych problemów będących poza zasięgiem klasycznych komputerów (jak ma to miejsce w przypadku obliczeń kwantowych), badacze podkreślają, że mniejszym kosztem wykonuje funkcje, do których potrzebne byłyby tysiące tranzystorów.

Tylko zadyszka?

Większość prowadzonych obecnie badań i poszukiwań rozwiązań obliczeniowych można opisać jako wysiłek zmierzający do przezwyciężenia kryzysu prawa Moore’a i fundamentalnych ograniczeń, do jakich dotarliśmy w procesach rozwoju technologii krzemowych. Mijające dziesięciolecieznaczone było piętnem schyłku możliwości rozwijanej od ponad półwiecza tranzystorowej elektroniki, co zwykły użytkownik widział chociażby w stagnacji sprzętowych parametrów, które mu oferowano. Wszyscy mocno liczą na to, że w okolicach 2030 r. będziemy mówić o tym czasie jako o jedynie przejściowej zadyszce postępu technicznego w komputerach.

Mirosław Usidus