Pomocna dłoń maszyny, która może sięgnąć po władzę

Ray Kurzweil (1), analizując historię ludzkości, doszedł do wniosku, że postęp techniczny następuje w sposób wykładniczy, ponieważ każdy wynalazek przyspiesza pojawienie się kolejnego. Uogólnił prawo Moore’a, opisujące geometryczny wzrost złożoności układów scalonych, odnosząc je również do innych technologii. Według jego przewidywań, kluczowe odkrycia naukowe będą następować w coraz krótszych odstępach czasu, aż dojdzie do "rozerwania tkanki historii cywilizacji".

Kurzweil wierzy, że stanie się to jeszcze przed końcem pierwszej połowy XXI wieku, najprawdopodobniej ok. roku 2045. Zakłada raczej stopniowe zbliżanie się do tego momentu niż gwałtownie rozwijającą się nadludzką inteligencję. Według niego, najpierw w 2029 r. pojawi się silna sztuczna inteligencja, która do 2045 r. wyewoluuje w tzw. technologiczną osobliwość (2). Inaczej mówiąc, naukowiec uważa, że będziemy mogli w tej perspektywie stworzyć w chmurze obliczeniowej obiekty działające podobnie do nowej kory mózgowej i już w okolicach 2030 r. połączyć z nimi nasze biologiczne mózgi.

Pojęcie osobliwości technologicznej jest ściśle związane z rozwojem sztucznej inteligencji (AI oraz ML - od machine learning, uczenia maszynowego). Pojawienie się nadludzkiej superinteligencji ma radykalnie zmienić reguły gry i tempo postępu.

Sam Kurzweil patrzy na to z optymizmem. Nie brakuje jednak opinii, że taka hipotetyczna superinteligencja błyskawicznie pozbyłaby się ludzi, albo zrobiła z nich niewolników, jeśli w ogóle do czegoś byliby jej potrzebni. Jeśli powstanie takiego sztucznego nad-umysłu jest możliwe (w co wielu ekspertów wątpi), pocieszające może być to, że w najbliższej dekadzie - na którą spoglądamy w tym numerze "MT" naszym prognostycznym okiem - na pewno to jeszcze nie nastąpi. Choć oczywiście AI już z nami będzie, wciąż rozwijana.

Warto zauważyć przede wszystkim, że panujące poglądy i przesądy na temat sztucznej inteligencji są często brutalnie weryfikowane przez rzeczywistość. I to zarówno w pozytywnym, jak i negatywnym sensie. Firma ZipRecuiter w przeprowadzonych kilka miesięcy temu badaniach skonfrontowała przekonania osób poszukujących zatrudnienia - spośród których 58% uważa, że AI niszczy więcej miejsc pracy niż tworzy - z danymi o 300-procentowym wzroście liczby stworzonych przez AI stanowisk pracy w stosunku do tych, które wcześniej zniszczyła.

Z kolei z badań wykonanych przez Harvey Nash/KPMG CIO Survey wynika wprawdzie, że 20% zatrudnionych w sektorze IT zostanie w ciągu pięciu lat zastąpionych przez AI/automatyzację, ale jednocześnie aż 69% dyrektorów IT uważa, że nowe miejsca w branży IT zrekompensują utratę tych, które znikną z powodu wprowadzania sztucznej inteligencji.

Jeśli w większości krajów wyraźna większość ankietowanych uważa, że AI zagraża pracownikom (np. w USA sądzi tak ponad 70% ludzi), to już w gronie kadry kierowniczej, która rzeczywiście zatrudnia zarówno ludzi jak i maszyny, nastawienie jest zgoła inne. W badaniach firmy Tibco tylko 9% dyrektorów przedsiębiorstw sądzi, że wprowadzanie systemów sztucznej inteligencji spowodowałaby znaczną utratę miejsc pracy, zaś 27% uważa przeciwnie - że doprowadzi do znaczącego ich wzrostu.

Nie tajemnicza AI, lecz pożyteczna RPA

Sztuczna inteligencja i maszynowe uczenie pojawiły się na dobre na medialnej scenie w latach 2014 i 2015, wraz z wielkimi inwestycjami liderów technologicznych, takich jak IBM oraz Microsoft - i z szumem, jaki to wszystko wywołało. Teraz rynek AI/ML wydaje się "wycofywać", uważa Craig Le Clair, analityk firmy Forrester Research. Podczas jednej z konferencji poświęconych tej tematyce Le Claire wskazał, że praktyka implementacji do naszej pracy i życia tego, co nazywamy AI, jest znacznie mniej efektowna niż wizje futurologów i medialne sensacje.

Obecnie najczęściej spotykanym przejawem obecności AI w gospodarce jest zrobotyzowana automatyzacja procesów (Robotic Process Automation, RPA), czyli technologia automatyzacji powtarzalnych procesów biznesowych z wykorzystaniem programów komputerowych - robotów symulujących pracę człowieka.

Zrobotyzowana automatyzacja procesów znajduje zastosowanie w gospodarce poprzez zlecanie maszynom zadań powierzanych wcześniej konkretnym pracownikom. Roboty RPA są programowane do samodzielnego działania o różnym stopniu skomplikowania, cechującym się powtarzalnością i ograniczoną liczbą wyjątków w regule algorytmu. Dobrze to brzmi, ale wcale nie jest łatwo wprowadzać tego rodzaju ulepszenia. Z badań firmy KPMG, która ankietowała sześciuset menedżerów firm w krajach zachodnich, wynikało, że zaledwie w siedemnastu przypadkach wprowadzono RPA z pełnym wykorzystaniem możliwości technicznych.

Problemem jest brak personelu i zasobów technologicznych, a także wsparcia organizacyjnego i wiedzy. Jak wynika z innych badań, tym razem firmy Deloitte, mimo wszystko już ponad połowa ankietowanych firm wdrożyła RPA, choć należałoby zapytać, co dokładnie przez to rozumieją. Większość pozostałych przedsiębiorstw zamierza wdrożyć tego rodzaju rozwiązania w ciągu najbliższych lat.

I właśnie to, a nie demoniczne superinteligencje, wydaje się dziś rzeczywistością AI. W dodatku chodzi o maszyny, których często nie widać, bo nie zawsze dotyczy to robotów fizycznych, zastępujących czynności ludzi, np. w fabrykach czy magazynach. Wiele z tych urządzeń pracuje w mroku, nocami, przeliczając, przetwarzając i sortując, aby ludzie mogli rano zasiąść przed efektami ich żmudnej pracy. Le Clair w swojej książce "Invisible Robots in the Quiet of the Night" przewiduje, że do 2025 r. większość pracowników firm będzie miała własnego robota wspomagającego i asystującego, samodzielnie konfigurowanego za pomocą prostych poleceń tekstowych.

Z wielu raportów płyną informacje o dużych korzyściach, jakie daje RPA po stronie kosztów, wydajności i zwiększenia dokładności procesów. Przykładem - stawki zamówień po wdrożeniu zautomatyzowanego systemu, które wzrosły w firmie telekomunikacyjnej Vodaphone z 73 do 96%. Z kolei emitent kart płatniczych VISA zaoszczędził 25 mld dolarów dzięki analitycznym narzędziom opartym na AI, wykrywającym potencjalne oszustwa i wyłudzenia produktów finansowych. Skoro są tak wyraźne korzyści, kierunek wydaje się oczywisty.

Algorytmiczny wyścig zbrojeń

Nadchodzące lata będą oczywiście również okresem nastającego wyścigu zbrojeń w dziedzinie AI. Wojsko amerykańskie gorączkowo pracuje nad włączeniem na niezliczone sposoby AI do swoich operacji - w tym samolotów bezzałogowych i robotów do transportu rannych żołnierzy z dala od pola walki, oprogramowania, które może wykryć ukryte siły wroga np. za wzgórzem, programów AI, dającym generałom i żołnierzom liniowym pełniejszy obraz bitwy, a nawet algorytmów potrafiących wskazywać właściwe osoby do konkretnych zadań i służb.

Projekty te, a także wiele innych, stanowią trzon ważnej inicjatywy Pentagonu, która przynosi daleko idące konsekwencje dla globalnej równowagi sił w XXI wieku. AI Task Force amerykańskiej armii, utworzona na początku 2019 r. jako część szerszego wysiłku Departamentu Obrony w celu urzeczywistnienia tego, co kiedyś było tylko science fiction, zgromadziła urzędników wojskowych i przywódców akademickich na Uniwersytecie Carnegie Mellon - instytucji uważanej niekiedy za miejsce narodzin badań nad AI.

Urzędnicy administracyjni i analitycy twierdzą oczywiście, iż główni amerykańscy rywale mają podobne cele. Rzeczywiście, Chiny prowadzą agresywne badania nad AI i przeznaczają miliardy dolarów na rewitalizację własnego wojska pod kątem walk następnej generacji. W przemówieniu wygłoszonym pod koniec 2018 r. chiński prezydent Xi Jinping powiedział, że Pekin musi poprawić swoje możliwości w zakresie AI, aby naród nie był zależny od sprzętu i oprogramowania wojskowego innych państw.

Kompleksową strategię AI realizuje również Rosja, mając zamiar wsparcia swojego wojska, instytucji akademickich, systemu opieki zdrowotnej i innych obszarów społeczeństwa. Podobnie jak w USA, podejście Moskwy w dużym stopniu opiera się na zacieśnianiu współpracy i koordynacji pomiędzy sektorem wojskowym, akademickim i prywatnym.

Zamiast klasycznych sieci neuronowych

Nie jest wykluczone, że obok modeli sieci neuronowych, do których zdążyliśmy się przyzwyczaić, powiązanych tradycyjnie z systemami uczenia maszynowego, głębokiego uczenia i ogólnie z AI, pojawią się w najbliższych latach alternatywne rozwiązania sztucznej inteligencji.

Najwięcej w tym kontekście mówi się o tzw. pamięci hierarchicznej (hierarchical temporal memory, HTM), która mogłaby posłużyć do rozwoju technik uczenia maszynowego nienadzorowanego.

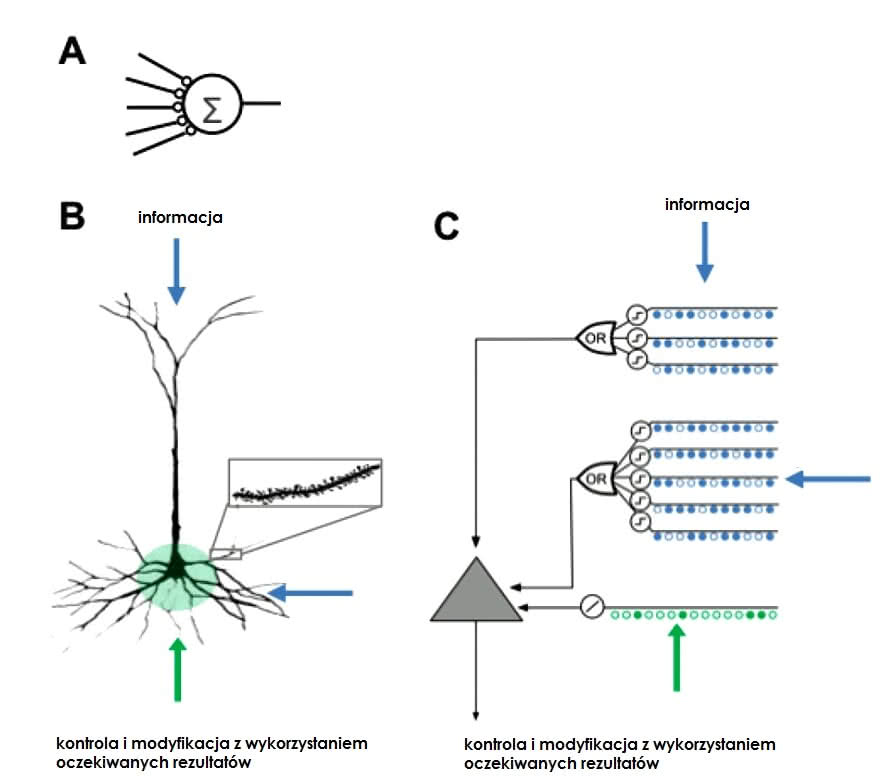

Choć wydawałoby się, że architektura sieci neuronowych jest najbliższa naszemu mózgowi w modelach nauczania maszynowego, jednak w praktyce są to modele nadzorowane, działającej inaczej niż ludzki mózg. Jeśli mamy stworzyć coś funkcjonującego podobnie do naszego umysłu, potrzeba odmiennego podejścia.

HTM to model uczenia maszyn opracowany przez Jeffa Hawkinsa i Dileepa George’a z firmy Numenta, założonej w 2005 r. Odzwierciedla on strukturalne i algorytmiczne właściwości kory nowej (neocortex). Model ten stosuje podejście podobne do tzw. sieci bayesowskich (zgodnie z definicją - służących do przedstawiania zależności pomiędzy zdarzeniami, w oparciu o rachunek prawdopodobieństwa). Związany jest z teorią przewidywania opartego na pamięci - teorii działania mózgu opisanej przez Hawkinsa w jego książce "Istota Inteligencji". Sieci HTM są uważane za bionaśladowcze modele wnioskowania o przyczynach (3).

Podczas gdy sieci neuronowe ignorują strukturę (hierarchie) i skupiają się na emulacji neuronów, sieci HTM koncentrują się na budowie hierarchicznej, a ignorują emulację neuronów. Typowa sieć HTM to hierarchia poziomów w kształcie drzewa, które składają się z mniejszych elementów zwanych regionami (lub węzłami). Jeden poziom w hierarchii może zawierać kilka regionów. Wyższe poziomy hierarchii często mają mniej regionów i mogą ponownie wykorzystać wzorce poznane na niższych poziomach, łącząc je w celu zapamiętania bardziej złożonych wzorców. Każdy region HTM ma taką samą podstawową funkcjonalność.

W trybach uczenia się i wnioskowania dane sensoryczne (np. pochodzące z pracy oczu) trafiają do regionów na najniższym poziomie. W trybie generowania regiony dolnego poziomu wyświetlają wytworzony wzorzec danej kategorii. Górny poziom ma zazwyczaj jeden region, przechowujący najbardziej ogólne kategorie (koncepcje), które określają lub są określane przez mniejsze koncepcje na niższych poziomach, bardziej ograniczonych w czasie i przestrzeni. Po ustawieniu w trybie wnioskowania, region (na każdym poziomie) interpretuje informacje napływające z jego regionów na niższym poziomie jako prawdopodobieństwo kategorii, które ma już w pamięci.

Algorytm - władca wszystkich algorytmów

Odnosząc się do problemu superinteligencji zapowiadanej przez Kurzweila, Daniel J. Buehrer, emerytowany profesor z National Chung Cheng University na Tajwanie, opublikował w kwietniu 2018 r. artykuł "A Mathematical Framework for Superintelligent Machines". Zaproponował w nim nową "matematykę klas", prowadzącą potencjalnie do narodzin świadomości maszyn. Jeśli jego teorie byłyby poprawne, mogłyby zaowocować stworzeniem wszechobejmującego, samouczącego się algorytmu. Buehrer proponuje matematyczną metodę organizowania różnych odmian AI-machine learningu w ramach jednego rządzącego konstruktu, opisanego obrazowo w książce Pedra Domingosa "The Master Algorithm" - "Algorytm Mistrza-Dominatora" (albo "Algorytm Pana").

Stworzenie klasy algorytmu samouczącego, która mogłaby uczyć się od dowolnej liczby podłączonych agentów AI (i kontrolować ich), na zasadzie dyrektora generalnego wszystkich maszyn sztucznej inteligencji, teoretycznie rozwijałoby się wykładniczo. Buehrer liczy na powstanie pętli sprzężenia zwrotnego, z której ostatecznie wyłonić miałaby się świadomość maszyny, całkiem podobna do ludzkiej (4).

Co ciekawe, badania Buehrera wskazują, że systemy AI mogą pewnego dnia wejść w konflikt ze sobą, w ramach walki o dominację, w czym uczony widzi analogię z wojnami i konfliktami, w jakie wchodzili historycznie ludzie. Wizje "algorytmu Pana" i wojen sztucznej inteligencji są dość dalekie od optymizmu Kurzweila, zaś osobliwość, która miałaby być "czymś zupełnie innym niż to, co znamy", stałaby się czymś dziwnie znajomym…

Mirosław Usidus