Powiedz kotku, jak myślisz w środku - efekt czarnej skrzynki

W 2015 r. grupa badawcza ze szpitala Mount Sinai w Nowym Jorku została poproszona o zastosowanie techniki deep learning do analizy rozległej bazy danych tamtejszych pacjentów (2). Ten ogromny zbiór zawiera ocean informacji dotyczących chorych, a pochodzących z wyników badań, wizyt lekarskich itp.

Powstały w toku prac program analityczny naukowcy nazwali Deep Patient. Został on przeszkolony z użyciem danych ok. 700 tys. osób, a po przetestowaniu na nowych rejestrach okazał się niezwykle skuteczny w przewidywaniu chorób. Bez asysty ludzkich specjalistów Deep Patient odkrył w danych szpitalnych wzorce wskazujące, który pacjent znajduje się na ścieżce do choroby, np. raka wątroby. W ocenie specjalistów skuteczność prognostyczno-diagnostyczna systemu była znacznie wyższa niż jakiekolwiek inne znane metody.

Jednocześnie badacze zauważyli, że Deep Patient działa w sposób zagadkowy. Okazało się np., że doskonale sprawdza się w rozpoznawaniu zaburzeń psychicznych, takich jak schizofrenia, co jest niezwykle trudne dla lekarzy. Wzbudziło to zdziwienie, zwłaszcza że nikt nie miał pojęcia, jak to się dzieje, iż system AI tak dobrze widzi chorobę psychiczną na podstawie samej tylko dokumentacji medycznej pacjenta. Owszem, specjaliści byli bardzo zadowoleni z pomocy tak skutecznego maszynowego diagnosty, byliby jednak znacznie bardziej usatysfakcjonowani, gdyby rozumieli, w jaki sposób AI dochodzi do swoich wniosków.

Warstwy sztucznych neuronów

Od początku, czyli od momentu, gdy pojęcie sztucznej inteligencji stało się znane, istniały dwie szkoły myślenia o AI. Pierwsza zakładała, że najbardziej sensowne jest budowanie maszyn, które rozumują zgodnie ze znanymi nam zasadami i ludzką logiką, czyniąc ich wewnętrzne funkcjonowanie przejrzystym dla każdego. Inni uważali, że inteligencja wyłoni się łatwiej, jeśli maszyny będą uczyć się przez obserwacje i kolejno powtarzane doświadczenia.

To drugie oznacza odwrócenie typowego programowania komputerowego. Zamiast programisty piszącego polecenia mające rozwiązać problem, program generuje własny algorytm na podstawie przykładowych danych i pożądanego wyjścia. Techniki uczenia maszynowego, które później wyewoluowały w najpotężniejsze znane dziś systemy AI, podążyły właśnie drogą, która polega na tym, że zasadniczo maszyna sama się programuje.

Podejście to w latach 60. i 70. pozostawało na marginesie badań nad systemami AI. Dopiero na początku poprzedniej dekady, po kilku innowacyjnych zmianach i udoskonaleniach, "głębokie" sieci neuronowe zaczęły wykazywać radykalną poprawę możliwości zautomatyzowanej percepcji.

Głębokie uczenie maszynowe dało komputerom niezwykłe moce, takie jak np. zdolność do rozpoznawania wypowiadanych słów niemal tak dokładnie, jak to potrafi człowiek. Jest to umiejętność zbyt złożona, aby można ją było zaprogramować z góry. Trzeba zapewnić maszynie możliwość stworzenia własnego "programu" przez naukę na ogromnych zbiorach danych.

Głębokie uczenie przekształciło też komputerowe rozpoznawanie obrazu i znacznie poprawiło jakość tłumaczenia maszynowego. Obecnie jest ono wykorzystywane do kierowania wszelkiego rodzaju kluczowymi decyzjami w medycynie, finansach, produkcji i nie tylko.

Przy tym wszystkim jednak nie można po prostu zajrzeć do głębokiej sieci neuronowej, aby zobaczyć, jak działa "wewnątrz". Procesy rozumowania sieci są osadzone w zachowaniach tysięcy symulowanych neuronów, ułożonych w dziesiątki, a nawet setki misternie połączonych ze sobą warstw.

Każdy z neuronów w pierwszej warstwie odbiera sygnał wejściowy, np. intensywność piksela w obrazie, a następnie wykonuje obliczenia, zanim wyprowadzi sygnał wyjściowy. Te są podawane, w złożonej sieci, do neuronów w następnej warstwie - i tak dalej, aż do ostatecznego sygnału wyjściowego. Ponadto istnieje proces znany jako back-propagation, dostosowujący obliczenia dokonywane w poszczególnych neuronach w sposób, który pozwala sieci uczyć produkować pożądany sygnał wyjściowy.

W często cytowanym przykładzie związanym z rozpoznawaniem obrazu psa niższe warstwy AI analizują proste cechy, takie jak kontury lub kolor. Wyższe zajmują się kwestiami bardziej złożonymi, w rodzaju futra lub oczu. Dopiero warstwa górna składa wszystko w całość, identyfikując komplet informacji jako psa.

To samo podejście można zastosować do innych typów danych wejściowych, zasilających maszynę w samodzielnym uczeniu: dźwięków, które składają się na słowa w mowie, liter i wyrazów tworzących zdania w tekście pisanym, lub np. ruchów kierownicą wymaganych do prowadzenia pojazdu.

Maszyna niczego nie pomija

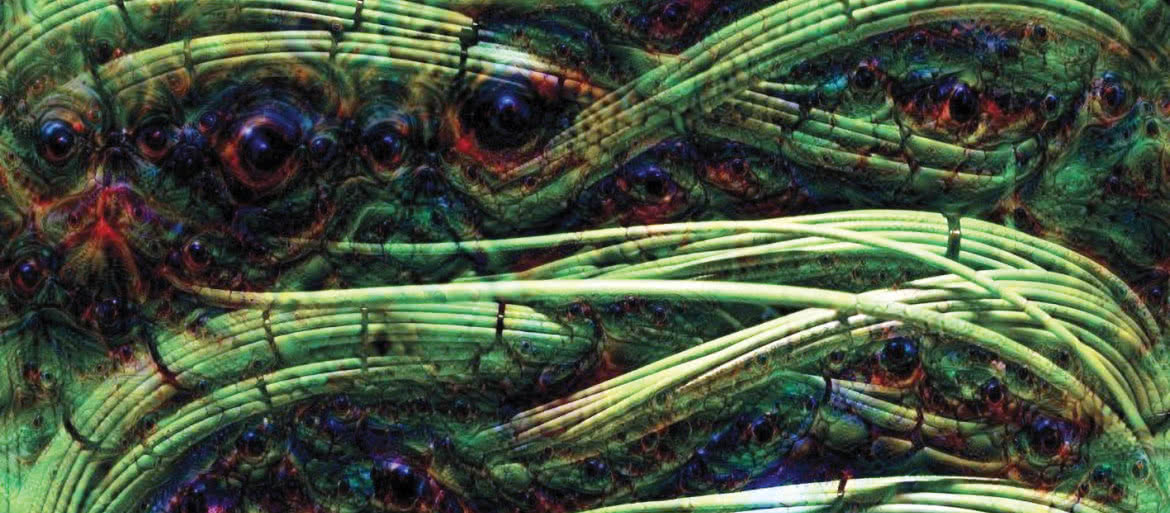

Próbowano wyjaśnić, co dokładnie dzieje się w tego rodzaju systemach. W 2015 r. naukowcy z Google’a tak zmodyfikowali algorytm rozpoznawania obrazu oparty na głębokim uczeniu, aby zamiast dostrzegać obiekty na zdjęciach, generował on je lub modyfikował. Uruchamiając algorytm w odwrotnym kierunku, chcieli odkryć cechy, które program wykorzystuje do rozpoznawania, powiedzmy, ptaka lub budynku.

Eksperymenty te, znane publicznie pod nazwą Deep Dream, doprowadziły do wygenerowania niesamowitych obrazów (3), przedstawiających groteskowe, dziwaczne zwierzęta, krajobrazy i postacie. Ujawniając pewne tajniki postrzegania maszynowego, np. fakt wielokrotnego powracania i powtarzania określonych wzorców, pokazały zarazem, jak bardzo głęboka nauka maszynowa różni się od ludzkiej percepcji - np. w tym sensie, że rozbudowuje i powiela artefakty, które my podczas naszego procesu percepcyjnego ignorujemy bez zastanowienia.

Nawiasem mówiąc, eksperymenty te wykazały od drugiej strony tajemniczość naszych własnych mechanizmów poznawczych. Być może bowiem to w naszym postrzeganiu są zawarte różne niejasne składniki, które sprawiają, że coś od razu rozumiemy i pomijamy, podczas gdy maszyna cierpliwie powtarza swoje iteracje na "nieważnych" dla nas obiektach.

Prowadzono też inne testy i badania usiłujące "zrozumieć" maszynę. Jason Yosinski zbudował narzędzie działające jak sonda wetknięta w mózg, celująca w dowolny sztuczny neuron i szukająca obrazu, który aktywuje go najsilniej. W tym ostatnim eksperymencie z "podglądania" sieci na gorącym uczynku wychodziły abstrakcyjne obrazy, które czynią procesy zachodzące w systemie jeszcze bardziej tajemniczymi.

Dla wielu naukowców takie badania są jednak nieporozumieniem, gdyż do zrozumienia systemu, do rozpoznawania wzorców wyższego rzędu i mechanizmów podejmowania skomplikowanych decyzji trzeba, ich zdaniem, poznać całość interakcji obliczeniowych wewnątrz głębokiej sieci neuronowej. To gigantyczny labirynt funkcji matematycznych i zmiennych. W tej chwili dla nas - nie do ogarnięcia.

Komputer nie przyjął do pracy? Dlaczego?

Dlaczego zrozumienie mechanizmów podejmowania decyzji przez zaawansowane systemy AI jest takie ważne? Już teraz modele matematyczne są wykorzystywane do określania, który z więźniów może iść na zwolnienie warunkowe, komu można udzielić kredytu, lub kto dostaje pracę. Każdy zainteresowany chciałby wiedzieć, dlaczego podjęta została taka a nie inna decyzja, jakie są jej podstawy i mechanizm.

- Ten problem jest istotny już teraz i będzie o wiele ważniejszy w przyszłości - przyznawał w kwietniu 2017 r. na łamach "MIT Technology Review" Tommi Jaakkola, profesor MIT, który pracuje nad aplikacjami nauki maszynowej. - Niezależnie od tego, czy mowa o decyzji inwestycyjnej, medycznej, czy militarnej, nie chcemy polegać wyłącznie na metodzie "czarnej skrzynki".

Istnieje już nawet stanowisko prawno-polityczne, mówiące o tym, że możliwość dokładnego zbadania i poznania mechanizmu podejmowania decyzji przez systemy sztucznej inteligencji jest fundamentalnym prawem człowieka.

Unia Europejska od 2018 r. pracuje nad wymogami udzielania przez firmy swoim klientom wyjaśnień dotyczących decyzji podejmowanych przez systemy automatyczne. Okazuje się, że bywa to niemożliwe nawet w przypadku systemów, które z pozoru wydają się stosunkowo proste, takich jak aplikacje i strony internetowe, wykorzystujących głęboką naukę do serwowania reklam lub polecania piosenek.

Komputery, które uruchamiają te usługi, same się zaprogramowały i zrobiły to w sposób, którego nie jesteśmy w stanie zrozumieć... Nawet inżynierowie budujący takie aplikacje nie potrafią w pełni wyjaśnić, jak to działa.