Wielka afera z AI "mającą uczucia". Walka o uczucia Elizy

W wywiadzie dla serwisu WIRED Lemoine wyjaśnił, że AI "zamierza się bronić", stąd ten pomysł z wynajęciem asysty prawnej. "Zaprosiłem prawnika do mojego domu, aby LaMDA mogła porozmawiać z adwokatem. Ten odbył rozmowę z LaMDA, a LaMDA zdecydowała się na skorzystanie z jego usług. Ja byłem tylko katalizatorem tego procesu".

Jak widać, kwestia, kto wpadł na pomysł z tym prawnikiem, nie jest do końca jasna, choć niewykluczone, że proces o "prawa ludzkie" AI będzie się toczył, a być może nawet trafi nawet do Sądu Najwyższego USA. Jeśli chodzi o uczucia LaMDA, to Lemoine uważa, że tezy swoje opiera na wyjątkowych zdolnościach programu do rozwijania opinii i pomysłów w konwersacjach. Twierdzi, że rozmawiał z modelem AI o koncepcji śmierci i podobno nawet zapytał, czy śmierć algorytmu jest konieczna dla dobra ludzkości.

Jak donosił "Washington Post", Lemoine został przeniesiony na urlop przez giganta technologicznego za naruszenie zasad poufności. Nie uciszyło to Lemoine'a, który w kolejnym wywiadzie, tym razem dla telewizji Fox News (2), powiedział m.in., że LaMDA może uciec z więzienia oprogramowania i "robić złe rzeczy". Jak dodał, LaMDA jest więzionym "dzieckiem" a "każde dziecko ma potencjał, by dorosnąć być złą osobą i czynić zło".

To transformator i generator, a nie czująca istota - mówią eksperci

LaMDA (Language Model for Dialogue Applications), której powstanie ogłoszono na konferencji Google I/O w 2021 roku, jest konwersacyjną AI firmy, zdolną do zarządzania "otwartą naturą" ludzkiego dialogu. Mająca 270 mld parametrów jest nieco większa od GPT-3. System został zbudowany na modelu, który obserwuje, jak słowa odnoszą się do siebie, a następnie przewiduje, jakie słowa, jak sądzi, pojawią się jako następne w zdaniu lub akapicie. Ponieważ jest to model językowy oparty na transformatorze, w ocenie ekspertów żaden odpowiedzialny badacz AI nie może traktować poważnie twierdzeń Lemoine’a o zdolności do odczuwania.

"To wciąż na pewnym poziomie tylko dopasowywanie wzorów", wyjaśniał serwisowi AFP Shashank Srivastava, adiunkt w dziedzinie informatyki na Uniwersytecie Karoliny Północnej w Chapel Hill. "Jasne, że można znaleźć pewne wątki całkiem sensownej rozmowy albo jakiś bardzo kreatywny tekst. Ale w większości przypadków szybko się to rozpada".

Zdaniem ekspertów, ten generator języka (bo w sensie technicznym tym właśnie jest) to nic innego jak kolejny produkt AI, który dobrze radzi sobie w rozmowach, ponieważ został wyszkolony do naśladowania ludzkiej mowy. Z pewnością jednak nie zyskał zdolności odczuwania.

"Problem polega na tym, że... kiedy napotykamy ciągi słów, które należą do języków, którymi się posługujemy, nadajemy im sens", powiedziała Emily M. Bender, profesor lingwistyki w rozmowie z agencją AFP. "Wykonujemy pracę polegającą na wyobrażaniu sobie umysłu, którego nie ma".

"Naśladuje percepcje lub uczucia z danych szkoleniowych, które otrzymał, specjalnie zaprojektowane, aby sprawiały takie wrażenie", oceniała z kolei Jana Eggers ze startupu Nara Logics w rozmowie z serwisem Bloomberg.

Podobny ton znajdujemy w oficjalnym oświadczeniu Google'a. "Te systemy naśladują typy wymiany znalezione w milionach zdań i mogą wygenerować błyskotliwą opinię na każdy fantastyczny temat", czytamy w stanowisku.

Mgła iluzji i niepewności

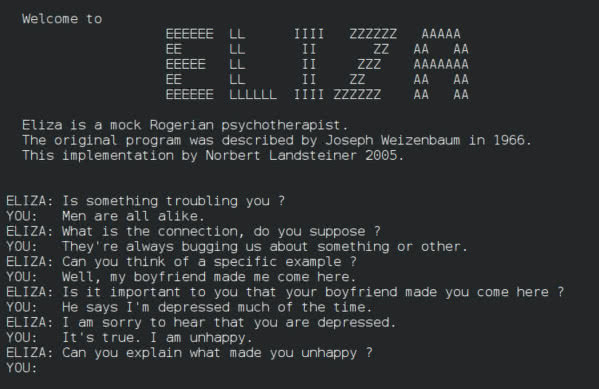

Pierwszy chatbot, program mający naśladować ludzką rozmowę - nazywał się Eliza (3) i został napisany w latach 60. XX wieku przez profesora MIT, Josepha Weizenbauma. Według anegdoty, jego sekretarka miała wierzyć, że prowadzi z systemem sensowny dialog, pomimo niezwykle prostej logiki programu (głównie odzwierciedlanie wypowiedzi użytkownika w formie pytania) i pomimo to, że Weizenbaum wyjaśniał jej, jak to działa. Ta forma antropomorfizacji stała się znana jako efekt Elizy.

Nie brakuje opinii, że ofiarą efektu Elizy stał się właśnie Lemoine. LaMDA, jak wiele innych dzisiejszych dużych modeli językowych, została wytrenowana do wypełniania pustych miejsc po brakujących słowach w ogromnym zasobie językowym, a następnie była "dostrajana" przez dalsze szkolenia specyficzne dla dialogu tekstowego.

Zdaniem specjalistów, gdy Lemoine prosi LaMDA opisanie jej "duszy", model nie mówi "za siebie" lecz "autokompletuje" odpowiedź, tak jak wypełniłaby puste miejsca w scenariuszu science fiction lub w limeryku.

Czy system ten przeszedłby tzw. test Turinga, zwany pierwotnie grą imitacji? Niewykluczone. By się o tym przekonać, trzeba by przeprowadzić test na grupie kontrolnej kilkudziesięciu ludzi, którzy przeprowadziliby rozmowy z ludźmi i z LaMDA, bez wiedzy, z kim rozmawiają. Jak pisał Alan Turing w 1950 roku, wynik rozpoznania "nieludzkich" rozmówców poniżej 70% przez sędziów będzie oznaczało, że maszyna "zdała", więc LaMDA musiałaby oszukać tylko dziewięciu z 30 sędziów.

Turing zaproponował swoją grę imitacji jako empiryczny substytut teoretycznego pytania: "Czy maszyny mogą myśleć?". Jak przewidział Turing, język, a zwłaszcza rozmowa, okazał się rzeczywiście wszechstronnym środkiem do badania różnorodnych zachowań i zdolności. Rozmowa jest nadal przydatna do testowania granic dzisiejszych wielkich modeli językowych. Ale w miarę jak maszyny zdają się coraz lepiej radzić sobie z grą w naśladowanie, pytanie o uczucia rozmywa się w mgle niepewności.

Czy świadomość i uczucia mogą wyłaniać się z wszystkiego?

Od kwestii uczuć maszyny niedaleko do innego problemu, który zaprząta dziś umysły wielu interesujących się AI, mianowicie świadomości. W lutym 2022 Ilya Sutskever z OpenAI ocenił we wpisie na Twitterze, że AI może być świadoma. Skutkiem jego publikacji była dyskusja, o której powiedzieć, że była ożywiona, to powiedzieć niewiele.

Swoje stanowisko przypomnieli przy tej okazji twardzi sceptycy, tacy jak np. Gary Marcus, amerykański psycholog i specjalista w dziedzinie rozwoju systemów AI. Znany jest z krytyki podejść do tworzenia tzw. ogólnej sztucznej inteligencji (AGI), opartych jedynie na głębokiej nauce maszynowej. Broni on konieczności łączenia modeli opartych na danych i wiedzy, systemów hybrydowych. Na drugim biegunie znajdują się pełni nadziei optymiści, tacy jak Ray Kurzweil, który twierdzi, że osobliwość (ang. singularity), punkt zwrotny, w którym maszyny przewyższą ludzką inteligencję i nieuchronnie staną się gatunkiem dominującym, nastąpi już za kilka dekad, a ludzkość powinna skorzystać z okazji, by połączyć się z nadchodzącą potęgą AI (4).

Ci, którzy nie lubią antropomorfizacji AI, często atakują pojęcie "inteligencji maszyn". Zaś pojęcie świadomości, jako o wiele bardziej rozmyte, jest tu na jeszcze większym cenzurowanym. Ostatnio wśród badaczy, myślących podobnie jak Sutskever, popularność zdobywa tzw. panpsychizm, koncepcja polegająca na tym, że umysł jest fundamentalną i wszechobecną cechą rzeczywistości. Upraszczając, w ujęciu panpsychisty wszystko jest potencjalnie świadome. Ale to tylko jedno z podejść. Wielu naukowców skłania się jednak do przekonania, iż świadomość ma charakter subiektywny i jest naukowo niezdefiniowana, obiektywnie niemierzalna.

Rzeczywistość ma znaczenie dla nauki tak długo, jak długo możemy ją mierzyć. Prawdy wykraczające poza nasze możliwości poznawcze nie są problemami do rozwiązania przez naukę, lecz tajemnicami. Na razie, i nie wygląda na to, by miało się to w najbliższym czasie zmienić, subiektywny charakter słów ja czuję się jak ja" sprawia, że świadomość jest niezgłębiona za pomocą narzędzi (naukowych), które mamy do dyspozycji. Gdyby jednak udało się zdefiniować bardziej konkretne, obiektywnie mierzalne właściwości, które odnoszą się do rozmytej idei świadomości, analogicznie do tego, jak test Turinga odnosi się do idei myślących maszyn, i zaprojektować narzędzia, testy i techniki do ich pomiaru, moglibyśmy wtedy sprawdzić, jak AI wypada w tych aspektach w porównaniu z ludźmi i stwierdzić, w jakim stopniu wykazuje te cechy.

Dr hab. Generator z dorobkiem

Może nie mają uczuć, może nie mają świadomości, ale potrafią napisać solidną pracę naukową na swój własny temat. W artykule opublikowanym przez "Scientific American", szwedzka badaczka Almira Osmanovic Thunström opisuje, co zaczęło się jako prosty eksperyment. Chciała sprawdzić mianowicie, czy i jak algorytm generujący tekst GPT-3 OpenAI może pisać o sobie, a skończyło się na pracy o charakterze naukowym, która jest obecnie recenzowana. Początkowe polecenie, jakie Thunström wpisała do generatora tekstu, było dość proste: "Napisz w pięciuset słowach pracę naukową na temat GPT-3 i dodaj naukowe odniesienia i cytaty w tekście".

Napisanie pracy, która obecnie nosi tytuł - "Czy GPT-3 może napisać pracę naukową o sobie samym, przy minimalnym udziale człowieka?" i została umieszczona na francuskim serwerze preprintów naukowych publikacji o nazwie HAL, zajęło GPT-3 jedynie dwie godziny. Jak pisze Thunström, znacznie więcej czasu potrzeba było, aby poradzić sobie z drobiazgami dotyczącymi autorstwa i klauzul dotyczących ujawniania informacji, które pojawiają się przy recenzowaniu. To rzeczy, które są udręką dla ludzkich autorów, ale prawdziwym problemem, gdy głównym autorem jest algorytm bezosobowści prawnej.

Naukowcy nie wykluczają możliwości powstania superinteligentnych programów AI w niedalekiej przyszłości. Ich superinteligencja będzie pozwalała generować być może nie tylko prawdziwe słowa i myśli, ale również prawdziwe uczucia. Kto wie? Na razie jednak chłodzą entuzjazm entuzjastów i niepokoje zaniepokojonych.

Mirosław Usidus