Żyjąc coraz głębiej w cyberprzestrzeni

Według futurysty Raya Kurzweila, już w pierwszej połowie lat 20. będziemy rutynowo pracować i bawić się w wirtualnych środowiskach, typu wizualne "pełne zanurzenie". W latach 30. zamieni się to natomiast w zanurzenie obejmujące wszystkie zmysły, czyli także dotyk i smak.

Zabierz kawę na Facebooka

Facebook buduje wielką infrastrukturę, której celem jest "wessanie" całego naszego życia do cyfrowego świata. Jako przykład tego dążenia podawana jest platforma Parse. W marcu 2015 r. odbyła się konferencja F8, podczas której Facebook ujawnił, jakie ma plany związane z tą przejętą dwa lata temu firmą (1). Dostarczyć ma ona zestaw narzędzi programistycznych z myślą o urządzeniach z sektora Internetu rzeczy (IoT), a więc o gadżetach podłączonych do sieci i komunikujących się między sobą.

Platforma połączyć ma ze sobą inteligentne urządzenia domowe z gadżetami noszonymi (wearables) i wszystkim dookoła.

Dzięki temu narzędziu będzie można np. zaprojektować inteligentny system zraszania roślin, sterowany przez aplikację mobilną, albo termostat lub też kamerę bezpieczeństwa zapisującą zdjęcia co minutę, a wszystko to kontrolowane byłoby przez aplikacje webowe. Facebook zamierza udostępnić SDK Parse for IoT na trzech platformach: Arduino Yún, Linux (na Raspberry Pi) oraz Real Time Operating Systems (RTOS).

Co to w praktyce oznacza? To, że w łatwy sposób - przez wpisanie kilku linijek kodu - proste urządzenia z naszego otoczenia mogą stać się elementami cyfrowej rzeczywistości i wejść do Internetu rzeczy. Jest to też metoda tworzenia wirtualnej rzeczywistości (VR), gdyż Parse może służyć również do zarządzania rozmaitymi urządzeniami wizualnymi, kamerami, radarami, za pomocą których możemy wirtualnie eksplorować oddalone lub trudno dostępne miejsca.

Zdaniem wielu ekspertów, w podobnym kierunku ewoluować będą także inne platformy, w tym Oculus Rift. Zamiast ograniczania się do świata gry czy filmu, połączone z siecią gogle wciągać mogą do wirtualnej rzeczywistości świat, który nas otacza. To nie będzie już tylko kreacja twórców gry. To będzie gra, którą można toczyć w wybranym przez użytkownika środowisku. Nie chodzi o augmented reality (AR), nawet tak wyrafinowane jak wytwarzane przez HoloLens Microsoftu czy Magic Leap Google'a (2). Byłaby to bowiem nie tyle rozszerzona rzeczywistość, ile raczej wirtualność doprawiana rzeczywistością. To świat, w którym filiżankę prawdziwej kawy można zabrać na Facebooka i tam ją wypić.

Facebook przyznał, że pracuje nad aplikacjami wykorzystującymi wirtualną rzeczywistość, a zakup Oculusa to część większego planu. O planach firmy opowiedział podczas konferencji Code/Media Chris Cox, szef produktu platformy. Według jego słów, VR będzie kolejnym wzbogaceniem oferty popularnego serwisu społecznościowego, w którym obecnie można udostępniać takie zasoby multimedialne, jak zdjęcia i filmy. Cox wyjaśnił, że VR stanie się logiczną kontynuacją rozwoju doświadczenia użytkownika serwisu, który może udostępniać "myśli, zdjęcia i filmy a wraz z VR będzie mógł przesłać pełniejszy obraz."

Wirtualność znana i nieznana

Na początku lat 80. XX wieku William Gibson (3) w powieści "Neuromancer" jako pierwszy użył słowa cyberprzestrzeń. Opisywał ją jako zbiorową halucynację, a także rodzaj interfejsu. Operator komputera podłączany był do niego poprzez łącze neuronowe. Dzięki temu mógł zostać przeniesiony do wytworzonej przez komputer sztucznej przestrzeni, w której zawarte w komputerze dane prezentowano w formie wizualnej.

Przyjrzyjmy się przez chwilę temu, jak wyobrażali sobie rzeczywistość wirtualną wizjonerzy. Można to sprowadzić do trzech sposobów wchodzenia do generowanej sztucznie rzeczywistości. Pierwszy z nich, występujący jak dotąd tylko w literaturze fantastycznej (choćby we wspomnianym wyżej "Neuromancerze"), oznacza całkowite zanurzenie się w cyberprzestrzeni. Osiąga się to zwykle poprzez bezpośrednią stymulację mózgu. Tylko wtedy możliwe jest dostarczenie człowiekowi dowolnego zestawu bodźców, przy równoczesnym pozbawieniu go bodźców płynących z jego realnego otoczenia.

Dopiero to pozwoliłoby na pełne zanurzenie się w rzeczywistości wirtualnej. Takie rozwiązania jeszcze nie istnieją, lecz praca nad nimi trwa. Interfejsy mózgowe to obecnie jedna z prężniejszych gałęzi badań naukowych.

Drugi sposób przenoszenia się do VR, w dość jeszcze niedoskonałej, ale szybko rozwijającej się formie, dostępny jest już dziś. Dostarczamy odpowiednich bodźców za pośrednictwem realnego ciała. Obraz wysyłany jest do oczu przez dwa ekrany ukryte w hełmie czy goglach.

Opór stawiany przez przedmioty może być symulowany przez odpowiednie urządzenia ukryte w rękawicy lub też w całym kostiumie. Przy tym rozwiązaniu sztucznie wytworzone bodźce niejako przesłaniają te, których dostarcza realny świat. Jednak cały czas zachowujemy świadomość, że to co widzimy, dotykamy, wąchamy i nawet smakujemy, to iluzje wygenerowane komputerowo. M.in. dlatego np. w grach jesteśmy znacznie bardziej skłonni do ryzyka, niż gdyby to była rzeczywistość.

Ostatni i najpłytszy sposób wchodzenia do cyberprzestrzeni jest dziś właściwie codziennością.

To Google, Facebook, Instagram, Twitter i wszelkie inne zakątki internetowej cyberprzestrzeni. Mogą to też być wszelkiego rodzaju gry, w które gramy za pomocą komputera i konsoli. Pochłania nas to często bardzo mocno, ale jednak zazwyczaj stymulacja kończy się na obrazie i dźwięku. Nie jesteśmy "otoczeni" światem gry, nie wykonujemy też ruchów, które naśladują rzeczywistość. Dotyk, smak i węch nie są pobudzane.

Sieć okazuje się być jednak dla człowieka nowym, naturalnym środowiskiem. Otoczeniem, w które chciałby się wtopić, stać się jego częścią. Marzenia transhumanistów, takich jak Kurzweil, nie wydają się obecnie już totalnymi mrzonkami, za jakie je uważano jeszcze np. dwie dekady temu. Człowiek żyje i zanurza się w technologii w każdym już prawie aspekcie życia, a połączenie z siecią towarzyszy nam niekiedy 24 godziny na dobę. Wizja belgijskiego myśliciela, Henriego Van Liera, czyli świat maszyn dialektycznych, które oplatają wszystko coraz gęstszą siecią komunikacyjną, realizuje się na naszych oczach. Jednym z kroków na tej drodze jest istniejąca już globalna sieć komputerowa - Internet.

Ciekawe, że cała niematerialna część ludzkiej kultury coraz bardziej się wirtualizuje, odrywa się od fizycznej rzeczywistości. Przykładem mogą być media, których przekazy odrywają się od fizycznego podłoża. Istotna jest treść, a nośniki takie jak papier, radio czy telewizor stają się tylko możliwymi, ale niekoniecznymi fizycznie, kanałami.

Ogarnąć wszystkie zmysły

Gry wideo potrafią wciągać nawet bez najnowocześniejszego osprzętu VR. Wkrótce gracze będą jednak mogli znacznie głębiej wejść w świat wirtualnej rozgrywki. Wszystko za sprawą urządzeń takich jak Oculus Rift. Kolejnym krokiem są urządzenia przenoszące nasze naturalne ruchy do wirtualnego świata. Okazuje się, że i takie rozwiązanie jest na wyciągnięcie ręki. Wszystko za sprawą WizDish, kontrolera, który transmituje ruchy naszych nóg do wirtualnego świata. Postać porusza się w nim tylko wtedy, gdy my - w specjalnym obuwiu na nogach - poruszamy się po WizDish (4).

Wydaje się, że nieprzypadkowo Microsoft najpierw kupił "Minecrafta" za 2,5 mld, a potem zaprezentował okulary HoloLens. Ktoś, kto zna tę grę i wie, jak działają gogle AR firmy z Redmond, od razu zrozumie niezwykły potencjał takiego połączenia (5). Oto rzeczywistość plus świat "Minecrafta". Gra w "Minecrafta" z elementami rzeczywistości. "Minecraft" plus inne gry, plus znajomi z rzeczywistości. Możliwości niemal nie mają końca.

Do tego dodajmy dodatkowe bodźce, aby świat wirtualny upodobnić jeszcze bardziej do rzeczywistości. Naukowcy z brytyjskiego uniwersytetu w Bristolu opracowali technologię "dotyku w powietrzu", która pozwala na lekkie wyczuwanie pod palcami kształtów przedmiotów będących trójwymiarowymi projekcjami.

Owe wirtualne obiekty mają sprawiać wrażenie, że istnieją i są pod opuszkami palców, a wszystko dzięki skupianiu ultradźwięków (6). Opis technologii został opublikowany w specjalistycznym czasopiśmie "ACM Transactions on Graphics". Wynika z niego, że wrażenia dotykowe wokół wyświetlanego w 3D obiektu tworzone są przez tysiące drobnych głośników, w które wyposażony jest układ projekcji. System wykrywa położenie dłoni i reaguje odpowiednim impulsem ultradźwiękowym, odczuwalnym jako czucie powierzchni obiektu. Technologia eliminuje całkowicie potrzebę fizycznego kontaktu z urządzeniem. Jej twórcy pracują ponadto nad wprowadzeniem możliwości odczuwania zmian kształtu i położenia wirtualnego obiektu.

Znane technologie i prototypy "wirtualnego dotyku" sprowadzają się zwykle do generowania wibracji lub innych prostych sygnałów wyczuwalnych pod palcami. Zestaw Dexmo (7), według opisów, dostarcza jednak więcej - wrażenia oporu dotykanej powierzchni. Użytkownik ma więc "naprawdę" czuć dotyk realnego przedmiotu. Opór stawiany palcom jest rzeczywisty, gdyż w egzoszkielet wbudowano wyrafinowany system hamulców, zatrzymujących je w odpowiednim momencie. W efekcie dzięki oprogramowaniu i hamulcom palce zatrzymują się każdy w nieco innym punkcie wirtualnego przedmiotu, zupełnie tak samo, jak gdyby spoczęły na powierzchni prawdziwego przedmiotu, np. piłki.

Z kolei grupa studentów z Uniwersytetu Rice zaprojektowała niedawno rękawicę pozwalającą na "dotykanie" i "łapanie" obiektów w wirtualnej rzeczywistości, czyli w powietrzu. Rękawica Hands Omni (8) pozwoli na wyczuwanie kształtów i rozmiarów "dotykanych" w wirtualnym świecie przedmiotów.

Dzięki sprzężeniu świata generowanego komputerowo, który widzi osoba mająca odpowiedni sprzęt na oczach, z wrażeniami generowanymi w rękawicach, powstać ma zbliżony do rzeczywistości ekwiwalent dotyku. W sensie fizycznym za wrażenia te odpowiadać mają napełniane powietrzem poduszki w palcach rękawicy Hands Omni. Stopień napełnienia odpowiada za odczucia twardości generowanych obiektów. Młody zespół konstruktorów współpracuje z twórcami bieżni Virtuix Omni, która służy do "poruszania" się po wirtualnej rzeczywistości. Mechanizm urządzenia działa na platformie Arduino.

Uzupełnianie wirtualnych wrażeń zmysłowych trwa w najlepsze, Oto zespół pod kierownictwem Haruki Matsukury z Tokyo University of Agriculture and Technology opracował technologię generowania zapachów. Aromaty emitowane przez widoczne na ekranie kwiaty czy kubek kawy pochodzą z kapsułek wypełnionych zapachowym żelem, które parują i są za pomocą miniwentylatorków nadmuchiwane na wyświetlacz.

Strumień pachnącego powietrza jest modyfikowany tak, aby zapach "wydzielał się" z tych części ekranu, w których widoczny jest aromatyczny przedmiot. Na razie ograniczenie rozwiązania stanowi możliwość emisji tylko jednego zapachu w danej chwili. Jednak, zdaniem japońskich konstruktorów, wkrótce możliwe będzie zmienianie w urządzeniu kapsułek aromatycznych.

Przekraczanie barier

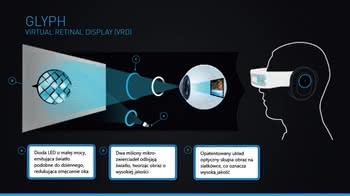

Projektanci idą dalej. Odbiór obrazu znacznie uprościłoby i udoskonaliło obejście konieczności stosowania drogiej i nie zawsze doskonałej optyki, a nawet niedoskonałości ludzkich oczu. Pojawił się więc projekt, dzięki któremu można zrozumieć różnicę znaczeniową między słowami "oglądać" a "widzieć". Zdobywające obecnie popularność gogle do wirtualnej rzeczywistości Oculus Rift pozwalają oglądać obrazy. Tymczasem wynalazek o nazwie Glyph, który zelektryzował nie tylko platformę crowdfoundingową Kickstarter, pozwoli po prostu widzieć, ponieważ obraz z niego ma wyświetlać się od razu na siatkówce - czyli, jak rozumiemy, częściowo zastępować oko. Nieuchronnie nasuwają się skojarzenia ze wspominanym "Neuromancerem", czyli odbiorem obrazu bezpośrednio przez układ nerwowy.

Glyph pomyślany jest nie tylko jako sprzęt do gier. Ma działać ze smartfonami i elektroniką użytkową, np. odtwarzaczami wideo. Z myślą o graczach przygotowano w nim mechanizm śledzący ruchy głowy, wbudowano żyroskop i akcelerometr, czyli "bioniczny" zestaw VR. Firma Avegant, która opracowała Glypha, twierdzi, że obraz rzutowany od razu na dno oka będzie ostrzejszy i wyraźniejszy. Mimo to wypada jednak poczekać na opinie lekarzy, okulistów i neurologów - co oni o takiej technice myślą.

Dawniej mawiało się m.in. o zanurzaniu się nie w wirtualnym świecie, ale np. w książkach. Okazuje się, że trwają prace nad technologią, której zadaniem byłoby przetwarzanie tekstów na obrazy 3D.

Do tego właśnie zmierza projekt MUSE (Machine Understanding for interactive StorytElling), który określa się jako translator tekstu na wirtualną rzeczywistość. Jak tłumaczyła w mediach prof. dr Marie-Francine Moens z Leuven, koordynatorka projektu, zamysł polega na przekładzie działań, podmiotów i obiektów rozpoznanych w tekście na efekty wizualne. Opracowano zaawansowane komponenty do przetwarzania języka semantycznego tekstów. Obejmują rozpoznawanie ról semantycznych w zdaniach (tj. "kto", "co robi", "gdzie", "kiedy" i "jak"), relacji przestrzennych między obiektami lub osobami (gdzie są zlokalizowane) oraz chronologii zdarzeń.

Rozwiązanie skierowane jest do dzieci. MUSE ma im ułatwiać uczenie się czytania oraz pomagać w rozwoju wnioskowania i ostatecznie w lepszym rozumieniu tekstu. Ponadto ma wspomagać zapamiętywanie i ustalanie wzajemnych powiązań tekstów (np. w czasie zapoznawania się z tekstem poświęconym naukom ścisłym czy biologii).