Za dziesięć lat, czyli nie wiadomo kiedy

Często słychać, że pierwsze prawdziwe i normalnie działające komputery kwantowe pojawią się za około dekadę. Jednak, jak zauważył w jednym z artykułów, Linley Gwennap, główny analityk firmy Linley Group: "Kiedy ludzie mówią, że komputer kwantowy pojawi się za dziesięć lat, to znaczy, że nie wiedzą, kiedy to się stanie".

Pomimo owej mglistości sytuacji już teraz czuć atmosferę rywalizacji o tzw. kwantową supremację. Zaniepokojona kwantowymi pracami i sukcesami Chińczyków amerykańska administracja w grudniu ubiegłego roku przyjęła "National Quantum Initiative Act" (1). Dokument zapewniać ma federalne wsparcie dla badań, rozwoju, demonstracji i zastosowania kwantowej informatyki oraz technologii. Przez magiczne dziesięć lat rząd USA przeznaczy miliardy na rzecz budowy kwantowej infrastruktury komputerowej, ekosystemu i pozyskania kadr. Wszyscy główni twórcy komputerów kwantowych - firmy D-Wave, Honeywell, IBM, Intel, IonQ, Microsoft i Rigetti, podobnie jak twórcy algorytmów kwantowych 1QBit i Zapata, przyjęli z zadowoleniem tę Narodową Inicjatywę Kwantową.

Pionierzy z D-WAve

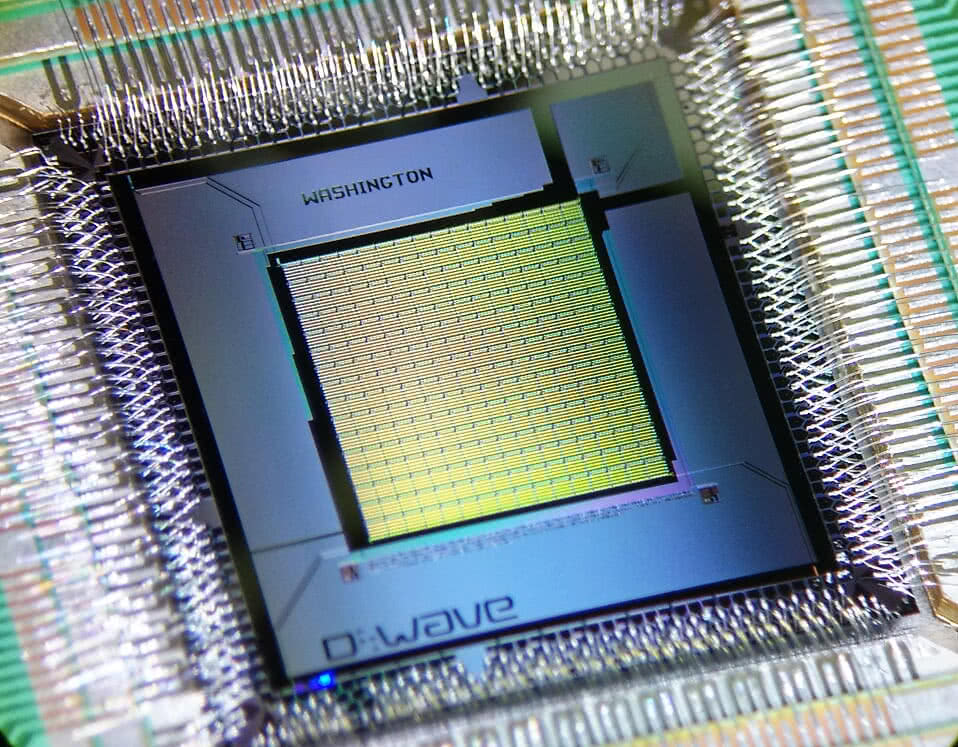

W 2007 r. firma D-Wave Systems zaprezentowała 128-kubitowy układ (2), nazywany pierwszym na świecie komputerem kwantowym. Nie było jednak pewności, czy można go tak nazwać - pokazano bowiem jedynie jego działanie bez szczegółów konstrukcji. W 2009 r. D-Wave Systems stworzyło dla Google’a system nazywany "kwantowym", wyszukujący grafiki. W maju 2011 r. firma Lockheed Martin zakupiła wyprodukowany przez D-Wave Systems kwantowy komputer D-Wave One za 10 mln dolarów, podpisując jednocześnie kilkuletni kontrakt na jego obsługę i opracowanie odpowiednich algorytmów.

W 2012 r. za pomocą tej maszyny zaprezentowano proces znajdowania zwiniętej cząsteczki białka o najniższej energii. Badacze z D-Wave Systems, stosując układy o różnych liczbach kubitów, przeprowadzili szereg obliczeń matematycznych, spośród których część mocno przekraczała możliwości klasycznych komputerów. Na początku 2014 r. John Smolin i Graeme Smith opublikowali jednak pracę, w której argumentowali, że maszyna D-Wave Systems nie jest żadnym komputerem kwantowym. Wkrótce potem w "Nature Physics" przedstawiono wyniki eksperymentów dowodzących, że D-Wave One jednak nim jest…

Kolejny test, z czerwca 2014 r., nie wykazał różnicy pomiędzy klasycznym komputerem a maszyną D-Wave Systems, lecz firma odpowiedziała, że różnica jest zauważalna dopiero dla bardziej zaawansowanych problemów niż te rozwiązywane w teście. Na początku 2017 r. firma przedstawiła maszynę rzekomo składającą się z 2 tys. kubitów, która była 2500 razy szybsza od najszybszych klasycznych algorytmów. I znowu - dwa miesiące później grupa naukowców udowodniła, że porównanie to nie jest trafne. Dla wielu sceptyków systemy D-Wave wciąż nie są żadnymi komputerami kwantowymi, lecz ich symulacjami za pomocą klasycznych metod.

System czwartej generacji D-Wave wykorzystuje annealery (wyżarzacze) kwantowe, zaś stany kubitowe realizowane są przez nadprzewodzące obwody kwantowe (bazujące o tzw. złącza Josephsona). Działają one w środowisku bliskim zera bezwzględnego i mogą pochwalić się systemem 2048-kubitowym. Pod koniec 2018 r. D-Wave wprowadziła na rynek LEAP, czyli własne środowisko aplikacji kwantowej w czasie rzeczywistym (QAE). Oparte na chmurze, zapewnia dostęp w czasie rzeczywistym do obliczeń kwantowych klientom zewnętrznym.

W lutym 2019 r. D-Wave zapowiedziała następną generację procesora kwantowego Pegasus. Ogłoszono, że będzie to "najbardziej rozbudowany komercyjny system kwantowy na świecie", z piętnastoma połączeniami na kubit zamiast sześciu, liczący ponad 5 tys. kubitów i umożliwiający redukcję zakłóceń na nieznanym dotychczas poziomie. Urządzenie ma być dostępne w połowie przyszłego roku.

Kubity, czyli superpozycje plus splątanie

Standardowe procesory komputerowe opierają się na pakietach lub fragmentach informacji, z których każdy reprezentuje pojedynczą odpowiedź "tak" lub "nie". Procesory kwantowe są inne. Nie działają w świecie zero-jedynkowym. Kubit, najmniejsza i niepodzielna jednostka informacji kwantowej jest układem opisanym dwuwymiarową przestrzenią Hilberta. W związku z tym różni się od klasycznego bitu tym, że może znajdować się w dowolnej superpozycji dwóch stanów kwantowych. Jako model fizyczny kubitu najczęściej podaje się przykład cząstki o spinie ½, np. elektronu, lub polaryzację pojedynczego fotonu.

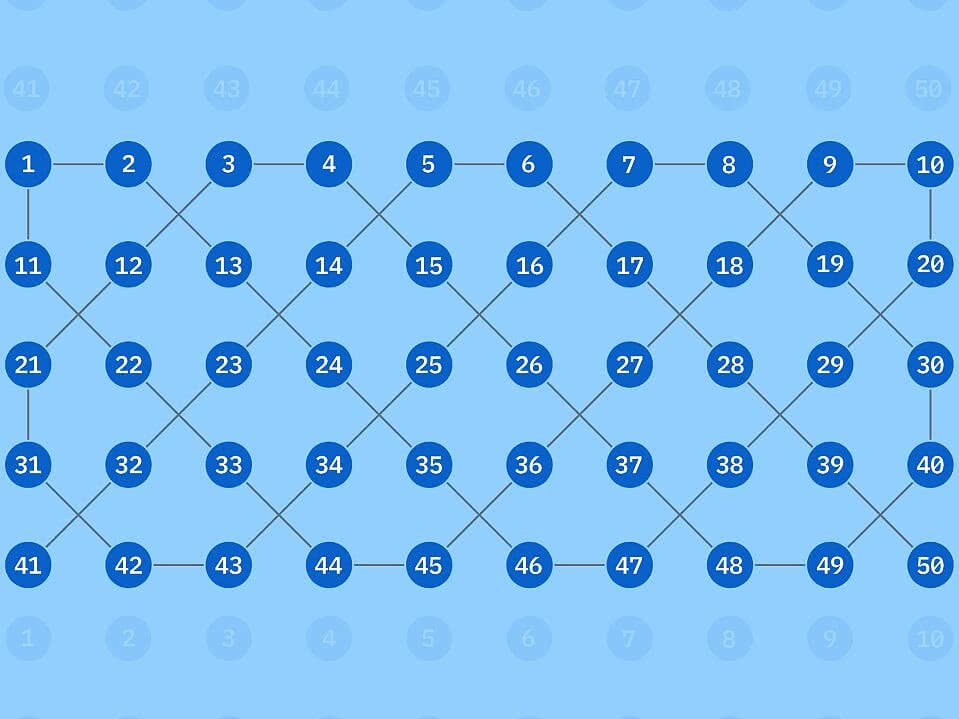

Aby wykorzystać moc kubitów, trzeba je połączyć za pomocą procesu zwanego splątaniem. Po dodaniu każdego dodatkowego kubitu moc obliczeniowa procesora podwaja się, gdyż do liczby splątań dochodzą splątania nowego kubitu ze wszystkimi stanami już obecnymi w procesorze (3). Ale generowanie i łączenie kubitów, a następnie instruowanie ich do wykonywania obliczeń w stanie splątania, nie jest zadaniem łatwym. Pozostają one niezwykle wrażliwe na siły zewnętrzne, które mogą prowadzić do błędów w obliczeniach, a w najgorszym przypadku powodować rozpadanie się uwikłanych kubitów, czyli dekoherencję, która jest prawdziwą zmorą systemów kwantowych. W miarę dodawania dodatkowych kubitów, nasilają się niekorzystne oddziaływania sił zewnętrznych. Jednym ze sposobów radzenia sobie z tym problemem jest włączenie dodatkowych kubitów "kontrolnych", których jedyną funkcją staje się sprawdzanie i korygowanie danych wyjściowych.

Oznacza to jednak, że potężniejsze komputery kwantowe, przydatne w rozwiązywaniu złożonych problemów, takich jak opracowanie sposobu zwijania cząsteczek białka czy modelowanie procesów fizycznych wewnątrz atomów, będą potrzebowały bardzo dużo kubitów. Tom Watson z Uniwersytetu Delft University w Holandii powiedział niedawno BBC News:

- Użyteczne obliczenia kwantowe prawdopodobnie będą wymagały tysięcy i może nawet milionów kubitów, więc procesory kwantowe muszą dawać się skalować.

Krótko mówiąc, jeśli komputery kwantowe mają wystartować, trzeba wymyślić prosty sposób na wyprodukowanie dużych i stabilnych procesorów kubitowych.

Ponieważ kubity są niestabilne, stworzenie systemu z wieloma z nich jest niezwykle trudne. Jeśli więc ostatecznie kubity jako koncepcja obliczeń kwantowych nie sprawdzą się, naukowcy mają alternatywę: bramki kwantowe z "kuditów" (qudits).

Zespół z Uniwersytetu Purdue opublikował w "npj Quantum Information" studium opisujące szczegółowo ich tworzenie. Naukowcy sądzą, że kudity, w przeciwieństwie do kubitów, mogą istnieć w więcej niż dwóch stanach kwantowych - np. 0 i 1 i 2, a dla każdego dodanego stanu zdolność przetwarzania pojedynczego kudita wzrasta. Innymi słowy, do zakodowania i przetworzenia tej samej ilości informacji potrzeba mniej kuditów niż kubitów.

Aby stworzyć bramkę kwantową zawierającą kudit, zespół z Purdue zakodował cztery kudity w dwóch zaplątanych fotonach pod względem częstotliwości i czasu. Zespół wybrał fotony, ponieważ nie są one łatwo zakłócane przez otoczenie, a wykorzystanie wielu domen pozwoliło osiągnąć większe uwikłanie przy użyciu mniejszej liczby fotonów. Gotowa bramka miała moc obliczeniową 20 kubitów, mimo że wymagała użycia tylko czterech kuditów, z dodatkową stabilnością wynikającą z użycia fotonów - co czyni z niej obiecujący system dla przyszłych komputerów kwantowych.

Krzem czy pułapki jonowe

Choć nie każdy podziela tę opinię, wykorzystanie do budowy komputerów kwantowych krzemu wydaje się mieć ogromne zalety, bo technologię krzemu mamy dobrze opanowaną i istnieje już gotowy wielki przemysł z nim związany. Krzem stosuje się w procesorach kwantowych budowanych przez Google’a i IBM, choć chłodzi się go w nich do bardzo niskich temperatur. Nie jest co prawda idealnym materiałem do kwantowych systemów, ale uczeni pracują nad tym.

Jak głosi niedawna publikacja w "Nature", zespół badaczy sięgnął po energię mikrofal do wyrównania dwóch cząstek elektronów zawieszonych w krzemie, a następnie wykorzystał je do wykonania zestawu obliczeń testowych. Grupa, w której skład weszli m.in. naukowcy z Uniwersytetu Wisconsin-Madison, "zawiesiła" w strukturze krzemowej pojedyncze kubity elektronowe, których spin został ustalony za pomocą energii mikrofal. W stanie superpozycji elektron wirował jednocześnie wokół dwóch różnych osi. Łączono następnie dwa kubity i programowano je do przeprowadzenia próbnych obliczeń, po czym badacze konfrontowali dane generowane przez ten układ z danymi uzyskiwanymi ze standardowego komputera wykonującego te same obliczenia testowe. Po dopasowaniu danych powstał programowalny dwubitowy kwantowy procesor krzemowy.

Chociaż wskaźnik błędu jest w nim nadal znacznie wyższy niż w tzw. pułapkach jonowych (urządzeniach przechowujących przez jakiś czas cząstki obdarzone ładunkiem - np. jony, elektrony, protony) czy komputerach kwantowych opartych na nadprzewodnikach, takich jak D-Wave, osiągnięcie pozostaje niezwykłe, ponieważ izolowanie kubitów od zewnętrznego szumu jest niezwykle trudne. Specjaliści widzą szanse skalowania i doskonalenia systemu. Zaś wykorzystanie krzemu, z punktu widzenia technologii i ekonomii, ma tu kluczowe znaczenie.

Dla wielu badaczy jednak to nie krzem stanowi przyszłość komputerów kwantowych. W grudniu ub. roku pojawiła się informacja, że do zbudowania najwydajniejszego na świecie komputera kwantowego, przewyższającego D-Wave i systemy IBM-a, inżynierowie amerykańskiej firmy IonQ użyli iterbu.

Powstała maszyna, która jeden atom zamknięty w pułapce jonowej (4) wykorzystuje do zakodowania jednego kubitu danych, a kubity są kontrolowane i mierzone za pomocą specjalnych impulsów laserowych. Komputer ma pamięć, w której da się zapisać 160 kubitów danych. Może też wykonywać obliczenia jednocześnie na 79 kubitach.

Naukowcy z IonQ przeprowadzili standardowy test z tzw. algorytmem Bernsteina-Vaziraniego. Zadaniem maszyny było odgadnięcie liczby z przedziału od 0 do 1023. Klasyczne komputery potrzebują w przypadku 10-bitowej liczby jedenastu prób. Komputerom kwantowym wystarczą dwa podejścia, by ze 100-procentową pewnością zgadnąć wynik. W pierwszym podejściu komputer kwantowy IonQ zgadywał średnio 73% zadanych liczb. Gdy algorytm jest uruchamiany dla każdej liczby pomiędzy 1 a 1023, wskaźnik sukcesu konwencjonalnego komputera wynosi 0,2%, zaś dla IonQ - 79%.

Specjaliści z IonQ reprezentują stanowisko, że układy oparte na pułapkach jonowych przewyższają krzemowe komputery kwantowe, które buduje Google i inni. Stworzona przez nich 79- kubitowa macierz przewyższa kwantowy procesor Bristlecone Google’a o 7 kubitów. Rewelacyjny jest też wynik IonQ, jeśli chodzi o bezbłędność systemu. Według danych twórców maszyny dla jednego kubitu utrzymuje się on na poziomie 99,97%, co oznacza poziom błędu 0,03%, podczas gdy najlepsze wyniki konkurencji wynoszą średnio ok. 0,5%. Dwukubitowy wskaźnik bezbłędności ma dla urządzenia IonQ kształtować się na poziomie 99,3%, podczas gdy u większości konkurentów nie przekracza 95%.

Warto przy okazji dodać, że wg obliczeń badaczy z Google’a supremację kwantową - czyli punkt, w którym komputer kwantowy przewyższy wszystkie inne dostępne maszyny - można uzyskać już za pomocą kwantowego komputera 49-kubitowego, pod warunkiem że poziom błędów na dwukubitowych bramkach będzie niższy od 0,5%. Jednak technika pułapki jonowej w obliczeniach kwantowych nadal ma do pokonania spore przeszkody: powolny czas działania i ogromne rozmiary, a także dokładność i skalowalność technologii.

Twierdza szyfrów w gruzach i inne konsekwencje

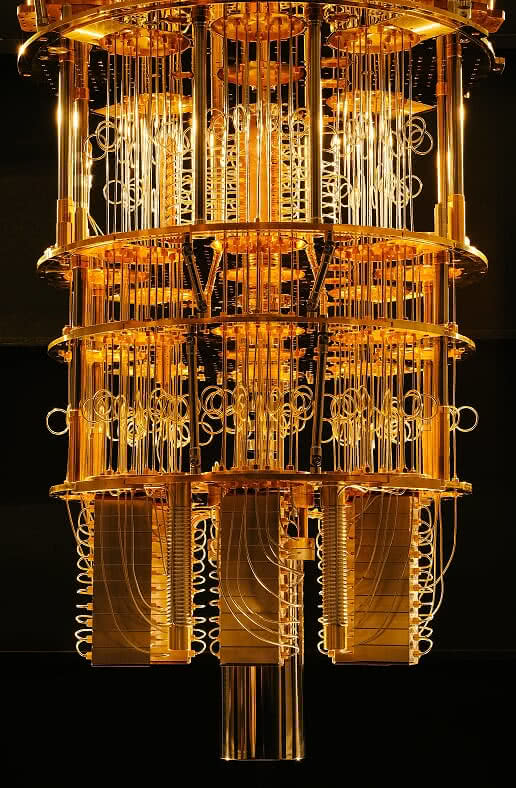

W styczniu 2019 r., na targach CES 2019, prezes IBM Ginni Rometty ogłosiła, że IBM oferuje już zintegrowany system obliczeń kwantowych do użytku komercyjnego. Komputery kwantowe IBM (5) znajdują się fizycznie w Nowym Jorku, stanowiąc część systemu IBM Q System One. Korzystając z sieci Q Network i Q Quantum Computational Center, programiści mogą łatwo stosować oprogramowania Qiskit do kompilowania algorytmów kwantowych. Moc obliczeniowa komputerów kwantowych IBM jest więc dostępna jako usługa w chmurze obliczeniowej, po przystępnej cenie.

Usługi takie świadczy również od pewnego czasu D-Wave, a inni główni gracze (np. Amazon) planują podobne oferty chmur kwantowych. Microsoft poszedł dalej, wprowadzając język programowania Q# (wymawiane jako Q sharp), który może współpracować z Visual Studio i działać na laptopie. Programiści dysponują narzędziem do symulacji algorytmów kwantowych i tworzenia mostu programowego pomiędzy obliczeniami klasycznymi i kwantowymi.

Pytanie jednak - do czego komputery i ich moce obliczeniowe mogą nam się tak naprawdę przydać. W badaniach opublikowanych w październiku ub.r. w czasopiśmie "Science", naukowcy z IBM, Uniwersytetu Waterloo i Politechniki Monachijskiej podjęli próbę przybliżenia typów problemów, dla których komputery kwantowe wydają się najbardziej odpowiednie.

Według opracowania, urządzenia takie będą w stanie rozwiązać złożone problemy algebry liniowej i optymalizacji. Brzmi to ogólnikowo, ale kryć się za tym mogą szanse na łatwiejsze i tańsze poradzenie sobie z kwestiami, które wymagają obecnie wielkich nakładów sił, środków i czasu, a czasem są w ogóle poza naszym zasięgiem.

Użyteczne obliczenia kwantowe zmieniają diametralnie pole kryptografii. Dzięki nim mogłyby zostać szybko złamane kody szyfrujące, a być może zniszczeniu uległaby technologia blockchain. Szyfrowanie RSA wydaje się obecnie niezawodnym i nienaruszalnym zabezpieczeniem, które chroni większość danych i komunikacji na świecie. Wystarczająco potężny komputer kwantowy może jednak z łatwością złamać otwarte szyfrowanie RSA przy użyciu algorytmu Shora.

Jak temu zapobiec? Niektórzy opowiadają się za zwiększeniem długości publicznych kluczy szyfrujących do takich rozmiarów, jakie są konieczne do pokonania deszyfrowania kwantowego. Zdaniem innych należy do zabezpieczenia komunikacji używać samych obliczeń kwantowych. Dzięki kryptografii kwantowej już sam akt przechwycenia danych spowodowałby ich uszkodzenie, po którym osoba zakłócająca cząstkę nie mogłaby uzyskać z nich użytecznych informacji, a odbiorca byłby ostrzeżony o próbie podsłuchu.

Wśród potencjalnych zastosowań obliczeń kwantowych często wymienia się również analizowanie i prognozowanie gospodarcze. Dzięki systemom kwantowym wyrafinowane modele zachowań rynkowych można by rozszerzyć, uwzględniając znacznie więcej zmiennych niż dotąd, i tworząc w efekcie dokładniejsze diagnozy oraz prognozy. Dzięki jednoczesnemu przetwarzaniu tysięcy zmiennych przez komputer kwantowy dałoby się także redukować czas i koszty niezbędne do opracowania nowych leków, rozwiązań transportowych i logistycznych, łańcuchów dostaw, modeli klimatycznych, a także do poradzenia sobie z wieloma innymi problemami o gigantycznej złożoności.

Prawo Nevena

Świat starych komputerów miał swoje prawo Moore’a, tymczasem komputery kwantowe rządzić mają się tzw. prawem Nevena. Swoją nazwę zawdzięcza ono jednemu z najwybitniejszych specjalistów kwantowych Google'a, Hartmuta Nevena (6), który głosi, że postęp dotyczący technologii obliczeń kwantowych dokonuje się obecnie w tempie podwójnie wykładniczym.

Oznacza to, że zamiast podwajać wydajność z kolejnymi iteracjami, jak to miało miejsce w przypadku klasycznych komputerów i prawa Moore'a, technologia kwantowa zwiększa wydajność w znacznie szybszym tempie.

Eksperci przewidują nadejście supremacji kwantowej, co można przekładać nie tylko na wyższość komputerów kwantowych nad jakimikolwiek klasycznymi, ale też inaczej - jako początek ery użytecznych komputerów kwantowych. W ten sposób otworzy się droga do przełomów w chemii, astrofizyce, medycynie, bezpieczeństwie, komunikacji i innych dziedzinach.

Istnieje jednak również przekonanie, że tego rodzaju supremacja nigdy nie nastąpi, przynajmniej w dającej się przewidzieć perspektywie. Łagodniejsza wersja sceptycyzmu głosi, iż komputery kwantowe nigdy nie zastąpią komputerów klasycznych, bo nie jest im to pisane. Nie można zastąpić iPhone'a czy komputera PC maszyną kwantową tak samo, jak nie da się zastąpić butów tenisowych… nuklearnym lotniskowcem. Klasyczne komputery pozwalają grać w gry, sprawdzać pocztę elektroniczną, przeglądać strony internetowe i uruchamiać programy. Komputery kwantowe zaś, w większości przypadków, przeprowadzają symulacje zbyt skomplikowane dla systemów binarnych, działających na bitach komputerowych. Innymi słowy, indywidualni konsumenci nie będą mieli prawie żadnego pożytku z własnego komputera kwantowego, ale już np. NASA czy MIT staną się prawdziwymi beneficjentami wynalazku.

Czas pokaże, czy podejście IBM lub Google'a ma większy sens. Zgodnie z prawem Nevena dzieli nas zaledwie kilka miesięcy od obejrzenia pełnoprawnej demonstracji supremacji kwantowej autorstwa tego czy innego zespołu. I nie jest to już perspektywa "za dziesięć lat, czyli nie wiadomo kiedy".

Mirosław Usidus