Horyzont eksa - i dalej…

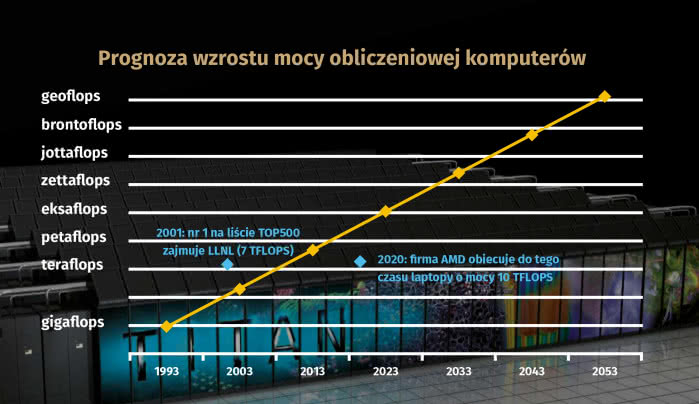

W latach 60. XX wieku najwydajniejsze komputery miały moc wyrażaną w megaflopsach (milionach operacji zmiennoprzecinkowych na sekundę). Pierwszym komputerem o mocy obliczeniowej powyżej 1 GFLOPS (gigaflopsa) był Cray-2, wyprodukowany przez Cray Research w 1985 r. Pierwszym modelem o mocy obliczeniowej powyżej 1 TFLOPS (teraflopsa) był ASCI Red, stworzony przez Intel w roku 1997. Moc 1 PFLOPS (petaflopsa) osiągnął Roadrunner, wyprodukowany przez IBM w 2008 r.

Obecnie obowiązujący rekord obliczeniowej potęgi należy do chińskiego Sunway TaihuLight i wynosi 9 PFLOPS.

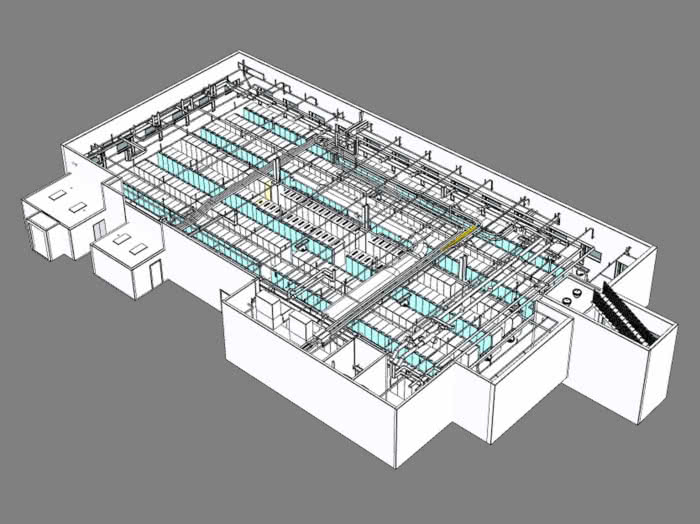

Choć, jak widać, najpotężniejsze maszyny nie wyszły jeszcze poza setkę petaflopsów, coraz częściej mówi się o konstrukcjach systemów eksaskalowych, w których moc liczona ma być w eksaflopsach (EFLOPS), czyli rzędu przekraczającego 1018 operacji na sekundę. Konstrukcje takie są jednak na razie wyłącznie na etapie projektów o różnym stopniu zaawansowania.

Na nowotwór potrzeba eksaskali

Eksaflops, czyli tysiąc petaflopsów, to moc obliczeniowa większa niż ta, którą mają wszystkie superkomputery z czołowej pięćsetki razem wzięte. Naukowcy liczą, że nowa generacja maszyn o takiej sile przyniesie przełom w różnych dziedzinach.

Moc obliczeniowa w eksaskali w połączeniu z szybko rozwijającymi się technikami uczenia maszynowego ma np. pomóc wreszcie złamać kod raka. Ilość danych, którymi lekarze muszą dysponować podczas diagnozowania i leczenia nowotworów, jest tak ogromna, że zwykłym komputerom trudno poradzić sobie z tym problemem. W typowym badaniu z biopsji pojedynczego guza pobiera się ponad 8 mln pomiarów, w trakcie których lekarze analizują zachowanie nowotworu, jego reakcje na leczenie farmakologiczne oraz wpływ na organizm pacjenta. To prawdziwy ocean danych.

- Medycyna precyzyjna jest zdolna dopasowywać terapię do każdego indywidualnego pacjenta w oparciu o jego genotyp, środowisko, historię choroby i wiele innych czynników - mówił Rick Stevens z Laboratorium Argonne, należącego do Departamentu Energii USA (DOE). - Aby to zrobić w przypadku nowotworów, potrzebne są gigantyczne ilości danych, nie tylko na temat pacjenta, ale także guza. Ponadto nowotwór zmienia charakterystykę otaczającej go tkanki.

Łącząc badania nad medycyną z mocą obliczeniową, naukowcy pracują nad systemem sieci neuronowych CANDLE (CANcer Distributed Learning Environment). Ma on umożliwić prognozowanie i opracowywanie planu leczenia dostosowanego do indywidualnych potrzeb każdego pacjenta. Pomoże naukowcom zrozumieć molekularne podstawy kluczowych interakcji białkowych, opracuje prognostyczne modele reakcji na leki i zaproponuje optymalne strategie leczenia. Specjaliści z Argonne uważają, że systemy eksaskalowe będą w stanie uruchomić aplikację CANDLE 50 do 100 razy szybciej niż obecnie znane najpotężniejsze supermaszyny.

Superkomputery eksaskalowe są więc niecierpliwie oczekiwane. Jednak pierwsze wersje pojawią się niekoniecznie w USA. Oczywiście Stany Zjednoczone są uczestnikiem wyścigu o ich stworzenie, a tamtejszy rząd w projekcie znanym jako Aurora współpracuje z AMD, IBM, Intelem i Nvidią, chcąc zdążyć przed zagranicznymi rywalami. Przewiduje się jednak, że nie stanie się to wcześniej niż w 2021 r. Tymczasem już w styczniu 2017 r. chińscy specjaliści poinformowali o stworzeniu eksaskalowego prototypu. W pełni funkcjonujący model jednostki obliczeniowej tego rodzaju - Tianhe-3 - nie będzie jednak prawdopodobnie gotowy przez kolejnych kilka lat.

Chińczycy trzymają się mocno

Faktem jest, że na czele listy najpotężniejszych komputerów na świecie już od 2013 r. figurują konstrukcje chińskie. Przez kilka lat dominował Tianhe-2, a teraz palma pierwszeństwa należy do wspomnianego Sunway TaihuLight. Uważa się, że te dwie najpotężniejsze maszyny Państwa Środka znacznie przewyższają mocą wszystkie dwadzieścia jeden superkomputerów amerykańskiego departamentu energii.

Amerykańscy naukowcy chcą oczywiście odzyskać najwyższe pozycje w rankingu, zajmowane jeszcze pięć lat temu, i pracują nad systemem, który im to umożliwi. W Laboratorium Narodowym Oak Ridge w Tennessee powstaje Summit (2), superkomputer, którego oddanie do użytku planuje się jeszcze w bieżącym roku. Ma przewyższyć mocą Sunway TaihuLight. Będzie służyć do testowania i opracowywania nowych, mocniejszych, lżejszych materiałów, modelowania wnętrza Ziemi na podstawie fal akustycznych, a także wspomagania projektów astrofizycznych, badających początki Wszechświata.

We wspomnianym Argonne National Laboratory naukowcy planują zresztą zbudować wkrótce jeszcze szybsze urządzenie. Znane na razie jako A21, ma sięgnąć mocy 200 petaflopsów.

W wyścigu superkomputerów bierze udział także Japonia. Znajduje się ona wprawdzie ostatnio trochę w cieniu amerykańsko-chińskiej rywalizacji, jednak to właśnie ten kraj planuje jeszcze w tym roku uruchomić system ABCI (AI Bridging Cloud Infrastructure), oferującego wydajność na poziomie 130 petaflopsów. Japończycy mają nadzieję, że taki superkomputer będzie mógł zostać wykorzystany w celu rozwoju AI (sztucznej inteligencji) czy głębokiego uczenia.

Tymczasem Parlament Europejski podjął właśnie decyzję o budowie unijnego superkomputera, za okrągły miliard euro. Ten potwór obliczeniowy miałby rozpocząć swoją pracę dla ośrodków badawczych z naszego kontynentu na przełomie lat 2022 i 2023. Maszyna powstanie w ramach projektu EuroHPC, a jej budowę sfinansują kraje członkowskie - udział w tym projekcie będzie więc miała również Polska. Jego prognozowaną moc określa się ogólnie jako "przed-eksaskalową".

Póki co, według rankingu z 2017 r., z pięciuset najszybszych na świecie superkomputerów w Chinach znajdują się 202 takie maszyny (40%), podczas gdy Ameryka kontroluje ich 144 (29%).

Chiny korzystają również z 35% światowej mocy obliczeniowej, w porównaniu z 30% USA. Kolejnymi krajami, które umieściły najwięcej superkomputerów na liście, są Japonia (35 systemów), Niemcy (20), Francja (18) i Wielka Brytania (15). Warto przy okazji zauważyć, iż niezależnie od kraju pochodzenia, wszystkie z pięciuset najpotężniejszych superkomputerów używają różnych wersji Linuksa...

Same się zaprojektują

Superkomputery są już cenionym narzędziem wspomagającym branże naukową i technologiczną. Umożliwiają badaczom i inżynierom stały postęp (a czasami nawet ogromne skoki naprzód) w takich dziedzinach, jak m.in. biologia, prognozowanie pogody i klimatu, astrofizyka czy broń jądrowa.

Właśnie od ich mocy zależy dalszy rozwój systemów sztucznej inteligencji. Na przestrzeni najbliższych dziesięcioleci wykorzystanie superkomputerów może w znaczącym stopniu zmienić sytuację gospodarczą, wojskową i geopolityczną tych państw, które mają do tego rodzaju ultranowoczesnej infrastruktury dostęp.

Postęp w tej kwestii jest tak szybki, że projektowanie nowych generacji mikroprocesorów stało się już zbyt skomplikowane nawet dla licznych zespołów ludzkich. Z tego powodu zaawansowane oprogramowanie komputerowe i superkomputery coraz częściej odgrywają wiodącą rolę w projektowaniu komputerów, w tym także tych z przedrostkiem "super".

Firmy farmaceutyczne dzięki supermocom obliczeniowym zyskają wkrótce możliwość pełnego przetwarzania ogromnej liczby genomów ludzkich, zwierzęcych i roślinnych, co pomoże w tworzeniu nowych leków i terapii dla różnych chorób.

Kolejnym powodem (tak naprawdę jednym z głównych), dla którego rządy inwestują tak duże środki w rozwój superkomputerów, jest bezpieczeństwo państw i społeczeństw. Bardziej wydajne maszyny pomogą przyszłym dowódcom wojskowym w tworzeniu precyzyjnych strategii walki w każdej sytuacji bojowej, umożliwią projektowanie skuteczniejszych systemów uzbrojenia oraz wesprą organy ścigania i agencje szpiegowskie w identyfikacji z odpowiednim wyprzedzeniem potencjalnych zagrożeń.

Na symulację mózgu nie starcza mocy

Nowe superkomputery mają pomóc zdekodować znany nam od dawna naturalny superkomputer, jakim jest ludzki mózg.

Międzynarodowy zespół naukowców opracował w ostatnim czasie algorytm, który stanowi nowi ważny krok w kierunku symulacji mózgowych połączeń nerwowych. Nowy algorytm NEST, opisany w dokumencie o otwartym dostępie, opublikowanym we "Frontiers in Neuroinformatics", ma umożliwić symulację na superkomputerach 100 miliardów połączonych ze sobą neuronów ludzkiego mózgu. W prace zaangażowani są naukowcy z niemieckiego centrum badawczego Jülich, Norweskiego Uniwersytetu Przyrodniczego, Uniwersytetu w Akwizgranie, japońskiego instytutu RIKEN oraz Królewskiego Instytutu Technologicznego KTH w Sztokholmie.

Już od 2014 r. na superkomputerach RIKEN i JUQUEEN w Centrum Superkomputerowym Jülich w Niemczech prowadzone są zakrojone na szeroką skalę symulacje sieci neuronowych, naśladujące połączenia ok. 1% neuronów w mózgu ludzkim. Dlaczego tylko tyle? Czy superkomputery są w stanie modelować cały mózg?

- Zanim da się przeprowadzić symulację sieci neuronów, trzeba wirtualnie stworzyć neurony i ich połączenia - wyjaśnia Susanne Kunkel ze szwedzkiego KTH.

Podczas symulacji należy najpierw przesłać potencjał czynnościowy neuronu (krótkie impulsy elektryczne) do wszystkich ok. 100 tys. małych komputerów, zwanych węzłami, z których każdy wyposażony jest w szereg procesorów wykonujących rzeczywiste obliczenia. Każdy węzeł sprawdza, które z tych impulsów są istotne dla wirtualnych neuronów istniejących na tym węźle.

Oczywiście ilość pamięci komputerowej potrzebnej procesorom dla tych dodatkowych bitów na neuron zwiększa się wraz z wielkością sieci neuronowej. Wykraczanie poza 1% symulacji całego ludzkiego mózgu (4) wymagałoby sto razy więcej pamięci niż ta, która jest dostępna we wszystkich dzisiejszych superkomputerach. O uzyskaniu symulacji całego mózgu można by więc mówić dopiero w kontekście przyszłych superkomputerów eksaskalowych. To właśnie tam ma pracować algorytm NEST nowej generacji.

1. Sunway TaihuLight - superkomputer o mocy obliczeniowej 93 PFLOPS, uruchomiony w 2016 r. w Wuxi, w Chinach. Od czerwca 2016 r. znajduje się na pierwszym miejscu listy TOP500 - superkomputerów o największej mocy obliczeniowej na świecie.

2. Tianhe-2 (Droga Mleczna-2) - superkomputer o mocy obliczeniowej 33,86 PFLOPS, zbudowany przez NUDT (National University of Defense Technology) w Chinach. Od czerwca 2013 r.

do czerwca 2016 r. był najszybszym superkomputerem świata.

3. Piz Daint - konstrukcja zaprojektowana przez firmę Cray, zainstalowana w Szwajcarskim Narodowym Centrum Superkomputerowym (Swiss National Supercomputing Centre - CSCS). Ostatnio została zmodernizowana - akceleratory Nvidia Tesla K20X zastąpiono nowymi, Tesla P100, co pozwoliło latem 2017 r. zwiększyć moc obliczeniową z 9,8 do 19,6 PFLOPS.

4. Gyoukou - superkomputer opracowany przez firmy ExaScaler i PEZY Computing. Znajduje się w Japońskiej Agencji Nauki i Techniki Morskiej (JAMSTEC) Instytutu Nauk o Ziemi Jokohama; na tym samym piętrze, na którym umieszczono symulator Ziemi. Moc: 19,14 PFLOPS.

5. Titan - superkomputer o mocy obliczeniowej 17,59 PFLOPS, wyprodukowany przez Cray Inc. i uruchomiony w październiku 2012 r. w Oak Ridge National Laboratory w USA. Od listopada 2012 r. do czerwca 2013 r. Titan był najszybszym superkomputerem na świecie. Obecnie jest na miejscu piątym, ale wciąż pozostaje najszybszym superkomputerem w USA.

O prymat w kwantach też walczą

IBM uważa, że w ciągu najbliższych pięciu lat ton zaczną nadawać nie superkomputery oparte na tradycyjnych krzemowych chipach, lecz komputery kwantowe. Zdaniem badaczy tej firmy przemysł dopiero zaczyna odkrywać, w jaki sposób komputery kwantowe mogą być wykorzystywane. Właśnie w ciągu pięciu lat inżynierowie mają odkryć pierwsze główne zastosowania tych maszyn.

Komputery kwantowe używają jednostki obliczeniowej zwanej kubitem. Zwykłe półprzewodniki reprezentują informacje jako seria 1s i 0s, a kubity wykazują właściwości kwantowe i mogą obliczać jednocześnie jako 1 i 0. Oznacza to, że dwa kubity są w stanie w tym samym czasie reprezentować sekwencje 1-0, 1-1, 0-1, 0-0. Moc obliczeniowa rośnie wykładniczo z każdym kubitem, więc teoretycznie komputer kwantowy z zaledwie 50 kubitami mógłby pomieścić więcej mocy obliczeniowej niż najpotężniejsze superkomputery świata.

D-Wave Systems sprzedaje już komputer kwantowy, który ma ponoć 2 tys. kubitów. Jednak egzemplarze D-Wave (5) wzbudzają kontrowersje. Wprawdzie niektórzy badacze znaleźli dla nich dobre zastosowania, ale wciąż nie pokonały one klasycznych komputerów i są użyteczne tylko dla niektórych klas problemów optymalizacji.

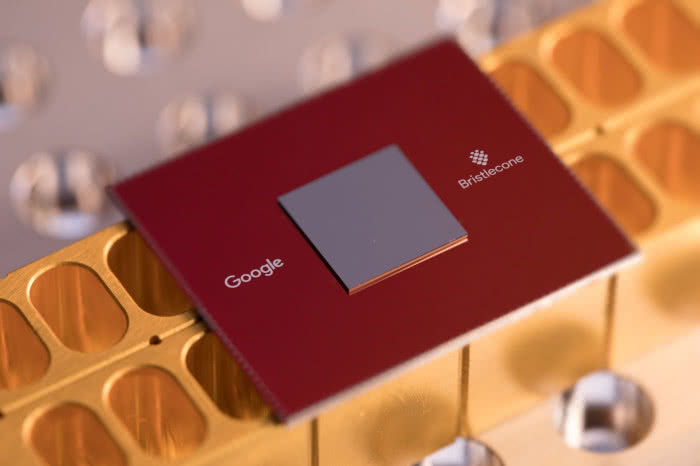

Kilka miesięcy temu Google Quantum AI Lab pokazał nowy, 72-kubitowy procesor kwantowy o nazwie Bristlecone (6). Wkrótce może on osiągnąć "kwantowy prymat", osiągając lepsze wyniki niż klasyczny superkomputer, przynajmniej jeśli chodzi o rozwiązywanie niektórych problemów. Gdy procesor kwantowy zaprezentuje wystarczająco niski poziom błędów w pracy, może okazać się bardziej wydajny niż klasyczny superkomputer, przy dobrze zdefiniowanym problemie informatycznym.

Procesor Google’a był kolejnym w serii, bowiem np. w styczniu Intel ogłosił swój własny, 49-kubitowy układ kwantowy, a wcześniej 50-kubitową wersję zaprezentował IBM. Układ Intela, Loihi, jest nowatorski także z innych względów. To pierwszy "neuromorfi czny" układ scalony - zaprojektowany tak, aby naśladować sposób, w jaki ludzki mózg uczy się i rozumie. Jest "w pełni funkcjonalny" i zostanie udostępniony partnerom badawczym jeszcze w tym roku.

To jednak dopiero początki, bo aby móc się mierzyć z potworami krzemowymi, potrzeba systemów z milionami kubitów. Zespół naukowców z holenderskiego Uniwersytetu Technicznego w Delft ma nadzieję, że drogą do osiągnięcia takich skal jest wykorzystywanie w komputerach kwantowych krzemu, jego członkowie znaleźli bowiem rozwiązanie, jak stosować krzem do produkcji programowalnego procesora kwantowego.

W swoich badaniach, opublikowanych w czasopiśmie "Nature", holenderski zespół sterował spinem pojedynczego elektronu za pomocą energii mikrofalowej. W krzemie elektron obracałby się jednocześnie w górę i w dół, skutecznie utrzymując go na miejscu. Po osiągnięciu tego celu zespół połączył ze sobą dwa elektrony i zaprogramował je do wykonywania algorytmów kwantowych.

Udało się stworzyć na bazie krzemu dwukubitowy procesor kwantowy.

- W przemyśle komputerowym krzem sprawdza się całkiem dobrze, jeśli chodzi o skalowanie przy użyciu stosowanych metod produkcji - wyjaśniał serwisowi BBC dr Tom Watson, jeden z autorów badań. Jeśli Watson i jego zespół zdołają połączyć jeszcze więcej elektronów, może to doprowadzić do powstania procesorów kubitowych, które produkowane seryjnie przybliżyłyby nas o krok do komputerów kwantowych przyszłości.

- Kto zbuduje w pełni funkcjonujący komputer kwantowy, ten będzie rządził światem - powiedział niedawno w jednym z wywiadów Manas Mukherjee z Narodowego Uniwersytetu Singapuru i główny badacz w krajowym Centrum Technologii Kwantowych. Wyścig między największymi firmami technologicznymi a laboratoriami badawczymi koncentruje się obecnie na tzw. supremacji kwantowej, czyli na punkcie, w którym komputer kwantowy jest w stanie wykonywać obliczenia przewyższające wszystko, co mogą zaoferować najbardziej zaawansowane współczesne komputery.

Podane przykłady osiągnięć Google’a, IBM i Intela sugerują, że w tej dziedzinie wyraźnie dominują firmy z USA (a zatem i to państwo). Jednak całkiem niedawno chiński serwis Alibaba Cloud udostępnił platformę chmury obliczeniowej, zasilaną przez procesor 11-kubitowy, co pozwala naukowcom na testowanie nowych algorytmów kwantowych. Oznacza to, że Chiny w dziedzinie kwantowych jednostek obliczeniowych też nie zasypiają gruszek w popiele.

Wysiłki na rzecz zbudowania superkomputerów kwantowych wzbudzają jednak oprócz entuzjazmu dla nowych możliwości, także spore kontrowersje.

Kilka miesięcy temu, podczas Międzynarodowej Konferencji Technologii Kwantowych w Moskwie, Aleksander Lwowski (7) z Rosyjskiego Centrum Kwantowego, zarazem profesor fizyki na Uniwersytecie Calgary w Kanadzie, powiedział, że komputery kwantowe są narzędziem destrukcji, a nie tworzenia.

Co miał na myśli? Przede wszystkim cyfrowe bezpieczeństwo. Obecnie wszystkie poufne informacje cyfrowe przesyłane przez Internet są szyfrowane w celu ochrony prywatności zainteresowanych stron. Widzieliśmy już przypadki, w których hakerzy mogli przechwycić te dane przez złamanie szyfrowania.

Według Lwowskiego pojawienie się komputera kwantowego tylko ułatwi zadanie cyberprzestępcom. Żadne z obecnie znanych szyfrowań nie byłoby w stanie obronić się przed mocą przetwarzania prawdziwego komputera kwantowego.

Dokumentacja medyczna, informacje finansowe, a nawet tajemnice rządów i organizacji wojskowych byłyby dostępne jak na patelni, co oznaczałoby, jak zauważa Lwowski, że nowa technologia mogłaby zagrozić całemu porządkowi światowemu. Inni eksperci uważają, że obawy Rosjanina są o tyle nieuzasadnione, iż stworzenie prawdziwego superkomputera kwantowego pozwoliłoby także zainicjować kryptografię kwantową, uchodzącą za niemożliwą do złamania.

Inne podejście

Oprócz tradycyjnych technik komputerowych i rozwoju systemów kwantowych, w różnych ośrodkach trwają prace nad innymi metodami budowy superkomputerów przyszłości.

Amerykańska agencja DARPA finansuje sześć centrów zajmujących się alternatywnymi rozwiązaniami w zakresie projektowania komputerów. Stosowana w obecnych maszynach architektura, zwana umownie architekturą von Neumanna, ma już siedemdziesiąt lat. Wsparcie dla badaczy uniwersyteckich ze strony podmiotu związanego z obronnością ma na celu wypracowanie inteligentniejszego niż dotąd podejścia do przetwarzania wielkich ilości danych.

Buforyzacja, prefetching i obliczenia równoległe to niektóre przykłady nowych metod, nad którymi pracują wspomniane zespoły. Kolejnym jest ADA (Applications Driving Architectures), która przewiduje uproszczenie rozwoju aplikacji poprzez przekształcenie komponentów procesora i pamięci modułami w tym samym zespole, zamiast zmagania się z kwestiami ich komunikacji na płycie głównej.

W ubiegłym roku zespół badaczy z Wielkiej Brytanii i Rosji z powodzeniem wykazał, że do rozwiązywania złożonych problemów obliczeniowych może być wykorzystywany rodzaj "magicznego pyłu", na który składają się światło i materia - ostatecznie przewyższając "osiągi" nawet najpotężniejszych superkomputerów.

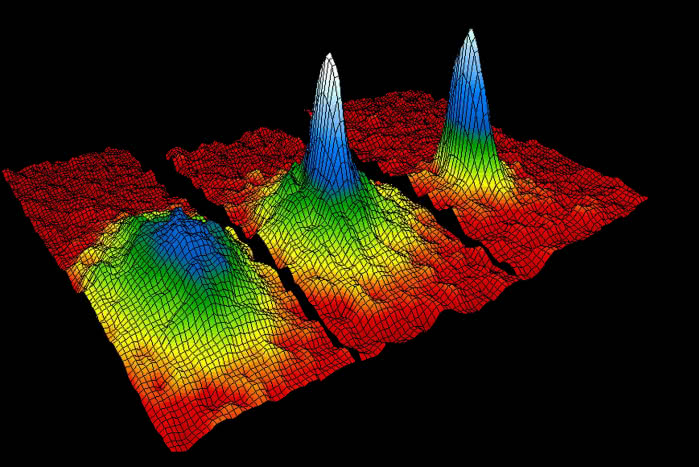

Naukowcy z uniwersytetów brytyjskich Cambridge, Southampton i Cardiff oraz rosyjskiego Instytutu Skolkowo wykorzystali w swoich eksperymentach cząstki kwantowe znane jako polarytony, które można określić jako coś pośredniego pomiędzy światłem a materią. To całkowicie nowe podejście do obliczeń komputerowych. Zdaniem uczonych, może ono stanowić podstawę nowego typu komputera, będącego w stanie rozwiązywać kwestie obecnie nierozwiązywalne - i to w różnych dziedzinach, takich jak biologia, finanse czy podróże kosmiczne. Wyniki badań opisano w czasopiśmie "Nature Materials".

Pamiętajmy, że nowoczesne superkomputery mogą poradzić sobie jedynie z niewielką częścią problemów. Nawet hipotetyczny komputer kwantowy, jeśli w końcu zostanie zbudowany, zaoferuje w najlepszym przypadku przyspieszenie do kwadratu rozwiązywania najbardziej złożonych kwestii. Tymczasem polarytony tworzące "magiczny pył" powstają poprzez aktywację wiązkami laserowymi warstw atomów galu, arsenu, indu i aluminium.

Elektrony znajdujące się w tych warstwach pochłaniają i emitują światło o określonej barwie. Polarytony są dziesięć tysięcy razy lżejsze od elektronów i mogą osiągnąć wystarczającą gęstość, aby zrodzić nowy stan materii, znany jako kondensat Bosego-Einsteina (8). Fazy kwantowe polarytonów synchronizują się w nim i tworzą pojedynczy makroskopowy obiekt kwantowy, który da się wykryć za pomocą pomiarów fotoluminescencji.

Okazuje się, że w tym specyficznym stanie kondensat polarytonowy może rozwiązać problem optymalizacji - o którym wspominaliśmy, opisując komputery kwantowe - znacznie efektywniej niż procesory oparte na kubitach. Autorzy brytyjsko-rosyjskich badań pokazali, że w miarę kondensacji polarytonów ich fazy kwantowe układają się w konfiguracji, która odpowiada absolutnemu minimum złożonej funkcji.

"Jesteśmy na początku badania potencjału wykresów polarytonowych do rozwiązywania złożonych problemów", pisze współautor publikacji w "Nature Materials", prof. Pavlos Lagoudakis, szef laboratorium hybrydowej fotoniki na Uniwersytecie Southampton. "Obecnie skalujemy nasze urządzenie do setek węzłów, jednocześnie testując podstawową moc obliczeniową."

Przy tych eksperymentach ze świata subtelnych faz kwantowych światła i materii nawet kwantowe procesory wydają się czymś topornym i twardo związanym z rzeczywistością. Naukowcy, jak widać, nie tylko pracują nad superkomputerami jutra i maszynami pojutrza, ale już planują, co stanie się popojutrze.

Na razie sporym wyzwaniem będzie osiągnięcie eksaskali, potem pomyśli się o kolejnych kamieniach milowych na skali flopsów (9). Jak łatwo się domyślić, samo dodawanie procesorów i pamięci do tego nie wystarczy. Jeśli wierzyć naukowcom, dotarcie do tak potężnej mocy obliczeniowej pozwoli nam poradzić sobie z megaproblemami, które znamy - takimi jak dekodowanie nowotworów czy analiza danych astronomicznych.

Dopasować pytanie do odpowiedzi

Co dalej?

Cóż, już w przypadku komputerów kwantowych pojawiają się pytania, do czego miałyby nam posłużyć. Zgodnie ze starym powiedzeniem, komputery rozwiązują problemy, których bez nich nie mielibyśmy. Zapewne powinniśmy więc najpierw te futurystyczne supermaszyny zbudować. Wówczas problemy same się pojawią.

Sztuczna inteligencja. AI (artificial intelligence) działa zgodnie z zasadą uczenia się poprzez doświadczenie - coraz dokładniejszego w miarę przekazywania informacji zwrotnych, aż do momentu, gdy program komputerowy zacznie wykazywać się "inteligencją". Informacja zwrotna opiera się na obliczeniach prawdopodobieństwa dla wielu możliwych wyborów. Wiemy już, że np. Lockheed Martin planuje wykorzystać swój komputer kwantowy D-Wave do testowania oprogramowania autopilota, które jest obecnie zbyt skomplikowane dla klasycznych komputerów, a z kolei Google używa komputera kwantowego do projektowania oprogramowania, które może odróżnić samochody od punktów orientacyjnych.

Modelowanie molekularne. Dzięki komputerom kwantowym można będzie precyzyjnie modelować oddziaływania molekularne, szukając optymalnych konfiguracji dla chemicznych reakcji. "Chemia kwantowa" jest tak złożona, że dzisiejsze komputery cyfrowe mogą analizować tylko najprostsze cząsteczki. Reakcje chemiczne mają charakter kwantowy, ponieważ tworzą silnie uwikłane stany kwantowe nakładające się na siebie, więc w pełni rozwinięte komputery kwantowe nie miałyby trudności z oceną nawet najbardziej złożonych procesów. Google ma już osiągnięcia na tym polu - zasymulował cząsteczkę wodoru. Skutkiem będą bardziej wydajne produkty, od ogniw słonecznych po leki.

Kryptografia. Systemy bezpieczeństwa zależą dziś od skutecznego generowania liczb pierwszych. Można to osiągnąć za pomocą komputerów cyfrowych, przeszukując wszystkie możliwe czynniki, ale wymagana do tego ogromna ilość czasu sprawia, że "złamanie kodu" staje się kosztowne i niepraktyczne. Komputery kwantowe mogą tymczasem dokonywać tego wykładniczo, efektywniej niż maszyny cyfrowe, co oznacza, że dzisiejsze metody zabezpieczeń wkrótce staną się przestarzałe. Istnieją również obiecujące metody szyfrowania kwantowego, opracowywane z wykorzystaniem jednokierunkowego charakteru splątania kwantowego. W kilku krajach zostały już zademonstrowane sieci obejmujące całe miasta, a ostatnio chińscy naukowcy ogłosili, że z powodzeniem wysyłają splątane fotony z orbitującego "kwantowego" satelity do trzech oddzielnych stacji bazowych z powrotem na Ziemię.

Modelowanie finansowe. Nowoczesne rynki należą do najbardziej skomplikowanych systemów, jakie istnieją. Chociaż opracowano naukowe i matematyczne narzędzia do ich opisu i kontroli, skuteczność tego rodzaju działań nadal jest mocno niewystarczająca z powodu zasadniczej różnicy między dziedzinami nauki: nie ma kontrolowanego środowiska, w którym można by przeprowadzać eksperymenty. Aby rozwiązać ten problem, inwestorzy i analitycy zwrócili się ku obliczeniom kwantowym. Jedną z natychmiastowych korzyści jest to, że przypadkowość, nieodłącznie związana z komputerami kwantowymi, jest zgodna ze stochastycznym charakterem rynków finansowych. Inwestorzy często chcą ocenić rozkład wyników w ramach bardzo dużej liczby losowo wygenerowanych scenariuszy.

Prognozowanie pogody. Główny ekonomista NOAA (National Oceanic and Atmospheric Administration), Rodney F. Weiher, twierdzi, że prawie 30% amerykańskiego PKB (6 bilionów dolarów) jest bezpośrednio lub pośrednio uzależnione od pogody, co ma wpływ m.in. na produkcję żywności, transport i handel detaliczny. Zdolność lepszego przewidywania aury przyniosłaby więc ogromne korzyści w wielu dziedzinach, nie wspominając już o dłuższym czasie pozostawionym na ochronę przed klęskami żywiołowymi. Krajowy brytyjski oddział meteorologiczny Met Office już zaczął inwestować w takie innowacje, aby sprostać zapotrzebowaniu na moc i skalowalność, z którymi będzie musiał się zmierzyć począwszy od roku 2020 - opublikował też sprawozdanie na temat własnych potrzeb w zakresie obliczeń eksaskalowych.

Fizyka cząstek stałych. Modele fizyki cząstek stałych są często niezwykle złożonymi, zagmatwanymi rozwiązaniami, wymagającymi dużo czasu obliczeniowego na symulacje numeryczne. To czyni je idealnymi do obliczeń kwantowych, a naukowcy już z tego korzystali. Badacze z Uniwersytetu w Innsbrucku oraz Instytutu Optyki Kwantowej i Informacji Kwantowej (IQOQI) zastosowali niedawno do przeprowadzenia takiej symulacji programowalny system kwantowy. Według publikacji w "Nature", grupa używała prostej wersji komputera kwantowego, w którym jony wykonywały operacje logiczne, podstawowe kroki w dowolnych obliczeniach komputerowych. Symulacja wykazała doskonałą zgodność z faktycznymi eksperymentami opisywanej fizyki. - Te dwa podejścia doskonale się uzupełniają - mówi fizyk teoretyczny Peter Zoller. - Nie można zastąpić eksperymentów z kolizjami cząsteczek, jednak opracowując symulatory kwantowe, pewnego dnia możemy zacząć te doświadczenia lepiej rozumieć.

Mirosław Usidus