Multikameryzm zamiast megalopikselozy

W pierwszej połowie 2018 r. z powodu dwóch nowych prototypów aparatów fotograficznych dość głośno stało się o nieznanej wcześniej firmie Light, oferującej technologię multiobiektywową - nie do swojego na razie, lecz do innych modeli smartfonów. Choć firma, o czym pisał wtedy także "MT", już w 2015 r. pokazała model L16 z szesnastoma obiektywami (1), dopiero w ostatnich kilkunastu miesiącach mnożenie aparatów w komórkach weszło do głównego nurtu.

Aparat pełen obiektywów

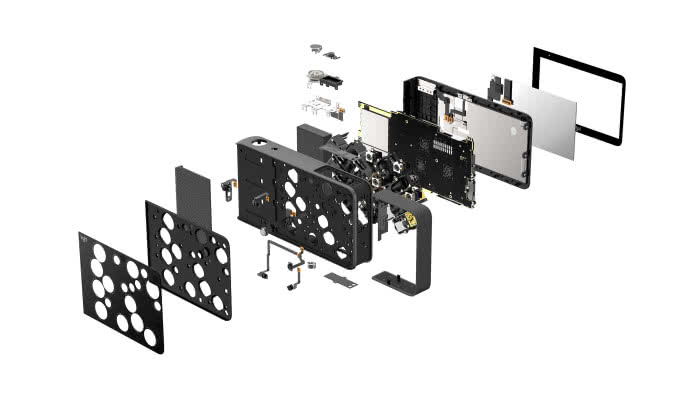

Ten pierwszy model firmy Light był kompaktowym aparatem fotograficznym (nie komórką) wielkości telefonu, który w założeniach miał zapewniać jakość cyfrowej lustrzanki. Robił zdjęcia o rozdzielczości nawet 52 megapikseli, oferował długość ogniskowej w zakresie 35-150 mm, wysoką jakość przy słabym oświetleniu i regulację głębi ostrości. Wszystko było możliwe dzięki połączeniu w jednej obudowie aż szesnastu kamer smartfonowych. Żaden z tych licznych obiektywów nie różnił się od optyki spotykanej w smartfonach. Różnica polegała na ich nagromadzeniu w jednym urządzeniu.

Podczas robienia zdjęcia obraz rejestrowało równocześnie dziesięć kamer, każda z własnymi parametrami ekspozycji. Wszystkie wykonane w ten sposób zdjęcia łączono w jedną, dużą fotografię, w której zawarte były wszystkie dane z pojedynczych ekspozycji. Układ pozwalał na edycję głębi ostrości i punktów fokusowych gotowego już zdjęcia. Fotografie zapisywano w formatach JPG, TIFF lub RAW DNG. Dostępny na rynku model L16 nie miał wbudowanej typowej lampy błyskowej, ale zdjęcia mogły być doświetlane niewielkim LED-em, znajdującym się w obudowie.

Tamta premiera w 2015 r. miała status ciekawostki. Nie zainteresowała wielu mediów i masowej publiczności. Biorąc jednak pod uwagę, że inwestorem w Light była firma Foxconn, dalszy rozwój wypadków nie stanowił zaskoczenia. Polegał on, mówiąc w skrócie, na rosnącym zainteresowaniu rozwiązaniem ze strony firm współpracujących z tajwańskim producentem sprzętu. A klientami Foxconnu są zarówno Apple, jak też m.in. Blackberry, Huawei, Microsoft, Motorola czy Xiaomi.

I tak w 2018 r. pojawiły się informacje o pracach prowadzonych przez Light nad wielokamerowymi układami w smartfonach. Potem okazało się, że startup współpracuje z Nokią, która na mobilnym kongresie MWC w Barcelonie w 2019 r. zaprezentowała pierwszy na świecie telefon z pięcioma aparatami fotograficznymi. Model 9 PureView (3) wyposażono w dwie kamery kolorowe oraz w trzy monochromatyczne.

Przedstawiciele Light wyjaśniali w serwisie "Quartz", że istnieją dwie główne różnice między L16 i Nokia 9 PureView. Ta ostatnia wykorzystuje nowszy układ przetwarzania do zszywania zdjęć z poszczególnych obiektywów. Poza tym w konstrukcji Nokii znajdziemy inne niż pierwotnie wykorzystywane przez Light aparaty fotograficzne, z optyką firmy ZEISS, przechwytujące więcej światła. Trzy z aparatów służą wyłącznie do przechwytywania światła w zakresie czarno-białym.

Zestaw kamer, każda o rozdzielczości 12 megapikseli, zapewnia większą kontrolę nad głębią ostrości obrazu i pozwala użytkownikom uchwycić szczegóły, które dla zwykłego aparatu komórkowego pozostają zwykle niewidoczne. Ponadto, wg udostępnionych opisów, 9 PureView jest w stanie przechwycić do dziesięciu razy więcej światła niż inne urządzenia i może tworzyć zdjęcia o łącznej rozdzielczości nawet do 240 megapikseli.

Ostry start telefonów wielokamerowych

Light to nie jedyne źródło innowacji w tej dziedzinie. Patent koreańskiej firmy LG z listopada 2018 r. opisuje łączenie różnych kątów widzenia kamery w celu stworzenia miniaturowego filmu, przypominającego kreacje Apple Live Photos lub obrazy z urządzeń Lytro, o których "MT" również pisał kilka lat temu, rejestrujące pole światła z regulowanym polem widzenia.

Według opisu patentowego LG, rozwiązanie to potrafi łączyć różne zestawy danych z różnych obiektywów do wycinania obiektów z obrazu (np. w przypadku trybu portretowego lub nawet całkowitej wymiany tła). Oczywiście na razie jest to tylko patent, bez wskazania, że LG planuje zrealizowanie go w telefonie. W miarę jednak coraz bardziej eskalującej wojny na polu fotografii smartfonowej, aparaty telefoniczne z takimi funkcjami mogą pojawić się na rynku szybciej, niż nam się wydaje.

Jak zobaczymy, przyglądając się historii multiobiektywowych aparatów, dwukamerowe układy nie są wcale nowością. Jednak już umieszczanie trzech kamer i więcej to pieśń ostatnich kilkunastu miesięcy.

Z wielkich producentów aparatów telefonicznych najszybszy z debiutem rynkowym trójkamerowego modelu był chiński Huawei. Już w marcu 2018 r. zaproponował Huawei P20 Pro (4), oferujący trzy obiektywy - zwykły, monochromatyczny i telezoom, a kilka miesięcy później zaprezentował Mate 20, również z trzema kamerami.

Jak to jednak już w historii techniki mobilnej bywało - potrzeba było dopiero odważnego wejścia w nowe rozwiązania firmy Apple, aby wszystkie media zaczęły mówić o przełomie i rewolucji. Podobnie więc jak pierwszy model iPhone’a z 2007 r. "wystartował" rynek znanych przecież już wcześniej smartfonów, a pierwszy iPad (ale nie pierwszy tablet w ogóle) zainaugurował w 2010 r. erę tabletów, tak we wrześniu 2019 r. multiobiektywowe iPhone’y "jedenastki" (5), autorstwa firmy z jabłkiem w godle, można było uznać za ostry start epoki smartfonów wielokamerowych.

11 Pro oraz 11 Pro Max wyposażono w trzy aparaty fotograficzne. W pierwszym z nich zamontowano sześcioelementowy obiektyw z ogniskową o ekwiwalencie 26 mm dla pełnej klatki i otworem względnym f/1.8. Producent deklaruje, że został on wyposażony w nowy, 12-megapikselowy sensor 100% focus pixels, co może oznaczać rozwiązanie podobne do tych stosowanych w aparatach Canon czy w smartfonach Samsunga, gdzie każdy piksel składa się z dwóch fotodiod.

W drugim aparacie pojawia się obiektyw szerokokątny (o ogniskowej 13 mm i jasności f/2.4), wyposażony w matrycę o rozdzielczości 12 Mpix. Do opisanych modułów dochodzi teleobiektyw, podwajający ogniskową względem obiektywu standardowego. Jest to konstrukcja o otworze względnym f/2.0. Sensor charakteryzuje się tą samą rozdzielczością, co pozostałe. Zarówno teleobiektyw, jak i obiektyw standardowy wyposażone są w optyczną stabilizację obrazu.

We wszystkich wersjach spotkamy znany z telefonów marki Huawei, Google Pixel czy Samsung tryb zdjęć nocnych. To też charakterystyczne rozwiązanie dla układów multiobiektywowych. Polega ono na tym, że aparat wykonuje kilka zdjęć o różnej kompensacji ekspozycji, a następnie łączy je w jedną fotografię o niższym szumie i lepszej dynamice tonalnej.

Aparat w telefonie - jak to się stało?

Pierwszym telefonem, który wyposażono w aparat fotograficzny, był Samsung SCH-V200. Urządzenie pojawiło się na półkach sklepowych w Korei Południowej w 2000 r.

Potrafiło przechować w swej pamięci dwadzieścia zdjęć o rozdzielczości 0,35 megapiksela. Aparat miał jednak poważną wadę - był słabo zintegrowany z telefonem. Z tego powodu część analityków uznaje go raczej za osobne urządzenie zamknięte w tej samej obudowie niż integralną część telefonu.

Sprawa wyglądała zupełnie inaczej w przypadku J-Phone’a, czyli telefonu, który u schyłku poprzedniego tysiąclecia przygotowała na rynek japoński firma Sharp. Sprzęt wykonywał zdjęcia w bardzo niskiej jakości 0,11 megapiksela, ale w przeciwieństwie do propozycji Samsunga fotografie można było bezprzewodowo przesyłać i wygodnie oglądać na ekranie komórki. J-Phone’a wyposażono w kolorowy wyświetlacz pokazujący 256 barw.

Aparaty w komórkach stały się dość szybko niezwykle modnym gadżetem. Jednak nie za sprawą urządzeń Sanyo czy J-Phone, a propozycji potentatów komórkowych, czyli wówczas głównie Nokii i Sony Ericssona.

Nokię 7650 wyposażono w 0,3-megapikselowy aparat. Był to jeden z pierwszych szeroko dostępnych i popularnych telefonów umożliwiających robienie zdjęć. Dobrze na rynku radził sobie również Sony Ericsson T68i. Żaden telefon przed nim nie był w stanie zarówno odbierać, jak i wysyłać wiadomości MMS. Inaczej jednak niż w przypadku poprzednich modeli omawianych na liście, aparat do T68i trzeba było… dokupić osobno i przyczepić do komórki.

Po premierze tych urządzeń popularność aparatów w komórkach zaczęła rosnąć w ogromnym tempie - już w 2003 r. sprzedawało się ich na świecie więcej niż standardowych aparatów cyfrowych.

W roku 2006 ponad połowa komórek na świecie miała wbudowany aparat. Rok później ktoś po raz pierwszy wpadł na pomysł umieszczenia w komórce dwóch obiektywów…

Od mobilnej telewizji, przez 3D po coraz lepszą fotografię

Wbrew pozorom historia multikamerowych rozwiązań nie jest taka krótka. Samsung oferował w swoim modelu B710 (6) podwójny obiektyw już w 2007 r. Wprawdzie wówczas bardziej zwracano uwagę na możliwości tego aparatu w zakresie mobilnej telewizji, jednak podwójny układ obiektywów pozwalał na uwiecznienie fotograficznych wspomnień w efekcie 3D. Gotowe zdjęcie oglądaliśmy na wyświetlaczu tego modelu bez potrzeby zakładania specjalnych okularów.

W tamtych latach, wielkiej mody na 3D, spoglądano na układy kamer jako na możliwość oddania właśnie tego efektu.

LG Optimus 3D, który miał premierę w lutym 2011 r., oraz HTC Evo 3D, wprowadzone na rynek w marcu 2011 r., używały podwójnych obiektywów, aby umożliwić robienie zdjęć 3D. Stosowano w nich tę samą technikę, po którą sięgali konstruktorzy "zwykłych" aparatów fotograficznych 3D, wykorzystujący podwójne obiektywy do stworzenia poczucia głębi w obrazach. Zostało to wzmocnione przez wyświetlacz 3D, przeznaczony do oglądania powstałych obrazów bez okularów.

3D okazało się jednak tylko przelotną modą. Wraz z jej zmierzchem przestano myśleć o układach wielokamerowych jako narzędziu uzyskiwania obrazów stereograficznych.

W każdym razie nie przede wszystkim. Pierwszym aparatem, który oferował dwa czujniki obrazu w celach podobnych do współczesnych, był HTC One M8 (7), wprowadzony na rynek w kwietniu 2014 r. Jego 4-megapikselowy główny przetwornik UltraPixel oraz 2-megapikselowy przetwornik przechwytujący dodatkowe dane miały za zadanie tworzyć poczucie głębi na zdjęciach.

Drugi obiektyw produkował mapę głębi i wprowadzał ją do końcowego efektu obrazowania. Oznaczało to możliwość tworzenia efektu rozmycia tła typu bokeh, ponownego ustawienia ostrości obrazu poprzez stuknięcie w panel wyświetlacza oraz łatwego manipulowania zdjęciami, z utrzymaniem ostrości obiektu i zmiany tła nawet po wykonaniu fotografii.

Nie wszyscy jednak chyba wówczas rozumieli potencjał tkwiący w tej technice. HTC One M8 może nie stał się rynkową porażką, ale też nie wyróżniał się szczególną popularnością. Następna znacząca w tej historii konstrukcja, LG G5, pojawiła się w lutym 2016 r. Wyposażono ją w główny sensor 16-megapikselowy i drugi 8-megapikselowy, stanowiący 135-stopniowy obiektyw szerokokątny, na który dawało się przełączać urządzenie.

W kwietniu 2016 r. Huawei zaproponował we współpracy z Leicą model P9, z dwiema kamerami z tyłu. Jedna nich służyła do uchwycenia kolorów z palety RGB (red, green, blue), druga miała uwieczniać monochromatyczne szczegóły. To na podstawie tego modelu Huawei stworzył potem wspominany model P20.

W 2016 r. na rynek wprowadzono również iPhone’a 7 Plus z dwiema kamerami z tyłu - obiema 12-megapikselowymi, ale oferującymi różne ogniskowe. Pierwszy aparat miał zoom 23 mm, drugi zaś 56 mm, co oznaczało wejście w erę smartfonowej telefotografii. Chodziło o to, aby pozwolić użytkownikowi powiększać obraz bez dużej utraty jakości - firma Apple chciała bowiem zająć się tym, co postrzegała jako istotny problem z fotografią smartfonów i opracowała rozwiązanie, które odpowiadało zachowaniu kupujących. Powieliła również rozwiązanie HTC, oferując efekty bokeh przez stosowanie map głębokości pochodzących z danych z obu obiektywów.

Wejście Huawei P20 Pro na początku 2018 r. oznaczało integrację wszystkich próbowanych dotychczas rozwiązań w jednym urządzeniu z potrójną kamerą. Do systemu czujników RGB i monochromatycznych dodano obiektyw zmiennoogniskowy, a wykorzystanie sztucznej inteligencji zapewniało o wiele więcej niż prostą sumę możliwości optyki i czujników. W dodatku pojawił się imponujący tryb nocny. Nowy model odniósł wielki sukces i w sensie rynkowym to on w rzeczywistości okazał się przełomem, a nie epatujący liczbą obiektywów aparat Nokii, czy efektowny jak zwykle produkt Apple’a.

Prekursor tendencji umieszczania więcej niż jednej kamery w telefonie - Samsung (8) - w 2018 r. również zaoferował trzyobiektywowy aparat fotograficzny. Znalazł się on w modelu Samsung Galaxy A7.

Producent zdecydował się jednak na obiektywy: zwykły, szerokokątny i trzecie oko do dostarczania niezbyt sprecyzowanej "informacji o głębokości". Za to kolejny model, Galaxy A9, oferował aż cztery obiektywy: ultraszerokokątny, teleobiektyw, standardowy aparat fotograficzny i czujnik głębi.

To dużo, bo standardem są w tej chwili wciąż trzy obiektywy. Nie licząc iPhone’a, flagowe modele swoich marek - takie jak Huawei P30 Pro i Samsung Galaxy S10+ - mają właśnie po trzy kamery z tyłu. Oczywiście nie liczymy mniejszego obiektywu, przeznaczonego do selfików, a umieszczanego z przodu.

Niewzruszony wydaje się w tym wszystkim Google. Jego Pixel 3 miał jeden z najlepszych aparatów fotograficznych na rynku i robił "wszystko" za pomocą ledwie jednego obiektywu.

Urządzenia Pixel używają specjalnego oprogramowania, aby zapewnić stabilizację, powiększenie i efekty głębi. Wyniki nie były tak dobre, jak mogłyby być przy zastosowaniu wielu obiektywów i czujników, ale różnica okazywała się mała i telefony Google’a uzupełniały niewielkie niedobory doskonałą wydajnością w słabym świetle. Jak się jednak zdaje, niedawno, w modelu Pixel 4, nawet Google ostatecznie się złamał, choć oferując wciąż jedynie dwa obiektywy: zwykły i tele.

Nie tylko bokeh

Co daje dodawanie większej liczby aparatów w jednym smartfonie? Zdaniem specjalistów, jeśli rejestrują one w różnych ogniskowych, ustawione są z różnymi przysłonami i przechwytują całe pakiety obrazów do dalszej obróbki algorytmicznej (compositing), zapewnia to zauważalny wzrost jakości w porównaniu do obrazów uzyskanych za pomocą telefonu z jednym aparatem.

Fotografie są ostrzejsze, bardziej szczegółowe, z prawdziwszymi kolorami i większym zakresem dynamiki. Wydajność przy słabym oświetleniu również jest znacznie lepsza.

Wielu osobom, które czytały o możliwościach układów wieloobiektywowych, kojarzą się one głównie z rozmyciem tła portretu typu bokeh, czyli oddawaniem nieostrości obiektów znajdujących się poza głębią ostrości. Chodzi jednak o znacznie więcej.

Aparaty fotograficzne tego rodzaju służą coraz szerszemu zakresowi funkcji, w tym bardziej precyzyjnemu mapowaniu trójwymiarowemu, wprowadzaniu rozszerzonej rzeczywistości oraz lepszemu rozpoznawaniu twarzy i scenerii.

Już wcześniej za pomocą aplikacji i sztucznej inteligencji optyczne sensory smartfonów podejmowały takie zadania, jak obrazowanie termiczne, tłumaczenie obcojęzycznych tekstów na podstawie obrazów, identyfikacja konstelacji gwiezdnych na nocnym niebie czy analiza boiskowych ruchów sportowca. Zastosowanie układów wielokamerowych znacznie ulepsza działanie tych zaawansowanych funkcji. I przede wszystkim przynosi nam to wszystko w jednym opakowaniu.

Dawniejsza historia rozwiązań wieloobiektywowych pokazuje różne poszukiwania, jednak trudnym do przezwyciężenia problemem były zawsze wysokie wymagania dotyczące przetwarzania danych, jakości algorytmów i zużycia energii. W przypadku nowoczesnych smartfonów wykorzystujących zarówno potężniejsze niż dotąd procesory sygnału wizualnego, jak i energooszczędne cyfrowe procesory sygnału, a nawet ulepszone możliwości sieci neuronowych, problemy te zostały znacząco zredukowane.

Wysoki poziom szczegółowości, wielkie możliwości zoomu optycznego i konfigurowalne efekty typu bokeh, to obecnie pierwsze pozycje na liście współczesnych wymagań wobec fotografii smartfonowej. Do niedawna, aby móc je spełnić, użytkownik smartfona musiał się przeprosić z tradycyjnym aparatem fotograficznym. Dziś już niekoniecznie.

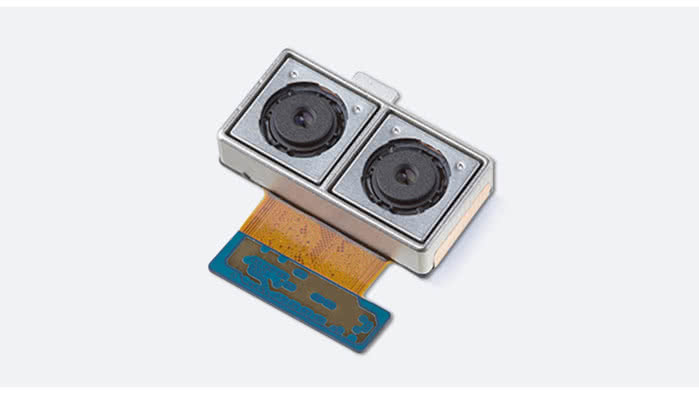

W przypadku dużych aparatów fotograficznych estetyczny efekt bokeh uzyskuje się dość naturalnie, gdy rozmiar obiektywu i wielkość przysłony są wystarczająco duże, by uzyskać analogowe rozmycie wszędzie tam, gdzie piksele pozostają nieostre. Telefony komórkowe mają soczewki i czujniki (9), które są zbyt małe, aby mogło się to wydarzyć w sposób naturalny (w przestrzeni analogowej). Dlatego też opracowywany jest proces emulacji za pomocą oprogramowania.

Piksele, które znajdują się dalej od obszaru ostrości lub płaszczyzny ostrości, są sztucznie rozmywane przy użyciu jednego z wielu algorytmów rozmycia, powszechnie stosowanych w przetwarzaniu obrazów. Odległość każdego piksela od obszaru ostrości najlepiej i najszybciej mierzy się za pomocą dwóch zdjęć wykonanych z separacją ~1 cm.

Ze względu na stałą długość separacji i możliwość fotografowania obu widoków w tym samym czasie (unikanie szumu ruchu), możliwe jest triangulowanie głębokości każdego piksela na zdjęciu (przy użyciu algorytmu stereo z użyciem wielu widoków). Teraz już łatwo uzyskać doskonałe oszacowanie położenia każdego piksela w stosunku do obszaru ostrości.

Nie jest to proste, ale telefony z dwoma aparatami usprawniają ten proces, ponieważ mogą robić zdjęcia jednocześnie. Systemy z pojedynczym obiektywem muszą albo wykonać dwie kolejne fotografie (pod różnymi kątami), albo użyć innego zbliżenia.

Sposobem na powiększanie zdjęć bez strat w rozdzielczości jest telefoto (zoom optyczny). Najwyższa wartość rzeczywistego zoomu optycznego, jaki można obecnie uzyskać w smartfonie, wynosi 5× - na Huawei P30 Pro.

W niektórych telefonach stosuje się systemy hybrydowe, które wykorzystują zarówno zoom optyczny, jak i cyfrowy, co pozwala na większe zbliżenia bez widocznej utraty jakości. Wspomniany Google Pixel 3 używa do tego samego niezwykle wyrafinowanych algorytmów komputerowych, nic dziwnego więc, że nie potrzebuje dodatkowych obiektywów. W "czwórce" wprowadzono już jednak zoom, a zatem wygląda na to, że bez optyki trudno się obejść.

Fizyka konstrukcji typowego obiektywu sprawia, że bardzo trudno zmieścić obiektyw zmiennoogniskowy w cienkiej obudowie wysokiej klasy smartfonu. W rezultacie, producenci telefonów byli w stanie osiągnąć najwyżej 2- lub 3-krotny zoom optyczny dzięki zastosowaniu w smartfonie tradycyjnej orientacji "czujnik-obiektyw". Dodanie teleobiektywu oznacza zazwyczaj grubszy telefon, mniejszy czujnik lub użycie składanej optyki.

Jeden ze sposobów na pokonanie granicy ogniskowej stanowi tzw. złożona optyka (10). Czujnik modułu kamery jest umieszczony pionowo w telefonie i skierowany na obiektyw z osią optyczną, który biegnie wzdłuż korpusu telefonu. Lustro lub pryzmat znajdują się pod odpowiednim kątem, tak aby odbijać światło ze sceny do obiektywu i czujnika.

W pierwszych projektach tego typu występowało lustro stałe, odpowiednie dla systemów dwuobiektywowych, takich jak Falcon, oraz produkty Hawkeye firmy Corephotonics, które łączą w sobie tradycyjny aparat fotograficzny i złożony projekt teleobiektywu w jednym module. Jednak na rynek zaczynają wchodzić również projekty firm w rodzaju Light, które wykorzystują ruchome lusterka do syntezy obrazów z wielu kamer.

Dokładnym przeciwieństwem telefoto jest fotografia szerokokątna. Zamiast zbliżeń, szeroki kąt widzenia pokazuje więcej tego, co mamy przed sobą. Fotografia szerokokątna została wprowadzona jako drugi system soczewek na LG G5 i kolejnych telefonach.

Opcja szerokokątna jest szczególnie przydatna do uchwycenia emocjonujących doświadczeń, takich jak przebywanie w tłumie na koncercie lub w miejscu zbyt dużym, by można było je uchwycić węższym obiektywem. Jest to również zazwyczaj doskonałe rozwiązanie dla oddania krajobrazów miejskich, uchwycenia wysokich budynków i innych rzeczy, których zwykłe obiektywy po prostu nie widzą. Przy tym zazwyczaj nie ma potrzeby przełączania na konkretny "tryb", ponieważ przełączanie kamery następuje w miarę zbliżania się do obiektu lub oddalania od niego, co jest doskonale zintegrowane z normalnym doświadczeniem używania aparatu fotograficznego w komórce.

Według firmy LG, 50% użytkowników kamer z dwoma obiektywami ma obiektyw szerokiego kąta ustawiony jako główny aparat fotograficzny.

Obecnie cała gama smartfonów jest już wyposażona w czujnik przeznaczony do wykonywania zdjęć monochromatycznych, czyli czarno-białych. Największą ich zaletą jest ostrość, dlatego też niektórzy fotografowie tak mocno je preferują.

Nowoczesne telefony są wystarczająco inteligentne, aby łączyć tę ostrość z informacjami pochodzącymi z czujników koloru, co pozwala uzyskać ujęcie, które teoretycznie jest dokładniej oświetlone. Mimo to użycie czujnika monochromatycznego pozostaje wciąż rzadkością. Jeśli jest dołączony do zestawu, zazwyczaj da się go odizolować od innych obiektywów. Opcję tę można znaleźć w ustawieniach aplikacji aparatu fotograficznego.

Ponieważ czujniki kamery nie rejestrują kolorów na własną rękę, wymagają zastosowania filtrów kolorowych o rozmiarze pikseli. W rezultacie każdy piksel nagrywa tylko w jednym kolorze - zwykle czerwonym, zielonym lub niebieskim.

Wynikowa suma pikseli powstaje w celu stworzenia użytecznego obrazu RGB, ale ten proces pociąga za sobą kilka kompromisów. Pierwszym z nich jest utrata rozdzielczości spowodowana przez matrycę kolorów, a ponieważ każdy piksel odbiera tylko część światła, aparat nie jest tak czuły jak urządzenie bez matrycy filtrów barwnych. I tu w sukurs wrażliwemu na jakość fotografującemu przychodzi właśnie czujnik monochromatyczny, który może rejestrować i nagrywać w pełnej rozdzielczości całe dostępne światło. Połączenie obrazu z kamery monochromatycznej z obrazem z głównej kamery RGB tworzy bardziej szczegółowy obraz końcowy.

Drugi czujnik monochromatyczny jest idealny do tego zastosowania, ale to nie jedyna opcja. Firma Archos robi np. coś podobnego do typowego monochromatu, ale wykorzystuje do tego dodatkowy czujnik RGB o wyższej rozdzielczości. Ponieważ obie kamery są przesunięte względem siebie, proces wyrównywania i łączenia dwóch obrazów pozostaje złożony, a obraz końcowy zazwyczaj nie jest tak szczegółowy jak wersja monochromatyczna o wyższej rozdzielczości.

Jednak w efekcie otrzymujemy wyraźną poprawę jakości w stosunku do ujęcia rejestrowanego za pomocą jednego modułu kamery.

Czujnik głębi, stosowany m.in. w aparatach Samsunga, pozwala osiągnąć profesjonalne efekty rozmycia i lepsze renderowanie rzeczywistości rozszerzonej, zarówno za pomocą przedniej, jak i tylnej kamery. Jednak telefony z najwyższej półki stopniowo zastępują czujniki głębi poprzez włączenie tego procesu do aparatów fotograficznych, które potrafią również wyczuwać głębię, takich jak urządzenia z obiektywami ultraszerokokątnym lub tele.

Oczywiście czujniki głębi zapewne nadal będą pojawiać się w telefonach bardziej przystępnych cenowo, oraz tych, w których dąży się do tworzenia efektów głębi bez kosztownej optyki, takich jak choćby Moto G7.

Rozszerzona rzeczywistość, czyli prawdziwa rewolucja

Gdy telefon wykorzysta różnice w obrazach uzyskanych z kilku aparatów fotograficznych do stworzenia mapy odległości od niego w danej scenie (powszechnie nazywanej mapą głębokości), może ją następnie wykorzystać do zasilania aplikacji rzeczywistości rozszerzonej (AR). Wesprze ją np. w umieszczaniu i wyświetlaniu syntetycznych obiektów na powierzchniach sceny. Jeśli odbywa się to w czasie rzeczywistym, obiekty będą w stanie ożywać i poruszać się.

Zarówno Apple ze swoim ARKitem, jak i Android z rozwiązaniem ARCore dostarczają platformy AR dla telefonów wielokamerowych.

Jednym z najlepszych przykładów nowych rozwiązań, jakie pojawiają się wraz z powszechnieniem smartfonów wyposażonych w wiele kamer, są dokonania startupu Lucid z Doliny Krzemowej. W niektórych kręgach może być on znany jako twórca VR180 LucidCam oraz myśli technologicznej stojącej za rewolucyjnym projektem aparatu Red 8K 3D.

Specjaliści z Lucid stworzyli platformę Lucid 3D Fusion (11), która wykorzystuje uczenie maszynowe i dane statystyczne do szybkiego pomiaru głębokości obrazów w czasie rzeczywistym. Technika ta umożliwia korzystanie z funkcji, które nie były dotychczas dostępne w smartfonach, takich jak zaawansowane śledzenie obiektów w rzeczywistości rozszerzonej oraz gestykulacja w powietrzu z wykorzystaniem obrazów o wysokiej rozdzielczości.

Z punktu widzenia firmy mnożące się w telefonach kamery to niezwykle użyteczne pole działania dla czujników AR, wbudowanych we wszechobecne komputery kieszonkowe, które uruchamiają aplikacje i są zawsze podłączone do Internetu. Już teraz aparaty fotograficzne w smartfonach są w stanie identyfikować i dostarczać dodatkowych informacji na temat tego, na co je kierujemy. Umożliwiają nam zbieranie danych wizualnych i oglądanie obiektów rzeczywistości rozszerzonej umieszczonych w świecie rzeczywistym.

Oprogramowanie Lucid potrafi konwertować dane z dwóch kamer na informacje 3D wykorzystywane do mapowania w czasie rzeczywistym i do rejestrowania scen z informacjami o głębokości. Umożliwia to szybkie tworzenie modeli 3D oraz gier wideo 3D. Firma stosowała zresztą swoją LucidCam do badań nad poszerzaniem zakresu ludzkiego widzenia jeszcze w czasach, gdy smartfony z dwiema kamerami stanowiły tylko drobną część rynku.

Wielu komentatorów zwraca uwagę, że koncentrując się jedynie na fotograficznych aspektach istnienia wielokamerowych smartfonów, nie zauważamy, co naprawdę sprzęt tego rodzaju może ze sobą przynieść. Weźmy choćby iPhone’a, który wykorzystuje algorytmy uczenia maszynowego do skanowania obiektów w obrębie sceny, tworząc w czasie rzeczywistym trójwymiarową mapę głębokości terenu i obiektów. Oprogramowanie wykorzystuje to do oddzielenia tła od pierwszego planu, aby selektywnie skupić się na znajdujących się na nim obiektach. Wynikające z tego efekty bokeh to tyko sztuczki. Ważne jest co innego.

Oprogramowanie przeprowadzające taką analizę widocznej sceny jednocześnie tworzy wirtualne okno na świat rzeczywisty. Korzystając z funkcji rozpoznawania gestów dłoni, użytkownicy mogliby za pomocą tej przestrzennej mapy naturalnie wchodzić w interakcję ze światem rzeczywistości mieszanej, z akcelerometrem telefonu i danymi GPS wykrywającymi i prowadzącymi do zmian w sposobie prezentacji i aktualizacji tego świata.

Zatem dodawanie kamer do smartfonów, które wydaje się z pozoru czczą zabawą i rywalizacją o to, kto da więcej, może ostatecznie mieć fundamentalny wpływ na interfejs maszynowy, a potem, kto wie, na sposoby interakcji międzyludzkiej.

Wracając na pole fotografii, wielu komentatorów zauważa jednak, że rozwiązania wielokamerowe mogą być ostatnim gwoździem do trumny wielu rodzajów aparatów fotograficznych, np. lustrzanek cyfrowych. Przekroczenie barier jakości obrazu powoduje, że sens istnienia zachowa jedynie specjalistyczny sprzęt fotograficzny najwyższej klasy. Podobnie może stać się z kamerami do nagrywania wideo.

Inaczej mówiąc, smartfony wyposażone w zespoły kamer różnego typu zastąpią nie tylko proste "pstrykawki", ale także większość profesjonalnych urządzeń. Czy w rzeczywistości tak się stanie - na razie trudno wyrokować. Póki co, uważają tak progności.

Mirosław Usidus