Czego AI nie może i co ją blokuje?

Społeczność badaczy uczenia maszynowego głęboko poruszył opublikowany w listopadzie 2020 r. artykuł zespołu AI Google pt. "Underspecification Presents Challenges for Credibility in Modern Machine Learning". Dokument zwraca uwagę na szczególnie drażliwy problem polegający na tym, że nawet jeśli modele uczenia maszynowego przechodzą testy dobrze, nie radzą sobie równie dobrze w świecie rzeczywistym. Błędy modeli, które nie osiągają wydajności w testach w świecie rzeczywistym, są znane od dawna, ale ta praca jest pierwszą, która publicznie udowadnia i wymienia ową "underspecification" (co można tłumaczyć jako "niedookreślenie") w roli głównej przyczyny problemów.

W przybliżeniu produkt uczenia maszynowego składa się z trzech etapów od pomysłu do wprowadzenia na rynek:

- Trening na przykładowych danych w celu zbudowania modelu;

- Testowanie modelu na danych, których nigdy wcześniej nie widział, aby potwierdzić, że model ma ogólne zastosowanie, a nie jest jedynie dopasowaniem do danych szkoleniowych;

- Zastosowanie w świecie rzeczywistym na nowych danych.

Proces ten opiera się na założeniu, że dobre wyniki na próbce testowej oznaczają dobre wyniki na danych rzeczywistych, z wyjątkiem systematycznych zmian pomiędzy testami a rzeczywistością (zwanych przesunięciem danych lub tendencyjnością). Na przykład model prognozujący sprzedaż odzieży uczony na przykładach zimowych będzie prawdopodobnie miał kłopoty w prognozowaniu w okresie letnim, ponieważ nauczył się dużo o grubych kurtkach, ale bardzo mało o szortach. Specjaliści w dziedzinie machine learningu muszą o tym pamiętać i szkolić system na odpowiednich danych.

Jednak naukowcy Google’a wsadzili kij w mrowisko, udowadniając, że nawet najlepsze w swojej klasie metodologie testowania nie dają pewności co do wymaganej wydajności w świecie rzeczywistym. Po testach niektóre modele będą znakomite w świecie rzeczywistym, ale niektóre rozczarują, i nie można tego przewidzieć z wyprzedzeniem.

Przyczynę specjaliści upatrują w tym, iż powtarzanie procesu szkolenia może wygenerować wiele różnych modeli o identycznych wynikach w testach. Każdy model różni się jedynie niewielkimi, arbitralnymi decyzjami dotyczącymi nauki, spowodowanymi, powiedzmy, losowo ustawionymi wartościami początkowymi lub kolejnością wejściowych danych treningowych. Różnice te są zazwyczaj uważane za nieistotne, ale okazuje się, że te pozornie przypadkowe zmiany mogą powodować znaczące, nieprzewidywalne odchylenia w świecie rzeczywistym.

To jest owa "niedookreśloność", która jest dużym kłopotem dla modeli obecnie modnych w firmach technologicznych (np. sieci neuronowe do rozpoznawania obrazów, systemy rekomendacji i głębokie nauczanie NLP). Występuje wtedy, gdy dostępne dane testowe mogą być równie dobrze dopasowane w wielu różnych konfiguracjach wewnętrznych obwodów obliczeniowych modelu. Kiedy modele mają wiele różnych sposobów na uzyskanie tego samego wyniku, nie możemy wiedzieć, które podejście jest umiejętnością, a które zdarzeniem losowym. Im więcej losowości w przewidywaniu danych testowych, tym większy zakres zmienności w kolejnych zastosowaniach w świecie rzeczywistym. Niepokoi to społeczność badaczy uczenia maszynowego, ponieważ pokazuje, że obecne metody testowania (dla modeli o dużej skali) nie gwarantują przewidywalnej, równoważnej wydajności w świecie rzeczywistym.

Wciąż te same modele

Aby było jasne, obserwowana nieprzewidywalność jest nieprzyjemna, ale rzadko paraliżuje całkowicie działanie systemów. Cykl treningowy i testowy jest zwykle wystarczający, aby wyeliminować czysto losowe modele. Po prostu niektóre modele, które odniosły sukces w testach, miały więcej szczęścia, niż oczekiwano. Jest to ostrzeżenie, ale nie znaczy, że modele nie działają i są błędne. Dla projektantów tego rodzaju AI to wyraźny sygnał, by skupili się na dobrych wynikach w świecie rzeczywistym, bo gdy okaże się, że ich systemy tam zawodzą, to ludzie stracą do nich zaufanie, często bezpowrotnie.

Nie wszyscy są tak ostrożni w krytyce AI. Według bardziej radykalnych opinii, pod wieloma względami utknęła ona w martwym punkcie. Algorytmy i sieci neuronowe wciąż osiągają nowe, imponujące wyniki, choćby AlphaFold firmy DeepMind trafnie przewidujący struktury białek czy GPT-3 stworzony przez OpenAI piszący artykuły nieodróżniane od napisanych ludzką ręką na podstawie krótkich podpowiedzi. Jednak większość tych systemów wciąż jest definiowana jako wąska inteligencja, potrafiąca wykonywać jedynie konkretne zadanie, do którego system był pieczołowicie szkolony na mnóstwie danych.

Tu warto wtrącić, iż akurat GPT-3 może być wyjątkiem, czyli pierwszym przykładem sztucznej inteligencji, która, choć nie jest "ogólna", przekroczyła definicję "wąskiej". Algorytm, choć był szkolony do pisania tekstów, ostatecznie potrafi także tłumaczyć między językami, pisać kod, autouzupełniać obrazy, wykonywać zadania matematyczne i inne zadania związane z językiem, do których nie był specyficznie szkolony. Jednak wszystkie możliwości GPT-3 są ograniczone do umiejętności, których nauczył się w dziedzinie języka (mówionego, pisanego lub języka programowania).

Zarówno sukces AlphaFolda, jak i GPT-3 wynikał w dużej mierze z ogromnych zbiorów danych, na których były trenowane. Nie były to żadne rewolucyjne nowe metody czy architektury treningowe. Jeśli wszystko, co jest potrzebne do rozwoju AI, to kontynuacja lub zwiększenie skali istniejącego modelu, czyli - więcej danych wejściowych daje większe możliwości, to wciąż zasadniczo mówimy tylko o jednym rodzaju technologii.

A ta nie jest doskonała. Może być wprowadzana w błąd za pomocą żenująco banalnych sztuczek. W kwietniu 2019 roku zespół badawczy chińskiego giganta technologicznego Tencent wykazał, że Tesla Model S w trybie autopilota może zostać oszukana i poprowadzona w zakręt, który nie istnieje. Wystarczy nakleić na drogę małe nalepki według określonego wzoru (2). Wcześniejsze badania w Stanach Zjednoczonych wykazały, że małe modyfikacje znaku stop mogą spowodować, że samochód bez kierowcy może uznać to za znak ograniczenia prędkości. Inne badania wykazały, że nadając określone, trudno identyfikowalne dźwięki, haker może spowodować, że głośnik Echo Amazona zamówi sam w sklepie rzeczy, których nie chcemy.

Techniki takiego "hakowania" AI nie polegają na włamywaniu się do systemów. Wykorzystują wiedzę o modelu do wmanewrowywania systemu w niepożądane zachowania. Robią to bez omijania jakiegokolwiek protokołu bezpieczeństwa. Nie jest to więc klasyczna cyberprzestępczość. Gdyby była, gdyby polegało to na łamaniu jakichś zabezpieczeń, uzyskiwaniu nieuprawnionego dostępu, to zapewne można byłoby algorytmy uczyć reagowania i obrony. Jednak AI nie może nauczyć się bronić przed atakami, które wykorzystują zasadniczo jej główne kompetencje.

Drogi algorytmie, Sherlockiem to ty nie jesteś

Jak pokazuje seria przykładów, niedoskonałości w działaniu sztucznej inteligencji do walki z przestępczością prowadzą do przykrych pomyłek o poważnych potencjalnie konsekwencjach. Policja ze stanu New Jersey znalazła się np. w ogniu krytyki po tym, jak na początku 2019 r. niesłusznie oskarżyła i aresztowała podejrzanego Nijeera Parksa na podstawie wskazania przez oprogramowanie Clearview AI do rozpoznawania twarzy. Potem pozwał on policję, a ta wycofała się z programu korzystania z AI. Prokurator generalny stanu New Jersey Gurbir Grewal nakazał policjantom zaprzestanie korzystania z technologii w styczniu 2020 r. - prawie cały rok po aresztowaniu Parksa.

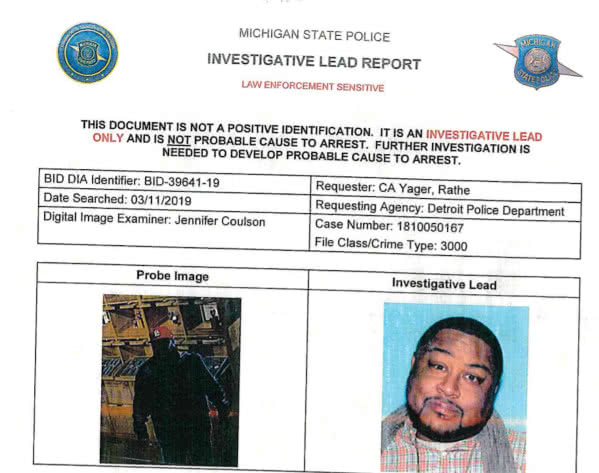

Inny znany przypadek wpadki tego typu to szeroko komentowana w mediach sprawa Roberta Juliana Borchak-Williamsa z Detroit. Kiedy wezwany Williams dotarł na posterunek, został aresztowany, ponieważ program do rozpoznawania twarzy ustalił, że to on był osobą widzianą na nagraniu z monitoringu kradzieży sklepowej z 2018 roku (3). Był niewinny i mógł to łatwo udowodnić, ale i tak musiał spędzić 30 godzin w więzieniu z powodu nadmiernego zaufania policjantów do AI.

Pomimo tych błędów w wielu miejscach wciąż trwają prace nad algorytmami sztucznej inteligencji mającymi przewidywać przestępstwo przed jego popełnieniem. Koncept taki, znany głównie ze sciencefiction, ma wielu zwolenników, np. szeryf w centralnej Florydzie zdecydował się zamówić system AI przewidujący, którzy z mieszkańców znajdujących się pod jego jurysdykcją najprawdopodobniej popełniliby przestępstwo. Do grona nachodzonych przez policję osób należał m.in. 15-letni Rio Wojecki. Nastolatek ukradł wcześniej rower elektryczny, dlatego przebywał pod opieką kuratora. Algorytm uznał, że Rio jest w pierwszej piątce osób, które mogą popełnić więcej przestępstw w hrabstwie. W efekcie pod jego drzwiami regularnie pojawiali się funkcjonariusze.

Jak podsumował we wrześniu 2020 r. dziennik "Tampa Bay Times", półroczne śledztwo dziennikarskie wykazało, że sztuczna inteligencja nie tylko nie zmniejszyła liczby przestępstw, ale spowodowała, że ponad dwadzieścia rodzin było regularnie nachodzonych przez służby, bo algorytm uznał je za potencjalne zagrożenie. Trudno więc mówić, że wizja rodem z "Raportu Mniejszości" w jakikolwiek sposób się sprawdza.

AI jeszcze dużo musi się nauczyć o świecie

Kolejne przykłady pokazują, że zdanie się na sztuczną inteligencję w wielu dziedzinach prowadzi do kłopotów. Gdy wybuchła pandemia, serwis YouTube zapowiedział, że od teraz będzie w większym stopniu niż wcześniej polegał na systemach uczenia maszynowego do oznaczania i usuwania materiałów naruszających regulamin serwisu, dezinformacji czy zawierających mowę nienawiści. Z serwisu zaczęło znikać znacznie więcej materiałów niż dotychczas, a przy tym wiele z nich niesłusznie.

Między kwietniem a czerwcem 2020 r. skasowano około jedenastu milionów filmów, czyli prawie dwa razy więcej niż miało to miejsce dotychczas. W związku z tymi zdjętymi materiałami serwis otrzymał ponad 320 tys. odwołań, co też jest dwukrotnie większą wartością niż kiedykolwiek wcześniej. Okazało się też m.in. że ponad połowa ze wspomnianych 11 milionów filmów została usunięta z YouTube’a bez obejrzenia ich przez kogokolwiek. YouTube, jak się wydaje, przeprosił się po tych doświadczeniach z moderatorami-ludźmi, a system AI wysłał do dalszej nauki.

Po okresie początkowej euforii z powodu nowej fali generatorów tekstu takich jak GPT-3 przyszła refleksja. Okazało się, że człowiek nadal tworzy lepsze treści niż AI, a to ze względu na problemy sztucznej inteligencji z logicznym rozumowaniem. Badania wykazały, że generatory tekstów oparte na sztucznej inteligencji są w stanie tworzyć treści poprawne gramatycznie, ale jeżeli chodzi o zgodność z prawami otaczającego nas świata, to ludzie nadal lepiej je pojmują.

Zespół naukowców z Uniwersytetu Południowej Kalifornii i kilku innych amerykańskich uczelni opracował testy badające umiejętności logicznego rozumowania. Polegały one na układaniu zdań, z wykorzystaniem do tego podanych rzeczowników i czasowniki. Jeden z generatorów tekstów, Unified Language Model, otrzymał od naukowców następujące wyrazy: pies, frisbee, rzucać, łapać. Zdanie, które stworzył to: "Dwa psy rzucają do siebie frisbee". Pomimo że jest zrozumiałe i poprawne gramatycznie, to jednak człowiek raczej tak nie napisze. Obraz psów rzucających sobie frisbee nie jest w sumie aż tak dziwaczny, jednak skłonni jesteśmy w roli rzucającego widzieć przede wszystkim człowieka.

Yuchen Lin, prowadzący badania, podsuwał, że teksty wygenerowane przez sztuczną inteligencję są w zdecydowanej większości poprawne gramatycznie, ale przedstawione w nich scenariusze są albo niemożliwe, albo po prostu zbyt dziwaczne, jak na świat, w którym żyjemy. AI stworzyła też takie zdanie: "Kosz na śmieci stoi pod albo na stole". Niby możliwe, ale zarówno obraz kosza na stole, jak i nawet pod stołem wydaje się dziwaczny i nietypowy. Badacze zauważają, że sieci neuronowe nie są często w stanie rozwinąć umiejętności logicznego myślenia, bo ich nauka opiera się na zapamiętywaniu rzeczy z zestawów danych i nie rozumieją przez to otaczającego nas świata.

Najbardziej chyba bolesną porażką AI, której nie omawia się i nie opisuje tak szeroko w mediach, jak jeszcze kilka lat temu szumnych zapowiedzi, jest to, co stało się ze sławnym Watsonem firmy IBM, który miał wspierać m.in. diagnostykę raka. Okazało się, że co innego wygrać z ludźmi teleturniej, a co innego dać sobie radę w roli lekarza. Jak pamiętamy, a pisał o tym także przed laty MT, system ten miał nawet "pozbawić lekarzy pracy". Watson, gdy już trafił do szpitali, doskonale sobie radził z analizą danych (np. skanów ludzkiego ciała), ale nie potrafił dobrać terapii do potrzeb konkretnego pacjenta i popełniał inne błędy, które go dyskwalifikowały. Dokładniej opisujemy tę historię w artykule o AI w medycynie.

Jeszcze nie teraz, ale AI "będzie umiała wszystko"

Pomimo niedoskonałości i porażek, jakie ponoszą algorytmy, specjaliści nie tracą optymizmu, uważając wszystkie te problemy za kolejne etapy w ewolucji AI, swoiste wąskie gardła rozwojowe, które, gdy zostaną przezwyciężone, pozwolą stworzyć po prostu lepsze algorytmy.

Pionier AI, Geoff Hinton (4), szef zespołu, który pracował nad znanym systemem rozpoznawania obrazów, ImageNet, twierdzi, że "głębokie uczenie maszynowe będzie w stanie zrobić wszystko". Pracował z głębokim nauczaniem od lat 80., ale wtedy jego skuteczność była ograniczona przez brak dużych zasobów danych i mocy obliczeniowej. Jego niezłomna wiara w tę technikę ostatecznie przyniosła ogromne korzyści. Niemal dekadę temu opracowany przez jego zespół ImageNet osiągnął niezwykłe przyrosty dokładności, zapoczątkowując w minionej dekadzie nową erę AI.

"Wierzę, że głęboka nauka będzie w stanie poradzić sobie ze wszystkim, ale myślę też, że musi nastąpić kilka koncepcyjnych przełomów. Na przykład, w 2017 roku Ashish Vaswani i inni wprowadzili transformatory pochodzące z udoskonalonych wektorów reprezentujących znaczenia słów. Był to przełom koncepcyjny. Obecnie jest on używany w prawie wszystkich najlepszych procesach przetwarzania w języku naturalnym (…)

Potrzebujemy też ogromnego wzrostu skali. Ludzki mózg ma około 100 bilionów połączeń, czyli parametrów. To, co dziś uważamy za naprawdę duży model, GPT-3, ma 175 miliardów. A więc jest tysiąc razy mniejszy niż mózg. GPT-3 może teraz generować całkiem wiarygodnie wyglądający tekst, a i tak jest malutki w porównaniu z mózgiem.

Tacy ludzie jak Hinton nie widzą w ograniczeniach, na jakich wciąż potyka się nauka maszynowa, zasadniczego problemu, który stawiałby pod znakiem zapytania sens rozwoju AI. Dla nich to tylko trudne zagadnienia, które jeszcze nie znalazły rozwiązania.

Mirosław Usidus