Sztuczna inteligencja

XIII–IV w. Hiszpański filozof Ramon Llull (1) opracowuje maszyny logiczne. Opisał swoje maszyny jako mechaniczne byty, które mogą łączyć podstawowe i niezaprzeczalne prawdy za pomocą prostych operacji logicznych, przeprowadzanych przez maszynę za pomocą mechanicznych znaczników.

lata 30-50. XX wieku Badania w neurologii wykazały, że mózg jest siecią neuronów, które wysyłają impulsy. Norbert Wiener opisuje cybernetyczne sterowanie i stabilność w sieciach elektrycznych. Claude Shannon tworzy teorię "informacji opisanych sygnałów cyfrowych".

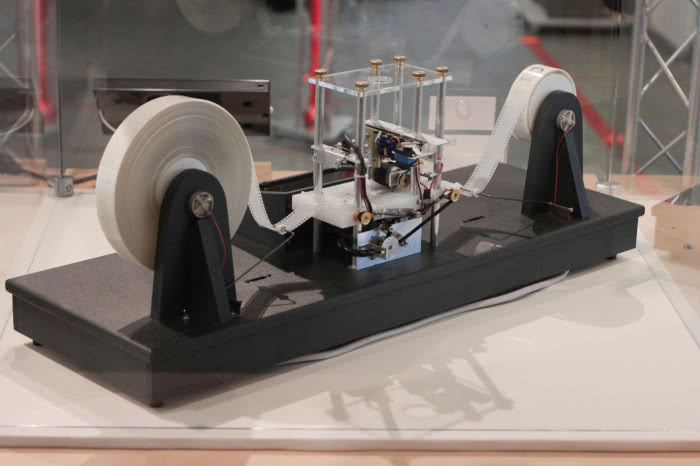

1936 Alan Turing publikuje pracę pt."O liczbach obliczalnych", której celem było rozwiązanie problemu rozstrzygalności, który został przedstawiony przez Davida Hilberta w 1928 r. To właśnie w niej wprowadził abstrakcyjną maszynę, która była w stanie wykonywać zaprogramowaną matematyczną operację, czyli algorytm.

Maszyna mogła wykonać tylko jeden, określony algorytm, na przykład mogła podnieść liczbę do kwadratu, podzielić, dodać, odjąć. W swojej pracy Turing opisał wiele takich maszyn, które uzyskały wspólne miano maszyn Turinga. Rozszerzeniem tej koncepcji była tak zwana uniwersalna maszyna Turinga, która w zależności od instrukcji zapisanej na taśmie miała wykonywać dowolną operację (2).

1943 Warren McCulloch i Walter Pitts pokazują, że sztuczny neuron może symulować proste operacje, tworząc model sieci neuronowej. Ich model był oparty wyłącznie na matematyce i algorytmach i nie można go było przetestować z powodu braku zasobów obliczeniowych.

1950 W swoim tekście pt. "Computing Machinery and Intelligence", opublikowanym w czasopiśmie "Mind", Alan M. Turing po raz pierwszy przedstawia test, nazywany potem "testem Turinga", Jest to sposób określania zdolności maszyny do posługiwania się językiem naturalnym i pośrednio mającym dowodzić opanowania przez nią umiejętności myślenia w sposób podobny do ludzkiego.

1951 Marvin Minsky oraz Dean Edmonds budują SNARC (ang. Stochastic Neural Analog Reinforcement Computer), pierwszą sztuczną sieć neuronową z 3 tys. lamp próżniowych. Maszyna odgrywała rolę szczura, który szuka wyjścia z labiryntu, by dotrzeć do pożywienia. System pozwalał śledzić wszystkie ruchy "szczura" w labiryncie. Błąd projektowy sprawił, że można było wprowadzić tam więcej niż jednego "szczura", w efekcie czego "szczury" zaczęły ze sobą współdziałać. Liczne próby, które podejmowały, pozwoliły im zacząć "myśleć" na logicznych podstawach, a to pomogło wzmocnić właściwe wybory. Za "szczurami" bardziej zaawansowanymi w nauce podążały inne "szczury".

1955 Allen Newell i (przyszły laureat Nagrody Nobla) Herbert A. Simon tworzą "Logic Theorist". Program ostatecznie dowodzi 38 z pierwszych 52 twierdzeń z "Principia Mathematica" Russella i Whiteheada, znajdując dla niektórych nowe i bardziej eleganckie dowody.

1956 Powstaje termin "sztuczna inteligencja". Po raz pierwszy użyto go podczas konferencji zorganizowanej przez Dartmouth College w New Hampshire (3). Nowe pojęcie zdefiniowano jako "system, który świadomie postrzega otoczenie i reaguje na nie tak, aby zmaksymalizować swoje szanse powodzenia". Wśród organizatorów wydarzenia byli m.in. Marvin Minsky, John McCarthy i dwóch starszych naukowców: Claude Shannon i Nathan Rochester z IBM.

1960 Budowa sieci elektrochemicznych uczących się elementów o nazwie Adaline. Zbudowana przez Bernarda Widrowa z Uniwersytetu Standforda sieć składała się z pojedynczych elementów Adaline (ang. Adaptive linear element), które powielone oraz połączone dały układ Madaline (ang. Many Adaline). Był to pierwszy neurokomputer oferowany komercyjnie. Sieć Madaline wykorzystywana jest w radarach, sonarach, modemach i liniach telefonicznych.

1966 Powstaje program ELIZA, prototypowy czatbot testowany w MIT. Został on zaprojektowany w prosty sposób: przekształcał zdania oznajmujące podane przez użytkownika w pytania i zadawał mu je, aby uzyskać kolejne stwierdzenia. Przykładowo, gdy użytkownik zwierzył się: "Boli mnie głowa", program pytał: "Dlaczego boli cię głowa?" ELIZA była z powodzeniem wykorzystywana do terapii osób z zaburzeniami psychicznymi.

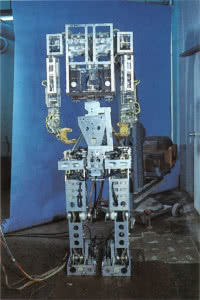

1967 W Japonii Uniwersytet Waseda zainicjował projekt WABOT (4) w 1967 r., pierwszego na świecie pełnowymiarowego inteligentnego robota humanoidalnego. Jego system kontroli kończyn pozwalał chodzić za pomocą kończyn dolnych oraz chwytać i przenosić przedmioty rękami za pomocą czujników dotykowych. Jego system wizyjny pozwolił mu mierzyć odległości i kierunki do obiektów za pomocą zewnętrznych receptorów, sztucznych oczu i uszu. A system konwersacyjny pozwalał mu komunikować się z osobą po japońsku, używając sztucznych ust.

1969 Marvin Minsky i Seymour Papert wykazują ograniczenia perceptronów. Napisana przez nich książka zawierała formalny dowód, że sieci jednowarstwowe mają bardzo ograniczony zakres zastosowań, co doprowadziło do stagnacji w tej dziedzinie badań. Taki stan utrzymywał się przez około 15 lat, aż do ukazania się serii publikacji, które w sposób bardzo sugestywny pokazywały, że sieci nieliniowe wolne są od ograniczeń pokazanych w pracy wcześniejszej. Jednocześnie w tym czasie ogłoszono szereg metod uczenia maszynowego sieci wielowarstwowych.

1973 Edward Shortliffe, lekarz i informatyk, stworzył program MYCIN, jeden z pierwszych systemów eksperckich do diagnostyki leczenia zakażeń bakteryjnych, oparty na sztucznej inteligencji, diagnozujący choroby krwi na podstawie wyników badań i obliczający prawidłowe dawki antybiotyków.

W latach 70. XX wieku większość lekarzy przed przepisaniem pacjentowi antybiotyków wymagała konsultacji ze specjalistą. Każdy antybiotyk oddziaływał bowiem na określoną grupę drobnoustrojów, ale wywołał też określone skutki uboczne. Wiedza na ten temat była jednak wśród zwykłych lekarzy mała. Dlatego Szkoła Medyczna Uniwersytetu Stanforda, ceniony na świecie ośrodek badawczy w dziedzinie antybiotyków, poprosiła o pomoc informatyków. Tak powstał artificial expert, system doradczy, który składał się z bogatej bazy danych i 500 zasad pomagających lekarzom właściwie stosować antybiotyki.

1975 Paul Werbos wymyśla propagację wsteczną, która rozwiązała problem i ograniczenia sieci jednowarstwowych i ogólnie uczyniła nauczanie sieci neuronowych bardziej wydajnym.

Lata 80. XX wieku Rozwój formy AI zwanej "systemami eksperckimi", a wiedza stała się przedmiotem zainteresowania głównego nurtu badań nad sztuczną inteligencją. Zamiast koncentrować się na ogólnej inteligencji, systemy eksperckie koncentrowały się na użyciu serii zasad w celu automatyzowania konkretnych zadań i podejmowania konkretnych decyzji w świecie rzeczywistym.

Pierwsze pomyślnie opracowane rozwiązanie, znane jaki RI, zostało wprowadzone przez firmę Digital Equipment Corporation w celu konfigurowania zamówień firmy i poprawiania dokładności. Wkrótce jednak firmy Apple i IBM wprowadziły uniwersalne komputery o większej mocy obliczeniowej niż te wykorzystywane do obsługi sztucznej inteligencji, rujnując branżę AI. To zatrzymało ponownie inwestycje w AI.

1988 Badacze w firmie IBM opublikowali pracę wprowadzającą zasady prawdopodobieństwa podczas automatycznego tłumaczenia języka francuskiego na angielski. To podejście, bardziej zbliżone do procesów kognitywnych zachodzących w ludzkim mózgu, zapewniło podwaliny pod dzisiejszą technologię uczenia maszynowego.

1989 Pojawia się ALVINN (Autonomous Land Vehicle In a Neural Network), który był wynikiem ośmiu lat badań finansowanych przez wojsko w instytucie robotyki CMU (5). Można go uznać za przodka dzisiejszych samochodów autonomicznych. Wdrożenie ALVINN przetwarzało dane z dwóch źródeł: kamery wideo i dalmierza laserowego. Był to system percepcyjny, który nauczył się sterować pojazdami, obserwując osobę prowadzącą. Wykorzystywał on sieć neuronową i podejmował decyzje bez potrzeby posiadania mapy.

Lata 90. W świecie AI przyjmuje się nowy paradygmat zwany "inteligentnymi agentami". Judea Pearl, Allen Newell, Leslie P. Kaelbling i inni zaproponowali zastosowanie teorii decyzji i ekonomii do badań nad sztuczną inteligencją.

1997 Deep Blue stworzony przez IBM wygrywa z arcymistrzem szachowym z Garrim Kasparovem (6). Superkomputer był wyspecjalizowaną wersją frameworka wyprodukowanego przez IBM i był w stanie przetwarzać dwa razy więcej ruchów na sekundę niż podczas pierwszego meczu (który maszyna przegrała), podobno 200 mln ruchów na sekundę.

1998 Pod świąteczne choinki trafiają cztery miliony uszatych robotów Furby, które z biegiem czasu uczą się angielskiego.

2002-09 W 2002 roku agencja DARPA rzuciła wyzwanie światu inteligentnych technologii: milion dolarów dla konstruktorów autonomicznego samochodu, który przejedzie 140 mil bezdroży pustyni Mojave. 18 maja 2005 roku na starcie wyścigu Grand Challenge stanął Stanley (7) - uzbrojony w lasery, radary, kamerę wideo, odbiornik GPS, sześć procesorów oraz zintegrowaną architekturę oprogramowania - i wygrał. Od tego czasu pojazd jest elementem ekspozycji Smithsonian Institution National Museum of American History. Wraz ze Stanleyem do historii sztucznej inteligencji przeszedł zespół konstruktorów z Uniwersytetu Stanforda, na którego czele stał prof. Sebastian Thrun, który kierował potem pracami nad samochodem autonomicznym Google’a powstałym w 2009 r.

2005 Honda prezentuje Asimo, humanoidalnego robota chodzącego na dwóch nogach (8). Podczas prac nad nim uzyskano dane, które wykorzystano na przykład przy projektowaniu protez umożliwiających poruszanie się seniorom.

2011 Superkomputer Watson firmy IBM, który w 2011 roku wygrywa z ówczesnymi mistrzami w teleturnieju "Jeopardy" (w Polsce emitowanym pod tytułem "Va Banque").

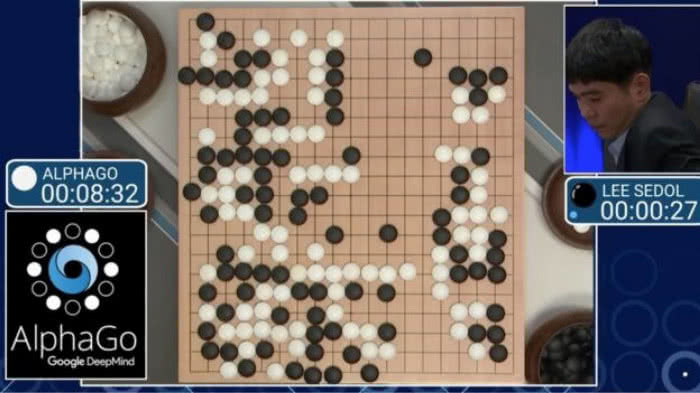

2016 Program komputerowy AlphaGo stworzony przez jedną ze spółek Google zwycięża z Lee Se-dolem, 18-krotnym mistrzem świata w Go (9).

2018 Google wraz z Allen Institute for Artificial Intelligence tworzą BERT-a, "pierwszą dwukierunkową, nienadzorowaną reprezentację językową, która może być wykorzystywana do różnych zadań z zakresu języka naturalnego przy użyciu transferu wiedzy". BERT to sztuczna inteligencja, która potrafi uzupełnić brakujące części zdań niemal tak samo dobrze, jak zrobiłby to człowiek. BERT to jedno z najciekawszych osiągnięć z dziedziny przetwarzania języka naturalnego (NLP), sektora sztucznej inteligencji, który w ostatnich latach rozwija się szczególnie szybko. Dzięki niemu dzień, w którym będziemy mogli porozmawiać z maszyną, znacznie się przybliżył.

2019 Głęboka sieć neuronowa o nazwie DeepCubeA, stworzona przez naukowców z Uniwersytetu Kalifornijskiego, ułożyła kostkę Rubika w 1,2 sekundy, niemal trzykrotnie szybciej niż najbardziej biegły w tym człowiek. Potrzebowała na to przeciętnie około 28 ruchów, podczas gdy człowiek wykonuje średnio 50 ruchów.

Klasyfikacja i zastosowania sztucznej inteligencji

I. Sztuczna inteligencja ma dwa podstawowe znaczenia:

- jest to hipotetyczna inteligencja realizowana w procesie inżynieryjnym, a nie naturalnym;

- jest to nazwa technologii i dziedzina badań naukowych informatyki czerpiąca także z osiągnięć neurologii, matematyki, psychologii, kognitywistyki i filozofii.

II. Literatura przedmiotu rozróżnia trzy główne stopnie AI:

- Wąska Sztuczna Inteligencja (Artificial Narrow Intelligence, ANI), która specjalizuje się w tylko jednym obszarze, jest to np. AlphaGo, czyli AI mogąca pokonać mistrza w grze Go. Jest to jednak jedyna czynność, którą jest w stanie przeprowadzić.

- Ogólna Sztuczna Inteligencja (Artificial General Intelligence, AGI) – zwana silną sztuczna inteligencją, odnoszącą się do komputera na poziomie intelektualnym przeciętnego człowieka – zdolna wykonać wszelkie zadania wykonywane przez niego. Zdaniem wielu ekspertów, jesteśmy na drodze dobudowy efektywnej AGI.

- Sztuczna Superinteligencja (Artificial Superintelligence, ASI). Oksfordzki teoretyk AI, Nick Bostrom, definiuje superinteligencję jako „intelekt znacznie mądrzejszy niż najinteligentniejsze ludzkie umysły pod praktycznie każdym względem, włącznie z twórczością naukową, ogólną wiedzą i umiejętnościami społecznymi”.

III. Współczesne praktyczne zastosowania AI:

- Technologie oparte na logice rozmytej – powszechnie stosowane np. do sterowania przebiegiem procesów technologicznych w fabrykach w warunkach „braku wszystkich danych”.

- Systemy eksperckie – systemy wykorzystujące bazę wiedzy i mechanizmy wnioskowania do rozwiązywania problemów.

- Maszynowe tłumaczenie tekstów – systemy tłumaczące nie dorównują człowiekowi, robią intensywne postępy, nadają się szczególnie do tłumaczenia tekstów technicznych.

- Sieci neuronowe – używane z powodzeniem w wielu zastosowaniach łącznie z programowaniem „inteligentnych przeciwników” w grach komputerowych.

- Uczenie maszynowe – dział sztucznej inteligencji zajmujący się algorytmami potrafiącymi uczyć się podejmować decyzje bądź nabywać wiedzę.

- Eksploracja danych – omawia obszary, powiązanie z potrzebami informacyjnymi, pozyskiwaniem wiedzy, stosowane techniki analizy, oczekiwane rezultaty.

- Rozpoznawanie obrazów – stosowane są już programy rozpoznające osoby na podstawie zdjęcia twarzy lub rozpoznające automatycznie zadane obiekty na zdjęciach satelitarnych.

- Rozpoznawanie mowy i rozpoznawanie mówców – stosowane już powszechnie na skalę komercyjną.

- Rozpoznawanie pisma (OCR) – stosowane już masowo np. do automatycznego sortowania listów oraz w elektronicznych notatnikach.

- Sztuczna twórczość – istnieją programy automatycznie generujące krótkie formy poetyckie, komponujące, aranżujące i interpretujące utwory muzyczne, które są w stanie skutecznie „zmylić” nawet profesjonalnych artystów, tak, że ci nie uznają utworów za wygenerowane sztucznie.

- W ekonomii powszechnie stosuje się systemy automatycznie oceniające m.in. zdolność kredytową, profil najlepszych klientów czy planujące kampanie reklamowe. Systemy te poddawane są wcześniej automatycznemu uczeniu na podstawie posiadanych danych (np. klientów banku, którzy regularnie spłacali kredyt i klientów, którzy mieli z tym problemy).

- Inteligentne interfejsy – stosowane do zautomatyzowanego zarządzania, monitorowania, raportowania oraz podjęcia prób rozwiązywania potencjalnych problemów w procesach technologicznych.

- Prognozowanie i wykrywanie oszustw – przy użyciu m.in. regresji logistycznej systemy analizują zbiory danych w celu wychwytywania np. podejrzanych transakcji finansowych.

M.U.