Postępy w hakowaniu mózgu dla AI i odwrotnie. Neurony i ruch

Przedstawiciele Synchrona tłumaczą, że ich technologia polega na wprowadzeniu do mózgu wewnątrznaczyniowego implantu (1) typu brain-computer interface. Dzieje się to w nieinwazyjny sposób, bez potrzeby wiercenia otworów w czaszce czy operacji na otwartym mózgu. Implant wprowadza się do mózgu przez tętnicę szyjną.

Co jeszcze potrafi taki implant? Na razie ma ograniczoną funkcjonalność, ale oprócz wysyłania wiadomości za pomocą serwisów społecznościowych i smartfona, jego użytkownik może sterować najróżniejszymi urządzeniami. Inżynierowie zapewniają, że tak naprawdę funkcjonalność implantu jest zależna od oprogramowania, całkiem tak jak w smartfonach.

Nad interfejsem mózg-komputer pracuje również, co jest faktem znanym i głośnym od dawna, firma Neuralink. Elon Musk ma jednak nieco inną koncepcję. Jego implant będzie wprowadzany do mózgu przez specjalne urządzenie. Ma to być metoda bezbolesna, ale inwazyjna. Na razie testy z powodzeniem prowadzone są na małpach, które grały w grę Pong z wykorzystaniem implantu. Pierwsze eksperymenty z udziałem ludzi mają rozpocząć się w 2022 roku. Na dobry początek implant Neuralink ma pozwolić normalnie funkcjonować ludziom sparaliżowanym, ale w przyszłości ma odmienić nie do poznania życie milionów całkiem zdrowych ludzi, którzy będą pragnęli stać się „nadludźmi" i posiąść niedostępne dla nikogo dotychczas zdolności.

Jak pisaliśmy kilka miesięcy temu w MT, również naukowcy ze Stanfordu opracowali implant mózgowy, który pozwala człowiekowi ze sparaliżowanymi rękami "pisać" do 90 znaków na minutę, po prostu myśląc o słowach. Naukowcy opublikowali swoje odkrycia w "Nature" w maju 2021 r. Implant neuronowy Stanford pozwolił pacjentowi pisać na klawiaturze poprzez wyobrażenie sobie, że pisze słowo ręką. Sztuczna inteligencja dekodowała sygnały neuronowe i wyświetlała słowo na ekranie. Zespół połączył system implantu neuronowego z funkcją autokorekty, co zaowocowało 99-procentowym wskaźnikiem dokładności.

Jak przekonać ludzi, że wszczepianie czujników elektrodowych do mózgu jest bezpieczne? Nie będzie to łatwe, szczególnie że pojawiają się nowe pomysły na hakowanie mózgu, którymi implanty umieszczone pod czaszką mogłyby otworzyć bramę do sfer całkowicie dotychczas prywatnych. Na przykład snów. Badacze z Harvardu, MIT i University of Montreal opublikowali esej na temat hakowania snów w czasopiśmie "Aeon", ostrzegając, że według ostatnich badań, 77 proc. marketerów planuje wykorzystać dreamtech reklamowy w ciągu najbliższych trzech lat.

"Wiele badań marketingowych otwarcie testuje nowe sposoby zmiany i napędzania zachowań zakupowych poprzez sen i hakowanie snów", piszą. Dwóch autorów eseju pracowało wcześniej nad urządzeniem MIT zaprojektowanym do komunikowania się ze śpiącymi obiektami, a nawet „hakowania" ich snów. Szczególne obawy, napisali, wzbudzała kampania reklamowa koncernu piwnego Molson Coors przed finałem Super Bowl, który w swoich reklamach obiecał darmowe piwo w zamian za udział w badaniach nad snami.

Naukowcy zwrócili uwagę, że Coors użył sformułowania "ukierunkowana inkubacja marzeń sennych", terminu ukutego przez naukowców we wcześniejszej pracy z 2020 roku, co oznacza, że reklamodawcy rzeczywiście pilnie przyglądają się tej dziedzinie badań. W "Aeon" naukowcy przywołują przykład badań, które wykazały, że mieszanie nieprzyjemnych zapachów z dymem papierosowym podczas snu palaczy ograniczało ilość wypalanych papierosów następnego dnia, ale same obiekty nie pamiętały jakichkolwiek odczuć ze snu.

Sztuczne neurony nie dorównują biologicznym

Nasze miękkie mózgi wydają się bardzo inne od twardych krzemowych chipów. Mimo to uczeni mają na koncie mają długą historię porównywania tych dwóch układów przetwarzających i prób naśladownictwa biologicznego mózgu w komputerach z jednej strony oraz przeniesienia elementów elektronicznych do mózgu, o czym mowa wyżej, - z drugiej.

Obecnie najpotężniejsze systemy sztucznej inteligencji wykorzystują rodzaj uczenia maszynowego zwanego głębokim uczeniem maszynowym. Algorytmy AI uczą się, przetwarzając ogromne ilości danych przez ukryte warstwy połączonych ze sobą węzłów, zwanych głębokimi sieciami neuronowymi. Jak sugeruje ich nazwa, głębokie sieci neuronowe zostały zainspirowane prawdziwymi sieciami neuronowymi w mózgu (2), z węzłami wzorowanymi na prawdziwych neuronach, lub przynajmniej na tym, co neurobiolodzy wiedzieli o neuronach w latach 50., kiedy powstał najbardziej chyba popularny model neuronu zwany perceptronem. Od tego czasu nasza wiedza o złożoności obliczeniowej neuronów znacznie się poszerzyła. Wiadomo, że biologiczne neurony są znacznie bardziej złożone niż sztuczne.

Sieci neuronowe, które naśladują podstawową strukturę mózgu, stały się niezwykle popularne w latach 80. Jednak w tamtym czasie brakowało mocy obliczeniowej i danych treningowych, których algorytmy potrzebowały, aby stać się naprawdę skuteczne. To się zmieniło wraz z rozwojem technik obliczeniowych i internetu, który daje ogromne zasoby danych, tekstowych i wizualnych.

W ostatnim czasie David Beniaguev, Idan Segev i Michael London z Uniwersytetu Hebrajskiego

w Jerozolimie wyszkolili sztuczną, głęboką sieć neuronową, aby naśladowała obliczenia symulowanego neuronu biologicznego. Wykazali oni, że głęboka sieć neuronowa wymaga od pięciu do ośmiu warstw połączonych ze sobą "neuronów", aby odwzorować złożoność pojedynczego neuronu biologicznego. Prawdę mówiąc, nie spodziewali się takiej złożoności. "Myślałem, że będzie to prostsze i mniejsze", komentował w mediach Beniaguev. Spodziewał się, że trzy lub cztery warstwy wystarczą, aby uchwycić obliczenia wykonywane wewnątrz komórki biologicznej.

Najbardziej podstawowa analogia pomiędzy sztucznymi i prawdziwymi neuronami dotyczy tego, jak radzą sobie one z przychodzącymi informacjami. Oba rodzaje neuronów odbierają przychodzące sygnały i decydują, czy wysłać swój własny sygnał do innych neuronów. Sztuczne neurony polegają na stosunkowo prostych obliczeniach, aby podjąć tę decyzję. Badania wykazały, że proces ten jest znacznie bardziej skomplikowany w neuronach biologicznych.

Uczeni stworzyli symulację funkcji wejścia-wyjścia neuronu typu znanego jako neuron piramidowy, pochodzącego z kory mózgowej szczura z wyraźnymi gałęziami dendrytycznymi na górze i na dole. Następnie wprowadzili symulację głębokiej sieci neuronowej, która miała do 256 sztucznych neuronów w każdej warstwie. Zwiększali liczbę warstw, aż osiągnęli 99-procentową dokładność na poziomie milisekund pomiędzy wejściem a wyjściem symulowanego neuronu. Głęboka sieć neuronowa z powodzeniem przewidywała zachowanie funkcji wejścia-wyjścia neuronu z co najmniej pięcioma, ale nie więcej niż ośmioma, sztucznymi warstwami. W większości sieci oznaczało to tysiąc sztucznych neuronów dla jednego neuronu biologicznego.

"Związek pomiędzy liczbą warstw w sieci neuronowej a złożonością sieci nie jest oczywisty", komentował w komunikacie badawczym London. "Nie możemy więc powiedzieć, o ile bardziej złożona jest sieć, gdy przechodzimy z, powiedzmy, czterech warstw do pięciu. Nie możemy też powiedzieć, że potrzeba tysiąca sztucznych neuronów oznacza, że biologiczny neuron jest dokładnie tysiąc razy bardziej złożony. Próbowaliśmy wielu architektur z wieloma głębokościami i wieloma rzeczami, i w większości przypadków nie udało nam się".

Autorzy podzielili się swoimi wynikami i kodem, aby zachęcić innych badaczy do znalezienia wydajniejszego rozwiązania z mniejszą liczbą warstw. Jeśli każdy biologiczny neuron jest jak pięciowarstwowa sztuczna sieć neuronowa, to być może sieć klasyfikacji obrazów z pięćdziesięcioma warstwami jest odpowiednikiem dziesięciu prawdziwych neuronów w sieci biologicznej.

Sztuczne sieci neuronowe mają co najmniej dwie warstwy perceptronów, jedną dla warstwy wejściowej i jedną dla wyjściowej. Po dodaniu jednej lub więcej "ukrytych" warstw pomiędzy warstwą wejściową i wyjściową otrzymujemy 'głęboką" sieć neuronową. Im większa liczba ukrytych warstw, tym głębsza sieć.

Czy model głębokiej sieci dla jakiejś części mózgu nie jest po prostu zastąpieniem jednej czarnej skrzynki inną? Badacze zwykle komentują to w ten sposób, że głębokie sieci neuronowe wciąż są łatwiejsze do zrozumienia niż mózg.

Badacze na Uniwersytecie Stanforda pracują nad stworzeniem nienadzorowanych sieci głębokich, które będą mogły uczyć się równie efektywnie jak przetwarzanie mózgowe. Głębokie sieci uczą się m.in. za pomocą algorytmu zwanego propagacją wsteczną, który zdaniem większości neurobiologów nie może działać w prawdziwej tkance nerwowej, ponieważ brakuje jej odpowiednich połączeń. A to tylko jeden z przykładów analogii pomiędzy biologiczną a sztuczną inteligencją, które nie działają.

Odtwarzanie kory mózgowej

Nasze mózgi robią znacznie więcej niż kategoryzowanie tego, co jest na zewnątrz. Ludzki system widzenia potrafi zrozumieć geometrię powierzchni i trójwymiarową strukturę sceny, a także potrafi wnioskować o leżących u podstaw czynnikach przyczynowych, na przykład może wywnioskować w czasie rzeczywistym, że drzewo zniknęło, tylko dlatego, że przejechał przed nim samochód. Trzylatek w zoo intuicyjnie będzie wiedział, że długonose stworzenie skubiące liście to ta sama rzecz, co żyrafa z książki z obrazkami. Ten pozornie łatwy wyczyn jest w rzeczywistości bardzo skomplikowany i dla maszyny niemożliwy w tej chwili do osiągnięcia.

Rysunek w książeczce to zastygła sylwetka złożona z prostych linii, podczas gdy żywe zwierzę jest pełne kolorów, faktur, ruchu i światła. Może przybierać różne kształty i wygląda inaczej pod każdym kątem. Ludzie doskonale radzą sobie z tego typu zadaniami. Potrafimy bez wysiłku wychwycić najważniejsze cechy obiektu na podstawie zaledwie kilku przykładów i zastosować te cechy do nieznanego nam obiektu. Maszyny zazwyczaj muszą przejrzeć całą bazę danych obrazów żyraf, pokazanych w wielu sceneriach i z różnych perspektyw, aby nauczyć się dokładnie rozpoznawać to zwierzę.

"Ludzie są o wiele lepszymi generalistami", mówi „Quanta Magazine" Tai Sing Lee, informatyk i neurobiolog z Carnegie Mellon University w Pittsburghu. "Wciąż jesteśmy bardziej elastyczni w myśleniu i potrafimy przewidywać, wyobrażać sobie i tworzyć przyszłe zdarzenia". "Dzisiejsze uczenie maszynowe zawodzi tam, gdzie ludzie są najlepsi", wtóruje mu Jacob Vogelstein, który kieruje programem w Intelligence Advanced Research Projects Activity (IARPA). "Chcemy zrewolucjonizować uczenie maszynowe poprzez inżynierię wsteczną algorytmów i obliczeń mózgu". Obaj biorą udział w projekcie IARPA, nazwanego Machine Intelligence from Cortical Networks (MICrONS). Naukowcy zamierzają w nim stworzyć mapę milimetra sześciennego kory mózgowej, który zawierałby około 100 tys. neuronów, od 3 do 15 milionów połączeń neuronalnych, czyli synaps.

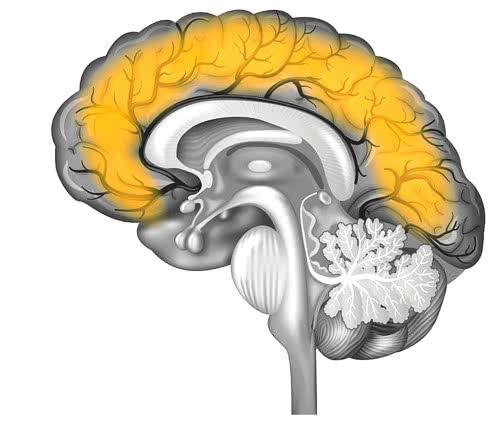

Pofałdowana kora mózgowa pod wieloma względami jest mikroprocesorem mózgu. Warstwa ta, o grubości około trzech milimetrów, składa się z serii powtarzających się modułów lub mikroobwodów, podobnych do tablicy bramek logicznych w chipie komputerowym. Każdy moduł składa się z około 100 tys. neuronów ułożonych w skomplikowaną sieć połączonych ze sobą komórek. Dowody sugerują, że podstawowa struktura tych modułów jest mniej więcej taka sama w całej korze mózgowej. Jednak moduły w różnych regionach mózgu są wyspecjalizowane do określonych celów, takich jak widzenie, ruch lub słuch.

Naukowcy wychodzą od znanej od dziesięcioleci teorii postrzegania, zwanej analizą przez syntezę. Zgodnie z tą koncepcją mózg przewiduje to, co wydarzy się w najbliższej przyszłości, a następnie uzgadnia te przewidywania z tym, co widzi. Siła tego podejścia leży w jego wydajności, gdyż wymaga mniej obliczeń niż ciągłe odtwarzanie każdego momentu w czasie.

Typowa dla współczesnych sieci neuronowych struktura "podawania dalej" pomiędzy warstwami pomija istotny element systemu biologicznego - sprzężenie zwrotne, zarówno w obrębie poszczególnych warstw, jak i z warstw wyższego rzędu do warstw niższego rzędu. W biologicznym mózgu neurony w jednej warstwie kory mózgowej są połączone ze swoimi sąsiadami, a także z neuronami w warstwach powyżej i poniżej, tworząc skomplikowaną sieć pętli. Istnieje tyle samo połączeń zwrotnych, co połączeń typu „podaj dalej" - uważają uczeni.

Jednak neurobiolodzy nie rozumieją jeszcze, jak dokładnie działają pętle sprzężenia zwrotnego, choć wiedzą, że są one ważne dla naszej zdolności do kierowania uwagą, pomagają nam np. słuchać głosu w telefonie, jednocześnie niwelując zakłócenia, choćby hałas miasta. Celem badaczy w projekcie MICrONS jest rozszyfrowanie zasad rządzących pętlami sprzężeń zwrotnych.

Zmienność i stabilność wiedzy

W swojej niedawno wydanej książce "A Thousand Brains: A New Theory of Intelligence" (3) naukowiec i przedsiębiorca Jeff Hawkins analizuje najnowsze badania przeprowadzone przez swój zespół nad korą nową (4), częścią mózgu, która jest odpowiedzialna za naszą zaawansowaną inteligencję.

W ciągu ostatnich lat naukowcy zaczęli dostrzegać, że mózg biologiczny jest maszyną predykcyjną. Tworzy on model świata i nieustannie przewiduje, co się stanie za chwilę. Kiedy przewidywania naszego mózgu nie są poprawne, zdajemy sobie sprawę, że coś jest nie tak i nasz mózg aktualizuje swój model świata. W miarę upływu czasu nasz model świata staje się coraz bogatszy i bardziej wyrafinowany. Tak więc w pewnym sensie żyjemy w symulacji, gdyż to, co postrzegamy, jest tak naprawdę modelem, który konstruuje mózg, a nie "rzeczywistością", która istnieje na zewnątrz. To wyjaśnia zjawiska fantomowych kończyn i podobne. Hawkins uważa, że nasz mózg uczy się modelu świata, analizując, jak dane wejściowe, które otrzymuje, zmieniają się, gdy się poruszamy (lub gdy owe dane się poruszają).

Jednak, jeśli nasza kora mózgowa nieustannie dokonuje bardzo dużej ilości przewidywań i dostosowuje się do wszelkich rozbieżności między swoimi modelami a tym, co postrzega, dlaczego nie zauważamy tych procesów, a zamiast tego postrzegamy jedną ciągłą rzeczywistość?

Zdaniem Hawkinsa kora zawiera komórki czy też, jak to ujmuje, kolumny z zakodowanymi (zapisanymi?) ramami odniesienia, które są jak siatki o wielu wymiarach, które pomagają mózgowi zorganizować każdy rodzaj wiedzy. Myślenie zachodzi, gdy zmieniamy położenie w obrębie tych ram odniesienia. Zatem to, o czym teraz myślimy, co jest teraz w naszej głowie, zależy od tego, gdzie w danym momencie znajdują się nasze kolumny kory mózgowej w różnych ramach odniesienia. Myśli ewoluują, w miarę jak mózg porusza się po tych strukturach. Istotą myślenia, a co za tym idzie uczenia się, jest ruch i dynamiczna zmiana.

Struktury kory mózgowej postrzegają, zdobywają wiedzę i uczą się, w miarę jak dane wejściowe zmieniają się w czasie. Nasza wiedza o czymkolwiek, obiekcie czy pojęciu, jest rozłożona na tysiące "kolumn" w korze, na tysiące uzupełniających się modeli. Wiedza ta jest zarazem odporna na uszkodzenia.

Można ująć to inaczej - nasza percepcja rzeczywistości jest wynikiem swoistego procesu głosowania. Różne kolumny kory osiągają konsensus poprzez głosowanie i to właśnie tworzy pojedynczą percepcję, która ujednolica różne przewidywania pochodzące z różnych części systemu (co może być również związane z różnorodnością typów wejść sensorycznych). Tylko niektóre komórki muszą głosować. Jak głosują? Kiedy rozpoznajemy jakiś obiekt, nasze kolumny kory osiągnęły konsensus co do tego, na co patrzymy.

Komórki głosujące (neurony) w każdej z naszych kolumn tworzą stabilny wzór, który reprezentuje ten obiekt i to, gdzie on się znajduje w stosunku do nas. I tak długo, jak postrzegamy ten sam obiekt, stan tych neuronów głosujących nie zmienia się, gdy wchodzimy w interakcję z tym elementem. Inne neurony zmienią swój stan, gdy my będziemy się poruszać lub obiekt będzie się poruszał, ale neurony głosujące pozostaną stabilne. Dlatego właśnie nasza percepcja jest stabilna i nie jesteśmy świadomi tego, jak wiele aktywności związanych z poruszającymi się przewidywaniami ma miejsce. Jesteśmy świadomi jedynie ostatecznych stabilnych wzorców, które powstają w wyniku konsensusu osiągniętego przez głosujące komórki.

Ruch jest kluczowy dla sposobu, w jaki mózg postrzega świat. To właśnie dzięki ruchowi (naszemu lub otaczającego nas świata) nasz mózg może wzbogacać swoje wewnętrzne modele obiektów i pojęć (ruch nie musi być fizyczny, może być wirtualny).

Wykorzystanie jednej zasady do przetwarzania wszystkich rodzajów danych wejściowych i tworzenia tysięcy przewidywań i modeli dla każdego elementu, z którym wchodzimy w interakcję, czyni te modele bogatymi i wszechstronnymi. Mechanizm konsensusu osiągniętego poprzez głosowanie oznacza, że nasze postrzeganie świata jest stabilne, a jednocześnie elastyczne i odporne.

Perturbacje w naszych sensorycznych wejściach mogą nas zdezorientować i sprawić, że będziemy interpretować rzeczy w niewłaściwy sposób. Większość z nas doświadczyła szerokiej gamy złudzeń optycznych. Jednak ogólnie rzecz biorąc, nasza percepcja jest spójna i dość odporna, a na pewno o wiele bardziej spójna niż ta, którą znajdujemy w dzisiejszych systemach głębokiego uczenia, gdzie niewidoczne zmiany mogą całkowicie zmienić wyniki ostateczne.

Prowadzi to do wniosku, że odtworzenie tego elastycznego, odpornego a zarazem twórczego systemu, który znamy z mózgu, stanowi największe wyzwanie dla sztucznych sieci neuronowych. Elementem, który właściwie nie jest brany pod uwagę w rozwoju AI, jest ów ruch i dynamizm, będący podstawą zdobywania wiedzy o świecie dla ludzi. Wprowadzenie tego nie będzie łatwe, ale nie wydaje się niemożliwe.

Mirosław Usidus