Gdzie jest i co robi sztuczna inteligencja? Zapracowane modele

Zarazem, wraz z rosnącą popularnością rozwiązań AI i uczenia maszynowego w przedsiębiorstwach, rośnie też zainteresowanie ich możliwie efektywnym wykorzystaniem. Niezależnie od tego, czy chodzi o dane, modele/eksperymenty, czy też zasoby obliczeniowe. Firma Gartner szacuje, że do 2025 roku ponad 30 proc. nowych leków i materiałów będzie systematycznie odkrywanych przy użyciu technik generatywnej sztucznej inteligencji.

Sztuczna inteligencja typu GAN (ang. skrót od Generative Adversarial Networks) już teraz powszechnie wykorzystywana jest do konwersji tekstu na obraz, obrazu na obraz, podnoszenia rozdzielczości i jakości obrazów, w różnego rodzaju gadżetach i rozrywkowych aplikacjach do np. postarzania twarzy, generowania emotikonek, przetwarzania NFT itp.

W związku z powszechną adaptacją rozwiązań machine learningu, powstaje coraz więcej modeli i eksperymentów. Pojawia się potrzeba zarządzania nimi, monitorowania i zarządzania całym procesem operacjonalizacji. Pojawiają się dziedziny praktycznej aktywności deweloperskiej nazywane kolejno MLOps, ModelOps, DataOps. Gartner prognozuje, że do 2025 roku 70 proc. organizacji biznesowych będzie miało zoperacjonalizowane dojrzałe architektury AI z zastępami specjalistów.

Konsultuje, doradza i chroni prywatność

AI zademonstrowała imponujące możliwości związane z tworzeniem, od zdolności komponowania muzyki, po umiejętność pisania wierszy czy tworzenia obrazów. W jaki sposób może to przynieść korzyści przeciętnemu konsumentowi lub firmom walczącym z ostrą konkurencją na rynku?

Jednym z najbardziej popularnych zastosowań AI są wszelkiego rodzaju chatboty (2), które pozwalają w coraz większym stopniu rozwiązać problemy petentów lub klientów bez kontaktowania się z prawdziwymi ludźmi. Chatboty dzielą się na różne kategorie: głosowe, tekstowe, medyczne, finansowe i wiele innych. Mogą słuchać i odpowiadać na pytania i prośby, reagując aktywnie na wymagania klientów. Pojawiły się już "domowe" boty napędzane przez AI. Na przykład Amazon niedawno zademonstrował Astro, robota, który może podążać za domownikami, łączyć się z Alexą, monitorować bezpieczeństwo itp.

Największe sukcesy AI w biznesie to zapewne zastosowania w systemach rekomendacji i dynamicznym ustalaniu cen. Niezależnie od tego, czy jest to sprzedaż, kupon na zniżkę, rekomendacje, ceny, pomoc algorytmów jest dziś już więcej niż doceniana. Można też oczekiwać wzrostu ilości danych zbieranych przez chatboty, cyfrowych asystentów, itp. Coraz więcej instytucji finansowych korzysta z technologii opartych na AI do prowadzenia analityki przewidującej, identyfikacji oszustw, obliczania ryzyka dla klienta i wyceny aktywów. Zwiększenie szybkości i trafności przewidywań dla firm zajmujących się rynkiem finansowym jest kluczowe jako główny wyznacznik sukcesu i pozytywnej oceny w oczach klientów.

Pomimo że Watson IBM-a nie był sukcesem, sztuczna inteligencja udowodniła swoją przydatność i skuteczność w pewnych rodzajach diagnostyki medycznej. AI może uczyć się lepiej, szybciej i na większych zbiorach danych niż człowiek, rozpoznając szybciej i trafniej chorobowe wzorce wśród pacjentów. Jeśli nawet sztuczna inteligencja w dającym przewidzieć się czasie nie zastąpi lekarzy, to z pewnością może lekarzom pomagać, jeśli oczywiście będą chcieli takiej pomocy i nauczą się z niej efektywnie korzystać.

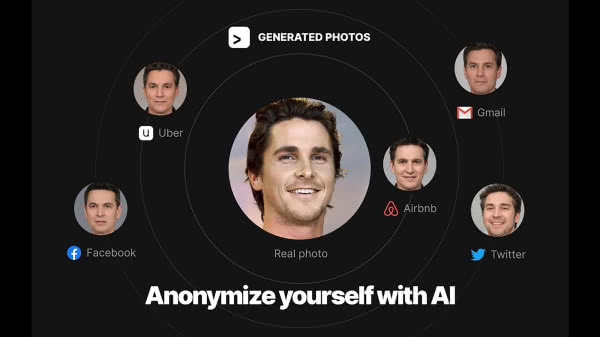

AI może nawet pomóc nam bronić się przed inwigilacją i inwazją na prywatność np. ze strony coraz bardziej wszędobylskich technik rozpoznawania twarzy. Startup Generated Media proponuje nam zastąpienie w sieci własnej twarzy zaawansowaną technologicznie podróbką stworzoną przez sieć neuronową. Fałszywka pozwala ludziom poznać wygląd użytkownika, zachowując jednocześnie anonimowość jego prawdziwej twarzy.

Mechanizm pozwala zresztą generować wiele twarzy, co ma całkowicie dezorientować wścibskie algorytmy. Generated Media wykorzystuje GAN konfrontującą ze sobą dwie rywalizujące sieci neuronowe. Generowane w narzędziu internetowym o nazwie Anonymizer twarze wyglądają zupełnie jak twarze prawdziwych ludzi, mogą być do oryginalnej twarzy użytkownika podobne na tyle, że znajomi uznają je za swoistą nawet prawdopodobną przeróbkę. Są jednocześnie czymś zupełnie niepowtarzalnym i nieznanym "w realu" (3).

Ostatnio dużo się mówi o metawersum, czyli połączeniu wirtualnej rzeczywistości, rzeczywistości rozszerzonej, światów online, spersonalizowanych doświadczeń i gier, które umożliwiają jednostkom interakcję, prowadzenie interesów i budowanie tożsamości całkowicie online. Wiele firm prześciga się w rozwijaniu i zajmowaniu części metawersum, którego elementy są już dostępne dla użytkowników w popularnych aplikacjach, takich jak Roblox. Co to ma wspólnego z AI? Sztuczna inteligencja ma do odegrania wiele ról w metawersum, od generowania syntetycznych postaci, przez tworzenie historii, po optymalizację doświadczeń VR.

Obecnie, gdy AI jest obecna w każdej branży, strategie AI są opracowywane przez każdy kraj. Pojawiają się również nowe przepisy regulujące AI i związane z nią aspekty, takie jak prywatność, AI jest obecnie wymogiem edukacyjnym w wielu zawodach. Bardzo prawdopodobne, że wkrótce pojawi się nowa kategoria specjalności na rynku pracy, zwana z angielska "AI Enabled Practitioners". To osoby, które rozumieją rolę AI w swoim zawodzie, niezależnie od tego, czy jest to praca w medycynie, sektorze prawnym, zasobach ludzkich, sprzedaży czy czymkolwiek innym.

Zjawiskiem stosunkowo nowym jest zainteresowanie rządów i świata polityki narzędziami AI. Wiadomo od pewnego czasu, że władze Szwajcarii i Chin zamierzają sięgać po technologie sztucznej inteligencji, by efektywniej prowadzić dyplomację na arenie międzynarodowej.

Eksperci uważają, że algorytmy mogą okazać się pomocne w szybszym osiągnięciu konsensusu w negocjacjach na najwyższym szczeblu. Miałaby ona stać się niejako cyfrowym odpowiednikiem ministra spraw zagranicznych i pomagać jemu oraz jego zespołowi w podejmowaniu skuteczniejszych decyzji, wolnych od strachu, emocji i obaw natury moralnej.

Systemy sztucznej inteligencji mogą wykorzystywać siłę naukową i technologiczną do odczytywania i analizowania danych w taki sposób, z jakim ludzie nie mogą się równać. Systemy AI nie będą uwzględniały nawet czynników moralnych, które są sprzeczne z celami strategicznymi. Michael Abmühl, były szwajcarski sekretarz stanu do spraw zagranicznych, przyznał, że kilka razy stosował już tego typu technologie w negocjacjach z władzami Unii Europejskiej i Iranu. Zapewnia on, że spełniły pokładane w nich nadzieje, a nawet pomogły w wypracowaniu owocnego porozumienia. Abmühl widzi ogromny potencjał w takich technologiach. Oczywiście, nie uważa on, że zastąpią one polityków, ale będą ich wspierały, co wszystkim wyjdzie na dobre.

Na spacer kwantowy

Po modele i techniki AI sięga oczywiście również nauka. Niedawno na przykład naukowcy z Europejskiego Laboratorium Biologii Molekularnej (EBML) połączyli algorytmy sztucznej inteligencji z dwiema najnowocześniejszymi obecnie technikami mikroskopowymi. Dzięki temu czas przetwarzania obrazów skrócił się z dni do zaledwie sekund, a uzyskane obrazy są ostre i dokładne. Wyniki badań zostały opublikowane w "Nature Methods". Mikroskopia pola świetlnego rejestruje duże obrazy 3D, które pozwalają badaczom śledzić i mierzyć bardzo drobne ruchy, np. bijące serce larwy ryby, przy bardzo dużych prędkościach.

Jednak technika ta generuje ogromne ilości danych, których przetwarzanie może trwać wiele dni, a końcowe obrazy zazwyczaj nie mają odpowiedniej rozdzielczości. Mikroskopia arkuszy świetlnych skupia się na pojedynczej płaszczyźnie 2D danej próbki w jednym czasie, dzięki czemu badacze mogą obrazować próbki w wyższej rozdzielczości.

W porównaniu do mikroskopii pola świetlnego, mikroskopia arkusza świetlnego daje obrazy, które są szybsze w obróbce, ale dane nie są tak wszechstronne, ponieważ przechwytują informacje tylko z jednej płaszczyzny 2D w danym momencie. Aby wykorzystać zalety każdej z technik, naukowcy z EMBL opracowali podejście, które wykorzystuje mikroskopię pola światła do obrazowania dużych próbek 3D i mikroskopię arkusza do szkolenia AI, która następnie tworzy dokładny obraz 3D próbki (4).

Rosyjscy naukowcy z Moskiewskiego Instytutu Fizyki i Technologii, Instytutu Fizyki i Technologii im. Waliewa oraz Uniwersytetu ITMO stworzyli w 2020 r. sieć neuronową, która nauczyła się przewidywać zachowanie systemu kwantowego przez "przyglądanie się" jego strukturze podczas "spacerów kwantowych", które można zobrazować jako podróż cząstki w pewnej sieci, na której opiera się obwód kwantowy.

Wyniki ich badań zostały opublikowane w "New Journal of Physics". "Udało nam się wytrenować komputer do samodzielnego przewidywania, czy złożona sieć ma przewagę kwantową", pisze w publikacji Leonid Fedyczkin z Wydziału Fizyki Teoretycznej MIFT. Wraz ze współautorem badań, Aleksandrem Alodjantsem, stworzyli narzędzie, które upraszcza tworzenie obwodów obliczeniowych opartych na algorytmach kwantowych.

Są to oczywiście tylko wyrywki z rozlicznych przykładów. Nauka bardzo szeroko korzysta z technik sztucznej inteligencji, od algorytmów pomagających przetwarzać ogromne ilości danych, np. z obserwacji astronomicznych, przez tworzenie nowych metod rozwiązywania problemów matematycznych, co niedawno opisywaliśmy w MT, po odkrywanie zjawisk i podejść, na które nauka dotychczas nie wpadła w fizyce teoretycznej (temat również poruszany w MT).

2021 - rokiem wielkich premier AI

W listopadzie 2021 r. OpenAI otworzyła dostęp do swojego generatora. Teraz każdy może korzystać z GPT-3 (5). OpenAI pobiera opłaty za token - wywołany lub wygenerowany przez GPT-3 (token można rozumieć jako część słowa. Bezpiecznie jest przyjąć, że token równa się 0,75 słowa). Przez pierwsze trzy miesiące użytkownik ma do dyspozycji 18 dolarów darmowego kredytu, który może wykorzystać według własnego uznania. W przypadku modelu DaVinci (najmocniejsza wersja GPT-3), 1000 tokenów kosztuje 0,06 dolara. Z 18 dolarami mamy 300 tysięcy darmowych tokenów. Według szacunków wystarczy to do napisania czterech pełnowymiarowych powieści.

GPT-3 jest trzecią wersją rodziny modeli językowych Generative Pre-Trained. Jego główne cechy to wielozadaniowość i zdolność do metanauki. Dzięki temu, że jest szkolony w sposób nienadzorowany na 570 GB danych tekstowych z Internetu, jest w stanie uczyć się zadań, w których nie był szkolony, widząc jedynie kilka przykładów (few-shot). Może również uczyć się z ustawień zero- i one-shot, ale jego wydajność jest zazwyczaj gorsza.

GPT-3 zademonstrował oszałamiające zdolności generowania języka. Może prowadzić rozmowy (podszywając się pod znane postacie, żywe lub historyczne), pisać poezję, piosenki, fikcję i eseje. Potrafi pisać kod, arkusze muzyczne i równania w formacie LaTeX. Poza tym GPT-3 wykazał się świetnymi wynikami w standardowych benchmarkach badawczych. Najbardziej błyszczy w zadaniach generatywnych, takich jak pisanie artykułów informacyjnych. W tym zadaniu osiągnął ludzki poziom, dezorientując sędziów próbujących oddzielić jego artykuły od tych stworzonych przez człowieka.

Osiągnięcia GPT-3 były wstępem do serii kolejnych prezentacji nowych modeli. W styczniu 2021 roku Google opublikowało pracę "Switch Transformers: Scaling to Trillion Parameter Models with Simple and Efficient Sparsity". Przedstawiono w nim transformatę przełączającą, nowy typ sieci neuronowej, którego celem było ułatwienie tworzenia większych modeli bez zwiększania kosztów obliczeniowych. Cechą odróżniającą ten model od poprzednich jest uproszczenie algorytmu Mixture of Experts.

Mixture of Experts (MoE) składa się z systemu, w którym tokeny (elementarne części wejścia) wchodzące do modelu są wysyłane do przetworzenia przez różne części sieci neuronowej (ekspertów). W ten sposób do przetworzenia danego tokena aktywna jest tylko część modelu. Obniża to koszty obliczeniowe, pozwalając na osiągnięcie granicy biliona parametrów.

Stojący za GPT-3 ośrodek OpenAI zaprezentował w lutym 2021 roku, w pracy zatytułowanej "Zero-Shot Text-to-Image Generation", generator DALL-E. System, nazwany na cześć hiszpańskiego malarza Salvadora Dalí i uroczego robota WALL-E z Pixara, jest mniejszą wersją GPT-3 ("tylko" 12 miliardów parametrów), wytrenowaną na parach tekst-obraz.

Według słów badaczy z OpenAI, "DALL-E bada możliwości generowania obrazów za pomocą ‚kompozycyjnej struktury języka’, łącząc znaczenie napisanego zdania z potencjalnymi reprezentacjami wizualnymi, jakie może ono posiadać". Jego siła opiera się na jego możliwościach "zero-shot", czyli może wykonywać zadania generowania, do których nie został przeszkolony, bez potrzeby korzystania z przykładów.

Wśród innych możliwości, może on generować obrazy od zera na podstawie pisemnej podpowiedzi, regenerować ukryte części obrazów, kontrolować atrybuty obiektów lub integrować je w jednym obrazie. DALL-E potrafi również łączyć pojęcia na wysokich poziomach abstrakcji (kiedy mówi mu się "ślimak zrobiony z harfy", często rysuje ślimaka jako mającego harfę jako skorupę) i tłumaczyć obraz na obraz (kiedy mówi mu się "dokładnie ten sam kot na górze jako szkic na dole", rysuje podobnego kota na oryginalnym obrazie). Z luźno interpretowalnych opisów języka pisanego tworzy wizualną rzeczywistość.

W maju 2021 roku na swojej corocznej konferencji I/O Google zaprezentowało z kolei LaMDA. LaMDA ma zrewolucjonizować technologię chatbotów dzięki swoim nowym umiejętnościom konwersacyjnym. LaMDA, co jest skrótem od Language Model for Dialogue Applications, jest następcą Meeny, zaprezentowanej w 2020 roku. LaMDA została zoptymalizowana tak, by zminimalizować niepewność w konwersacji. W przeciwieństwie do poprzednich modeli, potrafi poruszać się w otwartej konwersacji, nadając sens odpowiedziom, konkretyzować je, unikając znanych w chatbotach wytrychów typu "nie wiem".

Wraz z LaMDA Google zaprezentowało MUM, system mający zrewolucjonizować wyszukiwarkę internetową, w podobny, ale bardziej efektowny sposób niż wdrożony w 2019 r. algorytm wyszukiwawczy BERT. MUM, czyli Multitask Unified Model, to wielozadaniowy i multimodalny model językowy, wytrenowany na 75 językach i w wielu zadaniach, co daje mu lepsze zrozumienie świata. Przełomowa multimodalność polega na tym, że jest w stanie poradzić sobie z informacjami i zadaniami tekstowo-obrazowymi, co daje mu wszechstronność, której nie mają ani GPT-3, ani LaMDA.

Kolejnym wydarzeniem w tej sekwencji była premiera pierwszego czerwca 2021 na corocznej konferencji BAAI chińskiej AI o nazwie Wu Dao 2.0 (6), co w tłumaczeniu oznacza "oświecenie". Z 1,75 biliona parametrów narzędzie to dzierży tytuł największej znanej sieci neuronowej, wyprzedzając GPT-3.

Wu Dao 2.0 był trenowany na 4,9 TB wysokiej jakości danych tekstowych i graficznych, czyli na zasobie dziesięciokrotnie przewyższającym GPT-3. Wu Dao 2.0 jest w stanie wykonywać zadania multimodalne, tekstowo-obrazowe, przetwarzać i generować tekst, rozpoznawać i generować obrazy, a także wykonywać zadania mieszane, takie jak podpisywanie obrazów i tworzenie obrazów z opisów tekstowych. Potrafi również przewidywać struktury 3D białek, podobnie jak AlphaFold firmy DeepMind. Na bazie Wu Dao 2.0 stworzono wirtualnego ucznia, który potrafi już pisać wiersze i rysować obrazy, a w przyszłości nauczy się kodować.

Narzędzia, o których mowa, stają się, jak widać coraz bardziej uniwersalne. Wciąż jednak są to mechanizmy przetwarzające pewne określone typy danych, niepotrafiące przenieść swojej potęgi na pola, z których nie dostały danych do nauki. To zarówno źle, jak i dobrze, gdyż pozwala myśleć konkretnie o wąskich polach zastosowań, a nie zbyt ogólnie o samej ich potędze.

Mirosław Usidus