Rozszerzona rzeczywistość to nie tylko wzrok

Instalacje oddziałujące podczas wyświetlania projekcji filmowych na inne niż wzrok zmysły są znane od kilkudziesięciu lat. Były to najczęściej systemy z otaczającym dźwiękiem i ruchomymi siedzeniami dla widzów, które imitowały np. gwałtowne ewolucje rollercoastera. Potem pojawiły się "filmy 4D" oferujące multisensoryczne doświadczenia, z instalacjami imitującymi wiatr, deszcz, gorąco, zapachy, dym, bąbelki powietrza, w połączeniu ze stereoskopowym obrazem, wielokanałowym dźwiękiem i ruchomymi fotelami dla widzów (1).

Rzeczywistość rozszerzona oczywiście może oddziaływać na wielu płaszczyznach - wzrokowej, słuchowej, haptycznej, somatosensorycznej i węchowej. Rzecz w tym, że nie każda z tych płaszczyzn jest tak samo łatwa w obsłudze.

Słyszeć więcej lub mniej

Zmysłem, który przez wiele systemów rozszerzonej rzeczywistości jest już obsługiwany, podobnie jak wzrok, jest słuch. Miał z nim do czynienia każdy, kto korzystał np. przewodnika audio w muzeum. Dźwięk podobnie jak obraz jest w tych systemach kojarzony z lokalizacją.

Jak wiadomo, istnieją dwa rodzaje rozwiązań lokalizacji w AR: oparte na znacznikach i na czujnikach. Jako tych pierwszych używa się obiektów fizycznych, obrazów lub kodów QR. Algorytmy wyodrębniają ze znacznika różne informacje, w tym wielkość i położenie, wykorzystując je do korelacji wirtualnych obiektów (wizualizacji, plików audio, poleceń dla systemu haptycznego itd.) ze środowiskiem rzeczywistym.

Aplikacje oparte na czujnikach wykrywają obiekty za pomocą technologii lokalizacyjnych, takich jak GPS, RFID lub Wi-Fi. Pomagają w tym również żyroskopy i akcelerometry. Dodatkowo inżynierowie trenują algorytmy deep learning w celu dokładnego wykrywania znaczników w danych wideo na żywo. Wizualne formy AR po wykryciu lokalizacji komunikują się z ekranami lub okularami, dźwiękowa AR wykorzystuje inteligentne aparaty słuchowe. To nie tylko zwiedzanie muzeów. Asystent głosowy z funkcją AR w uchu może wskazać właściwy kierunek w mieście i przypomnieć o zbliżającym się spotkaniu biznesowym.

Według raportu "Markets and Markets", wartość rynku urządzeń dousznych szacuje się na 23,24 miliarda dolarów do 2023 roku. Zaś ostatni raport firmy Juniper Research mówi, że liczba używanych urządzeń słuchowych wzrośnie do ponad 970 milionów sztuk do 2024 roku (wzrost o 270 proc. w porównaniu z rokiem 2020). Na czele rynku rzeczywistości rozszerzonej audio znajdują się asystenci głosowi stworzeni przez technologicznych gigantów - Alexa Amazona, Siri od Apple i Asystent Google.

W 2019 roku Amazon rozszerzył funkcje Alexa na obsługę słuchawek i wkładek dousznych. Dzięki obsłudze lokalizacji opartej na GPS, użytkownicy mają teraz możliwość otrzymywania informacji nawigacyjnych i o ruchu drogowym z Google Maps. Inne ważne funkcje Alexa Mobile Accessory Kit obejmują zarządzanie kalendarzem, sterowanie urządzeniem smart home i odtwarzanie muzyki.

Z punktu widzenia technologicznego wielkim przełomem może być już wkrótce możliwość tłumaczenia języków obcych w czasie rzeczywistym za pomocą takich urządzeń. Rozwiązanie tego typu zazwyczaj łączy się ze smartfonem. Tutaj augmented reality polega na dodaniu do świata rzeczywistego warstwy natychmiastowego zrozumienia obcego języka, którym ktoś do nas mówi, który odczytujemy z napisów, tablic informacyjnych. Wielka sprawa, ale do prawdziwej rewolucji brakuje tu jednak trochę. Przede wszystkim dostępne algorytmy tłumaczące wciąż nie wywiązują się z tego zadania w sposób zadowalający.

Nieco inną, ale również obiecującą odmianą "rozszerzonej rzeczywistości" są systemy redukcji szumów. AR jest tu w cudzysłowie, gdyż systemy takie robią coś odwrotnego - nie tyle rozszerzają rzeczywistość dźwiękową, ile redukują ją w zgiełku do tego, co naprawdę chcemy słyszeć. Algorytmy aktywnej redukcji szumów (ANC) zbierają oba rodzaje sygnałów - bezpośrednią mowę i niepożądany dźwięk - a następnie wyodrębniają pożądany dźwięk z szumów zewnętrznych. Aby zapewnić, że urządzenie wytwarza pożądany dźwięk bez szumów tła o niskiej częstotliwości, inżynierowie opracowują logikę niestandardowego modułu cyfrowego przetwarzania sygnału (DSP) i konfigurują ustawienia modułu zintegrowanego, a także modułów mikrofonowych i jednostek transportowych.

Inżynierowie wyposażają inteligentne aparaty słuchowe w mikrofony kierunkowe, które przechwytują dźwięk docelowy i tablice mikrofonów, które zbierają szumy z otoczenia. Algorytmy wyodrębniają pożądany dźwięk z wszystkich innych dźwięków. Wbudowany DSP i wzmacniacze audio zwiększają głośność dźwięku i redukują niepożądane dźwięki. Techniki mogą również poprawić rozpoznawanie mowy w głośnym otoczeniu dzięki technologii przetwarzania sygnału, zwanej beamforming (z ang. "kształtowanie wiązki"). Wykorzystuje się tu 2-4 mikrofony kierunkowe, zamiast zbierać sygnał ze wszystkich kierunków, co pomaga urządzeniu wykryć właściwego mówcę.

Dotyk przez dotyk i przez brak dotyku

Haptykę można ogólnie definiować jako odtwarzanie zmysłu dotyku poprzez siły, wibracje i ruchy urządzeń pośredniczących. Zmysł ten jest bogaty i złożony, rejestruje zakresy bodźców od muśnięcia lekkim piórkiem, przez uściski dłoni, aż po masaże i zadawanie bólu. "Interfejse" tego zmysłu jest w ludzkim ciele nie tylko skóra. Nasz przedsionek ucha wewnętrznego także wyczuwa wibracje i ruchy drgające, dostarczając informacji o poruszających się w pobliżu obiektach.

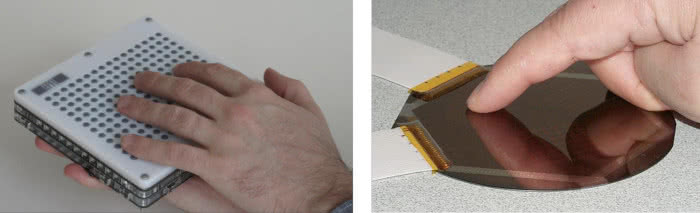

Na zmysł dotyku nakierowane są "wyświetlacze haptyczne", w których poruszają się zazwyczaj fizycznie matryce elementów oddziałujących na skórę odbiorcy. Znane są też "wyświetlacze elektrostatyczne" (2), które nie mają żadnych ruchomych części i raczej imitują uczucie dotyku, niż fizycznie dotykają.

Badania nad tego rodzaju interfejsami trwają już od dawna. W 1998 roku profesor MIT Media Lab Hiroshi Ishii oraz studenci Scott Brave i Andrew Dahley zaprezentowali inTouch (3), system składający się z dwóch ręcznie wykonanych identycznych urządzeń, z których każde ma trzy równoległe drewniane kołki mające imitować wrażenia dotykowe.

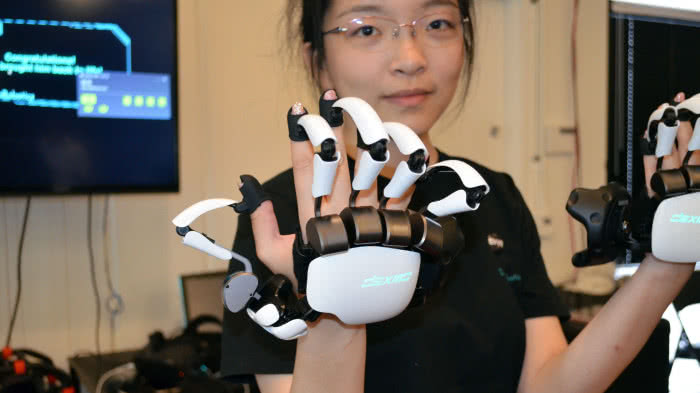

Od tego czasu nastąpił znaczący rozwój systemów naśladujących dotyk. Powstają specjalne rękawice i egzoszkielety. Zestaw Dexmo (4) dostarcza wrażenia oporu dotykanej powierzchni, czyli użytkownik ma czuć, jak gdyby dotykał realnego przedmiotu. Opór stawiany palcom jest realny, gdyż w rękę-egzoszkielet wbudowano wyrafinowany system hamulców, zatrzymujących je w odpowiednim momencie. W efekcie dzięki oprogramowaniu i hamulcom palce zatrzymują się, każdy w nieco innym punkcie wirtualnego przedmiotu zupełnie tak samo, jak gdyby spoczęły na powierzchni prawdziwego przedmiotu, np. piłki.

Grupa studentów z Uniwersytetu Rice zaprojektowała parę lat temu rękawicę pozwalającą na "dotykanie" i "łapanie" obiektów w wirtualnej rzeczywistości, czyli w powietrzu. Rękawica Hands Omni pozwoli na wyczuwanie kształtów i rozmiarów "dotykanych" w wirtualnym świecie przedmiotów. Dzięki sprzężeniu świata generowanego komputerowo, który widzi osoba z odpowiednim sprzętem na oczach, z wrażeniami generowanymi w rękawicach, powstać ma zbliżony do rzeczywistości ekwiwalent dotyku. W sensie fizycznym za wrażenia te odpowiadać mają napełniane powietrzem poduszki w palcach rękawicy Hands Omni. Stopień napełnienia odpowiada za odczucia twardości generowanych obiektów.

Profesor Politechniki Federalnej w Lozannie (École Polytechnique Fédérale de Lausanne EPFL) Herbert Shea od lat pracuje nad siłownikami na bazie silikonu. Tym razem, wraz ze swoim zespołem z laboratorium przetworników miękkich, opracował bardzo małe, cienkie i szybkie siłowniki. Badacze wytworzyli mikrokapsułki wielkości milimetra z silikonowej membrany izolacyjnej oraz metalizowanego poliestru, które wykorzystując energię elektrostatyczną, napełniają się oleistą cieczą i opróżniają. Każda kapsułka otoczona jest czterema elektrodami, które zamykają się jak zamek błyskawiczny - po przyłożeniu napięcia elektrody są ściągane razem, powodując pęcznienie środka kapsułki. Mogą też pęcznieć w górę i w dół, ale także na boki i dookoła. Kiedy są umieszczane pod palcami, sprawiają wrażenie dotykania różnych obiektów.

Zespół Shea opracowuje teraz cienką rękawicę, w której integruje ze sobą kilkanaście takich kapsułek. Zostaną przyłączone do nowatorskiego systemu, który będzie blokował ruch palców. Dzięki temu użytkownik rękawicy będzie miał wrażenie, że dotyka lub trzyma solidny przedmiot, pomimo że jego dłoń w rzeczywistości pozostaje pusta. Użytkownik gogli VR będzie mógł określić, czy nieistniejący w rzeczywistości przedmiot, który trzyma lub którego dotyka, jest wykonany z drewna, szkła czy metalu. To wszystko da się zaprogramować, odpowiednio trenując algorytmy co do wagi, struktury i wrażeń dotykowych różnych przedmiotów. To ostatni etap zadania, jakie wyznaczyli sobie Szwajcarzy. Mówią, że nowy system rękawic będą mogli wykorzystywać na przykład uczący się gry na jakimś instrumencie czy trenujący sport wymagający wyczucia w rękach.

Zaprezentowana niedawno technika haptyczna z Instytutu Hasso Plattnera w Niemczech do tworzenia iluzji oporu np. ścian wykorzystuje z kolei elektryczne impulsy stymulujące mięśnie, czyli inną niż fizyczne siłowniki technikę, znaną dotychczas z zastosowań medycznych.

Oprócz układów haptycznych z siłownikami i układami elektrostatycznymi, które tak czy inaczej oznaczają fizyczne dotykanie urządzeń, znane są pomysły na rozwiązania imitujące dotyk… bezdotykowo. Są to najczęściej różnego rodzaju koncepcje oparte na wydmuchiwaniu odpowiednio kontrolowanych strumieni powietrza. Nad układami takimi od lat pracował Microsoft Research. Inna bezkontaktowa metoda haptyczna wykorzystuje matryce przetworników ultradźwiękowych. Brytyjski startup Ultrahaptics opracował niewielką matrycę z 64 przetworników, które pozwalają ludziom "dotykać wirtualnych obiektów w powietrzu" (5).

Bez fiolki ani rusz

Kina wyposażone w maszyny emitujące zapachy, nazywane "Smell-O-Vision", funkcjonowały już w latach 60. XX wieku. Wyświetlały jednak tylko filmy produkowane specjalnie dla nich. Największym problemem było usuwanie aromatów w tempie równie szybkim jak je emitowano. Od tego czasu powstało sporo koncepcyjnych urządzeń i pojawiło się nieco pomysłów, jak dodawać do oglądanego obrazu zapach, ale dziedzina ta funkcjonuje wciąż gdzieś na obrzeżach nauki i techniki.

Znamy np. rozwiązania polegające na noszeniu na szyi małych urządzeń uwalniających zapachy. Firma RemniScent z Los Angeles tworzy małe bezprzewodowe moduły wyposażone w filtry zapachowe na bazie chemikaliów. W 2010 roku Meta Cookie połączyła zestaw VR z "kaskiem zapachowym" z wizualnie zakodowanymi "ciasteczkami", których zapach był skorelowany z emiterem obrazu (6). Inny wynalazek, Project Nourished, ma na celu wykorzystanie podobnej technologii do odchudzania, leczenia alergii i cukrzycy, terapii żywieniowej i zdalnego żywienia, cokolwiek to znaczy.

Zespół pod kierownictwem Haruki Matsukury z uniwersytetu w Tokio opracował inną technologię generowania zapachów. Aromaty emitowane przez widoczne na ekranie kwiaty czy kubek kawy pochodzą z kapsułek wypełnionych zapachowym żelem, które parują i są za pomocą wentylatorków nadmuchiwane na wyświetlacz. Strumień pachnącego powietrza jest modyfikowany tak, aby zapach "wydzielał się" z tych części ekranu, w których widoczny jest aromatyczny przedmiot. Na razie ograniczeniem rozwiązania jest możliwość emisji tylko jednego zapachu w danej chwili. Jednak, zdaniem japońskich konstruktorów, możliwe będzie wkrótce zmienianie kapsułek aromatycznych w urządzeniu. Japoński startup Vaqso pracuje z kolei nad dodaniem zapachów do technologii wirtualnej rzeczywistości. Firma pracuje nad urządzeniem wielkości batonika, które można doczepić do okularów do wirtualnej rzeczywistości. Zawiera ono trzy kartridże, a więc teoretycznie pozwala na generowanie większej gamy zapachów.

Jeszcze bardziej ambitne plany miała FeelReal, finansowana za pośrednictwem Kickstartera firma, która zapowiadała urządzenie doczepiane do okularów i wyposażone w siedem kartridży z zapachami. Zostały one podobno przygotowane przez zawodowych twórców perfum, którzy dobrali zapachy tak, by odpowiadały jak najszerszej gamie zapachów z filmów i gier. Mamy odczuć m.in. zapachy oceanu, prochu czy ognia. Urządzenie planowane przez FeelReal ma również korzystać z systemów chłodzenia i ogrzewania, gracz poczuje więc również podmuchy chłodnego i gorącego powietrza niosące zapach. Jakby jeszcze tego było mało, dołączony ma też zostać jonizator, dzięki któremu odczujemy wilgoć mgły unoszącej się w dżungli czy opary w dusznej piwnicy.

Prawie wszystkie znane pomysły zapachowej AR opierają się na chemii, nie na elektronice. Każdy zapach wymaga tu własnego zasobnika z substancją zapachową. To samo jest zresztą niezbędne dla pobudzania zmysłu smaku. Jednak w dziedzinie emulacji wrażeń smakowych pojawiają się pomysły, które starają się zaprzęgnąć do tego elektronikę.

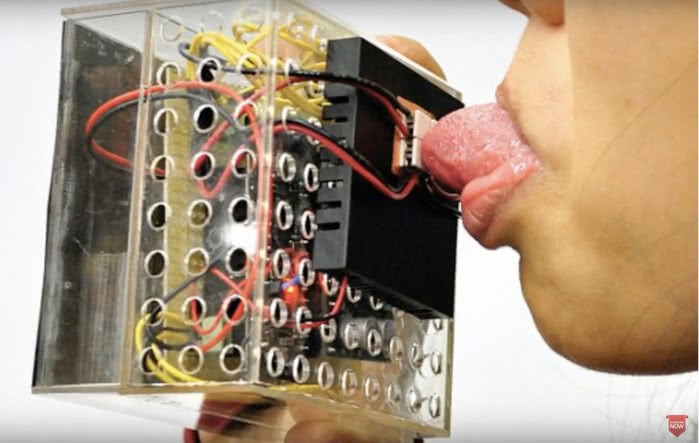

Zasadniczo lizanie gadżetów elektronicznych nie jest dobrym pomysłem. Jednak badacze z japońskiego Uniwersytetu Meiji, którzy twierdzą, że wynaleźli coś, co można nazwać "taste display" (z ang. "wyświetlacz smakowy" mają na ten temat zdanie odrębne. Zbudowali urządzenie zwane "syntezatorem Norimaki", które za sprawą pięciu żelowych kulek przewodzących glicynę czy chlorek magnezu, pobudzając receptory w kubkach smakowych na języku użytkownika, może odtworzyć dowolny smak. Porównują swój system do systemu wyświetlania kolorów na ekranach, gdzie miesza się podstawowe barwy. Pomysł więc polega tu na łączeniu elektroniki i chemii.

Jak widać, pobudzanie innych zmysłów niż wzrok i słuch wzbudza szczególne zainteresowanie w Japonii. Już 2003 roku podczas wystawy w LA Convention Center pojawił się "syntezator żywności", wynaleziony przez profesora uniwersytetu w Tsukubie Hiroo Iwatę (7). To również było połączenie elektroniki, elektromechaniki i wykorzystania substancji chemicznych.

Niedawno, w 2016 r. badacze z uniwersytetu w Singapurze, Nimesha Ranasinghe i Ellen Yi-Luen, poinformowali o testach elektronicznego systemu imitującego smaki nazywanego Virtual Sweet. Zmysły "oszukiwane" niejako są tutaj przez zmiany temperatury powierzchni urządzenia dotykanego językiem (8).

Czy naprawdę można imitować wrażenia smakowe za pomocą impulsów elektrycznych i termicznych? Jak powiedział Arthur C. Clarke, "każda wystarczająco zaawansowana technologia jest nie do odróżnienia od magii". Rozszerzona rzeczywistość ma sporo z magii, kreuje bowiem obiekty, których "nie ma", zwłaszcza że przeważnie tylko je widać. Nie można ich dotknąć ani powąchać. Do tego jest potrzebna bardziej zaawansowana magia… czy technologia, jak kto woli.

Mirosław Usidus