Jak przetrwać tsunami z 120 bitami w głowie? Ludzki mózg i ogrom informacji

Zdolność przetwarzania danych przez świadomy umysł została oszacowana przez Mihaly’ego Csikszentmihalyi oraz niezależnie przez inżyniera Bell Labs Roberta Lucky’ego na 120 bitów na sekundę. Ta przepustowość jest ograniczeniem prędkości ruchu informacji, na które możemy zwrócić świadomą uwagę w danym wycinku czasu.

Co to oznacza w kontekście naszych interakcji z innymi? Aby zrozumieć jedną osobę mówiącą do nas, musimy przetworzyć 60 bitów informacji na sekundę. Przy limicie przetwarzania wynoszącym 120 bitów na sekundę oznacza to, że ledwo można zrozumieć dwie osoby mówiące w tym samym czasie. W większości przypadków nie można zrozumieć trzech osób mówiących w tym samym czasie. Nasze mózgi ewoluowały, aby pomóc nam radzić sobie z życiem w fazie łowiecko-zbierackiej historii ludzkości, w czasie, gdy mogliśmy spotkać nie więcej niż tysiąc osób w ciągu całego naszego życia. Spacerując po centrum miasta, mijamy taką liczbę osób w ciągu pół godziny.

W Ameryce wszystko się bada i mierzy. I tak są badania, według których, w 2011 roku przeciętny obywatel USA przyjmował każdego dnia pięć razy więcej informacji niż w 1986 roku. Była to równowartość 174 tradycyjnych gazet codziennych. W czasie wolnym, nie licząc pracy, każdy przetwarzał ponad dekadę temu codziennie 34 gigabajty, czyli 100 tysięcy słów. Tysiące stacji telewizyjnych na świecie produkują codziennie prawie sto tysięcy godzin programów walczących o widza spędzającego przy telewizorze średnio pięć godzin dziennie, co oznacza przekazywanie mu ok. 20 gigabajtów obrazów audio-wideo. To wszystko, nie licząc YouTube i innych internetowych serwisów wideo. A gry komputerowe? Generują więcej bitów niż wszystkie inne media razem wzięte, czyli DVD, telewizja, książki, czasopisma i Internet. Przeciętny użytkownik komputera ma w swoim pececie zapisaną ma równowartość ponad pół miliona książek.

Idąc dalej, naukowcy zmierzyli ilość danych, które rzeczywiście trafiają do mózgu. Z ich badań wynika, iż przeciętny człowiek żyjący współcześnie przetwarza aż 74 GB informacji dziennie. Pochodzą one z setek telewizji, komputerów, telefonów komórkowych, tabletów, billboardów i innych źródeł. Jeszcze 500 lat temu 74 GB informacji wykształcona osoba przyjmowała w ciągu całego swojego życia, w postaci książek i opowieści.

"Filtry uwagi" nie dają rady

Miliony neuronów nieustannie monitorują środowisko, aby wybrać najważniejsze rzeczy, na których mamy się skupić. Neurony te stanowią zbiorczy "filtr uwagi". Pracują one w dużej mierze w tle, poza naszą świadomością. To właśnie dlatego większość percepcyjnych bodźców w biegu naszego codziennego życia nie jest rejestrowana. To dlatego kierowca jadący autostradą przez kilka godzin, nie pamięta zbyt wiele z otoczenia drogi. Filtr uwagi chroni przed rejestrowaniem tego, co nie jest to uważane za ważne. Jest zarazem jednym z największych osiągnięć ewolucji. Dzięki niemu zwierzęta, także człowiek, nie rozpraszają się przez nieistotne bodźce. Wiewiórki zwracają uwagę na orzechy i drapieżników i niewiele poza tym. Psy, których zmysł węchu jest milion razy czulszy od naszego, używają zapachu do zbierania informacji o świecie bardziej niż dźwięku, a ich filtr uwagi wyewoluował w tym kierunku.

Kiedy nasi protohumanoidalni przodkowie opuścili osłonę drzew, by szukać nowych źródeł pożywienia, otwierając szerszy wachlarz nowych możliwości zdobycia pożywienia jednocześnie wystawili się na nowe niebezpieczeństwa ze strony drapieżników. Bycie czujnym i uważnym na zagrażające dźwięki i wizualne wskazówki pozwoliło im przetrwać. Zarazem oznaczało to przepuszczanie coraz większej ilości informacji przez filtr uwagi. Gdy nasi przodkowie rozwinęli większe mózgi, ich obszary odpowiedzialne za widzenie, słyszenie i odczuwanie świata zaczęły odgrywać coraz ważniejszą rolę. Uczą się na podstawie doświadczeń i stają się lepsze w zauważaniu zdarzeń, które są dla nas naprawdę ważne, takich jak zagrożenia (na przykład warczący pies) i możliwości (na przykład pyszne jedzenie).

Skupianie się naszych zmysłów na rzeczach, które mają znaczenie, a ignorowanie rzeczy nieistotnych pomaga nam wybrać najlepsze zachowania, zapamiętywać ważne informacje i uczyć się na błędach, jak również na sukcesach. Udało nam się przetrwać w prawie każdym klimacie, jaki oferuje nasza planeta. Nasz sukces zawdzięczamy w dużej mierze naszym zdolnościom poznawczym, czyli zdolności naszych mózgów do elastycznego przetwarzania informacji. Jednak nasze mózgi ewoluowały w znacznie prostszym świecie, w którym docierało do nas znacznie mniej informacji. Dziś nasze filtry uwagi łatwo ulegają przeciążeniu.

Dla neurologów ów "filtr uwagi" składa się z dwóch części - pierwsza to wybieranie istotnych rzeczy ze strumienia informacji, które nieustannie docierają do naszych zmysłów a druga zabezpieczanie ważnych informacji przed nadpisaniem przez mniej ważne. Internet, smartfony itp. tworzą środowisko, w którym nieustannie w sposób szybki włączamy i wyłączamy uwagę. Serwisy informacyjne często walczą utrzymanie jednego tematu w centrum uwagi przez długi czas. Skandal polityczny, który w poniedziałek dawniej wstrząsnąłby społeczeństwem na kilka tygodni, może być już nieaktualny we wtorek. Czasami te kolejne fale tsunami informacyjnego są celowo wzbudzane, ponieważ specjaliści od komunikacji i propagandy wiedzą, że jednym z najlepszych sposobów na zwalczenie jednej narracji jest propagowanie innej. W rezultacie odbiorcy są przytłoczeni. Według raportu z 2019 roku przygotowanego przez Reuters Institute for the Study of Journalism, 35 proc. respondentów w Wielkiej Brytanii, a 41 proc. w USA, aktywnie unikało wiadomości.

Jednocześnie badania opublikowane w tym samym czasie przez "Journal of Experimental Psychology" wykazywały, że im mniej czasu dana osoba ma na zrozumienie informacji, tym mniej prawdopodobne jest, że będzie sceptyczna wobec doniesień fałszywych. Dalsze badania przeprowadzone przez naukowców z Uniwersytetu Macquarie i MIT sugerują, że to efekt przytłoczenia informacjami a nie uprzedzenia polityczne odpowiadają za eksplozję fake newsów.

Metafory inteligencji

Komputery działają na symbolicznych reprezentacjach świata. Przechowują i pobierają dane. Przetwarzają je. "Wspomnienia" komputerów istnieją w sensie fizycznym, jako zapisy w układach pamięci. Zawsze kierują się też algorytmami, instrukcjami programowymi, które wcześniej powstały. Choć w XX wieku analogia pomiędzy ludzkim umysłem a komputerami była bardzo popularna, dziś większość badaczy już ją kwestionuje. Wspomnienia w ludzkich mózgach nie są jak pamięć komputerowa. Nie ma też programów ani algorytmów. Przynajmniej takich, jakie umiemy rozpoznać.

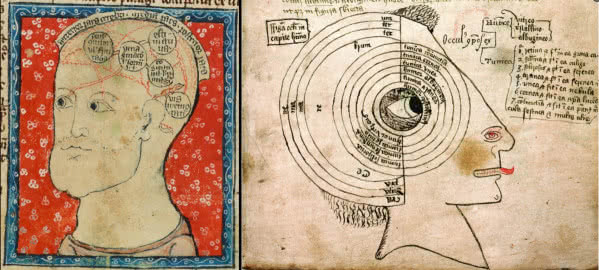

W książce z 2015 r. pt. "In Our Own Image" ekspert w dziedzinie sztucznej inteligencji George Zarkadakis przedstawia szereg metafor, które ludzie stosowali w ciągu ostatnich dwóch tysięcy lat, próbując wyjaśnić ludzką inteligencję. W najwcześniejszej z nich, zachowanej w Biblii inteligentny Bóg napełnił nas swoim duchem, co dało nam inteligencję. Wynalezienie inżynierii hydraulicznej w III wieku p.n.e. doprowadziło do popularyzacji hydraulicznego modelu ludzkiej inteligencji, idei, że przepływ różnych płynów w ciele, "humorów", odpowiada za nasze fizyczne i umysłowe funkcjonowanie (2). Później opracowano pierwsze automaty napędzane sprężynami i kołami zębatymi, co ostatecznie zainspirowało myślicieli, w tym Kartezjusza, do twierdzenia, że ludzie są złożonymi maszynami. W XVII w. brytyjski filozof Thomas Hobbes zasugerował, że myślenie powstaje w wyniku drobnych ruchów mechanicznych w mózgu. W XVIII wieku odkrycia dotyczące elektryczności i chemii doprowadziły do powstania nowych teorii ludzkiej inteligencji. W połowie XIX wieku, zainspirowany osiągnięciami w dziedzinie komunikacji, niemiecki fizyk Hermann von Helmholtz porównał mózg do telegrafu.

W połowie XX wieku narodziła się "kognitywistyką". Za jej symboliczne narodziny uznaje się wydanie książki "Language and Communication" (1951), psychologa George’a Millera. Według niego, świat mentalny może być badany przy użyciu pojęć z teorii informacji, obliczeń i lingwistyki. Kontynuacją tego toku myślenia była praca "The Computer and the Brain" (1958), w której matematyk John von Neumann uznał, że funkcje ludzkiego systemu nerwowego są nade wszystko cyfrowe.

Nurt badań zakorzeniony w idei, że ludzie są, podobnie jak komputery, procesorami informacji rozwijał się przez kolejne dekady. Książka Raya Kurzweila "Jak stworzyć umysł", z jej spekulacjami na temat "algorytmów" mózgu, "przetwarzania danych", a nawet rzekomego podobieństwa struktur mózgu do układów scalonych, stanowi jeden z nowszych przykładów tej perspektywy.

Wydaje się, że analogia przyrównująca mózg do komputera obecnie wciąż dominuje w naszym myśleniu, zarówno w sensie potocznym, jak i w naukach ścisłych. Jednak to wciąż coś w rodzaju metafory, bez ścisłych, twardych dowodów.

Gdzie w mózgu jest symfonia a gdzie nagranie głosu mamy?

To prawda, że w sensie funkcjonalnym możemy stwierdzić, że każdy system neuronalny (rejon mózgu) posiada jednostki - przetwarzającą i przechowującą dane, które mogą się zmieniać w czasie i/lub w trakcie wykonywania zadań poznawczych. Można układ połączeń w mózgu potraktować jako sieć komunikacyjną, zbiorem węzłów/regionów, w rozumieniu opisywanej w innym artykule w tym numerze MT teorii informacji Shannona z prawem zachowania informacji.

Jest jednak także inne spojrzenie polegające na przekonaniu, iż mózg nie przetwarza informacji, nie pobiera wiedzy, ani nie przechowuje wspomnień. Krótko mówiąc, mózg człowieka nie jest komputerem. Zwolennicy tego poglądu wskazują, że nie da się w mózgu znaleźć zapisu kopii V Symfonii Beethovena, ani kopii słów, obrazów, reguł gramatycznych czy jakichkolwiek innych pamiętanych bodźców. Oczywiście, jak głosi ta koncepcja, ludzki mózg nie jest "pusty", jednak nie zawiera rzeczy, co do których panuje przekonanie, że zawiera, nawet żadnych "wspomnień".

Zwolennicy tego poglądu proponują, by zwrócić uwagę na mózgi niemowląt. Noworodki ludzkie, podobnie jak noworodki wszystkich innych gatunków ssaków, nie wchodzą w świat z zasobem przygotowanych informacji, ale jednak przygotowane do efektywnej interakcji z otoczeniem. Wzrok dziecka jest nieostry, jednak zwraca ono szczególną uwagę na twarze i szybko potrafi rozpoznać matkę. Woli dźwięk głosu ludzkiego od innych dźwięków i potrafi odróżnić jedne proste dźwięki mowy od innych. Zdrowy noworodek jest wyposażony w szereg odruchów - gotowych reakcji na określone bodźce, które są ważne dla jego przetrwania. Obraca głowę w kierunku czegoś, co muska jego policzek, a następnie ssie to, co dostanie się do jego ust. Wstrzymuje oddech, gdy zanurza się w wodzie. Chwyta przedmioty włożone do rąk tak mocno, że może prawie utrzymać swój ciężar. Przy tym najważniejsze wydaje się, że noworodki są wy-posażone w potężną zdolność uczenia się, co pozwala im szybko się zmieniać, coraz skuteczniej oddziaływać na otaczający świat. Gdyby po urodzeniu zabrakło nam którejkolwiek z tych zdolności, mielibyśmy problemy z przetrwaniem.

Jednakże, co należy podkreślić nie rodzimy się z informacjami, danymi, regułami, oprogramowaniem, wiedzą, reprezentacjami, algorytmami, programami, modelami, pamięcią, obrazami, procesorami, koderami, dekoderami, symbolami czy buforami, zapisanymi w głowie i gotowymi do wykorzystania. Nie tylko nie rodzimy się z tym wszystkim, ale też, zdaniem przeciwników komputerowej analogii, nie rozwijamy ich nigdy. Nie tworzymy np. reprezentacji bodźców wizualnych, nie przechowujemy ich w buforze pamięci krótkotrwałej, a następnie nie przenosimy reprezentacji do urządzenia pamięci długotrwałej. Nie pobieramy informacji, obrazów czy słów z rejestrów pamięci.

Żywe organizmy nie działają jak komputery, podkreślają oponenci komputerowego modelu mózgu. Komputery przetwarzają informacje, liczby, litery, słowa, wzory, obrazy. Informacje te muszą być najpierw zakodowane w formacie, którego mogą używać komputery, czyli jako wzory jedynek i zer ("bity"), zorganizowane w porcje ("bajty"). Komputery przenoszą i kopiują te wzory z miejsca na miejsce w różnych fizycznych miejscach przechowywania danych w komponentach elektronicznych a czasami przekształcają je na różne sposoby. Reguły, których komputery przestrzegają przy tych operacjach, są również przechowywane wewnątrz komputera. Ich zestawy nazywa się "programami" lub "algorytmami". Nic takiego w mózgu człowieka, według naszej wiedzy, nie ma.

Dziś wielu kognitywistów, np. Anthony Chemero z Uniwersystetu w Cincinnati (3), autor książki "Radical Embodied Cognitive Science" z 2009 r., całkowicie odrzuca pogląd, że ludzki mózg działa jak komputer. Wadliwa logika "metafory IP" (tak bywa nazywana koncepcja analogii działania mózgu z komputerem) jest, w jego ocenie, dość łatwa do stwierdzenia. Opiera się ona na fałszywym sylogizmie, który ma dwie dające się przyjąć przesłanki prowadzą do wadliwego wniosku. Uzasadniona przesłanka nr 1: wszystkie komputery są w stanie zachowywać się inteligentnie. Uzasadniona przesłanka nr 2: wszystkie komputery są procesorami informacji. Błędny natomiast jest, zdaniem Chemero, wniosek, że wszystkie jednostki zdolne do inteligentnego zachowania są procesorami informacji.

Perspektywę mózgu jako komputera podważa stosowany przez jej przeciwników przykład dotyczący wyjaśnienia, jak baseballiście udaje się złapać lecącą piłkę (4). Jako pierwszy posłużył się nim Michael McBeath i jego zespół w artykule z 1995 roku w "Science". Koncepcja mózgu jako analogu komputera wymaga od gracza sformułowania szacunków dotyczących różnych warunków początkowych lotu piłki, siły uderzenia, kąta trajektorii, tego typu rzeczy, a następnie stworzenia i przeanalizowania wewnętrznego modelu ścieżki, po której prawdopodobnie poruszy się piłka, a następnie wykorzystania tego modelu do kierowania i dostosowania ruchów motorycznych w sposób ciągły w czasie, by przechwycić piłkę. To wszystko tak wyglądałoby, gdybyśmy funkcjonowali jak komputery, ale każdy intuicyjnie rozumie, że tak raczej nie jest. McBeath i jego koledzy przedstawili prostsze rozwiązanie polegające na tym, iż, aby złapać piłkę, gracz musi po prostu poruszać się w taki sposób, aby utrzymać piłkę w stałej relacji wzrokowej w stosunku do płyty głównej i otaczającej ją scenerii (technicznie rzecz biorąc, w "liniowej trajektorii optycznej"). W rzeczywistości jest to dość proste i całkowicie wolne od obliczeń, reprezentacji i algorytmów.

Z konceptem mózgu - analogu komputera jest też głębszy problem, nazywany czasem problemem unikatowości. Ponieważ w mózgu nie istnieją ani "banki pamięci", ani "reprezentacje" bodźców. Nie ma dowodu ani powodu, by wierzyć, że mózgi dwóch ludzi zmieniają się w ten sam sposób pod wpływem tego samego doświadczenia. Jeśli dwie osoby pójdą na ten sam koncert, zmiany, które pod jego wpływem zachodzą w mózgu jednej są najprawdopodobniej inne niż u drugiej. Te zmiany, jakiekolwiek by były, są budowane na unikatowej strukturze neuronowej, która już istnieje, a każda struktura rozwinęła się w ciągu całego życia unikatowych doświadczeń. To dlatego, jak wykazał Frederic Bartlett w swojej książce "Remembering", wydanej w 1932 roku, żadna z dwóch osób nie powtórzy usłyszanej historii w ten sam sposób i dlatego z czasem ich recytacje będą się coraz bardziej różnić. Żadna uniwersalna "kopia" historii nigdy nie powstaje. Raczej każda osoba, po usłyszeniu historii, zmienia się do pewnego stopnia, na tyle, że kiedy zapyta się ją o historię później. Każdy z nas jest naprawdę wyjątkowy, nie tylko pod względem genetycznym, ale nawet pod względem sposobu, w jaki nasze mózgi zmieniają się w czasie.

Aby zrozumieć choćby podstawy tego, jak mózg utrzymuje ludzki intelekt, musielibyśmy znać nie tylko aktualny stan wszystkich 86 miliardów neuronów i ich 100 bilionów połączeń, nie tylko różne oddziaływania tworzące te połączenia, i nie tylko stany ponad tysiąca białek, które istnieją w każdym punkcie połączenia, ale także to, jak bieżąca aktywność mózgu przyczynia się do integralności systemu. Jeśli dodamy do tego unikatowość każdego mózgu, wynikającą z unikatowości doświadczeń życiowych każdej osoby, to prognozy "komputerystów" brzmią jak żart. W jednym z artykułów w "The New York Times" neurolog Kenneth Miller zasugerował, że potrzeba będzie "stuleci", by rozgryźć choćby podstawowe połączenia między neuronami.

Najbardziej rażący niedawny przypadek ślepej uliczki jaką stanowi myślenie o mózgu jako komputerze dotyczy wartego 1,3 miliarda dolarów Human Brain Project finansowanego przez Unię Europejską od 2013 roku (5). Przekonani przez Henry’ego Markrama, że może on stworzyć symulację całego ludzkiego mózgu na superkomputerze do roku 2023, i że taki model zrewolucjonizuje leczenie choroby Alzheimera i innych schorzeń, urzędnicy UE sfinansowali jego projekt. Po niespełna dwóch latach fiako projektu było oczywiste a Markram został poproszony o ustąpienie.

Są przepowiednie, m.in. autorstwa między innymi wspomnianego Kurzweila, fizyka Stephena Hawkinga i neurologa Randala Koene’a, że, ponieważ ludzka świadomość jest rzekomo jak oprogramowanie komputerowe, wkrótce będzie można ściągnąć ludzkie umysły do komputera, w którego obwodach staniemy się niezmiernie potężni intelektualnie, a nawet - nieśmiertelni. W świetle braku realnych fizycznych dowodów, że rzeczywiście zawartość naszych mózgów jest "kopiowalna", koncepty te pozostają fantazjami.

Mirosław Usidus