Wojna o krzem, którego nagle zabrakło. Procesory pożądania

IBM dodał, że jego układ testowy może poprawić wydajność o 45 proc. w stosunku do obecnie dostępnych na rynku produktów wykonanych w technologii 7 nm. Zużywa zarazem 75% mniej energii. Firma głosi, że technologia ta może "czterokrotnie" zwiększyć żywotność baterii telefonów komórkowych.

Przemysł chipów komputerowych od lat używa nanometrów, jednej miliardowej części metra, do podawania fizycznych rozmiarów tranzystorów. Jednocześnie parametr "nm" jest postrzegany jako termin marketingowy, służący do opisania nowych generacji technologii, prowadzących do lepszej wydajności i niższej mocy.

Układy do komputerów stacjonarnych oparte na procesie 7 nm, takie jak czołowe procesory Ryzen firmy AMD, nie były rynkowo dostępne aż do 2019 roku, czyli cztery lata po tym, jak IBM ogłosił, że opanował proces 7 nm. To ogólna, choć nie wiążąca, wskazówka co do tego, kiedy możemy się spodziewać procesorów 2 nm na rynku. Jak wspomniano "proces 5 nm" został ogłoszony jako opanowany przez IBM w 2017. Gdyby przyjąć czteroletnie opóźnienie jako obowiązujący interwał, to powinniśmy spodziewać się chipów tego rodzaju już w tym roku. Na razie jest zapowiedź Intela i tajwańskich zakładów TSMC wypuszczenia urządzeń w litografii 5 nm do końca 2021 r. Być może więc czteroletni cykl zostanie dotrzymany.

Jak zabrakło chipów

Doniesienia o kolejnych postępach miniaturyzacyjnych IBM pojawiają się w sytuacji światowego niedoboru chipów komputerowych i zapowiedzi radykalnych zmian w globalnym łańcuchu produkcji i dostaw chipów, sprowadzających się w skrócie do tego, by mniej uzależniać USA i inne kraje od wytwórni w Chinach i na Tajwanie. Producenci samochodów zostali zmuszeni do zawieszenia produkcji z powodu braku komponentów komputerowych, producenci smartfonów ostrzegli, że premiery produktów mogą zostać przesunięte, a zaawansowane części komputerów, takie jak karty graficzne, są trudne do znalezienia lub mają bardzo wysokie ceny.

Tymczasowe zamknięcia fabryk z powodu pandemii również spowodowały przerwy w dostawach. Gdy fabryki zostały ponownie otwarte, producenci dóbr elektronicznych składali wielkie zamówienia "nadrabiające zaległości", tworząc coraz większe luki w dostawach chipów.

Pandemia nie była jedynym czynnikiem wpływającym na tę sytuację. Z powodu zjawisk atmosferycznych w kilku zakładach w Teksasie wstrzymano na pewien czas produkcję, a w marcu 2020 r. pożar strawił jedną z japońskich fabryk. W sierpniu 2020 roku, w związku z zarzutami o szpiegostwo, Stany Zjednoczone zakazały zagranicznym firmom, których chipy wykorzystują amerykańską technologię, sprzedaży komponentów chińskiemu gigantowi technologicznemu Huawei.

Chiński potentat rozpoczął gromadzenie zapasów komponentów półprzewodnikowych jeszcze przed wejściem w życie sankcji, a inne firmy poszły w jego ślady, co jeszcze bardziej ograniczyło dostawy.

Ponieważ producenci samochodów zmniejszyli produkcję na początku pandemii, ich dostawcy układów scalonych zwrócili się ze swoją ofertą do klientów z innych sektorów, mianowicie do producentów artykułów elektronicznych, na które wzrósł duży popyt z powodu pandemii. Po pewnym czasie wielkie marki samochodowe, od Volkswagena po Volvo, gdy sprzedaż aut zaczęła znów wzrastać, zaczęły mieć problemy z brakami produktów półprzewodnikowych. Tysiące niedokończonych samochodów zaparkowanych w fabryce Volkswagena w Pampelunie, w Hiszpanii, to symboliczna ilustracja tej sytuacji (2).

Jean-Marc Chery, dyrektor generalny francusko-włoskiego producenta chipów STMicroelectronics, powiedział, że zamówienia na przyszły rok już przekroczyły możliwości produkcyjne jego firmy. SEB, francuski producent sprzętu AGD ostrzegł, że jest zmuszony do podniesienia cen. Producenci smartfonów byli w tym okresie względnie bezpieczni, ponieważ mieli zapasy chipów, ale z czasem i oni zaczęli odczuwać niedobory.

Szef Apple Tim Cook powiedział, że braki te mogą uderzyć w produkcję iPhone’ów i iPadów. Mocniej ucierpieli mniejsi producenci smartfonów. Oczywiście uderzyło to także w producentów sprzętu do gier, np. konsoli, takich jak PlayStation 5 i Xbox Series X.

Problemy te dla wielu ludzi w krajach technologicznie rozwiniętych były jasnym sygnałem, że w trudnych sytuacjach globalizacja i przesunięcie zakładów wytwarzających komponenty gdzieś daleko do Azji może oznaczać kłopoty. Krzemowe produkty są obecnie zbyt ważne dla gospodarki, by zdawać się na niepewne dalekie źródła i długie łańcuchy dostaw.

Szef Intela Pat Gelsinger wprost ocenił w rozmowie z BBC, że ulokowanie 80% światowych źródeł dostaw chipów w Azji nie jest dobrym pomysłem. Kto może więc, czyli ma know-how, zdolności produkcyjne, zaplecze, no i oczywiście odpowiednie możliwości finansowe, podejmuje działania, by zapewnić produkcję krzemowych komponentów "u siebie".

Wiosną 2021 r. Korea Południowa ogłosiła podjęcie gigantycznych inwestycji o wartości 451 miliardów dolarów, które mają docelowo przekształcić ten kraj w "giganta półprzewodników". W tym samym czasie amerykański Senat uchwalił wydatki w wysokości 52 miliardów dolarów na dotacje dla rozwoju wytwórni układów scalonych, znanych w USA jako "fabs".

Prezydent Biden podpisał rozporządzenie wykonawcze inicjujące strategię narodową, której celem jest zapobieżenie niedoborom półprzewodników w przyszłości. Działania amerykańskich władz powiązane są z planami Intela, który chce wydać 20 mld dolarów na nowe fabryki i rozbudowę istniejących na terenie USA. Unia Europejska zapowiada, że dąży do podwojenia swojego udziału w globalnej produkcji układów scalonych do 20% globalnego rynku do roku 2030.

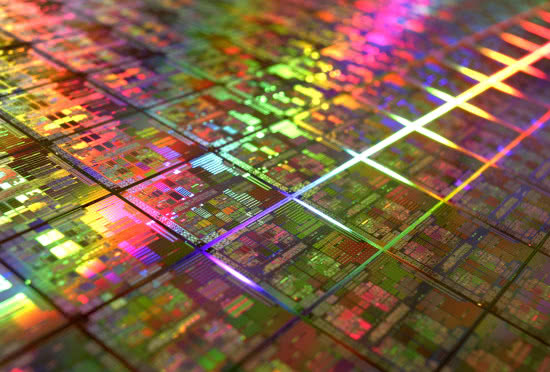

Oczywiście zakłady nie mogą zostać otwarte z dnia na dzień, szczególnie te, które produkują w procesach półprzewodnikowych opartych na trawieniu i obróbce wafli krzemowych (3), co jest znane jako jedne z najbardziej wymagających technik wytwórczych, jakie zna przemysł. "Budowa nowych mocy produkcyjnych wymaga czasu, w przypadku nowej fabryki krzemowej ponad dwóch i pół roku, więc większość przedsięwzięć, które zaczynają się teraz, nie zwiększy dostępnych mocy produkcyjnych do 2023 roku", wyjaśniał w wypowiedzi dla prasy Ondrej Burkacky z firmy konsultingowej McKinsey.

Nowi chętni do robienia procesorów

Do zwiększenia tumultu na rynku układów scalonych przyczynia się zaostrzająca się rywalizacja firm projektujących i produkujących procesory (4), takich jak AMD, Intel, Nvidia, do których chcą doszlusować, jako równorzędni gracze na rynku półprzewodnikowym, firmy znane dotychczas raczej z produkcji produktów finalnych i korzystające z gotowych komponentów, przede wszystkim Apple, za nim również Google i Amazon. Ten ostatni zresztą już wytwarza własne chipy.

Choć Intel przez dekady był niekwestionowanym liderem rynku, procesory Ryzen firmy AMD (Advanced Micro Devices), które od ok. 2018 roku zaczęły wyprzedzać pod względem parametrów technicznych produkty Intela, oraz ambicje firmy Nvidia, która była wcześniej znana głównie z tworzenia GPU, a ostatnio nabyła producenta chipów komputerowych ARM Holdings od Softbanku za 40 miliardów dolarów, sprawiły, że o Intelu, mającym ogromne problemy z opanowaniem procesu produkcji procesorów 7 nm, zaczęto mówić z czymś w rodzaju politowania.

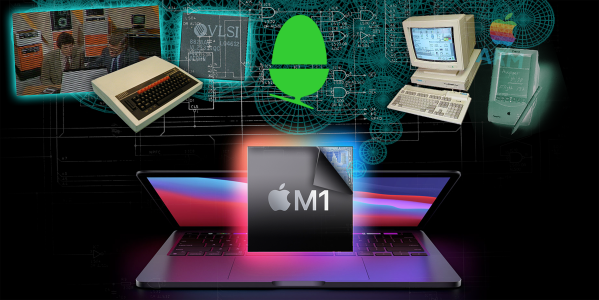

W listopadzie 2020 firma Apple zaproponowała w swoich niektórych urządzeniach M1 autorski procesor, który łączy w jednym układzie wiele funkcji wykonywanych wcześniej przez różne części komputera, takie jak procesor graficzny. "Do tej pory Mac potrzebował wielu różnych układów scalonych, aby zrealizować wszystkie swoje funkcje, w tym - procesora, układów wejścia/wyjścia, zabezpieczenia i pamięci", czytamy w komunikacie wprowadzającym M1. "W M1 technologie te zostały połączone w jeden system na chipie (SoC), zapewniając nowy poziom integracji w celu uzyskania większej prostoty i niesamowitej wydajności".

W drugiej połowie 2021 roku Apple przygotowuje się do wprowadzenia kolejnych procesorów, nazywanych w przeciekach medialnych M1X a także M2. Być może będą to dwa odrębne produkty.

Amazon przez lata stopniowo stawał się jednym z największych na świecie nabywców chipów komputerowych, które zasilały jego centra danych i usługi serwerowe AWS. Ostatnio firma coraz bardziej koncentruje się na projektowaniu własnych chipów. Amazon zaczął sygnalizować swoje zamiary już w 2015 roku, kiedy nabył Annapurna Labs, małego izraelskiego projektanta układów scalonych.

W mediach można znaleźć opinie klientów Amazona zadowolonych z korzystania z chipów własnych tej firmy. Smugmug, internetowy serwis fotograficzny, który używa AWS, twierdzi, że obniżył swoje koszty aż o 40% tylko dzięki przejściu na usługę AWS, opartą na własnym procesorze Amazona, nazwanym Graviton, opartym na architekturze ARM, podobnie jak M1 Apple’a. AWS w większości nadal opiera się na produktach Intela, ale Smugmug płaci mniej dzięki temu właśnie, że korzysta z usług opartych na własnym sprzęcie Amazona. "W rezultacie mamy znacznie niższy rachunek bez konieczności podejmowania jakichkolwiek działań", zachwalał Don MacAskill, dyrektor generalny Smugmug.

Nad własnymi wyspecjalizowanymi chipami pracują również Microsoft Corp. i Google Alphabet Inc., skupiając się na mniejszym zużyciu energii w swoich centrach danych. Według Applied Materials, największego producenta sprzętu do produkcji chipów, do 2025 roku centra danych będą zużywać 15% światowej energii elektrycznej, w porównaniu z około 2 proc. w 2020 roku. Utrzymanie niskiego zużycia energii staje się dla właścicieli centrów danych ważniejsze niż koszt sprzętu.

Technologia leżąca u podstaw niskoenergetycznych chipów do smartfonów jest tworzona przez ARM Ltd., brytyjską firmę półprzewodnikową, która udziela licencji, ale sama nie produkuje chipów. Amazon i Microsoft używają ARM jako podstawy do swoich wewnętrznych projektów chipów. Nvidia, która przejmuje ARM, obiecuje utrzymać otwarty dostęp do technologii ARM. Jednak niektórzy z klientów ARM już zgłosili zastrzeżenia do regulatorów rozważających zatwierdzających tę transakcję. Głośno krytykuje to przejęcie na przykład Elon Musk. Agencja Bloomberg News donosiła, że wśród skarżących są m.in. Google, Microsoft i Qualcomm.

Koniec "prawa Moore’a" czy nieprzerwany postęp do 2050 roku?

Osiemdziesiąt lat temu Alan Turing stworzył matematyczne podstawy obliczeń komputerowych. Dekadę później John von Neumann stworzył praktyczną architekturę komputera. Od tego czasu postępy w technologii informacyjnej zyskały fundamentalne znaczenie dla naszego życia i światowej gospodarki. Udało nam się przez parę dekad utrzymywać wykładniczy wzrost wydajności przy wykładniczo malejących kosztach. Opisuje to prawo, a raczej prognoza Gordona Moore’a z 1971 r., głosząca, że liczba tranzystorów, które możemy umieścić w mikroprocesorze, będzie się podwajać co 18-24 miesiące. I po latach doszliśmy do tego, że układ pamięci we współczesnym telefonie komórkowym ma milion razy większą pojemność niż komputer, który John Von Neumann zbudował dla Institute for Advanced Study ok. 1951 r.

Choć od ponad dekady wykładniczy wzrost wydajności techniki procesorowej ulega spowolnieniu (przynajmniej w klasycznym rozumieniu, ale do tego wrócimy), wykładniczy wzrost popytu utrzymuje się na niezmienionym poziomie. Ilość informacji, które generujemy jako gatunek, podwaja się co dwa lata. Zdecydowana większość tych informacji jest obecnie zapisywana w centrach danych i to ich wymogi, przede wszystkim wyzwania energetyczne, dyktują dziś postęp techniczny w krzemowej branży.

Patrick Moorhead, uznawany za czołowego analityka przemysłu półprzewodnikowego, powiedział kiedyś, że prawo Moore’a, według najściślejszej definicji mówiącej o podwajaniu gęstości chipów co dwa lata, już nie obowiązuje. Zarówno on jednak, jak i wielu ekspertów zwracają uwagę na sformułowanie "według najściślejszej definicji". W rzeczywistości producenci, od Intela po Apple, od wielu lat osiągają wzrosty wydajności procesorów innymi sposobami niż zagęszczanie liczby tranzystorów na chipie.

Trudno zliczyć wszystkie innowacyjne techniki, swoiste "wybiegi" w architekturze i w połączeniach jednostek przetwarzających, stosowane przez producentów. Zatrzymajmy się na chwilę przy nowych rozwiązaniach proponowanych, co samo w sobie jest interesujące, przez największego producenta w branży krzemowej, tajwańską firmę TSMC, od której fabryk, jak wspominaliśmy, wiele państw chce się "uwolnić".

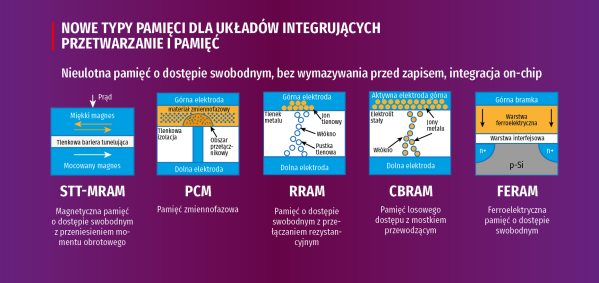

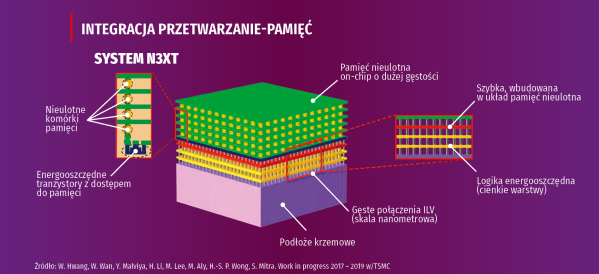

Jeszcze przed pandemią, w sierpniu 2019 roku Philip Wong, szef działu badań w Taiwan Semiconductor Manufacturing Corp., na konferencji Hot Chips na Uniwersytecie Stanforda mówił o najnowszych osiągnięciach w rozwoju techniki układów scalonych, wśród nich m.in. umieszczaniu pamięci bezpośrednio na procesorze (5), które znacznie zwiększą wydajność i spowodują, że "prawo Moore’a" będzie wciąż żywe", choć zapewne już nie "według najściślejszej definicji". Takie połączenie radykalnie zwiększy szybkość i wydajność, ponieważ układy logiczne na chipie będą szybciej otrzymywać potrzebne dane, bez niepotrzebnych "przestojów". Wong na slajdach swojej prezentacji, jak oceniano, "w sposób bezczelny prognozował nieprzerwany postęp w chipach aż do 2050 roku", podkreślając, że "postęp nie zatrzyma się w miejscu, gdy elektronika osiągnie fundamentalne granice wielkości atomów".

Przedstawiciel tajwańskiej firmy mówił o technikach, nad którymi prace badawcze trwają od lat, w tym o zastosowaniu w chipach nanorurek węglowych, że obecnie istnieją już praktyczne możliwości ich wdrożenia. Innowacja polegająca na zastosowaniu dwuwymiarowych materiałów warstwowych, pozwalająca elektronom na łatwiejszy przepływ przez układy scalone, również, jak twierdził Wong, jest już produkcyjnie dostępna.

Kolejna nowa technika układania w architekturze 3D (6) oznaczać ma, że funkcje procesora komputerowego, które obecnie są odizolowane, mogą być umieszczone w wielu warstwach, połączonych szybkimi ścieżkami danych, zwanymi przelotkami krzemowymi. "W tego typu systemach, w których wiele warstw logiki i pamięci jest zintegrowanych w drobnoziarnisty sposób, łączność jest kluczowa", mówił Wong.

Przygotowania do walnej bitwy

Przez ok. dwie i pół dekady branża procesorów komputerowych była zdominowana przez jedną architekturę - x86 - utożsamianą z imperium Intela. Lata 90. to powstanie kilku architektur technicznie konkurujących z Intelem, ale ostatecznie pod koniec dekady AMD było osamotnione w walce z ówczesnym dominatorem. W połowie pierwszej dekady XXI wieku IBM zrezygnował z koncepcji G5. Wydawało się, że Intel ostatecznie wygrał. Po latach wygląda to bardziej jak chwilowa przewaga niż trwałe zwycięstwo.

Rynek procesorów rozgrzewa się teraz znów do temperatury, której nie zaznaliśmy od dawna. Znów pojawiają się chipowe startupy z buńczucznymi zapowiedziami, np. firma SiFive, która twierdzi, że zbuduje układy RISC-V do komputerów stacjonarnych. Inny startup, Nuvia, przejęty niedawno przez Qualcomma, ma zaoferować zupełnie nowe, niestandardowe układy krzemowe do 2023 roku. Wielcy też czują powiewy wiatru zmian - zarówno AMD, jak i Intel zadebiutowały ostatnio z nowymi architekturami. AMD rozszerzyło swój projekt Zen 3 na serwery i urządzenia przenośne, a Intel wprowadził nowe układy Rocket Lake i Ice Lake Server.

Premiera Ryzena w kwietniu 2017 roku była początkiem nowej ery w skalowaniu wydajności pecetów. Architektury Zen, Zen+, Zen 2 a potem Zen 3 firmy AMD wielokrotnie wybijały się ponad swoją kategorię wagową. Do gry weszło Apple z własnym M1.

Choć procesor ten nie jest nokautem dla AMD i Intela, to wyznacza nową poprzeczkę w wydajności i efektywności energetycznej, z którą obie firmy bazujące w swoich głównych produktach na x86 będą musiały się zmierzyć w dłuższej perspektywie.

Apple nie zamierza jednak przejąć masowego rynku pecetów. Przynajmniej tak się wydaje. Inaczej Qualcomm, który ogłosił, że zamierza wprowadzić na rynek laptopy oparte na nowej konstrukcji procesora Nuvia. Intel i AMD mają jeszcze trochę swobody we wprowadzaniu nowego sprzętu na rynek, ale długo odkładana walna bitwa pomiędzy x86 i ARM zbliża się wielkimi krokami.

Pod kierownictwem Pata Gelsingera, nowego dyrektora generalnego Intela, firma zwraca się w kierunku budowania nowych jednostek CPU i GPU. Jednak nawet w najlepszym scenariuszu dla Intela, odzyskanie dominującej pozycji zajmie firmie wiele lat.

Gelsinger obiecał, że Alder Lake pojawi się na desktopach pod koniec 2021 roku, zastępując Rocket Lake. Procesory te zbudowane są w technologii 10 nm. Firma wcześniej potwierdziła wprowadzenie rodziny mikroprocesorów 7 nm, obecnie nazywanej Intel 4, o nazwie Meteor Lake, która ma się ukazać w 2023 r.

Jeśli Intel nie będzie w stanie dostatecznie szybko wprowadzić konkurencyjnych konstrukcji, to w pewnym sensie będzie potrzebował produktów AMD, by wykazać, że x86 może konkurować z architekturą ARM. Jeśli AMD nie sprosta zadaniu, obaj wielcy producenci x86 mogą zostać zepchnięci na margines. AMD może być teraz gwiazdą rynku pecetów, ale potrzebuje wolumenu sprzedaży i ogromnej bazy instalacyjnej Intela, aby pozycjonować swoje procesory jako atrakcyjne alternatywy wobec rozwiązań ARM przedstawianych jako wciąż niepewna alternatywa.

Zen 3, który wszedł w 2020 r., nie zwiększył drastycznie liczby rdzeni ani częstotliwości taktowania, jednak ma znacznie lepsze parametry energetyczne niż poprzednie wersje chipów AMD. Zen 4, który według przewidywań ma mieć przeprojektowaną płytę główną, nowy proces produkcyjny i obsługę szybkich pamięci DDR5, może pojawić się w 2022 roku.

Wstępne testy nowych macbooków potwierdzają, że oparty na architekturze ARM M1 (7) oferuje dużą przewagę wydajnościową nad tradycyjnymi laptopami z procesorami Intela i niemal dwukrotnie dłuższy czas pracy na baterii. Projektując swój pierwszy procesor dla pecetów, firma Apple zdobyła przewagę, ale producenci komputerów PC z systemem Windows nie chcą pozostać w tyle. Dell, HP i inni producenci komputerów coraz głośniej domagają się od Intela lepszych procesorów, które będą w stanie konkurować z M1. Jeśli dawny imperator krzemowy odpowiednio szybko tego nie zrobi, to będą szukać alternatywnych dostawców.

Kluczową technologią, na której opiera się nowy układ Apple, jest zestaw instrukcji ARM. Apple korzysta zarazem z doświadczeń dekady projektowania niestandardowych procesorów do iPhone’ów. Procesory te muszą być bardzo energooszczędne, aby nie "zjadać" zbyt szybko baterii smartfona. Przeniesienie tej wydajności do laptopów umożliwia duży wzrost wydajności i wydłużenie czasu pracy na ładowanie.

Procesory Intel dla komputerów tej klasy po prostu nie są tak wydajne. Gdy są umieszczone w cienkim i lekkim laptopie, muszą obniżać szybkość pracy, aby uniknąć przegrzewania. W rezultacie, w porównaniu z macbookiem z procesorem Intela wydanym na początku tego roku, energooszczędny procesor M1 zapewnia o 40 proc. lepsze wyniki w popularnym benchmarku CPU i o 70 proc. dłuższy czas pracy na baterii podczas przeglądania stron internetowych.

Przejście na platformę ARM staje się szerzej widoczną tendencją. Microsoft np. przeportował system Windows na platformę ARM, umożliwiając firmom takim jak Acer, HP i Lenovo wypuszczenie na rynek "komputerów hybrydowych" (małych komputerów typu PC-tablet) opartych na procesorach o architekturze ARM firmy Qualcomm. ARM zaczyna również pojawiać się w centrach danych. Amazon twierdzi, że Graviton oferuje o 20 proc. lepszą wydajność niż porównywalny procesor Xeon przy 20% niższych kosztach.

Zmiana z zestawu instrukcji x86 Intela na ARM stwarza jednak problemy z oprogramowaniem. Podobnie jak Microsoft, Apple musiało "przepiąć" swój system operacyjny MacOS, aby działał na ARM, wraz ze wszystkimi aplikacjami firmowymi. Natywne aplikacje w pełni wykorzystują wyższą wydajność M1 i czas pracy na baterii. Wiele aplikacji firm trzecich jest jednak zaprojektowanych wyłącznie do procesorów Intela. Aby zapewnić kompatybilność z tymi aplikacjami, Apple udostępnia emulator (o nazwie Rosetta 2), który tłumaczy z x86 na ARM, ale aplikacje działają z szybkością przeciętnie o połowę mniejszą niż aplikacje natywne.

Apple nie sprzedaje swoich procesorów innym producentom komputerów. Aby uzyskać podobne procesory oparte na architekturze ARM, firmy te muszą zwrócić się do dostawców układów scalonych, takich jak Nvidia i Qualcomm. Nvidia opracowała już wysokowydajny procesor kompatybilny z ARM (znany jako Carmel), który mogłaby połączyć ze swoją technologią graficzną, tworząc procesory dla komputerów PC podobne do procesorów Apple. Qualcomm, jak wspomniano, dostarcza procesory oparte na ARM dla małych pecetów, ale nie spełniają one na razie bardziej rygorystycznych wymagań laptopów.

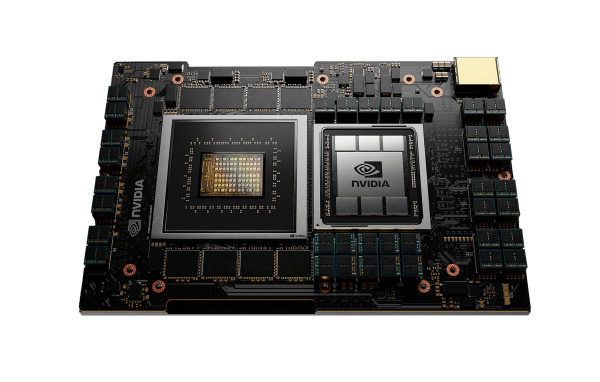

NVIDIA wprowadza na rynek procesor Grace (8), który zwiększy wydajność procesorów ARM w ogromnych obciążeniach związanych ze sztuczną inteligencją, w superkomputerach AI wykorzystujących ogromne zbiory danych.

Procesor NVIDIA Grace został zaprezentowany na konferencji NVIDIA GTC 2021 i od razu zrobił furorę w świecie obliczeń wymagających wysokiej wydajności (HPC). Grace będzie wykorzystywany w potężnych nowych superkomputerach opracowywanych przez Narodowe Laboratorium Los Alamos i Szwajcarskie Narodowe Centrum Superkomputerowe. NVIDIA twierdzi, że system oparty na Grace będzie w stanie wytrenować model przetwarzania języka naturalnego (NLP) o bilionie parametrów dziesięć razy szybciej niż współczesne systemy oparte na NVIDIA DGX, które działają na procesorach x86.

Jak widać, nowa wielka wojna krzemowa zaostrza się. Dobra wiadomość dla zwykłych użytkowników komputerów jest taka, że powinna ona doprowadzić do tego, że laptopy odnotują kolejny duży wzrost szybkości działania, wydajności i żywotności baterii. I to wszystko pomimo faktu, że "prawo Moore’a już nie obowiązuje".

Mirosław Usidus