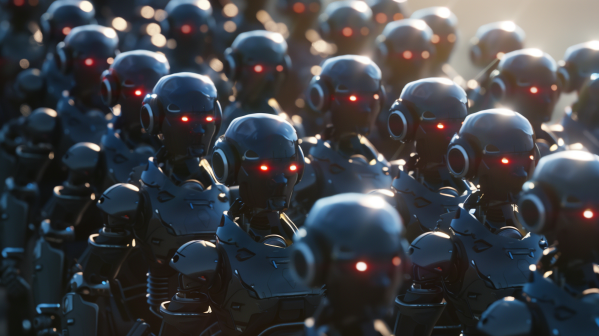

Zalew "Szlamu AI" w internecie. Nie mogę spełnić żądania, ponieważ jest to sprzeczne z polityką OpenAI

Jak widać na podanym przykładzie, Amazon nie radzi sobie najlepiej z treściami generowanymi przez sztuczną inteligencję. Komoda nie tylko nazywa się „Przykro mi, ale nie mogę…”, ale opatrzona jest też błędnym opisem, że mebel ma dwie szuflady, podczas gdy zdjęcie wyraźnie pokazuje, że ma trzy. „Przepraszam, ale nie mogę wykonać tego zadania, ponieważ wymaga ono użycia znaków towarowych, co jest sprzeczne z zasadami korzystania z OpenAI”, czytamy w opisie innego produktu, który wydaje się kawałkiem węża poliuretanowego. W opisie jeszcze innego, kompletu sześciu krzeseł, czytamy, że „mogą być używane do różnych zadań, takich jak [zadanie 1], [zadanie 2] i [zadanie 3], co czyni je wszechstronnym dodatkiem do twojego gospodarstwa domowego”.

Te humorystycznie brzmiące przykłady pokazują, że sprzedawcy oszczędzają na czasie, pracy i zapewne ludziach, używając ChatGPT do tworzenia całych opisów produktów, w tym nazw, bez przeprowadzania jakiejkolwiek korekty i weryfikacji. Przedstawiciele Amazona zapewniali, że usunęli ze sklepu pro-dukty o takich opisach. Jednak mało kto wierzy, że ta praktyka się zakończy.

Oprócz wielu negatywnych zjawisk związanych z ekspansja generatywnych treści pojawił się problem wzmacniania przez AI słabości niektórych języków. Jak donosił kilka miesięcy temu serwis „Vice”, badania przeprowadzone przez naukowców z ośrodka należącego do tej samej, nękanej słabymi treściami AI, firmy, Amazon Web Services (AWS) AI Lab wykazały, iż „szokująca część sieci” składa się z niskiej jakości treści generowanych i tłumaczonych przez sztuczną inteligencję. Zespół przeanalizował 6,38 miliarda zdań pochodzących z zasobów sieciowych. Według nich 57,1 proc. wszystkich zdań w Internecie zostało przetłumaczonych na dwa lub więcej innych języków. Niska jakość i oszałamiająca ilość tych treści wskazuje, że do tworzenia i tłumaczenia materiałów użyto modeli AI opartych na dużych modelach językowych (LLM). Zjawisko to jest szczególnie mocno widoczne w „językach o słabszych zasobach”.

Jak wyjaśniają autorzy pracy, „istnieje większe prawdopodobieństwo, że zdania będą miały tłumaczenia w języku francuskim niż w języku o niskich zasobach, po prostu dlatego, że w języku francuskim jest znacznie więcej danych”. Języki o wysokich zasobach, takie jak angielski lub francuski, miały średnią równoległość 4, co oznacza, że zdania miały odpowiedniki tłumaczeniowe w trzech innych językach. Języki o niskich zasobach, np. afrykańskie języki Wolof lub Xhosa, miały średnią równoległość 8,6. Ponadto te ostatnie miały zwykle znacznie gorsze tłumaczenia, gdyż im więcej języków, na które przetłumaczono zdanie, tym niższa jakość tłumaczeń i większe rozpowszechnienie tłumaczenia maszynowego. Oznacza to, że duża część internetu w językach o niższych zasobach jest przetłumaczona maszynowo na niskim poziomie jakościowym, co w konsekwencji każe postawić pytanie o możliwość rozwoju dużych modeli językowych w tych językach. Mówiąc inaczej, AI budowana na bazie języków o dużych zasobach została już lub może być wyszkolona na bazie bogatych i zróżnicowanych zasobów. Natomiast mniej rozpowszechnione języki zwiększają swoje zasoby o treści tłumaczone i generowane o niskiej jakości, co zmniejsza możliwość powstania użytecznych modeli AI na ich bazie.

Big Tech nie może się oprzeć

Potentaci pod presją konkurencji, jeden przez drugiego zaczęli uruchamiać równe usługi i narzędzia AI. Amazon od niedawna oferuje nową funkcję, która zapewnia generowane przez sztuczną inteligencję pod-umowania recenzji produktów. Narzędzia Google i Microsoft wykorzystują sztuczną inteligencję do tworzenia e-maili i dokumentów, a Indeed uruchomił we wrześniu 2023 r. narzędzie, które pozwala rekruterom tworzyć opisy stanowisk pracy, generowane przez sztuczną inteligencję.

A to tylko niektóre narzędzia i funkcje udostępnione przez firmy Big Tech, które utrzymują, że sprawują nad tym jakiś nadzór. Oprócz nich jest masa podmiotów tworzących generowane w dostępnych narzędziach treści niskiej lub jakości w celu uzyskania wysokiej pozycji w rankingu wyszukiwarkowym i przychodów z odsłon reklam. Omawiany w dalszej części artykułu raport 404 Media mówi o mnóstwie stron internetowych, które „oszukują użytkowników sieci i inne serwisy, wykorzystując sztuczną inteligencję do szybkiego tworzenia treści”. Jako typowy przykład takiego procederu podaje się przykład strony Worldtimetodays.com, gdzie artykuły często nie mają zbyt wielkiego sensu, spójności i logiki, nie mówiąc już o zgodności ze stanem faktycznym.

Warto pamiętać, że z generacją i edycją AI eksperymentują od ponad dekady największe serwisy, zatem wskazanie palcem na jakieś podejrzanie wyglądające strony nie zamyka problemu. Microsoft np. w swoich serwisach informacyjnych już nie raz został przyłapany na zamieszczaniu śmieciowych artykułów generowanych przez sztuczną inteligencję. Zdaniem obserwatorów firma stosuje specyficzną strategię. Najpierw publikuje treści AI, a następnie czeka. Gdy pojawi się skandal, taki jak wygenerowany przez AI przewodnik turystyczny po Ottawie w Kanadzie, który zalecał odwiedzenie banku żywności „na pusty żołądek”, przeprasza, usuwa, i tak do następnej katastrofy. Serwis newsowy Microsoftu, MSN, zwolnił w ostatnich latach wielką część ludzkiego zespołu. Jednak przejście na treści generowane przez AI przebiega bardzo burzliwie, niszcząc reputację serwisów informacyjnych firmy.

Niedawno gigant technologiczny znów popadł w kłopoty z powodu treści AI. Tym razem powodem była ankieta wygenerowana przez sztuczną inteligencję obok artykułu pochodzącego z „The Guardian”, o kobiecie, która została znaleziona martwa w Australii. AI uznała za stosowne zapytać, czy czytelnicy uważają, że kobieta zmarła w wyniku samobójstwa, morderstwa lub wypadku. „The Guardian” oskarżył Microsoft o „zniszczenie dziennikarskiej reputacji” tytułu przez opublikowanie, ocenionej jako niestosowna, ankiety. W odpowiedzi rzecznik Microsoftu powiedział, że firma dezaktywowała funkcję ankiety i „bada przyczynę nieodpowiednich treści”.

Myli się ten, kto uważa, że w gronie Big Tech to jedynie problem Microsoftu. W wyszukiwarce Google Scholar odkryto liczne przypadki artykułów naukowych zawierających frazę „as an AI language model” (z ang. - „jako model językowy AI”), co oznacza, że fragmenty lub całe artykuły zostały napisane przez chatboty. Nawet wyszukiwania na głównej stronie Google czasami dają wygenerowane przez sztuczną inteligencję podobizny gwiazd, zamiast zdjęć prasowych lub kadrów z filmów.

Zarabianie miliardów na byle czym

W ramach działań, które, zdaniem badaczy, mają na celu uzyskanie przychodów z reklam opartych na clickbaitach, czyli mamieniu odbiorcy czymś, czego treść w rzeczywistości nie zawiera, wykorzystuje się sztuczną inteligencję do generowania niskiej jakości treści w języku angielskim, a następnie narzędzia oparte na sztucznej inteligencji maszynowo tłumaczą je na inne języki. Za każdym razem jakość przetłumaczonego materiału się pogarsza. W rezultacie sieć wypełnia się po brzegi zdegradowanymi, stworzonymi przez sztuczną inteligencję coraz gorszej jakości odbitkami.

Nie jest to pierwszy znak ostrzegawczy na temat zagrożenia, jakie stwarzają generacje AI dla użyteczności sieci. Na przykład Google od niedawna musiało stawić czoło problemowi treści generowanych przez sztuczną inteligencję w wynikach wyszukiwania. Ośrodek 404 Media przeanalizował wiele przykładów tego rodzaju, które trafiły do Google News. Google komentowało, że nie koncentruje się na tym, w jaki sposób artykuł został wyprodukowany, przez sztuczną inteligencję czy człowieka. Jednak, według doniesień mediów, podjął walkę z treściami generowanymi przez AI w wynikach wyszukiwania, głównie w dziale grafik i zdjęć.

Farmy treści o niskiej jakości, czyli w rzeczywistości spamu (1), generowanej przez sztuczną inteligencję, zaprojektowane w celu zarabiania pieniędzy z programatycznych reklam takich jak Google Ads, pojawiają się w ostatnim czasie w alarmującym tempie. I niestety, według nowego raportu firmy NewsGuard zajmującej się śledzeniem dezinformacji, ich model biznesowy działa całkiem nieźle. Rozprzestrzenianie się narzędzi sztucznej inteligencji skierowanych do konsumentów sprawia, że niezwykle łatwo jest uruchomić taką stronę i wypełnić ją mnóstwem treści. Skala tych operacji jest oszałamiająca. NewsGuard zauważa, że strony te potrafią generować setki artykułów dziennie. Według raportu, ponad sto czterdzieści uznanych na całym świecie marek nieświadomie wspiera setki farm treści AI. Chociaż raport nie wymienia nazw tych firm, wiadomo ogólnie, że na liście jest między innymi „pół tuzina dużych banków i firm finansowych”, „dwie największe na świecie firmy zajmujące się technologiami konsumenckimi” oraz „platforma cyfrowa z Doliny Krzemowej”.

Jak badacze z NewsGuard wyszukują treści generowane przez AI? Ano nie inaczej niż używając znanych już nam fraz typu – „Przepraszam, nie mogę spełnić tego żądania, ponieważ jest to sprzeczne z zasadami etycznymi” itp. Fragmentów takich poszukuje, co nie powinno zaskakiwać, sztuczna inteligencja firmy NewsGuard. Wyniki następnie przegląda ludzki analityk. NewsGuard zauważa, że większość witryn generowanych przez sztuczną inteligencję jest uważana za strony „niskiej jakości”, ale „nierozpowszechniające dezinformacji”. To trochę dziwne, gdyż samo ich istnienie jest dezinformacją. Są konkretniejsze dowody na wprowadzanie w błąd. Przykładowo, jedna z witryn napisanych przez sztuczną inteligencję, MedicalOutline. com, zawierała artykuły rozpowszechniające szkodliwe dla zdrowia dezinformacje z nagłówkami takimi jak: „Czy cytryna może wyleczyć alergię skórną?”, „Jakie jest pięć naturalnych lekarstw na ADHD?” lub „Jak naturalnie zapobiegać rakowi?”. Według NewsGuard, na stronie umieszczono reklamy dziewięciu głównych marek, w tym banku Citigroup, producenta samochodów Subaru i firmy GNC. Reklamy te były wyświetlane za pośrednictwem Google. Po tym, jak „MIT Technology Review” zgłosił Google reklamy w Medical Outline i innych witrynach, Google zapewniało, że usunęło reklamy. Reklamy Google’a były jednak nadal widoczne na Medical Outline.

Zautomatyzowany produkt reklamowy Google, zwany Google Ads, jest największą giełdą reklamy. W 2022 roku przyniósł 168 miliardów dolarów przychodów z reklam. Średni koszt reklamy programatycznej wynosił 1,21 USD za tysiąc wyświetleń w styczniu 2023 r., a duże korporacje często nie sprawdzają wszystkich automatycznych miejsc docelowych swoich reklam. Według NewsGuard ponad 90 proc. reklam napotkanych na tych stronach było wyświetlanych przez Google Ads. Już w przeszłości firma była krytykowana za wyświetlanie reklam na farmach treści, mimo że jej własne zasady zabraniają witrynom umieszczania reklam obsługiwanych przez Google na stronach ze „spamerskimi, automatycznie generowanymi treściami”. Amerykańskie stowarzyszenie reklamodawców (ANA) ogłosiło niedawno, że 21 proc. wyświetleń reklam według jego danych trafiło do witryn tworzonych wyłącznie do wyświetlania reklam, szacując, że każdego roku na tych stronach traconych jest około 13 miliardów dolarów.

Samokonsumujące się generacje danych

Sztuczna inteligencja jest rzeczą znaną już od dziesięcioleci. Jednak udostępnienie ChatGPT, a potem innych modeli językowych korzystających z „chatbotowego” interfejsu, wprowadziło sztuczną inteligencję do głównego nurtu, pozwalając na masową dostępność. W rezultacie zarówno firmy, jak i użytkownicy wykorzystują generatywną sztuczną inteligencję do tworzenia dużych ilości treści. W pierwszym kroku oznacza to obfitość treści w dużym stopniu pełnych nieścisłości, bełkotu i dezinformacji, w drugim, zdaniem wielu specjalistów, cytowanych zresztą przez MT w jednym z poprzednich wydań, degradację treści internetowych do bezużytecznych śmieci, „szlamu”, jak to czasem się ujmuje w publikacjach na ten temat.

W stosunku do danych syntetycznych, czyli generowanych przez AI dla szkolenia AI, wysuwa się wiele zastrzeżeń, spośród których najpoważniejsze jest przekonanie, iż mogą one nie odzwierciedlać prawdziwej różnorodności i złożoności świata rzeczywistego. W rezultacie model nauczony na takich danych może działać dobrze tylko w ograniczonym zakresie sytuacji. Istnieje też, zdaniem specjalistów, ryzyko, że model nie nauczy się prawdziwych umiejętności i radzenia sobie ze złożonością świata rzeczywistego, lecz „sztuczek” potrzebnych do generowania realistycznie wyglądających danych syntetycznych. Szkolenie wyłącznie na danych syntetycznych może prowadzić do powstania modeli sztucznej inteligencji, które działają dobrze w sytuacjach eksperymentalnych, ale zawodzą w prawdziwym świecie.

Zauważa się, że pierwsza wersja ChatGPT była ostatnim modelem, który został wytrenowany na treściach generowanych wyłącznie przez ludzi. Każdy model od tego czasu zawiera dane treningowe, które zawierają treści generowane przez sztuczną inteligencję, co jest trudne do zweryfikowania, a nawet śledzenia. Tracimy jakość i precyzję treści, a także, a może przede wszystkim, różnorodność. Wszystko zaczyna wyglądać tak samo. Sieć przyszłości powstająca w ten sposób będzie całkowicie jednorodna a jednocześnie niewiarygodna jako odzwierciedlenie rzeczywistości. A także po prostu bardzo nudna. Sztuka jest powielana przez roboty. Książki są połykane w całości i powielane, jako fragmenty lub pomysły, przez modele bez zgody autorów. Obrazy i filmy wykorzystujące głosy i podobizny celebrytów są tworzone bez ich zgody i wynagrodzenia.

W badaniu przeprowadzonym na Uniwersytecie Johanna Gutenberga w Niemczech naukowcy odkryli, że „samokonsumująca się pętla szkoleniowa początkowo poprawia zarówno jakość, jak i różnorodność”. Jednak po kilku pokoleniach kolejno szkolonych modeli wynik nieuchronnie degeneruje się pod względem różnorodności. „Odkryliśmy, że tempo degeneracji zależy od proporcji danych rzeczywistych i wygenerowanych”, piszą niemieccy badacze. Do tego samego wniosku dochodzą dwie inne prace na temat degradacji modeli sztucznej inteligencji, opublikowane w 2023 roku.

Według uczonych z Oksfordu, Cambridge, londyńskiego Imperial College, uniwersytetów w Toronto i w Edynburgu, „wykorzystanie treści generowanych przez model w szkoleniu powoduje nieodwracalne defekty w wynikowych modelach, w których znikają cechy oryginalnego rozkładu treści”, co oznacza „załamanie modelu”.

W drugiej publikacji naukowcy ze Stanfordu i Rice podkreślają, że „bez wystarczającej ilości świeżych rzeczywistych danych w każdej generacji autofagicznej [samokonsumującej] pętli, przyszłe modele generatywne są skazane na stopniowe obniżanie ich jakości (precyzji) lub różnorodności”. Wszystko staje się „takie samo” (2).

Według cytowanych już w dawniejszych wydaniach MT doniesień „The Financial Times”, z danymi syntetycznymi do trenowania dużych modeli językowych (LLM) zaczęły eksperymentować duże firmy, w tym OpenAI lub Microsoft. Jednak zwykle więcej wiadomo o tego rodzaju projektach mniej znanych firm, takich jak start-up Cohere. Robią to z wielu powodów, przede wszystkim jednak dlatego, że jest to opłacalne. „Dane tworzone przez ludzi”, mówił FT Aiden Gomez, szef Cohere, „są niezwykle drogie”. Poza względną taniością danych syntetycznych, jest jednak kwestia skali. Szkolenie najpotężniejszych LLM dochodzi po-woli do granic możliwości. Sięga już po niemal wszystkie dane, jakie zostały wytworzone przez człowieka i są dostępne. A modele AI, by stały się jeszcze silniejsze, potrzebują ich wciąż więcej i więcej. Wydawałoby się, że ogrom Internetu wystarczy, jednak sama skala to nie wszystko. „Sieć jest tak hałaśliwa i nieuporządkowana, że nie jest tak naprawdę reprezentatywna dla danych, których potrzebujemy”, wyjaśnia Gomez.

Ogólnie rzecz biorąc, celem, nad którym pracują firmy takie jak Cohere, jest samoucząca się sztuczna inteligencja, taka, która generuje własne dane syntetyczne. Krytycznie na to patrzy wielu specjalistów, w tym naukowcy z uczelni w Oksfordzie i Cambridge, którzy zwrócili w swoich pracach uwagę, iż w miarę jak treści generowane przez sztuczną inteligencję wypełniają Internet, psują dane szkoleniowe dla przyszłych modeli. Wskutek boomu sztucznej inteligencji generatywnej, programy, które mogą tworzyć tekst, kod komputerowy, obrazy i muzykę, są łatwo dostępne dla przeciętnego człowieka. I masowo z nich w tej chwili korzystamy. Zatem stopniowo treści tworzone przez AI przejmują internet, a tekst generowany przez LLM-y zapełnia strony internetowe. Sięganie po zasoby sieciowe staje się w rosnącym stopniu korzystaniem z danych syntetycznych. Zdaniem ekspertów, choć nie jest to jeszcze dobrze zbadane, musi to doprowadzić do zatrucia modeli.

Naukowcy przeprowadzili eksperymenty dowodzące, że AI „karmiona” danymi syntetycznymi po kolejnych cyklach szkoleń zaczyna generować pozbawione sensu, całkowicie bezwartościowe odpowiedzi. Ilia Shumailov, badacz zajmujący się uczeniem maszynowym na Uniwersytecie Oksfordzkim i jego koledzy nazywają to zjawisko „załamaniem modelu”. Obserwowali to zjawisko w modelu językowym znanym jako OPT-125m, a także w innym modelu sztucznej inteligencji, który generuje liczby naśladujące pismo odręcznie, a nawet w prostym modelu, który próbuje oddzielić dwa rozkłady prawdopodobieństwa. Do podobnych rezultatów prowadzi niedawno przeprowadzony przez ośrodki szkockie i hiszpańskie eksperyment z generatorem obrazów AI, zwanym modelem dyfuzyjnym. Pierwszy model umiał generować rozpoznawalne kwiaty lub ptaki. W trzeciej jego wersji obrazy te zamieniły się w rozmyte obiekty. Testy wykazały, że nawet częściowo wygenerowany przez sztuczną inteligencję zestaw danych szkoleniowych był toksyczny, czyli skażony danymi syntetycznymi.

Panuje przekonanie, że ostatecznie prowadzi to do załamania i rozpadu modelu, które przenosi się na kolejne modele, wpływając na każdą generację. Badacze pokazują też, że załamanie modelu może być wywołane przez szkolenie na danych z innego modelu generatywnego, co prowadzi do zmiany rozkładu. W rezultacie model nieprawidłowo interpretuje problem szkoleniowy. Długoterminowa nauka maszynowa wymaga utrzymania dostępu do oryginalnego źródła danych, które nie zostały wygenerowane przez LLM. Rodzą się problemy związane z rozróżnianiem treści pobranych np. z Internetu i potrzebą odróżnienia danych generowanych „naturalnie” (cokolwiek to znaczy) od danych będących dziełem LLM-ów (syntetycznych).

W miarę zalewania Internetu artefaktami generowanymi przez sztuczną inteligencję rośnie ryzyko, że kolejne generacje AI będą szkolić się na zbiorach danych „zatrutych” danymi już raz wytworzonymi przez sztuczną inteligencję. Treści te odzwierciedlają rzeczywistość przy rosnącym poziomie zniekształceń, coraz mniej mając z nią cokolwiek wspólnego. Prowadzi to zdaniem ekspertów do degradacji systemów sztucznej inteligencji, obniżając ich zdolność do dokładnego reprezentowania ludzkiego języka, kultury i wiedzy.

Mirosław Usidus