Superbaterie, nadprzewodniki w pokoju, komputery kwantowe - gdzie to wszystko jest?

Niestety, za każdym razem bliższe zapoznanie się ze stanem badań i perspektywami powstania działających zadowalająco prototypów przynosi spore rozczarowanie. W żadnym wypadku nie wygląda na to, że już "za moment" będziemy mieć małe akumulatory magazynujące wielkie ilości energii, nadprzewodniki działające bez drogich krioinstalacji czy maszyny kwantowe rozwiązujące problemy, z którymi nasze najpotężniejsze superkomputery sobie nie radzą.

W każdej z tych dziedzin wciąż ogromną rolę ma do odegrania nauka, a precyzyjnie mówiąc, fizyka. Czy to będą poszukiwania i badanie nowych materiałów, czy właściwe zrozumienie zjawisk w nich zachodzących, które mogłoby pomóc przezwyciężyć trudności. To od fizyków należy oczekiwać znalezienia odpowiedzi i rozwiązania problemów, które otworzą drogę do upragnionych i wyczekiwanych przełomów.

Na superbaterie przyjdzie poczekać dłużej

Z analizy Massachusetts Institute of Technology z listopada 2019 r. wynika, że spadek kosztów baterii, który dawało się zaobserwować ostatnimi laty, wkrótce się zatrzyma. Raport MIT Energy Initiative ostrzega, że przy obecnie stosowanych rozwiązaniach, czyli głównie akumulatorach litowo-jonowych, pojazdy elektryczne mogą nigdy nie osiągnąć tej samej ceny co spalinowe. Przede wszystkim przez koszt surowców. Zdaniem analityków prawdopodobnie minie kolejne dziesięciolecie, zanim wyeliminowane zostaną różnice w kosztach eksploatacji.

Obecne akumulatory litowo-jonowe kosztują od około 175 do 300 dolarów za kilowatogodzinę. Wcześniej wielu komercyjnych i akademickich badaczy przewidywało, że koszty takich akumulatorów osiągną 100 USD/kWh do 2025 r. lub wcześniej, a miałaby to być "magiczna liczba", w której pojazdy elektryczne i napędzane paliwami ciekłymi osiągają parytet cen detalicznych bez doliczania dotacji. Nawet jednak osiągnięcie progu 100 USD do 2030 r. wymagałoby utrzymania kosztów materiałowych na niezmienionym poziomie przez następną dekadę, w okresie, w którym spodziewany jest gwałtowny wzrost globalnego popytu na akumulatory litowo-jonowe, zauważa inny raport MIT "Insights into Future Mobility". Przewiduje, że do tego czasu koszty prawdopodobnie spadną jedynie do 124 USD za kilowatogodzinę. Cena auta elektrycznego będzie więc wciąż dużo wyższa niż benzyniaka.

Dalej postępujący spadek kosztów po 2030 r. będzie prawdopodobnie wymagał przejścia od dominującej obecnie techniki litowo-jonowej do zupełnie innych rozwiązań, takich jak baterie litowo-metalowe, półprzewodnikowe czy litowo-siarkowe. Zdaniem ekspertów wątpliwe jest, czy któraś z nich będzie w stanie zastąpić litowo-jonowe baterie do 2030 r.

Nowe rozwiązania w opisach brzmią niezwykle zachęcająco. Kuzhikalail M. Abraham, konstruktor akumulatorów litowo-powietrznych, mówi w wywiadach prasowych, że jego technika może pozwolić zbudować pojazdy elektryczne o zasięgu 1000 mil (1600 km) na jednym ładowaniu, smartfony, które pracować będą przez tydzień bez ładowania i drony, które latają godzinami, a nie najwyżej dziesiątki minut jak obecnie.

Tak naprawdę gra toczy się nie tylko o ów magiczny zasięg i czas pracy. Równie ważny jest cykl życia akumulatora, czyli liczba cykli ładowania/rozładowania, zanim jego pojemność spadnie poniżej 80 proc. pierwotnej pojemności. Kolejny postulat to zwiększanie gęstości energii, która jest mierzona jako energia na jednostkę masy lub objętości akumulatora.

W 1991 roku, kiedy to Sony zaproponowało pierwszą rynkową wersję baterii litowo-jonowej, miała ona pojemność nieco mniejszą niż amperogodzina. Teraz akumulator tej samej wielkości ma pojemność ok. 3,6 amperogodziny. Tak więc w ciągu ostatnich nieomal trzech dekad pojemność akumulatorów litowo-jonowych wzrosła czterokrotnie (1). W tym czasie zwiększyła się również żywotność baterii - z około stu cykli do ponad tysiąca.

Materiały stosowane w dzisiejszych bateriach litowo-jonowych to związki (tlenki) tego metalu przejściowego, który ma określoną limitem maksymalną liczbę generowanych w reakcjach elektronów. Aby liczbę elektronów zwiększyć, nie zwiększając znacząco masy ogniwa (lekkość litu to jeden z jego największych atutów), szuka się innych rozwiązań, np. stosowanie siarki, tlenu lub materiału półprzewodnikowego.

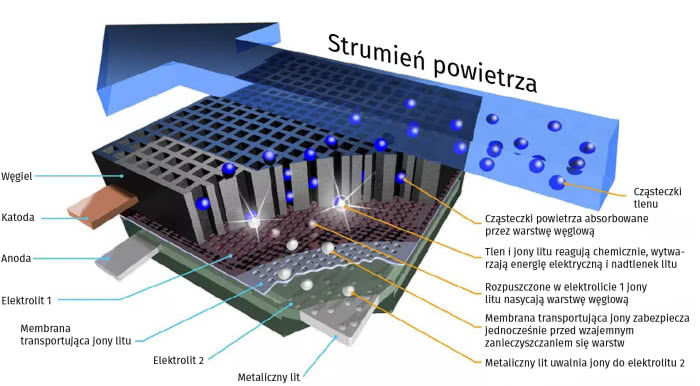

Wspomniane ogniwa litowo-powietrzne (2), a właściwie należałoby mówić litowo-tlenowe, bo o ten gaz z powietrza chodzi, mają dużo, wyższe gęstości energii niż ogniwa litowo-jonowe. Teoretycznie energia akumulatorów litowo-powietrznych wynosi około 40,1 MJ na kilogram, co stanowi około 85 proc. gęstości energii benzyny. Nawet jeśli przyjmiemy najgorszy scenariusz 20 proc. wydajności, to i tak mamy tysiąc watogodzin na kilogram, czyli około pięciu razy więcej niż dla akumulatora litowo-jonowego. Jeśli chodzi o masę, powietrzne ogniwa powinny być znacznie lżejsze niż akumulatory litowo-jonowe.

Głównym problemem w układzie litowo-powietrznym jest to, że trzeba wystawić ogniwo na działanie powietrza. Prowadzi to do możliwości wprowadzenia do ogniwa innych substancji, takich jak woda, a lit nie lubi wilgoci. Dlatego trzeba mieć możliwość filtrowania powietrza, aby uzyskać dostęp tylko do tlenu, nie bez innych zanieczyszczeń. Testowano już pod tym kątem półprzepuszczalne membrany, ale ostatnio uważa się, że problem wnikania wilgoci lepiej może rozwiązać zastosowanie elektrolitu półprzewodnikowego zamiast ciekłego elektrolitu.

A inne pomysły? Zarówno elektrody dodatnie, jak i ujemne w akumulatorach litowo-siarkowych mają dziesięciokrotnie większą pojemność ładowania niż materiały stosowane w dzisiejszych akumulatorach litowo-jonowych. Siarka jest powszechnie dostępna jako produkt uboczny w przemyśle naftowym i gazowym, dzięki czemu produkcja akumulatorów jest tania. Siarka jest również bardziej przyjazna dla środowiska niż tlenki metali stosowane w akumulatorach litowo-jonowych.

Baterie litowo-siarkowe wciąż jednak nie są trwałe tak jak ich odpowiedniki litowo-jonowe. Cykle działania baterii litowo-siarkowej, procesy jej ładowania i rozładowywania mogą powodować tworzenie się na anodzie litowo-metalowej osadów przypominających igły, które rozkładają elektrolit i mogą spowodować uwięzienie części litu, uniemożliwiając elektrodzie dostarczenie pełnej mocy. Reakcja ta może również spowodować zwarcie akumulatora i potencjalnie doprowadzić do jego zapłonu. Grupa naukowców z Cockrell School of Engineering na Uniwersytecie Teksasu w Austin znalazła sposób - stworzenie sztucznej warstwy zawierającej tellur, wewnątrz baterii na powierzchni litu metalicznego, która może sprawić, że wytrzyma ona cztery razy dłużej.

W lipcu 2020 r. międzynarodowy zespół naukowców z NUST MISIS, Rosyjskiej Akademii Nauk i Helmholtz-Zentrum Drezno-Rossendorf ogłosił, że zamiast litu do produkcji akumulatorów można użyć w specjalny sposób uformowanego sodu. Baterie sodowe miałyby podobną pojemność i byłyby znacznie tańsze niż istniejące baterie litowe.

Wyniki badań opublikowane w czasopiśmie "Nano Energy" opisują dwuwarstwowy układ atomów sodu zwany "bigraphen sandwich" powstały po umieszczeniu warstw atomów metalu pomiędzy warstwami grafenu. Wykazuje on pojemność anody porównywalną do pojemności konwencjonalnej anody grafitowej w bateriach litowo-jonowych - około 335 mAh/g w porównaniu z 372 mAh/g dla litu. Sód jest znacznie bardziej rozpowszechniony niż lit, a zatem tańszy i łatwiejszy do uzyskania.

Bezstratne przewodniki są, ale to kosztuje

Nadprzewodnictwo jest zjawiskiem fizycznym, w którym materiał ma zerowy opór elektryczny. Nadprzewodnik nieposiadający oporności oznacza, że prąd elektryczny może być przepuszczany przez niego bez utraty energii lub nagrzewania go. Może to pozwolić na doskonale efektywne przesyłanie i magazynowanie energii. Gdyby naukowcy byli w stanie odkryć nadprzewodnik działający temperaturze i ciśnieniu typowym dla w pomieszczenia, zrewolucjonizowałoby to technologię. Niestety, okazało się to bardzo trudnym zadaniem i może w ogóle nie być możliwe.

Nadprzewodnik o temperaturze pokojowej przyczyniłby się do zmniejszenia światowych problemów energetycznych poprzez niemal całkowitą eliminację energii elektrycznej traconej podczas transmisji na duże odległości przez linie energetyczne. Pozwoliłoby to również na szybsze komputery i urządzenia pamięciowe wraz z bardziej czułymi czujnikami naukowymi. O wiele tańsze stałoby się uruchamianie potężnych magnesów stosowanych w takich urządzeniach jak akceleratory cząstek, maszyny MRI, prototypowe reaktory syntezy jądrowej i pociągi maglev, ponieważ magnesy nie wymagałyby ciekłego azotu do chłodzenia.

Nadprzewodnictwo to nazwa zjawiska, przez które prądy elektryczne przechodzą przez materiał o zerowej rezystancji. Zostało ono odkryte po raz pierwszy w 1911 roku przez Heike Kamerlingha Onnesa, który zdobył nagrodę Nobla w 1913 roku, i zostało wyjaśnione w 1957 roku przez Johna Bardeena, Leona Coopera i Johna Roberta Schrieffer’a, którzy dzielili nagrodę w 1972 roku. W 1986 r. Johannes Georg Bednorz i K. Alex Müller odkryli klasę materiałów zawierających tlenki miedzi, które mogą zachować nadprzewodnictwo w temperaturach przekraczających to, na co pozwalała teoria z 1957 r. Rok później, w 1987 roku, duet otrzymałby Nagrodę Nobla.

Po odkryciu materiałów miedzianych dwie dekady minęły bez żadnych przełomów w tej dziedzinie. Zmieniło się to w 2008 roku, gdy zespół naukowców z Japonii pod kierownictwem Hideo Hosono odkrył nową klasę materiałów zawierających żelazo, które wykazują nadprzewodnictwo w niekonwencjonalnie wysokich temperaturach. Następnie, w 2014 roku, grupa z Niemiec, pod kierownictwem Mikhaila Eremetsa, odkryła kolejną rodzinę materiałów nadprzewodzących, tym razem zawierających wodór (wodorków).

Niestety, wszystkie znane nadprzewodniki stają się nadprzewodnikami wciąż skrajnie dla nas niskich temperaturach. Nadprzewodnik "wysokotemperaturowy" definiuje się jako materiał, który zachowuje się jak nadprzewodnik powyżej temperatury ciekłego azotu (73K lub –200°C). Dokładna temperatura, w której opór elektryczny materiału spada do zera, nazywana jest "temperaturą krytyczną".

Nadprzewodnikiem działającym w najwyższej temperaturze w normalnych warunkach ciśnieniowych jest Hg12Tl3Ba30Ca30Cu45O127, którego temperatura krytyczna wynosi 138K lub –135°C przy ciśnieniu jednej atmosfery. Kwestia ciśnienia jest bardzo istotna. Siarczek wodoru (H2S) ma temperaturę krytyczną zaledwie 203K (–70°C), a dekawodorek lantanu (LAH10) ma temperaturę krytyczną 250K (–23°C). Niestety, materiały te, aby nadprzewodzić, muszą być pod bardzo wysokim ciśnieniem. H2S potrzebuje 986923 atmosfer ciśnienia, a LaH10 1677770 atmosfer.

Termin "nadprzewodnik temperatury pokojowej" jest używany w odniesieniu do potencjalnych przyszłych materiałów, które wykazują nadprzewodnictwo w temperaturach powyżej 273K lub 0°C. Aby stały się one szczególnie użyteczne w świecie rzeczywistym, materiały te musiałyby być również nadprzewodzące w pobliżu jednej atmosfery ciśnienia.

Niedawno międzynarodowy zespół naukowców odkrył, że atomy wodoru w wodorkach metalu są dużo gęściej upakowane niż uważano do tej pory. Właściwość ta może prowadzić do pojawienia się nadprzewodnictwa w temperaturach i ciśnieniach zbliżonych do panujących w warunkach pokojowych. W należącym do Departamentu Energii Stanów Zjednoczonych Narodowym Laboratorium Oak Ridge (ORNL) naukowcy przeprowadzili eksperymenty rozpraszania neutronów na wodorku cyrkonowo-wanadowym pod ciśnieniem atmosferycznym w zakresie temperatur sięgających od –268 stopni Celsjusza (5 K) do –23 stopni Celsjusza (250 K).

Prof. Zbigniew Łodziana z Instytutu Fizyki Jądrowej Polskiej Akademii Nauk w Krakowie, jeden z członków międzynarodowego zespołu badaczy, zaproponował nowy model tego wodorku. Model ten, poddany obliczeniom na jednym z najpotężniejszych superkomputerów na świecie, pozwolił w prosty sposób wyjaśnić obserwacje eksperymentalne. Okazało się, że odległości pomiędzy atomami wodoru w badanym materiale wynoszą 1,6 angstrema, podczas gdy dotychczas ugruntowane przewidywania dla tych związków wyznaczały tę odległość na poziomie co najmniej 2,1 angstrema.

Inne materiały o podobnym upakowaniu atomów wodoru przechodzą w stan nadprzewodnictwa, ale tylko przy bardzo wysokich ciśnieniach. Tak wysokie ciśnienie potrzebne jest, by zbliżyć do siebie atomy wodoru na odległość mniejszą niż 2 angstremy. Jak wyjaśnia prof. Zbigniew Łodziana z IFJ PAN, jego zespołowi udało się pokazać, że wodór można upakować w taki sposób również pod ciśnieniem atmosferycznym.

Komputer z dziurami, czarnymi dziurami

Sporo w ostatnich wydaniach MT pisaliśmy o rywalizacji w dziedzinie obliczeń kwantowych. Dlatego tę dziedzinie potraktujemy skrótowo, wspominając jedynie o tym co nowego się w ostatnim czasie pojawiło.

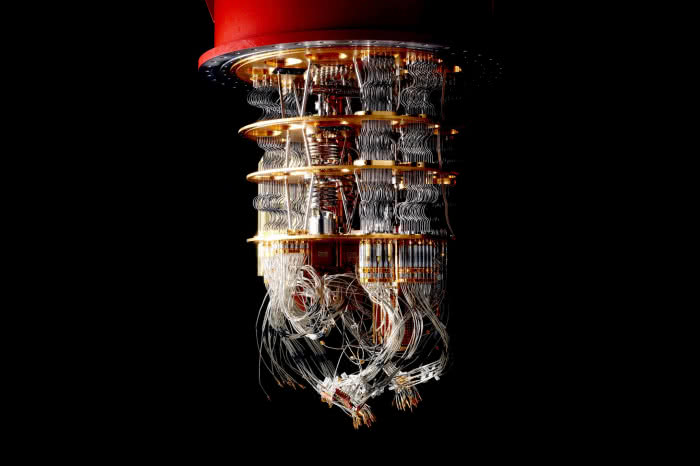

Trwa na świecie wyścig o to kto zbuduje pierwszy na świecie praktycznego komputera kwantowego (4), czyli takiego, który będzie w stanie dostarczyć technologię o długo oczekiwanej zdolności do wspomagania naukowców w takich działaniach, jak opracowywanie cudownych nowych materiałów, szyfrowanie danych z niemal doskonałym bezpieczeństwem i dokładne przewidywanie zmian klimatu na Ziemi. Większość z kamieni milowych publikowanych skwapliwie przez IBM, Microsoft, Google, Intel to pakowanie coraz większej ilości kwantowych bitów, czyli kubitów - podstawowej jednostki informacji w kwantowym komputerze na procesor.

Ze względu na te możliwości, obliczenia kwantowe będą bardzo pomocne w inżynierii chemicznej i modelowaniu molekularnym, kryptografii, analizie wyników badań przestrzeni kosmicznej i danych SETI, ewolucji sztucznej i maszynowej inteligencji, w inżynierii lądowej i planowaniu przestrzennym, rozpoznawaniu twarzy i wzorów w działaniach antyterrorystycznych, modelowaniu fizyki cząstek elementarnych, inżynierii genetycznej, prognozowaniu pogody i przewidywaniu klimatu. Jednym z negatywnych skutków obliczeń kwantowych jest to, że znacznie zwiększa on szybkość, z jaką ktoś może złamać hasło lub inne środki bezpieczeństwa, w porównaniu z brutalnymi próbami siłowymi przy użyciu tradycyjnego komputera.

Pierwszy tranzystor został wprowadzony w 1947 roku. Pierwszy układ scalony pojawił się w 1958 roku. Pierwszy mikroprocesor Intela - który miał tylko około 2,5 tysiąca tranzystorów - pojawił się dopiero w 1971 roku. Każdy z tych kamieni milowych był oddalony od siebie o ponad dekadę. Ludzie myślą, że komputery kwantowe są tuż za rogiem, ale historia pokazuje, że te postępy wymagają czasu. Jeśli za 10 lat będziemy mieli komputer kwantowy, który ma kilka tysięcy kubitów, to z pewnością zmieni świat w taki sam sposób, jak pierwszy mikroprocesor.

Z nękającą tę dziedzinę badań tendencją do rozpadania się kubitów i błędów próbuje się walczyć za pomocą coraz ciekawszych metod. Uczeni z MIT zbudowali sztuczne, oparte na nadprzewodnikach, "gigantyczne atomy". Badania, opublikowane w czasopiśmie "Nature" kilka miesięcy temu, sugerują, że te gigantyczne atomy mogą pomóc w stworzeniu komputerów kwantowych, które są rzeczywiście praktyczne. Sztuczne atomy wstrzymują transfer kubitów, stabilizując je, co zwiększa niezawodność układu.

Także inżynierowie kwantowi z Uniwersytetu Nowej Południowej Walii w Sydney stworzyli sztuczne atomy (5). Co ciekawe, zrobili to w chipach krzemowych, tzw. kropkach kwantowych. W artykule opublikowanym w "Nature Communications". Jako kwanty (lub bity kwantowe) są używane elektrony. Profesor Andrew Dzurak z UNSW wyjaśnia, że w przeciwieństwie do prawdziwego atomu, sztuczny atom nie ma jądra, ale wciąż ma powłoki elektronów wirujących wokół centrum urządzenia, a nie wokół jądra atomu.

- "Pomysł stworzenia sztucznych atomów przy użyciu elektronów nie jest nowy, w rzeczywistości został po raz pierwszy zaproponowany teoretycznie w latach trzydziestych, a następnie zademonstrowany eksperymentalnie w latach dziewięćdziesiątych, choć nie w krzemie. Po raz pierwszy zrobiliśmy jego podstawową wersję w krzemie w 2013 roku", napisał w publikacji profesor Dzurak. "Sztuczne atomy o większej liczbie elektronów okazują się znacznie bardziej wytrzymałe, niż wcześniej sądzono, co oznacza, że mogą być niezawodnie wykorzystywane do obliczeń w komputerach kwantowych. Jest to istotne, ponieważ kubity oparte tylko na jednym elektronie mogą być bardzo niewiarygodne". Wydaje się, że dodatkowe elektrony w powłokach wewnętrznych działają jak "podkład" na niedoskonałej powierzchni kwantowej kropki, wygładzając i nadając stabilność elektronowi w powłoce zewnętrznej.

Osiągnięcie stabilności i kontroli elektronów jest kluczowym krokiem w kierunku urzeczywistnienia się komputerów kwantowych opartych na krzemie. Do kodowania wartości kubitu używany jest spin elektronu. "Nasza nowa praca pokazuje, że możemy kontrolować spin elektronów w zewnętrznych powłokach tych sztucznych atomów, aby uzyskać niezawodne i stabilne kubity", wyjaśnia prof. Dzurak.

W lecie 2020 r. badacze z Uniwersytetu Maryland, Christopher Monroe i Brian Swingle, poinformowali serwis "Quanta", że możliwe jest zbudowanie obwodów kwantowych, które zachowywałyby się tak, jak splątane czarne dziury. Gdyby układ zadziałał, byłby w stanie wprowadzić kwantową informację do jednego obwodu "czarnej dziury", który by ją zakodował. Po jakimś czasie informacja ta wyskakiwałaby z drugiego obwodu już nie zakodowana i odszyfrowana. To odróżnia ją od istniejących technik teleportacji kwantowej, ponieważ przesyłane informacje są tam od początku w pełni zakodowane, a następnie muszą być odszyfrowane, co sprawia, że proces trwa dłużej i jest mniej dokładny, ponieważ podatny na błędy komputer kwantowy próbuje odtworzyć oryginalny komunikat. Komentując propozycję wykorzystania miniaturowych czarnych dziur, badacze uznali, że gdyby to było wykonalne, oznaczałoby nową erę kwantowej teleinformatyki.

Jeśli dotarliśmy do syntezy komputera kwantowego z czarnymi dziurami, to wyraźny sygnał, by kończyć rozważania. Nie dlatego, że to nie ma sensu. Być może ma doskonały sens. Niestety jednak trudno się oprzeć wrażeniu, że dziedzina, w której sięga się po tak egzotyczne pomysły, wciąż jest daleka od realiów technicznej wykonalności.

Mirosław Usidus