Konwersacyjna rewolucja techniczna

W Stanach Zjednoczonych prawie 70 milionów dorosłych korzysta z inteligentnych głośników (2) - to prawie jedna czwarta społeczeństwa, która z większym lub mniejszym zaangażowaniem rozmawia z maszynami. Liczba platform konwersacyjnych (które są dostępne nie tylko w głośnikach domowych, takich jak Echo Amazona) stale rośnie.

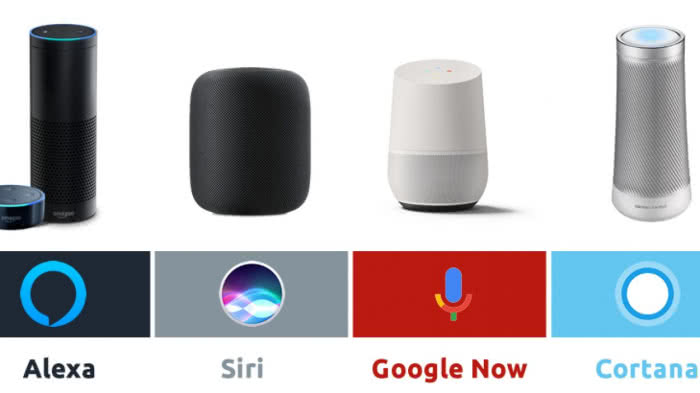

Znamy dobrze platformy:

- Google Assistant,

- Alexa Amazona,

- Facebook Messenger,

- Apple iMessage,

- Slack, Twilio,

- Samsung Bixby.

Systemy komunikacji głosowej napędzane przez sztuczną inteligencję od kilku lat wkraczają w wiele sfer naszego życia, od urządzeń domowych, przez samochód, infrastrukturę podróżną i transportową, obszary publiczne, aż po miejsca pracy, zarówno w biurach, jak i halach fabrycznych.

Bilet u czatbota

Według najnowszych badań, globalna wartość rynku inteligentnych wirtualnych asystentów ma przekroczyć dwa biliony USD do 2025 roku, z porównaniu z nieco ponad bilionem USD w 2019 roku. Serwis eMarketer uważa, że do 2021 roku 123 miliony osób będzie opierać się w swojej prywatnej i służbowej aktywności przede wszystkim na asystentach głosowych. W raporcie Gartnera z lutego 2020 r. stwierdza się, że do 2021 roku 70 proc. firm będzie wykorzystywać czaty i czatboty w swoim biznesie.

Dzięki automatyzacji zadań i wyeliminowaniu pracowników ludzkich z niepotrzebnych interakcji, firmy mają nadzieję na zwiększenie swojej efektywności i szybkości działania. Interfejsy konwersacyjne zapewniają firmom łatwy i efektywny kosztowo sposób na otrzymywanie informacji zwrotnych od klientów, poprawę ich relacji z klientami i zwiększenie ich lojalności. Według Accenture, sama bankowość konwersacyjna może przyspieszyć wzrost przychodów o 25 proc. i obniżyć koszty nawet o 30 proc.

Inteligentne formy biznesu pozwalają konsumentom na korzystanie z usług poprzez interakcje w naturalnym języku. Korzystając z własnego głosu lub SMS-ów za pomocą dowolnego urządzenia, takiego jak tablet, smartfon, smartwatch, a nawet inteligentny telewizor, klienci mogą oczekiwać informacji, kupować nowe produkty i przeprowadzać transakcje. Inteligentna np. bankowość konwersacyjna może być łatwo zintegrowana z kanałami komunikacyjnymi, z których klienci korzystają najczęściej, takimi jak Facebook i Instagram, lub wirtualnymi asystentami, takimi jak Amazon Alexa czy Google Assistant (zobacz także: Inteligentna droga. Prowadzi do celu i wszystko rozumie).

Najczęstsze obecnie przypadki wykorzystania czatbotów to obsługa klienta, wsparcie IT, sprzedaży, komunikacja marketingowa i handlowa. Ważne jest, jeśli firmy poważnie myślą o wprowadzaniu tego rodzaju rozwiązań na dużą skalę, utwierdzenie klientów i partnerów w przekonaniu, że platforma konwersacyjna zapewnia pełne bezpieczeństwo danych osobowych, finansowych i wszelkich innych wrażliwych obszarów.

Interfejs konwersacyjny to metoda komunikacji z maszyną, w ramach której można z urządzeniem, a właściwie całym systemem rozmawiać lub prowadzić tekstową komunikację w prostym języku. Jego celem jest zapewnienie komunikacji w taki sposób, jakbyśmy rozmawiali z przyjacielem lub znajomym albo co najmniej w człowiekiem pracującym w okienku obsługi.

Firmy stosują technologie konwersacyjne, których znanym przykładem jest czatbot BlueBot linii lotniczych KLM (3), w celu poprawy doświadczeń zarówno pracowników, jak i klientów. Platformy konwersacyjne są jednym z najczęstszych zastosowań dla aplikacji AI. Czatboty zapewniają szybszą, dostępną 24 godziny na dobę i 7 dni w tygodniu obsługę klientów i pracowników. Firmy dążą do poprawy doświadczenia klientów obsługiwanych drogą online, ale również do zmniejszenia kosztów.

Boty podstawowe, asystenci i asystenci głosowi

Programy konwersacyjnej sztucznej inteligencji mogą komunikować się jak człowiek, rozumiejąc cel, do którego zmierza konwersacja, posługując się tekstem albo imitując ludzką mowę. Ostateczny cel techniki konwersacyjnego interfejsu to, jak wspominaliśmy, sytuacja, w której jest ona nie do odróżnienia od rozmowy z człowiekiem. Jednak projektowanie interakcji, które brzmią naturalnie, jest znacznym wyzwaniem dla mówiącej lub choćby tylko piszącej do nas sztucznej inteligencji.

Interfejsy konwersacyjne można podzielić na trzy szerokie kategorie: boty podstawowe (basic-bots), asystenci tekstowi oraz asystenci głosowi. Funkcje podstawowych botów są stosunkowo ograniczone. Konstrukcja interfejsu pozwala na wykonywanie podstawowych poleceń. Jakość działania czatbotów tekstowych zależy od jakości danych wejściowych. Zależnie od jakości baz danych asystenci tekstowi spisują się albo całkiem nieźle, albo umiarkowanie. Asystenci głosowi, tacy jak Asystent Google i Alexa Amazona, zapewniają większą automatyzację i zmniejszają czas poświęcany na pisanie, obniżając bariery w korzystaniu z urządzeń. Jednak sporą barierą dla ich niezawodności są wciąż nie zawsze doskonałe techniki rozpoznawania ludzkiej mowy.

Zbudowanie czatbota jest właściwie łatwe. Trudniej uczynić go użytecznym. Kłopoty nastręcza przede wszystkim integracja różnych źródeł danych. W biznesie źródłami danych może być np. oprogramowanie obsługujące klienta (CRM) lub platformy e-commerce. Niedoskonałości rozwoju interfejsu konwersacyjnego wymagają nadzoru człowieka, jeśli celem jest opracowanie w pełni i niezawodnie funkcjonującego systemu. Dążeniem rozwijających te techniki powinno być maksymalne uproszczenie czatbota. Wymaga to stworzenia jak najprostszego interfejsu komunikacyjnego. Język, którym posługuje się bot, kształtuje dane wejściowe dostarczane przez użytkownika. Tak więc kształtowanie zachowania użytkownika, poprzez dostarczanie właściwych wskazówek, sprawiłoby, że rozmowa przebiegałaby płynnie.

Dzięki uczeniu maszynowemu platformy konwersacyjne (4) mogą obsługiwać stopniowo coraz szerszy zakres zapytań. Dodatkowo, systemy konwersacyjne AI mogą brać pod uwagę kontekst (tzn. pozostałą część rozmowy), określając z rosnącą trafnością intencje użytkowników i poprawne odpowiedzi. Istotnym krokiem w budowie takiego mechanizmu jest nauka na błędach. Chodzi zwłaszcza o gromadzenie właściwych danych i doskonalenie interfejsu. Dlatego projektanci muszą zapewnić odpowiednie narzędzia i mechanizmy informacji zwrotnej do korygowania błędów i pojawiających się problemów.

W budowie inteligentnych czatbotów wykorzystuje się przetwarzanie języka naturalnego (natural language processing, NLP). To dział sztucznej inteligencji, który pozwala na analityczny rozkład, zrozumienie, przetworzenie i określenie wymaganego we wprowadzonych słowach działania. NLP służy m.in. do sterowania dialogiem i przewidywania zadań.

Podkategorią NLP jest rozumienie języka naturalnego (natural language understanding, NLU). Technika ta służy do analizy struktury zdań w tekście i formatach mowy. NLU umożliwia komputerowi interpretację znaczenia w intencji z uwzględnieniem powszechnym ludzkich błędów, takich jak błędna wymowa lub transponowane litery. Silniki NLU są zasilane dużymi zbiorami danych i wymagają nieustanne weryfikacji. Giganci technologiczni, tacy jak Google, ulepszają te silniki poprzez wykorzystanie swoich ogromnych zasobów danych.

Kolejną techniką stosowaną w rozwoju czatbotów jest generowanie języka naturalnego (natural language generation, NLG). To również podkategoria NLP. Umożliwia generowanie odpowiedzi udzielanych tekstowo lub głosowo użytkownikowi. Aby mowa maszynowa była przekonująca i płynna, muszą być tworzone odpowiedzi, które użytkownicy uznają za brzmiące naturalnie, jak zwykłe ludzkie odpowiedzi.

Łatwo powiedzieć - trudniej zrozumieć

Ekspansja interfejsu głosowego, konwersacyjnego (VUI) jako sposobu do interakcji z urządzeniami cyfrowymi uznawana jest za rewolucję technologiczną naszych czasów. Po raz pierwszy od czasu wynalezienia komputerów, maszyny na poważnie i na dużą skalę uczą się naturalnego języka człowieka. Oznacza to, że jeśli celem projektanta VUI jest stworzenie efektywnej interakcji werbalnej człowiek-maszyna, interfejs musi odzwierciedlać wzorce myślowe i praktyki społeczno-kulturowe zawarte w modelach interakcji ludzi w codziennych rozmowach.

Przez osadzenie modelu interakcji w naturalnym interaktywnym schemacie ludzkiej rozmowy projektanci VUI w naturalny sposób wprowadzają do rozmowy elementy językowe niewymagane przez czysto pragmatyczne potrzeby komunikacyjne i logikę, np. różnego rodzaju zwroty grzecznościowe, emocjonalne lub wyrażające stosunek do wypowiedzianych słów formy językowe. Innymi słowy, projektanci VUI starają się wprowadzić do konwersacji z maszynami ten sam ładunek uczuć i emocji, które znamy z dialogów międzyludzkich.

Obecnie maszyny wciąż radzą sobie z różnymi niuansami językowymi zarówno w żywym języku pisanym, jak mówionym, w sposób daleki od ideału. Kto posługuje się tłumaczem Google, z pewnością wie, o czym mowa. Problemem, jaki napotykają systemy Automatic Speech Recognition (ASR), jest wydobycie z sygnału mowy użytecznych danych i skojarzenie ich z konkretnym słowem, które dla człowieka ma określone znaczenie. Wypowiadane dźwięki za każdym razem są inne. Zmienność sygnału mowy jest naturalną jego cechą, dzięki której na przykład rozpoznajemy akcent czy intonację. Każdy z elementów systemu rozpoznawania mowy ma określone zadanie. Na podstawie przetworzonego sygnału i jego parametrów powstaje model akustyczny, który będzie skojarzony z modelem języka.

System rozpoznawania mowy może działać w oparciu o małą bądź dużą liczbę wzorców, co determinuje wielkość słownika, z jakim system współpracuje. Mogą to być małe słowniki w przypadku systemów rozpoznających izolowane słowa bądź komendy, jak również duże bazy danych zawierające odpowiednik zbioru językowego oraz uwzględniające model językowy (gramatykę).

Wyzwania, z którymi zmagają się interfejsy głosowe, to przede wszystkim poprawne zrozumienie mowy, w której np. często opuszczane są całe sekwencje gramatyczne, pojawiają się błędy językowe i fonetyczne, pomyłki, lapsusy, wady wymowy, homonimy, powtarzanie itd. Przy tym wszystkim systemy ASR muszą działać szybko i niezawodnie. Przynajmniej takie są oczekiwania.

W systemach rozpoznawania mowy źródłem trudności są też sygnały akustyczne inne niż rozpoznawana mowa, dostające się na wejście systemu rozpoznającego, czyli wszelkiego rodzaju zakłócenia i szum. W najprostszym przypadku są to zakłócenia i szumy, które trzeba odfiltrować. Właściwie zadanie to wydaje się rutynowe i łatwe (w końcu filtrowane są przeróżne sygnały i każdy elektronik wie, jak to się robi), ale trzeba to zrobić naprawdę dokładnie i starannie, jeśli wynik rozpoznawania mowy ma być zgodny z naszymi oczekiwaniami.

Stosowane współcześnie filtracje pozwalają usunąć zewnętrzne szumy pochwycone przez mikrofon wraz z sygnałem mowy oraz wewnętrzne właściwości samego sygnału mowy, utrudniające jego rozpoznanie. Znacznie trudniejszy problem techniczny pojawia się w sytuacji, gdy zakłóceniem dla analizowanego właśnie sygnału mowy jest… inny sygnał mowy. Zagadnienie takie znane jest w literaturze jako tzw. cocktail party problem. Wymaga ono stosowania skomplikowanych metod tzw. dekonwolucji (odplątania) sygnału, co jest dość złożonym zagadnieniem.

Na filtracji sygnału kłopoty z rozpoznawaniem sygnału mowy bynajmniej się nie kończą. Omówimy teraz kilka zagadnień związanych z bogatą zawartością sygnału mowy. Warto sobie uświadomić, że sygnał mowy niesie bardzo wiele różnego rodzaju informacji. W głosie osoby mówiącej zawarta jest bowiem informacja o płci, wieku, a także innych cechach osobniczych mówcy. W sygnale mowy zawarte są też wiadomości o stanie zdrowia osoby mówiącej. Istnieje dziś obszerny dział inżynierii biomedycznej, który zajmuje się diagnostyką różnych chorób na podstawie charakterystycznych zjawisk akustycznych wykrywanych w sygnale mowy.

Gdy chodzi o system, to w taki sam sposób odbiera i interpretuje docierające do niego polecenia i inne wypowiedzi niezależnie od tego, kto wydał polecenie i jakie są indywidualne cechy głosu osoby mówiącej. Są jednak zastosowania, w których głównym celem analizy akustycznej sygnału mowy jest identyfikacja mówcy albo weryfikacja, czy jest on tym, za kogo się podaje (głos zamiast klucza, hasła albo PIK-kodu), co także może mieć zastosowanie w technice inteligentnych budynków.

Pierwszym elementem tego systemu jest mikrofon. Sygnał mowy w takiej postaci, w jakiej rejestruje go mikrofon, jest jednak generalnie mało przydatny z punktu widzenia rozważanych tu systemów. Badania wykazują, że kształt i przebieg fali dźwiękowej rozpatrywanej w dziedzinie czasu bardzo silnie zmienia się w zależności od osoby mówcy, od tempa mowy, częściowo także w zależności od nastroju osoby mówiącej - natomiast w niewielkim stopniu odwzorowuje treść wypowiadanych poleceń.

Sygnał ten trzeba więc odpowiednio przetworzyć. Współczesna akustyka, fonetyka i informatyka stwarzają łącznie bogaty zestaw narzędzi, które mogą być zastosowane do przetwarzania, analizy, rozpoznawania i rozumienia sygnału mowy. Wygodną podstawą do automatycznego rozpoznawania mowy są widma dynamiczne sygnału, tak zwane spektrogramy dynamiczne. Ich miłą cechą jest to, że można je stosunkowo łatwo uzyskać, a ponadto mowa reprezentowana w postaci spektrogramu dynamicznego może być stosunkowo łatwo rozpoznawana przy użyciu technik podobnych do tych, jakie są stosowane przy rozpoznawaniu obrazów.

Proste elementy mowy (na przykład komendy) mogą być rozpoznawane na podstawie prostego podobieństwa całych spektrogramów. Na przykład słownik sterowanego głosem telefonu komórkowego zawiera zaledwie od kilkudziesięciu do kilkuset słów i zwrotów, z reguły z góry narzuconych tak, żeby można je było łatwo i skutecznie rozpoznawać. Wystarcza to w prostych zadaniach sterowania, ale bardzo ogranicza ogólność zastosowań takiego systemu. Systemy budowane według schematu z reguły obsługują tylko konkretnych mówców, do których głosów są one specjalnie trenowane. Jeśli pojawi się ktoś nowy, kto będzie chciał użyć swojego głosu do sterowania systemem, to z dużym prawdopodobieństwem taka próba się nie powiedzie.

Wynik tej operacji określany jest jako spektrogram 2-W, czyli widmo dwuwymiarowe. Natomiast w bloku tym wpisana jest jeszcze jedna czynność, na którą warto zwrócić uwagę - segmentacja. Najogólniej mówiąc, chodzi tu o podzielenie ciągłego sygnału mowy na kawałki, które będą podlegały oddzielnemu rozpoznawaniu, a potem z tych oddzielnych rozpoznań montuje się rozpoznanie całości. Takie postępowanie jest konieczne, bo całej długiej i złożonej wypowiedzi jednorazowo rozpoznać się nie da. Na temat tego, jakie segmenty należy wyróżniać w sygnale mowy podczas jego rozpoznawania, napisano już całe tomy, więc nie będziemy przesądzać, czy wydzielonymi segmentami mają być fonemy (odpowiedniki głosek), sylaby czy może podfonemy.

Proces automatycznego rozpoznawania odwołuje się zawsze do jakichś cech rozpoznawanych obiektów. Dla sygnału mowy badano setki zestawów różnych cech i parametrów. Mając sygnał mowy podzielony na rozpoznawane ramki oraz mając wybrane cechy, za pomocą których ramki te są przedstawiane w procesie rozpoznawania, możemy przeprowadzić (dla każdej ramki osobno) klasyfikację, czyli przypisanie do tej ramki identyfikatora, który ją będzie dalej reprezentował.

Sygnał mowy przekształcony do postaci sekwencji identyfikatorów ramek. Kolejną fazą jest montowanie ramek w pojedyncze słowa - najczęściej w oparciu o model niejawnych modeli Markowa HMM (hidden Markov model), na których wyjaśnianie nie ma tutaj miejsca. Następnie zachodzi montowanie ze słów kompletnych zdań.

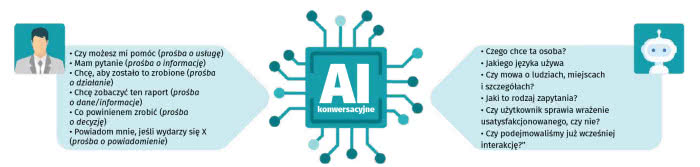

Na przykładzie systemu Alexa proces maszynowego "zrozumienia" człowieka, a dokładniej wydawanego przez niego polecenia czy zadawane - go pytania przebiega wieloetapowo.

Zrozumienie słów, a zrozumienie znaczenia i pojęcie intencji użytkownika to zupełnie różne sprawy. Dlatego kolejny etap do działanie modułu NLP (Natural Language Processing), którego zadaniem jest rozpoznanie intencji użytkownika, czyli znaczenia wydanego polecenia/pytania w kontekście, w jakim ono zostało wypowiedziane. Jeżeli intencja zostaje rozpoznana, następnym etapem jest przypisanie "umiejętności", czyli konkretnej funkcji obsługiwanej przez inteligentnego asystenta. W przypadku pytania o pogodę następuje wywołanie źródła danych na temat pogody. Gdy dane zostają otrzymane, pozostaje je przetworzyć na mowę (mechanizm TTS - text-to-speech) i użytkownik słyszy odpowiedź na zadane pytanie.

Haki internetowe

Firmy rozwijające konwersacyjną AI zdały sobie sprawę, że praca nad rozwojem poziomu dialogu człowiek-maszyna może być wykonana tylko przez profesjonalistów z dobrą znajomością języka naturalnego. Dokładniej mówiąc, poszukują projektantów CUX (conversational UX), którzy potrafią kreować naturalne wymiany zdań.

Inteligentny konwersacyjny bot nie powinien brzmieć jak robot. Zamiast wypowiadać te same zdania w każdym przypadku, bot mógłby być skonfigurowany tak, aby wybierał je losowo z szerszej listy. Odpowiedź, którą musi wygenerować bot, zależy nie tylko od poprzedniej wiadomości użytkownika, ale także od kontekstu. Kontekst obejmuje wiele rzeczy, takich jak wcześniejsze rozmowy czatbota z użytkownikiem, modalność platformy (głosowa vs. tekstowa), wiedzę lub doświadczenie użytkownika w odniesieniu do produktu lub usługi oraz etap całego procesu współpracy, na którym znajduje się użytkownik.

Po zdefiniowaniu interakcji, kolejnym krokiem jest zbudowanie przepływu komunikacji z wykorzystaniem abstrakcji, takich jak intencje, zmienne, "webhooki" do wywoływania API, drzewa decyzyjne do rozwiązywania problemów oraz baza wiedzy do odpowiadania na pytania.

Intencje są podstawowym tworzywem każdego interfejsu konwersacyjnego, który wychwytuje znaczenie wiadomości wprowadzanych przez użytkownika. Intencje mogą składać się ze słów kluczowych, zmiennych i tzw. haków internetowych (webhooks, elementów, które wykorzystują zewnętrzne interfejsy API serwisów internetowych lub aplikacji, aby znaleźć odpowiedź w zewnętrznych bazach danych) prowadzących do wykonania akcji przez system.

Słowa kluczowe to różne frazy, które użytkownik może wypowiedzieć, a system zrozumieć, że odnoszą się do intencji. Różne słowa kluczowe intencji wraz z rzeczywistymi komunikatami użytkownika (etykietowane) dla danych szkoleniowych do klasyfikacji intencji. W przypadku obsługi klienta, możemy zdefiniować intencje do śledzenia zamówienia i/lub porozmawiać z agentem obsługi klienta.

Zmienne służą do definiowania wejść, które musimy uzyskać od użytkownika, aby wykonać ten zamiar. Na przykład, aby śledzić zamówienie, system musi uzyskać numer identyfikacyjny zamówienia od użytkownika. Po zidentyfikowaniu zamiaru i otrzymaniu wymaganych zmiennych, musimy wykonać akcję. W tym przypadku możemy wykonać webhook, aby wywołać połączenie API w celu uzyskania statusu zamówienia, poznania pojawiających się problemów itd.

Wiele przypadków użycia wymaga podejmowania pewnych decyzji i reagowania na sposób, w jaki użytkownicy przekazują swoje informacje. Drzewa decyzyjne to świetny sposób na rozwiązanie tego typu problemów. Posiadanie sposobu na zdefiniowanie drzewa decyzyjnego i przepływu kontroli jest ważnym elementem składowym do zdefiniowania przepływu wymiany komunikacyjnej.

W końcu jest też baza wiedzy jako sposób na wprowadzanie często zadawanych pytań (FAQ) i znalezienie właściwej odpowiedzi na pytanie użytkownika.

Życzy pan sobie tłumaczenie, taksówkę czy śniadanie do łóżka?

Rozwojowi czatbotów towarzyszy wzrost wykorzystania technik wyszukiwania głosowego, które stopniowo, nie rewolucyjne, ale z nieubłaganą konsekwencją wypierają tradycyjne metody wyszukiwania informacji. Już w tym roku, według prognoz, ma stanowić 50 proc. wyszukiwań sieciowych. "Forbes" przewidywał kilka miesięcy temu, że do końca 2020 r. około 30 proc. stron internetowych na świecie będzie znajdowanych za pomocą wyszukiwania głosowego.

Konsumenci przyzwyczajają się do korzystania z asystenta głosowego w swoich smartfonach. Dzieci, które w krajach rozwiniętych dorastają przy Alexa i Google Assistant w domu, raczej na pewno będą kontynuować konwersacje z asystentem głosowym, gdy staną się właścicielami smartfonów. Według danych podawanych przez Google, 41 proc. dorosłych i 55 proc. nastolatków używa wyszukiwarki głosowej codziennie do takich zadań jak nawiązywanie kontaktów, wyszukiwanie filmów i odkrywanie miejsc, w których można coś zjeść.

Użytkownicy wykorzystują również polecenia głosowe do odtwarzania muzyki, wyszukiwania informacji i znajdowania wskazówek, co sprawia, że jest to doskonałe narzędzie dla podróżnych. Już w 2018 roku odsetek podróżnych, którzy używali funkcji wyłącznie głosowych w swoich smartfonach sięgnął 50 proc. Ok. 70 proc. użytkowników z takich krajów jak Chiny, Indie i Turcja korzysta z wyszukiwania głosowego w podróży. W niektórych przypadkach, np. w Chinach, ze względu na poziom komplikacji pisma, mowa może być znacznie szybszym i prostszym sposobem wydobycia informacji z urządzeń, pod warunkiem oczywiście, że interfejs jest niezawodny.

Ważnym udoskonaleniem z tego punktu widzenia jest możliwość używania mobilnych urządzeń do tłumaczenia na bieżąco (5). Od niedawna wystarczy poprosić np. Asystenta Google o pomoc w przeprowadzeniu rozmowy w danym języku. Na przykład - "Hej Google, bądź moim hiszpańskim tłumaczem", aby uruchomić tryb tłumacza ustnego i uzyskać możliwość mówienia w obcojęzyczną osobą na bieżąco (lub za pomocą inteligentnych skanerów, tłumaczenia napisów). Tryb tłumacza ustnego jest już zainstalowany w telefonie, nie ma potrzeby pobierania aplikacji.

Google poszedł jeszcze dalej i połączył swoje usługi Maps i Translate. Dzięki tej nowej funkcji aplikacja Mapy Google będzie automatycznie tłumaczyć i odczytywać na głos nazwę miejsca i jego adres w lokalnym języku. Wprowadzono także rozszerzenie wskazówek dla pieszych, przeznaczone specjalnie dla osób niedowidzących. Wskazówki te pomagają ludziom, którzy nie widzą, w nawigacji z miejsca do miejsca, ostrzegając ich o potencjalnie ruchliwych miejscach. Tak więc Google może wejść na całkiem nowe terytorium, ułatwiając przemieszczanie się osobom niepełnosprawnym.

Nie tylko Google stara się pozyskać podróżujących do korzystania z jego usług. Inteligentny asystent Alexa Amazona oferuje również szereg umiejętności głosowych, które ułatwiają podróżowanie, np. firma Virgin Holidays uruchomiła na tej platformie nową umiejętność (ang. "skill"), która może przekształcić asystenta głosowego Amazona w osobiste biuro podróży. Pozwala użytkownikowi wybrać najlepszą opcję podróży z ponad 3 milionów terminów, lotnisk i miejsc docelowych, a następnie znaleźć link do rezerwacji w aplikacji Alexa. Wszystko to za pomocą konwersacji w telefonie.

Podobne usługi oferują za pomocą Alexa również inni potentaci w branży podróżniczej. Expedia może tą drogą dostarczyć szczegółowych informacji na temat zbliżających się podróży, sprawdzić status lotu, zarezerwować wynajęty samochód, przypomnieć, co pakować i sprawdzić swoje punkty lojalnościowe. W innej usłudze, oferowanej przez popularny serwis Kayak, użytkownik może zapytać: "Alexa, zapytaj Kayak, gdzie mogę polecieć za 500 dolarów" lub "Alexa, poproś Kayak o rezerwację hotelu w Berlinie". Gdy użytkownicy podadzą szczegółowe informacje, takie jak daty podróży, umiejętność będzie generować opcje i zakresy cenowe.

Dla chcących oszczędzić sobie czekania na lotniskach jest umiejętność Airport Security Line Wait Times, która pozwala uzyskać informacje na temat możliwych czasów oczekiwania w punktach kontroli na ponad 450 lotniskach w całych Stanach Zjednoczonych. Można też poprosić asystenta głosowego Amazona o tłumaczenie krótkich zdań z angielskiego na 36 języków. Alexa odczyta tłumaczenie, dzięki czemu użytkownicy będą mogli dowiedzieć się, jak je wymawiać. Można oczywiście też to zakomunikować osobie obcojęzycznej.

W roku 2016 hotel Wynn Las Vegas ogłosił, że w każdym pokoju hotelowym Las Vegas ma zostać zainstalowane urządzenie Amazon Echo. W październiku 2017 roku Marriott ogłosił plany wyposażenia 100 tysięcy pokoi hotelowych w Chinach w inteligentny głośnik Tmall Genie firmy Alibaba. Sieć jest też partnerem usługi Alexa for Hospitality (6). Dzięki temu goście hotelowi mogą sterować za pomocą asystenta oświetleniem pokoju, odtwarzaniem treści audio, poznać prognozy pogody, zamawiać usługi do pokojów, dzwonić do recepcji, a nawet wymeldować się głosowo.

Giganci i ich platformy

Z niedawnego badania Gartnera wynika, że rynek AI, czatbotów i wirtualnych asystentów to ok. półtora tysiąca dostawców na całym świecie. Wykorzystują oni oczywiście swoje własne rozwiązania, ale częściej jednak sięgają po platformy oferowane przez największych graczy, takie, jak Dialogflow Google, asystenta IBM Watson, SAP Conversational AI, TARS, asystenta Oracle Digital, Verloop, Amazon Lex, Kore. ai, SentiOne, Chatfuel.

Jedną z najstarszych firm w tej branży jest Nuance, założona już w 1992 roku. Zajmowała się uwierzytelnianiem głosowym i oprogramowaniem call center. Opracowany przez nią w ostatnich ltach czatbot Nina szczyci się klientami z listy Fortune 500, takimi jak Coca-Cola i ING.

Innym historycznym przykładem jest założona w 2002 roku firma Next IT będąca najstarszym dostawcą rozwiązań ściśle czatbotowych. Bardziej znana, choć znacznie młodsza, jest firma Kore.ai, która przygotowuje boty dla firm na zamówienie. Inne znane na światowym rynku produkty to InbentaBot, zdolny do obsługi ponad 25 języków, Personetics, który według zapewnień twórców, na rynku finansowym potrafi odpowiedzieć na 95 proc. zapytań klientów, Nano Rep, który twierdzi, że dzięki swojemu czatbotowi redukuje obciążenie agentów nawet o 70 proc., MindMeld przejęty przez Cisco w marcu 2017 r. oraz Claire.AI, który specjalizuje się w usługach finansowych w Azji Południowo-Wschodniej, obsługując m.in. języki - indonezyjski, chiński (uproszczony i kantoński), japoński, koreański, malajski, tagalski, tajski i wietnamski.

Giganci technologiczni, tacy jak Google, IBM, Microsoft, Amazon i Facebook, inwestują w konwersacyjne platformy AI, aby umożliwić programistom łatwe budowanie czatbotów. Do najpopularniejszych należy należąca do Google aplikacja Dialogflow (7). To ona w tej chwili stanowi punkt odniesienia do porównań dla konkurencji.

Dialogflow, dawniej api.ai, jest platformą służącą do rozwoju czatbotów zakupioną przez Google w 2016 roku. Zmieniono jej nazwę na Dialogflow. Wikipedia opisuje Dialogflow jako "kreatora technik interakcji człowiek-komputer opartych na konwersacjach w naturalnym języku".

Dialogflow jest platformą, która może być wykorzystana do projektowania interakcji konwersacyjnyjnego AI w czatbotach, głosowych i wirtualnych asystentach, które są zintegrowane z różnymi platformami komunikacyjnymi, przede wszystkim w Asystencie Google, ale również w innych aplikacjach, w tym w Messengerze Facebooka, Slacku, Twitterze, Kiku, Line, Skype, Telegramie, Twilio czy Viberze.

Jak działa Google Dialogflow? Użytkownik wysyła dane wejściowe do aplikacji za pośrednictwem urządzenia. Wejście to może być tekstem lub wiadomością głosową. Wiadomość ta jest wysyłana do systemu Dialogflow. Przychodząca wiadomość jest kategoryzowana przez Dialogflow i dopasowywana do intencji zdefiniowanych przez dewelopera czatbota. Programista czatbota może używać fraz szkoleniowych w celu przeszkolenia systemu w zakresie identyfikacji intencji. Na wspominanej wyżej zasadzie webhooka wysyłane są zapytania, jakie działania w serwisie bądź aplikacji należy podjąć dla danego zapytania. Odpowiedzi bota mogą być napisane bezpośrednio przez dewelopera lub mogą być wybrane przez Dialogflow. System dialogowy może być zasilany z zewnątrz i rozwijany przez webhooki i zewnętrzne API. Odpowiedź jest porządkowana i formatowana zgodnie z wymaganiami aplikacji konwersacyjnej.

Inne podobne do Dialogflow platformy rozwojowe czatbotów AI to m.in. Amazon Lex, Asystent IBM Watson, Wit.ai Facebooka (8) oraz usługa Microsoft Azure Bot. Jako atut Dialogflow wymienia się możliwości szerokiej integracji z różnymi platformami. Jednak, o czym warto pamiętać, także inne platformy czatbotowe współpracują z wieloma platformami. Na przykład, IBM Watson zapewnia integrację z popularnym narzędziem tworzenia stron internetowych, WordPressem.

Facebookowy Wit.ai nie zapewnia bezpośredniej integracji z aplikacjami, jednak dostępne są na tej platformie biblioteki dla różnych języków programowania, takich jak Python, węzeł JavaScript. Dlatego też programiści mogą dość wygodnie korzystać z Wit.ai podczas tworzenia swoich konwersacyjnych aplikacji AI. Ponadto facebookowe narzędzie jest całkowicie darmowe, zaś inne platformy są darmowe jedynie w ograniczonych zakresie. Warto też pamiętać, że Wit.ai oferuje aż pięćdziesiąt wariantów językowych. Dialogflow obsługuje ponad dwadzieścia języków. IBM Watson obsługuje ponad dziesięć języków w swojej wersji beta. Amazon Lex obsługuje tylko język angielski.

Każdy, kto miał do czynienia z konwersacyjnymi interfejsami, czatbotami i asystentami głosowymi, zgodzi się chyba z twierdzeniem, że obecny poziom rozwoju tej techniki można porównać do wyszukiwarek internetowych z czasów, zanim pojawiła się wyszukiwarka Google. Starsi internauci pamiętają, jak mało satysfakcjonujące było wówczas wyszukiwanie czegokolwiek w internecie. Zatem wiemy, czego chcemy, jeśli chodzi o rozmowy z maszynami, wiemy, jakie są z tym w tej chwili problemy (9) i czekamy na rozwiązanie, które je rozwiąże, tak jak przed laty zrobił to z przeszukiwaniem internetu algorytm Google.

Mirosław Usidus