Widmo maszynowego zabójcy nie znika. W co wierzy Prezydent Putin

Wielu zwolenników stosowania robotów-zabójców zdecydowanie uważa, że dzięki nim wojny staną się mniej krwawe, bo ginąć będzie mniej żołnierzy. Zwracają uwagę, że roboty, choć nie odczuwają litości, są odporne na negatywne ludzkie emocje, takie jak panika, gniew i żądza zemsty, które nierzadko prowadzą do zbrodni wojennych.

Obrońcy robotów używają też argumentu, że postęp techniki wojskowej doprowadził w ostatnim półwieczu do ogromnego zmniejszenia strat cywilnych, a robotyzacja armii pozwala wprowadzić mechanizm ściślejszego przestrzegania praw wojny. Twierdzą, że maszyny staną się etyczne, gdy zostaną wyposażone w oprogramowanie zmuszające je do przestrzegania praw wojny.

Oczywiście ogromna liczba ludzi, w tym bardzo znanych, nie podziela tej opinii i to od lat. W kwietniu 2013 r. wystartowała międzynarodowa kampania pod hasłem Stop Killer Robots (2). W jej ramach organizacje pozarządowe domagają się pełnego zakazu używania broni autonomicznej. Specjaliści z wielu krajów zasiedli po raz pierwszy do dyskusji na ten temat podczas konferencji rozbrojeniowych ONZ w Genewie w maju 2014 r. Opublikowany kilka miesięcy później raport organizacji Human Rights Watch i naukowców z Uniwersytetu Harvarda głosił, że autonomiczne militarne roboty byłyby zbyt niebezpieczne - same wybierałyby bowiem swoje cele i zabijały ludzi. Przy tym nie bardzo wiadomo, kogo w razie czego pociągnąć do odpowiedzialności.

Co potrafi rój małych dronów

Spory o zrobotyzowanych zabójców (Lethal Autono - mous Weapons Systems - LAWS) trwają od lat i nie gasną. Ostatnie miesiące przyniosły kolejne próby zastopowania militarnych robotów i falę doniesień o nowych projektach tego typu, z których niektóre są już nawet sprawdzane w realnej walce.

W listopadzie 2017 r. na YouTube pojawił się film wideo pokazujący zabójcze roje minidronów , slaughterbotów , w przerażającym działaniu. Widzowie ujrzeli, że nie potrzebujemy już ciężkich maszyn bojowych, czołgów czy pocisków miotanych przez Predatory, aby masowo i maszynowo zabijać. Główny twórca filmu, Stuart Russell, profesor sztucznej inteligencji w Berkeley, mówi w nim:

- Pozwolenie maszynom na zabijanie ludzi byłoby destrukcyjne dla naszego bezpieczeństwa i wolności.

Wiosną ub. roku pięćdziesięciu profesorów czołowych uczelni świata podpisało apel do Koreańskiego Instytutu Zaawansowanych Nauk i Technologii (KAIST) oraz jego partnera, firmy Hanwha Systems. Naukowcy zapowiedzieli, że nie będą współpracować z uczelnią, ani przyjmować gości z KAIST. Powodem były prowadzone przez obie instytucje projekty budowy "autonomicznej broni". KAIST zaprzeczył doniesieniom mediów.

Wkrótce potem w Stanach Zjednoczonych ponad 3 tys. pracowników Google’a zaprotestowało przeciwko pracom firmy nad sztuczną inteligencją dla wojska. Niepokoiło ich, że Google jest partnerem rządowego projektu o kryptonimie Maven , którego celem jest wykorzystanie AI do rozpoznawania obiektów i twarzy na nagraniach wideo z dronów wojskowych. Kierownictwo firmy twierdzi, że celem Maven pozostaje ratowanie życia i odciążenie ludzi od wykonywania żmudnej pracy, a nie agresja. Nie przekonało to protestujących.

Kolejną odsłoną batalii było oświadczenie specjalistów z dziedziny sztucznej inteligencji, m.in. działających przy projekcie DeepMind Google’a oraz Elona Muska. Obiecują oni, że nie będą opracowywać robotycznych maszyn do zabijania. Wzywają również rządy do zwiększenia wysiłków na rzecz uregulowania i ograniczenia tego rodzaju broni.

W oświadczeniu czytamy m.in., że "decyzja o odebraniu ludzkiego życia nigdy nie powinna być pozostawiona maszynie". Wprawdzie na wyposażeniu armii świata jest wiele urządzeń automatycznych, czasem o dużym stopniu autonomii, ale wielu ekspertów obawia się, że w przyszłości technologia ta może stać się całkowicie autonomiczna, pozwalając zabijać bez żadnego udziału ludzkich operatorów i dowódców.

Specjaliści ostrzegają również, że autonomiczne maszyny do zabijania mogą być jeszcze bardziej niebezpieczne niż "broń jądrowa, chemiczna i biologiczna", ponieważ wyścig zbrojeń jest w stanie łatwo wymknąć się spod kontroli. W sumie list pod auspicjami Instytutu Przyszłości Życia (FLI) podpisało w lipcu ub. roku 170 organizacji i 2464 osoby fizyczne. W pierwszych miesiącach 2019 r. grupa naukowców, tym razem z dziedziny zdrowia, związanych z FLI ponownie wezwała, w nowym liście, do wprowadzenia zakazu rozwoju broni kontrolowanej przez sztuczną inteligencję (AI).

Ubiegłoroczne sierpniowe spotkanie ONZ w Gnewie w sprawie możliwej regulacji prawnej odnośnie militarnych "robotów-zabójców" zakończyło się jednak sukcesem... maszyn. Grupa krajów - w tym USA, Rosja i Izrael - zablokowała dalsze prace nad wprowadzeniem międzynarodowego zakazu tej broni (projektu Konwencji o zakazie lub ograniczeniu użycia pewnych broni konwencjonalnych, CCW). Nieprzypadkowo są to państwa znane z prac nad zaawansowanymi systemami autonomicznej i zrobotyzowanej broni.

Rosja stawia na roboty bojowe

Często cytowane są słowa prezydenta Władimira Putina na temat militarnych systemów AI i wojskowych robotów:

- Kto zostanie liderem w tej dziedzinie, zostanie władcą świata.

Rosja otwarcie mówi o rozwoju broni autonomicznej. Generał Walerij Gierasimow, szef sztabu generalnego jej sił zbrojnych, powiedział niedawno wojskowej agencji prasowej Interfaks-AVN, że używanie robotów będzie jedną z głównych cech przyszłych wojen. Dodał, że Rosja stara się całkowicie zautomatyzować pole bitwy. Podobne komentarze wygłosili wicepremier Dmitrij Rogozin i minister obrony Siergiej Szojgu. Wiktor Bondariew, przewodniczący Komitetu Obrony i Bezpieczeństwa Rady Federacji, stwierdził, że Rosja dąży do opracowania technologii "roju", która pozwoliłaby sieci dronów działać jako jedna jednostka.

Nie jest to zaskakujące, jeśli ktoś pamięta, że najwcześniejsze zdalnie sterowane czołgi "teletanki" zostały opracowane właśnie przez Związek Radziecki, i to już w latach 30. XX wieku. Były wykorzystane jeszcze na początku II wojny światowej. Dziś Rosja również tworzy robo-czołgi , które mają być coraz bardziej autonomiczne.

Państwo Putina wysłało niedawno do Syrii swój bezzałogowy pojazd bojowy Uran-9 (3). Zdalnie sterowane urządzenie straciło kontakt ze stacjami kontroli naziemnej, miało kłopoty z systemem zawieszenia, a jego broń nie działała idealnie i nie trafiała do celów znajdujących się w ruchu. Nie brzmi to zbyt poważnie, ale wielu uważa syryjskie przetarcie za dobry test w warunkach bojowych, który pozwoli Rosjanom udoskonalić maszynę.

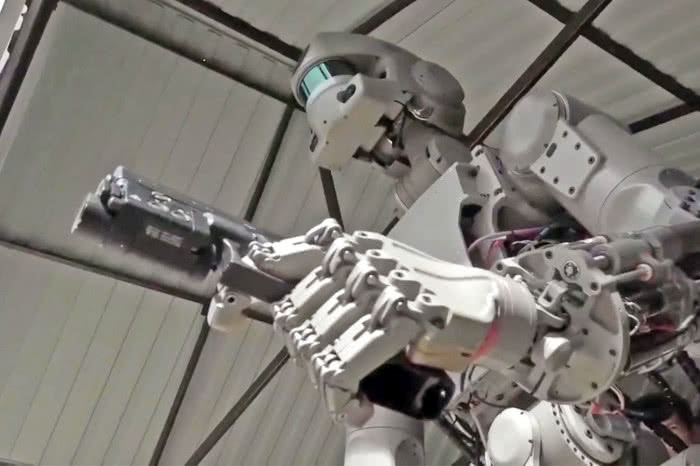

Rosyjska agencja kosmiczna Roskosmos zatwierdziła wstępny plan wysłania do sierpnia tego roku na Międzynarodową Stację Kosmiczną dwóch robotów Fedor (4), w bezzałogowym statku Sojuz. Nie w charakterze ładunku, ale pilotów. Podobny do filmowego Robocopa Fedor włada bronią i wykazuje zabójczą dokładność podczas ćwiczeń strzeleckich.

Powstaje pytanie, po co robot w kosmosie ma być uzbrojony? Są podejrzenia, że wcale nie chodzi o kosmos tylko o zastosowania naziemne. A tymczasem na Ziemi rosyjski producent broni Kałasznikow pokazał wizualizację robota Igorek, który choć wzbudził sporo śmiechu, sygnalizuje, że firma poważnie pracuje nad autonomicznymi maszynami bojowymi. W lipcu 2018 r. Kałasznikow ogłosił, że konstruuje broń, która do podejmowania decyzji "strzelać - nie strzelać" wykorzystuje sieci neuronowe.

Do tych informacji należy dodać doniesienia, że rosyjski producent broni, Diegtiariew, opracował mały autonomiczny czołg Nerekhta , który może samodzielnie nawigować do celu w trybie cichym, a następnie eksplodować z potężną siłą, aby zniszczyć inne czołgi lub całe budynki. Zaś czołg T14 Armata , duma rosyjskich sił zbrojnych, został zaprojektowany z myślą o możliwym zdalnym sterowaniu i bezzałogowej jeździe. Serwis Sputnik twierdzi, że rosyjscy inżynierowie wojskowi pracują nad tym, aby T-14 był w pełni autonomicznym pojazdem pancernym.

Dyrektywa sprzeciwu

Wojskowi amerykańscy sami nałożyli dość wyraźne ograniczenie na poziom autonomii swojego uzbrojenia. W 2012 r. Departament Obrony USA wydał dyrektywę 3000.09, która mówi, że ludzie muszą mieć prawo sprzeciwu wobec działań uzbrojonych robotów (choć mogą być pewne wyjątki). Dyrektywa ta pozostaje w mocy. Obecna polityka Pentagonu zakłada, że decydującym o użyciu broni powinien być zawsze człowiek oraz że taki osąd musi być zgodny z prawami wojny.

Choć od kilku dekad Amerykanie wykorzystują drony latające, Predatory, Reapery i wiele innych supermaszyn, nie były i nie są to modele autonomiczne. Sterują nimi zdalnie operatorzy, czasami z odległości kilku tysięcy kilometrów. Gorąca dyskusja o autonomii tego typu maszyn rozpoczęła się przy okazji premiery prototypu drona X-47B (5), który nie tylko samodzielnie latał, ale potrafił startować z lotniskowca, lądować na nim i tankować w powietrzu. W domyśle - również ostrzeliwać czy bombardować bez udziału człowieka. Jednak projekt pozostaje wciąż w sferze testów i rozważań.

W 2003 r. Departament Obrony rozpoczął eksperymenty z małym robotem czołgopodobnym SWORDS , wyposażonym w karabin maszynowy. W 2007 r. wysłano go do Iraku. Wojsko jednak zakończyło program po tym, jak robot zaczął zachowywać się nieprzewidywalnie, chaotycznie poruszając karabinem. W efekcie armia amerykańska porzuciła na lata badania nad uzbrojonymi robotami naziemnymi.

Jednocześnie armia amerykańska zwiększyła wydatki na roboty z 20 mln dolarów w 2014 r. do 156 mln w 2018 r. W 2019 r. budżet ten urósł już skokowo do 327 mln dolarów. To łączny wzrost o 1823% w ciągu zaledwie kilku lat. Eksperci twierdzą, że już w 2025 r. wojsko USA może mieć na polu walki więcej żołnierzy-robotów niż ludzi.

Niedawno spore kontrowersje wzbudził zaś ogłoszony przez US Army projekt ATLAS (Advanced Targeting and Lethality Automated System) - automatycznego czołgu. W mediach uznano to za złamanie wspomnianej dyrektywy 3000.09. Wojskowi amerykańscy zaprzeczają jednak i zapewniają, że nie ma mowy o usunięciu człowieka z pętli decyzyjnej.

AI rozpoznaje rekiny, rozpozna i cywili

Nowe argumenty mają też jednak obrońcy autonomicznej broni. Prof. Ronald Arkin, robotyk z Georgia Institute of Technology, przekonuje w swoich publikacjach, że w nowoczesnych działaniach wojennych inteligentna broń jest niezbędna do uniknięcia ofiar wśród ludności cywilnej, bo techniki uczenia maszynowego mogą skutecznie pomóc w rozróżnieniu między walczącymi a ludnością cywilną, a także między celami ważnymi i nieważnymi.

Przykładem tych umiejętności AI są patrolujące australijskie plaże drony Little Ripper, wyposażone w system SharkSpotter , opracowany przez Politechnikę w Sydney. System ten automatycznie skanuje wodę w poszukiwaniu rekinów i ostrzega operatora, gdy widzi coś niebezpiecznego. SharkSpotter (6) może identyfikować ludzi, delfiny, łodzie, deski surfingowe i przedmioty w wodzie, odróżniając je od rekinów. Potrafi z dużą dokładnością wykryć i zidentyfikować około szesnastu rodzajów różnych obiektów.

Te zaawansowane techniki uczenia maszynowego poprawiają dokładność rozpoznania powietrznego o ponad 90%. Dla porównania, ludzki operator w podobnej sytuacji trafnie rozpoznaje na zdjęciach lotniczych 20-30% obiektów. W dodatku identyfikacja SharkSpotter jest jeszcze sprawdzana przez człowieka, zanim ogłasza się alarm.

Na polu walki operator drona widzący obraz na ekranie może mieć trudności z ustaleniem, czy ludzie na ziemi to bojownicy z AK-47 w dłoniach, czy np. rolnicy z pikami. Arkin zwraca uwagę, że ludzie mają tendencję do "widzenia tego, co chcą widzieć", zwłaszcza w sytuacjach stresowych. Efekt ów przyczynił się do przypadkowego zestrzelenia irańskiego samolotu przez USS Vincennes w 1987 r. Z całą pewnością, jego zdaniem, broń prowadzona przez AI byłaby lepsza niż obecne "inteligentne bomby", które nie są tak naprawdę inteligentne. W sierpniu ub. roku sterowany laserowo saudyjski pocisk uderzył w autobus pełen uczniów w Jemenie, zabijając czterdzieścioro dzieci.

"Jeśli tylko autobus szkolny będzie odpowiednio oznakowany, jego rozpoznanie w autonomicznym systemie może być stosunkowo proste", przekonuje Arkin na łamach 'Popular Mechanics".

Nie wydaje się jednak, aby te argumenty przekonywały uczestników kampanii przeciw zautomatyzowanym zabójcom. Poza grozą, jaką budzą mordercze roboty, pozostaje jeszcze jedna ważna ewentualność, którą trzeba brać pod uwagę. Nawet "dobry" i "uważny" system może zostać zhakowany i przejęty przez bardzo złych ludzi. Wówczas wszelkie argumenty broniące wojskowych automatów tracą ważność.

Mirosław Usidus